基于深度学习的无人船移动路径自动规划方法.docx

骑着****猪猪

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于深度学习的无人船移动路径自动规划方法.docx

基于深度学习的无人船移动路径自动规划方法一、引言随着技术的不断发展,无人船的应用范围和使用环境也不断扩大。无人船被广泛应用于水域监测、水下勘测、环境调查等领域。在无人船的应用过程中,路径规划是关键问题之一。传统的路径规划方法受限于环境和控制器的精度等因素,无法达到理想的效果。本文基于深度学习,提出了一种基于神经网络的无人船移动路径自动规划方法,利用自主学习的方式,提高了路径规划的精度和速度。二、研究背景与现状无人船移动路径规划在很多领域都有广泛的应用,例如船舶自动驾驶、水质监测等。传统的路径规划方法通常采

无人船路径规划方法及系统.pdf

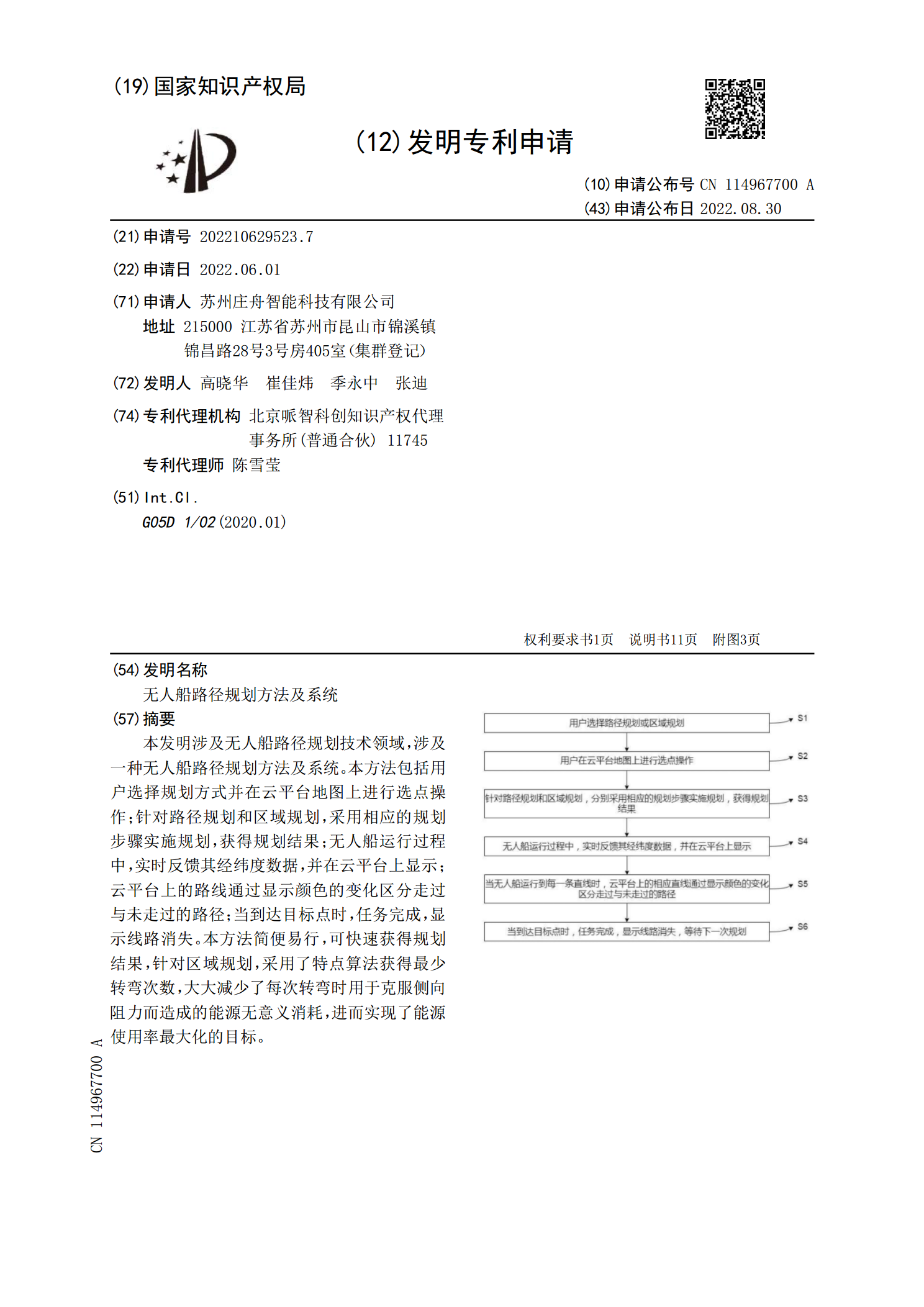

本发明涉及无人船路径规划技术领域,涉及一种无人船路径规划方法及系统。本方法包括用户选择规划方式并在云平台地图上进行选点操作;针对路径规划和区域规划,采用相应的规划步骤实施规划,获得规划结果;无人船运行过程中,实时反馈其经纬度数据,并在云平台上显示;云平台上的路线通过显示颜色的变化区分走过与未走过的路径;当到达目标点时,任务完成,显示线路消失。本方法简便易行,可快速获得规划结果,针对区域规划,采用了特点算法获得最少转弯次数,大大减少了每次转弯时用于克服侧向阻力而造成的能源无意义消耗,进而实现了能源使用率最大

基于深度强化学习的无人播种机自动路径规划研究.docx

基于深度强化学习的无人播种机自动路径规划研究摘要无人播种机是近年发展迅猛的农业智能化设备,其自动化能力可以大大提高农业生产效率和农产品的品质。本文提出了基于深度强化学习的无人播种机自动路径规划方法,通过构建无人播种机工作环境模型和训练强化学习智能体,实现了机器人在不同作业状态下的路径规划和动态调整,有效提高了机器人的自主性和作业效率。关键字:无人播种机,深度强化学习,路径规划AbstractUnmannedseedersareintelligentagriculturalequipmentthathasd

基于深度强化学习的无人车充电路径规划方法.pdf

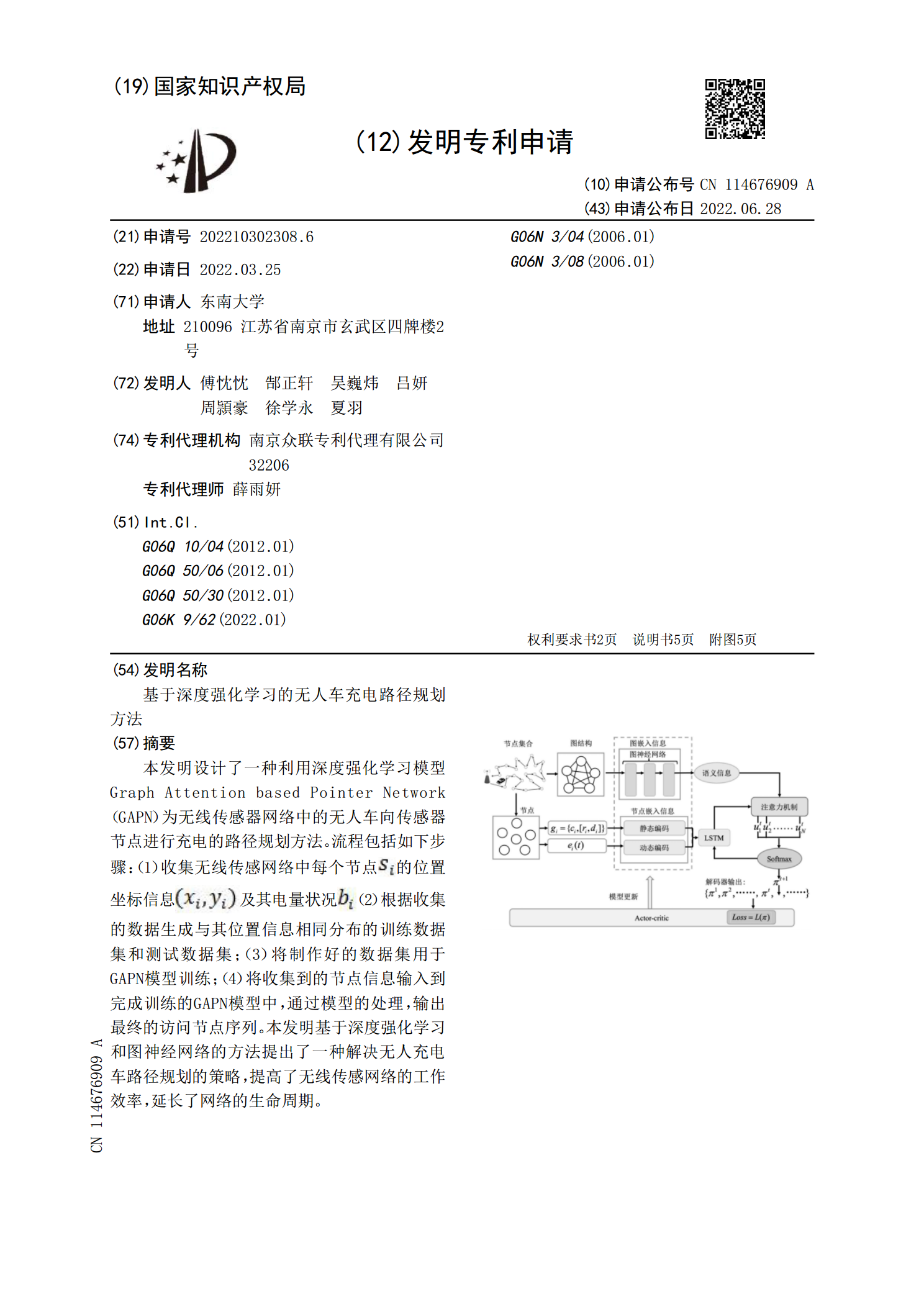

本发明设计了一种利用深度强化学习模型GraphAttentionbasedPointerNetwork(GAPN)为无线传感器网络中的无人车向传感器节点进行充电的路径规划方法。流程包括如下步骤:(1)收集无线传感网络中每个节点<base:Imagehe=@17@wi=@15@file=@DEST_PATH_IMAGE002.JPG@imgContent=@drawing@imgFormat=@JPEG@orientation=@portrait@inline=@yes@/>的位置坐标信息<base:Ima

基于深度强化学习的多无人车协同路径规划方法.docx

本文档只有word版,所有PDF版本都为盗版,侵权必究基于深度强化学习的多无人车协同路径规划方法目录一、内容简述................................................21.研究背景与意义........................................22.国内外研究现状........................................33.研究内容与方法........................................4