一种多智能体目标协同搜索方法及系统.pdf

是你****馨呀

亲,该文档总共20页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

一种多智能体目标协同搜索方法及系统.pdf

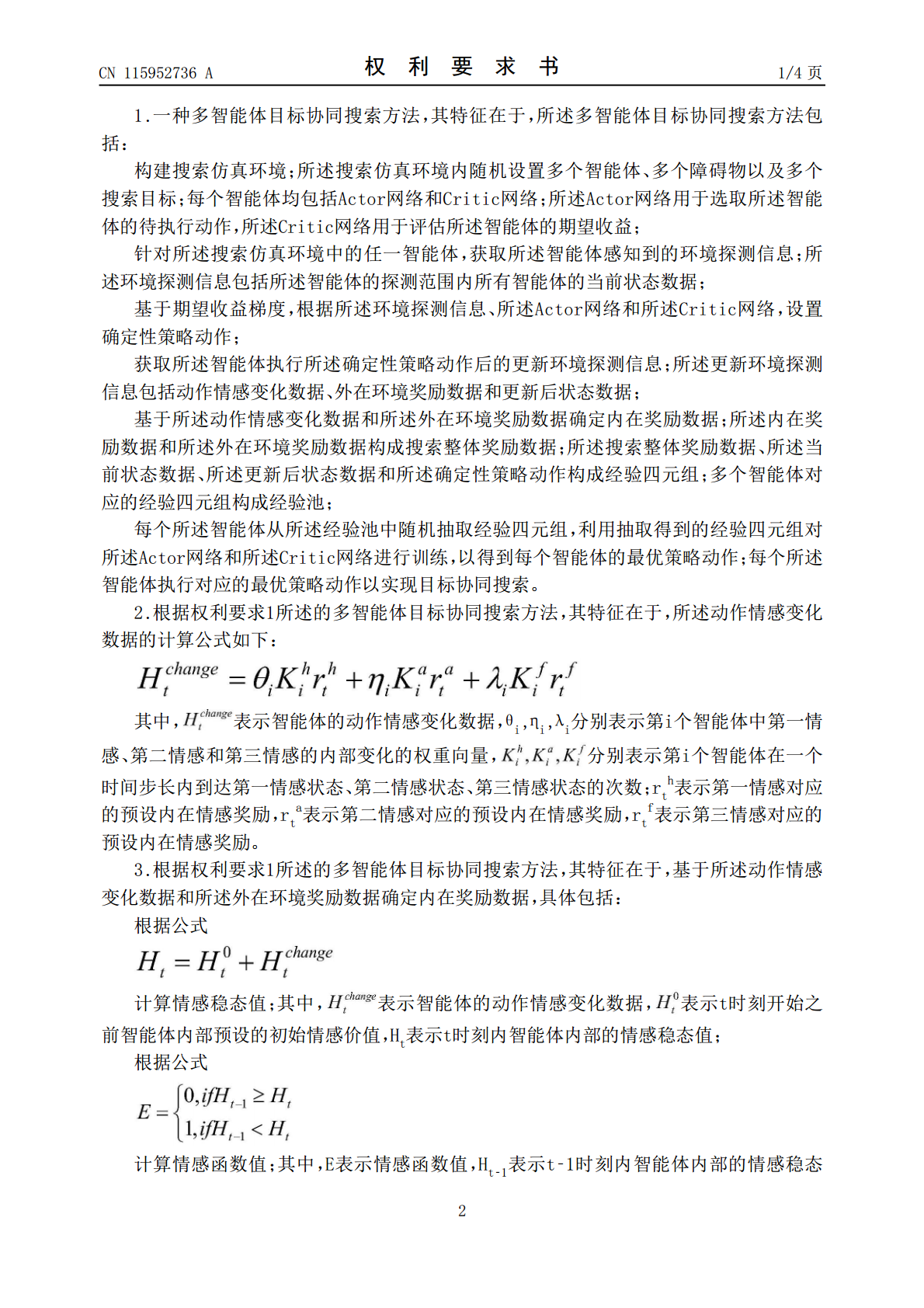

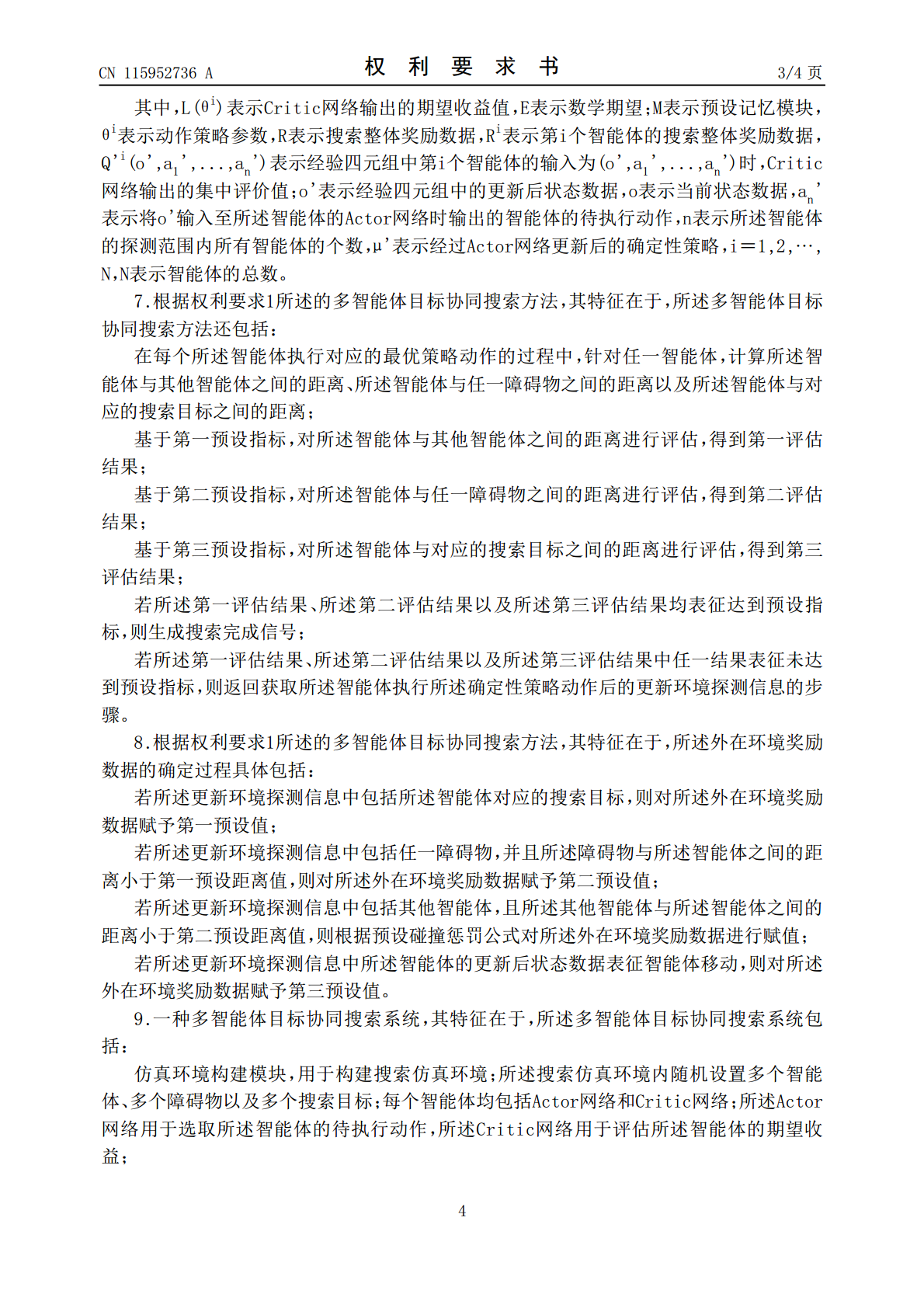

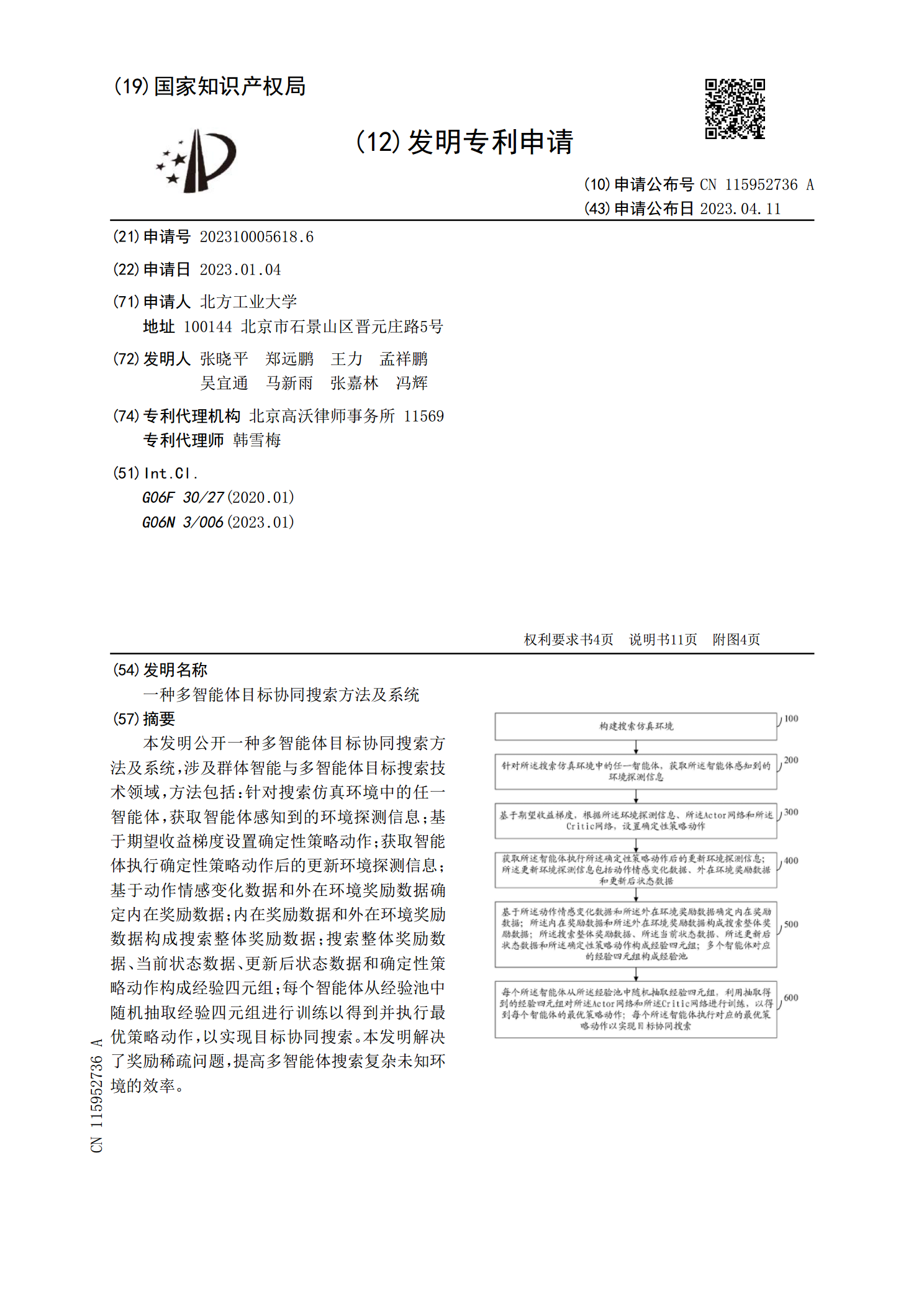

本发明公开一种多智能体目标协同搜索方法及系统,涉及群体智能与多智能体目标搜索技术领域,方法包括:针对搜索仿真环境中的任一智能体,获取智能体感知到的环境探测信息;基于期望收益梯度设置确定性策略动作;获取智能体执行确定性策略动作后的更新环境探测信息;基于动作情感变化数据和外在环境奖励数据确定内在奖励数据;内在奖励数据和外在环境奖励数据构成搜索整体奖励数据;搜索整体奖励数据、当前状态数据、更新后状态数据和确定性策略动作构成经验四元组;每个智能体从经验池中随机抽取经验四元组进行训练以得到并执行最优策略动作,以实现

多智能体动态目标协同搜索策略研究.docx

多智能体动态目标协同搜索策略研究多智能体动态目标协同搜索策略研究随着智能化时代的到来和社会的发展,越来越多的问题需要在动态环境下解决,其中多智能体系统的问题尤为突出。多智能体系统中,不同个体需要协同完成任务,即便一个个体能够完成任务,其效率也会受到局限。因此,如何让多个智能体协同完成任务成为一个亟待解决的问题。在多智能体系统中,动态目标的协同搜索能力尤为重要,本文将深入研究多智能体动态目标协同搜索策略。一、关于多智能体动态目标协同搜索多智能体系统中协同搜索是指多个智能体同时在同一环境中搜索目标。动态目标是

一种基于搜索的多智能体路径规划方法及系统.pdf

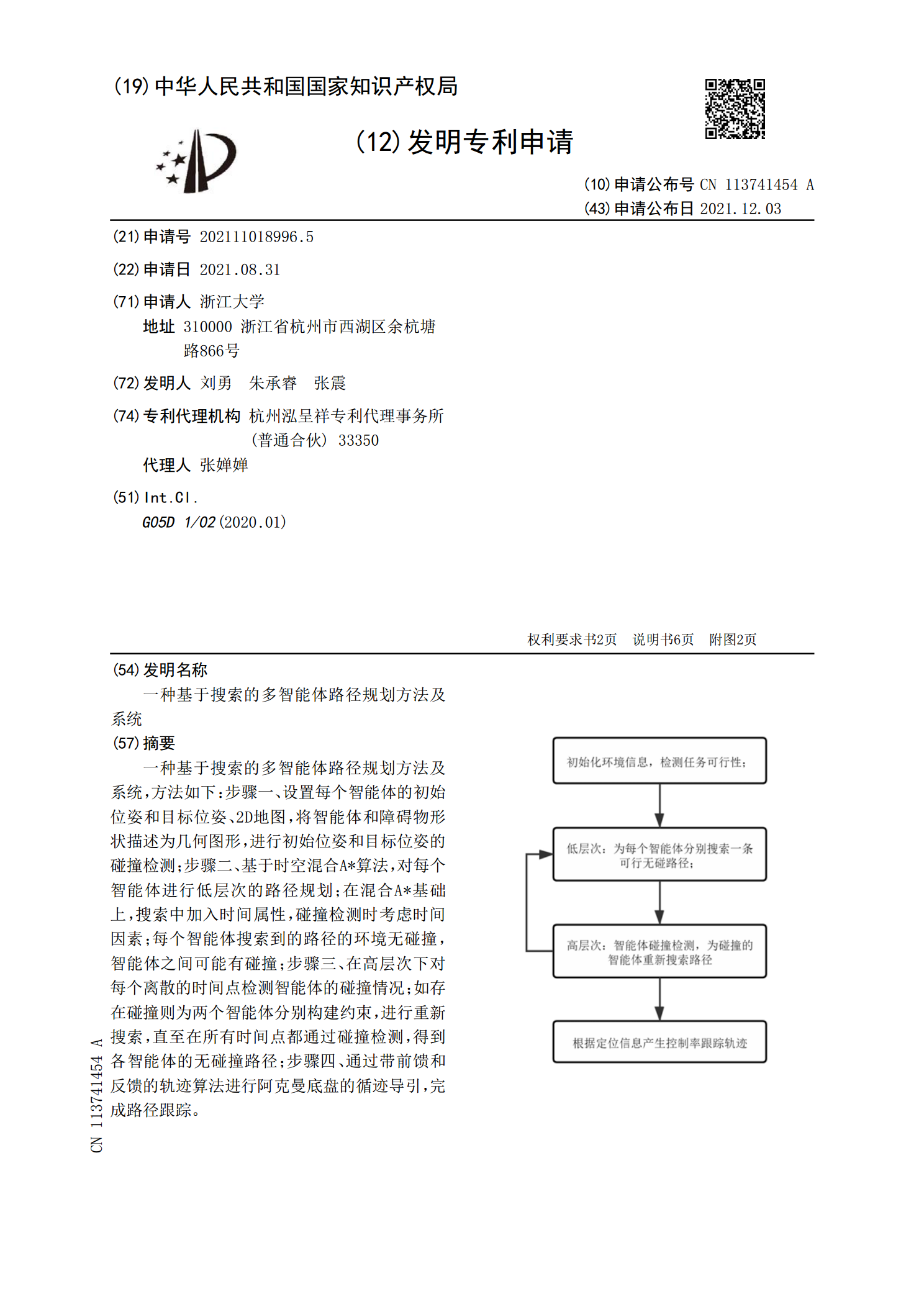

一种基于搜索的多智能体路径规划方法及系统,方法如下:步骤一、设置每个智能体的初始位姿和目标位姿、2D地图,将智能体和障碍物形状描述为几何图形,进行初始位姿和目标位姿的碰撞检测;步骤二、基于时空混合A*算法,对每个智能体进行低层次的路径规划;在混合A*基础上,搜索中加入时间属性,碰撞检测时考虑时间因素;每个智能体搜索到的路径的环境无碰撞,智能体之间可能有碰撞;步骤三、在高层次下对每个离散的时间点检测智能体的碰撞情况;如存在碰撞则为两个智能体分别构建约束,进行重新搜索,直至在所有时间点都通过碰撞检测,得到各智

一种基于多智能体的协同运输方法及其系统.pdf

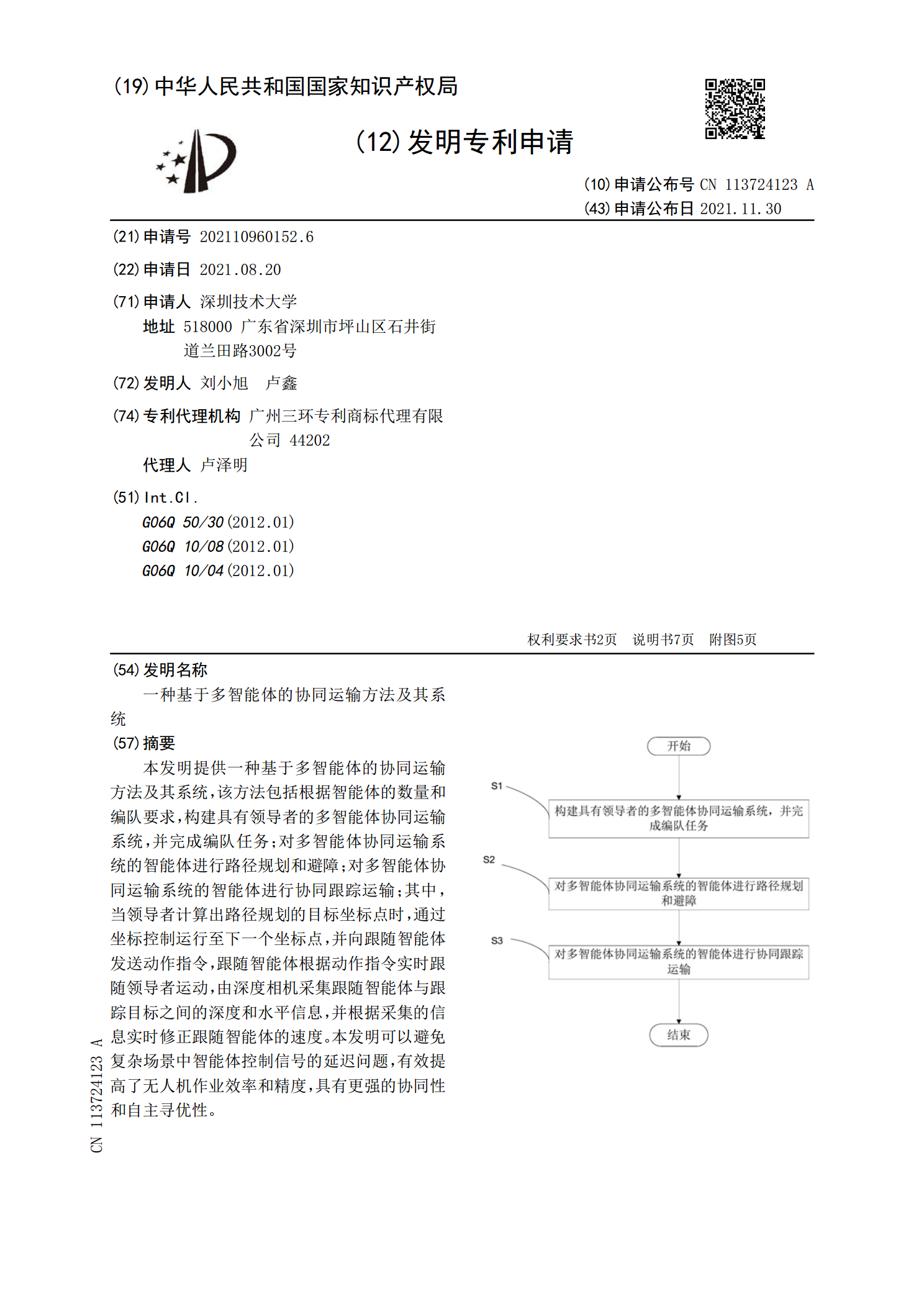

本发明提供一种基于多智能体的协同运输方法及其系统,该方法包括根据智能体的数量和编队要求,构建具有领导者的多智能体协同运输系统,并完成编队任务;对多智能体协同运输系统的智能体进行路径规划和避障;对多智能体协同运输系统的智能体进行协同跟踪运输;其中,当领导者计算出路径规划的目标坐标点时,通过坐标控制运行至下一个坐标点,并向跟随智能体发送动作指令,跟随智能体根据动作指令实时跟随领导者运动,由深度相机采集跟随智能体与跟踪目标之间的深度和水平信息,并根据采集的信息实时修正跟随智能体的速度。本发明可以避免复杂场景中智

一种多智能体搜索情感目标路径规划方法及装置.pdf

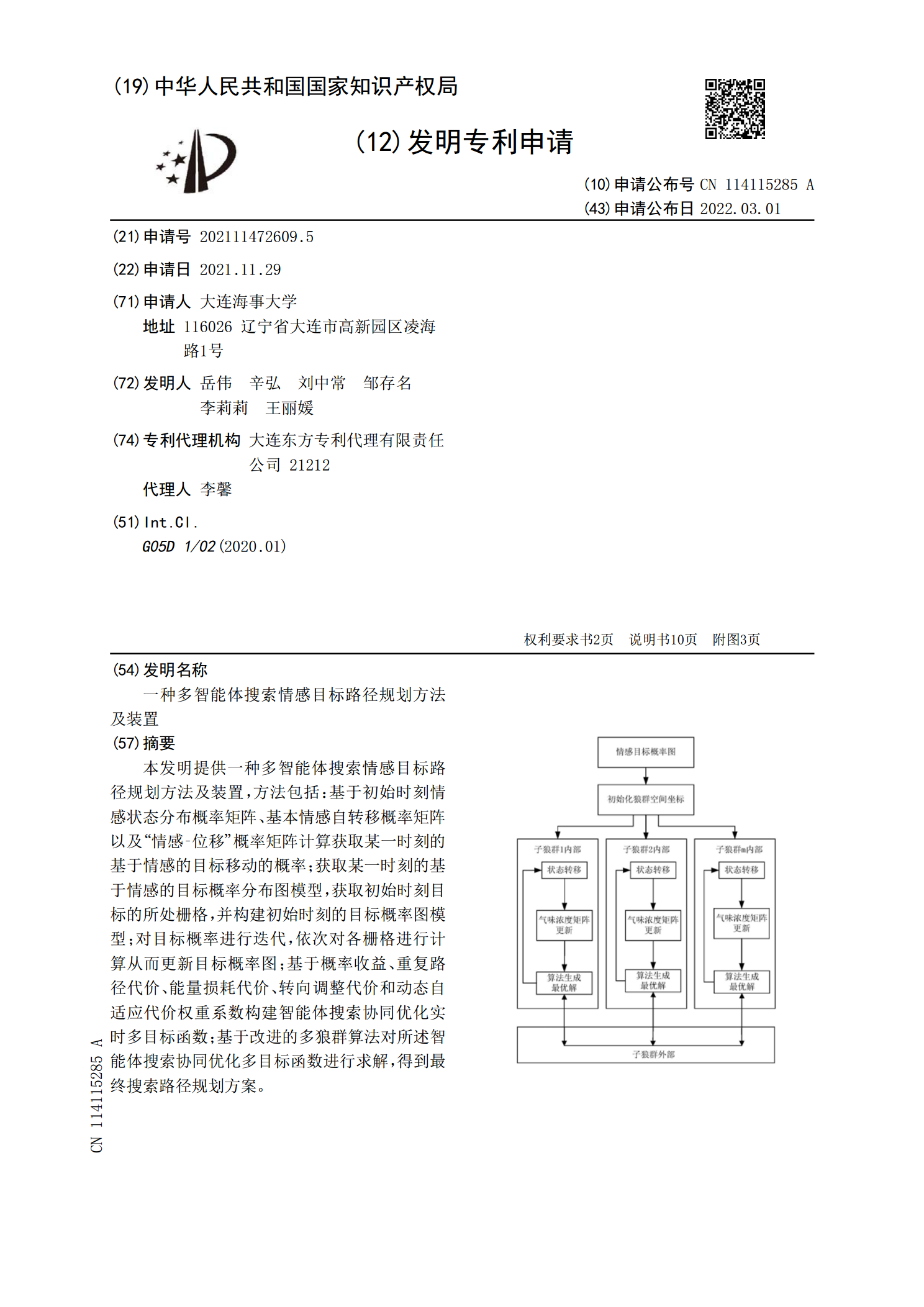

本发明提供一种多智能体搜索情感目标路径规划方法及装置,方法包括:基于初始时刻情感状态分布概率矩阵、基本情感自转移概率矩阵以及“情感‑位移”概率矩阵计算获取某一时刻的基于情感的目标移动的概率;获取某一时刻的基于情感的目标概率分布图模型,获取初始时刻目标的所处栅格,并构建初始时刻的目标概率图模型;对目标概率进行迭代,依次对各栅格进行计算从而更新目标概率图;基于概率收益、重复路径代价、能量损耗代价、转向调整代价和动态自适应代价权重系数构建智能体搜索协同优化实时多目标函数;基于改进的多狼群算法对所述智能体搜索协同