主动诱骗式智能抗干扰方法.pdf

兴朝****45

亲,该文档总共13页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

主动诱骗式智能抗干扰方法.pdf

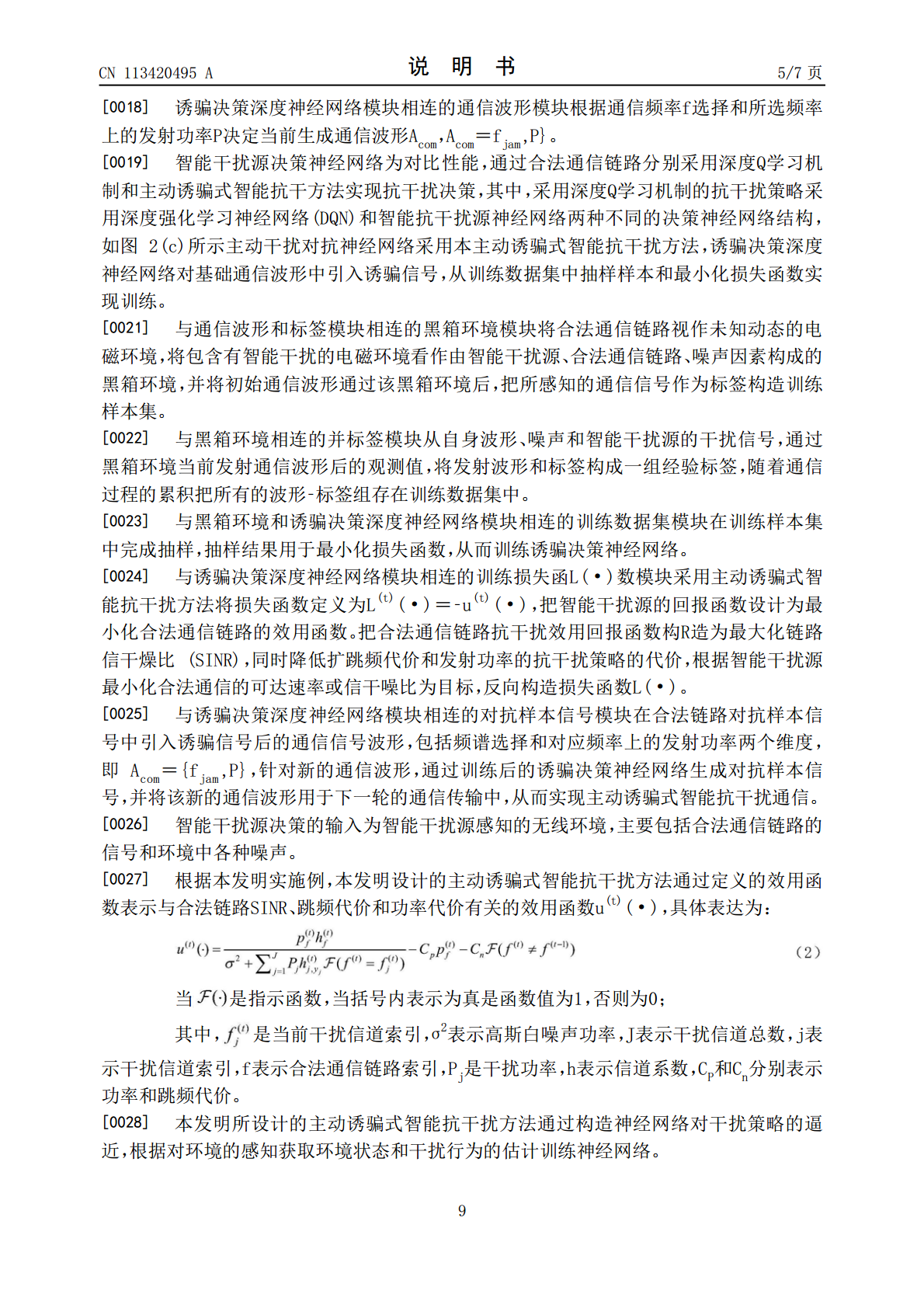

本发明公开的一种主动诱骗式智能抗干扰方法,具有较低的训练复杂度和较高的资源利用率。本发明通过下述技术方实现:首先根据黑箱环境模块接收的通信波形和当前全频带感知信号强度以及下一次感知一起构造环境状态,基于观察智能干扰源的干扰行为构造样本标签模块,生成对抗样本信号的训练数据集和诱骗决策深度神经网络,以最小化干扰源的干扰期望回报值和干扰效果为目标,将诱惑样本攻击过程建模为一个关于干扰时机和干扰样本值两个变量;对更新干扰行为的观察进行迭代训练参数,计算攻击时机变量和攻击样本变量,进行干扰行为决策和攻击网络训练;引

介入式主动操控智能轮椅的控制系统及方法.pdf

本发明提供一种介入式主动操控智能轮椅的控制系统和方法,包括数据采集模块,采集轮椅的椅面和脚踏的压力,以及轮椅的运行加速度;唤醒模块根据采集到的椅面的压力,在轮椅有人时解除锁定;状态判断模块根据轮椅的加速度,判断轮椅是否处于行驶状态;坐姿提醒模块用于在行驶状态下保持在不良坐姿的时间超时则发出报警并发送减速信号;脚踏提醒模块用于在行驶状态下当脚不当放置或者离开脚踏时间超时则发出报警并发送减速信号;减速控制模块用于控制轮椅的两个电机接口,将行驶速度降低到安全速度以内,并解除报警状态。本发明实现对轮椅使用者坐姿状

一种主动交互式智能售卖系统及方法.pdf

本发明公开了一种主动交互式智能售卖系统及方法,属于智能零售技术领域,解决了现有售卖装置推荐商品针对性不搞、商品购买率低下的问题。一种主动交互式智能售卖系统,包括主动信息获取模块、场景化分析模块、表情及姿态识别模块、自适应推荐模块,所述主动信息获取模块,用于获取售卖装置的位置信息和潜在购买人的人物图像信息;所述场景化分析模块,用于得到对应的地域信息和应用场景;所述表情及姿态识别模块,用于对所述人物图像信息进行人脸表情识别及人物姿态识别;所述自适应推荐模块,用于利用人物表情状态识别结果以及人物姿态结果,得到人

浅议智能仪器抗干扰设计的方法.docx

浅议智能仪器抗干扰设计的方法智能仪器在现代科学技术发展中发挥着重要作用,其高精度和高灵敏度使得其在各个领域得到广泛应用。然而,智能仪器在实际工作过程中常常会面临许多电磁干扰的问题,这些干扰会对仪器的性能和测量结果产生不可忽视的影响。因此,如何设计一种能够有效抵御电磁干扰的智能仪器成为了一个重要的研究方向。一、电磁干扰的分类电磁干扰可以分为外部干扰和内部干扰两种类型。外部干扰主要来自于外界的电磁场,例如无线电台、电视台、手机等电子设备产生的辐射。内部干扰则主要来自于仪器设备自身产生的电磁信号,例如仪器内部的

主动交互式的智能语音系统.pdf

本发明公开了一种主动交互式的智能语音系统,包括语音对话终端与云端处理系统;所述语音对话终端包括语音接收单元、主控单元、通讯单元、存储单元、语音播放单元以及主动交互触发单元;所述云端处理系统包括语音识别模块、语义分析模块、智能对话逻辑模块、文字转语音模块。采用上述技术方案,本发明的主动交互式的智能语音系统,突破现有被动式交互方式,可以根据所处场景信息、并结合用户个性化数据、大数据行为分析,主动发起话题,激发更多的交互可能性。本发明的主动交互式的智能语音系统,可广泛应用于商业领域,如酒店、娱乐场所、餐饮、商场