一种用于视频监控的感兴趣区域提取方法.pdf

运升****魔王

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

一种用于视频监控的感兴趣区域提取方法.pdf

本发明提供一种视频图像中感兴趣区域的提取方法,适用于视频监控领域。所述方法可以将感兴趣区域自动标记出来,具体包括以下步骤:1)采用双目摄像头(已预先标定)进行视频采集;2)对左右两视点的图像进行校正,消除畸变;3)左右视点选择其一,通过双目视差计算其深度图,并通过连续图像构建其高斯混合背景模型;4)使用全局的深度对比度获取深度显著性区域,同时使用背景差值的方法获取运动区域,得到两幅二值图像;5)对步骤4获取的两幅二值图像做异或运算,然后筛选连通区域(去噪),并对剩余的连通区域做膨胀操作;6)最后标记轮廓和

一种基于深度的视频感兴趣区域提取方法.pdf

本发明公开了一种基于深度的视频感兴趣区域提取方法,优点在于联合利用了时间上同步的纹理视频帧和纹理视频帧对应的深度视频帧,首先获取纹理视频帧的运动区域和轮廓纹理的二值掩模图像及深度视频帧的各个深度层和深度不连续区域的二值掩模图像,然后获取各个深度层的各个深度对象层的二值掩模图像,及各个深度层的轮廓特征区域的二值掩模图像,再以各个深度层的轮廓特征区域的二值掩模图像为特征,对各个深度对象层的二值掩模图像进行扫描,得到各个深度对象层的二值掩模图像中的感兴趣区域,最后叠加各个深度对象层的二值掩模图像中的感

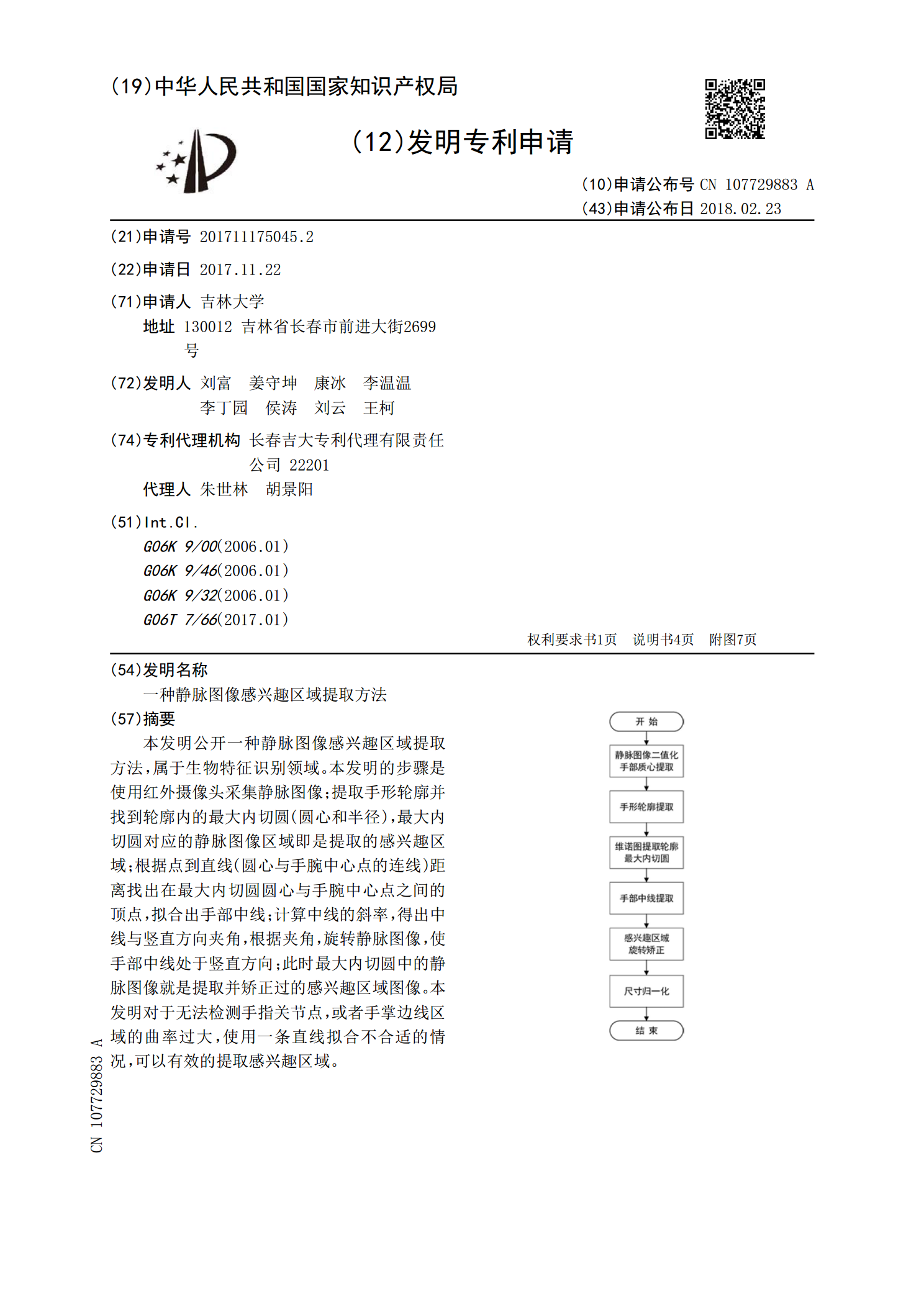

一种静脉图像感兴趣区域提取方法.pdf

本发明公开一种静脉图像感兴趣区域提取方法,属于生物特征识别领域。本发明的步骤是使用红外摄像头采集静脉图像;提取手形轮廓并找到轮廓内的最大内切圆(圆心和半径),最大内切圆对应的静脉图像区域即是提取的感兴趣区域;根据点到直线(圆心与手腕中心点的连线)距离找出在最大内切圆圆心与手腕中心点之间的顶点,拟合出手部中线;计算中线的斜率,得出中线与竖直方向夹角,根据夹角,旋转静脉图像,使手部中线处于竖直方向;此时最大内切圆中的静脉图像就是提取并矫正过的感兴趣区域图像。本发明对于无法检测手指关节点,或者手掌边线区域的曲率

一种用于正电子检测正弦矩阵图的感兴趣区域提取方法.pdf

本发明公开了一种用于正电子检测正弦矩阵图的感兴趣区域提取方法。根据正弦矩阵图的数据存储规则和感兴趣区域的物理位置范围进行感兴趣区域的提取;利用最大似然估计法对提取了感兴趣区域的正弦矩阵图进行图像重建,获得切片图;构建PCNN网络结构,利用PCNN网络对切片图进行处理,完成切片图的感兴趣区域的提取。本发明通过感兴趣区域的提取与单独处理,最大限度地保留感兴趣区域的信息,单独对感兴趣区域进行图像重建,在损失不关心区域信息的条件下,最大限度地保留了感兴趣区域的原始信息,有利于提高感兴趣区域的成像分辨率,有利于对病

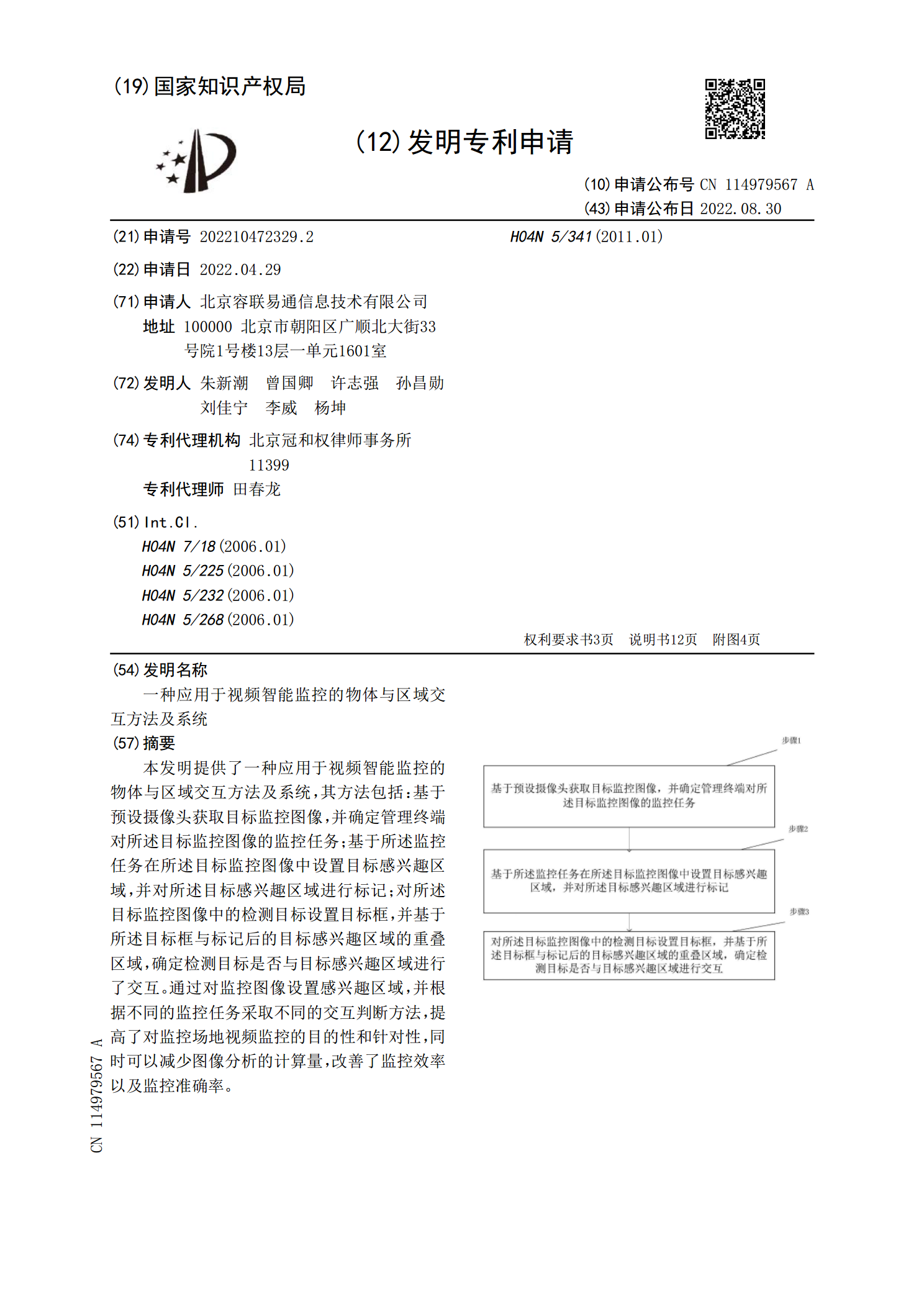

一种应用于视频智能监控的物体与区域交互方法及系统.pdf

本发明提供了一种应用于视频智能监控的物体与区域交互方法及系统,其方法包括:基于预设摄像头获取目标监控图像,并确定管理终端对所述目标监控图像的监控任务;基于所述监控任务在所述目标监控图像中设置目标感兴趣区域,并对所述目标感兴趣区域进行标记;对所述目标监控图像中的检测目标设置目标框,并基于所述目标框与标记后的目标感兴趣区域的重叠区域,确定检测目标是否与目标感兴趣区域进行了交互。通过对监控图像设置感兴趣区域,并根据不同的监控任务采取不同的交互判断方法,提高了对监控场地视频监控的目的性和针对性,同时可以减少图像分