基于注意力Unet的多尺度胎儿图像分割方法.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于注意力Unet的多尺度胎儿图像分割方法.docx

基于注意力Unet的多尺度胎儿图像分割方法基于注意力UNet的多尺度胎儿图像分割方法摘要:随着胎儿医学图像技术的快速发展,胎儿图像分割成为了解剖结构,提取特征和疾病诊断的重要环节。然而,胎儿图像分割面临着复杂的挑战,包括胎儿的形状和姿态的变化,背景噪声的干扰以及图像质量的不一致性。本研究针对这些问题,提出了一种基于注意力UNet的多尺度胎儿图像分割方法。该方法通过引入注意力机制在UNet的编码器和解码器之间构建了与尺度相关的特征模块,提高了模型对胎儿图像重要区域的关注度,并减弱了对背景和噪声的干扰。实验结

融合多尺度扩张率的D-UNet裂缝图像分割方法.pdf

本发明公开了一种融合多尺度扩张率的D‑UNet裂缝图像分割方法,将UNet进行修改,将模型中的双重卷积的第二层传统卷积替换为不同扩张率的空洞卷积进行提取特征,在编码阶段和解码阶段设置的扩张率形成对称结构。本发明提供了融合多尺度扩张率的D‑UNet裂缝图像分割方法,在分割领域提供了新的解决方案,针对裂缝分割任务存在的特点对已有的分割模型进行了优化,对实际工程中应用本模型具有指导意义;本发明利用原始UNet作为基础的主干网络进行优化,对其编码器和解码器进行卷积替换,替换的空洞卷积更加有利于特征的提取。对于下采

融合多尺度和多头注意力的医疗图像分割方法.pptx

汇报人:/目录0102不同尺度的特征信息多尺度特征提取方法尺度间的信息融合实验验证与结果分析03注意力机制的基本原理多头注意力机制的设计注意力权重的训练与优化实验验证与结果分析04方法概述与流程图特征提取与注意力机制的融合分割网络的构建与训练实验验证与结果分析05在医疗图像分割领域的应用场景与其他方法的优势对比分析在实际应用中的潜在价值未来发展方向与展望汇报人:

基于多尺度特征和注意力机制的航空图像分割.docx

基于多尺度特征和注意力机制的航空图像分割摘要:航空图像分割是计算机视觉领域的一个重要任务,具有广泛的应用价值。然而,由于航空图像的特殊性,包含大面积的地物和复杂的纹理等因素,航空图像的分割任务具有一定的挑战性。为了解决这个问题,本文提出了一种基于多尺度特征和注意力机制的航空图像分割方法。首先,本文使用多尺度特征来提取航空图像的更全面的信息。在传统的航空图像分割方法中,通常只使用固定大小的滑动窗口来提取特征。然而,由于航空图像的尺度巨大,只使用固定大小的滑动窗口往往不能捕捉到完整的目标信息。因此,本文采用了

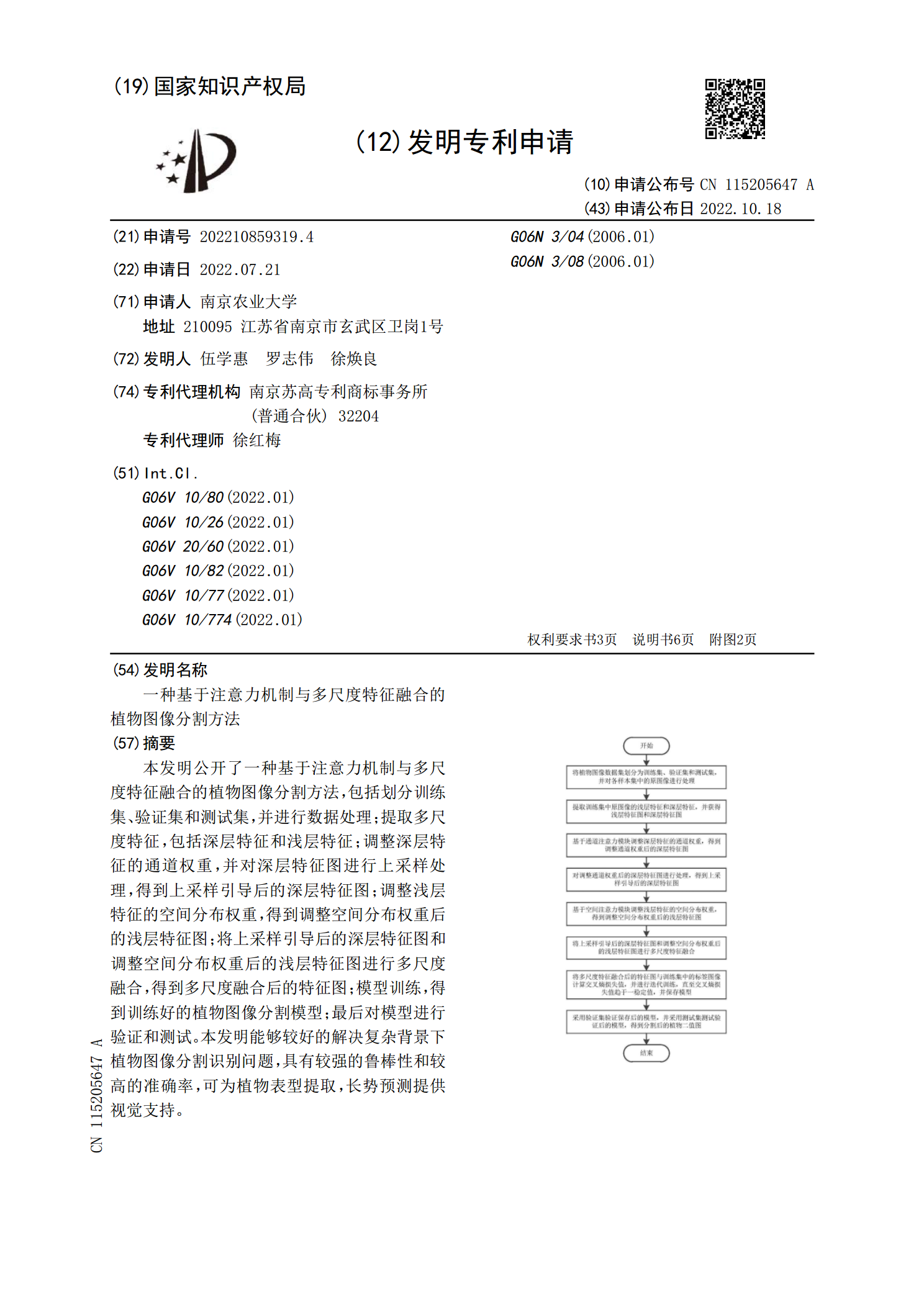

一种基于注意力机制与多尺度特征融合的植物图像分割方法.pdf

本发明公开了一种基于注意力机制与多尺度特征融合的植物图像分割方法,包括划分训练集、验证集和测试集,并进行数据处理;提取多尺度特征,包括深层特征和浅层特征;调整深层特征的通道权重,并对深层特征图进行上采样处理,得到上采样引导后的深层特征图;调整浅层特征的空间分布权重,得到调整空间分布权重后的浅层特征图;将上采样引导后的深层特征图和调整空间分布权重后的浅层特征图进行多尺度融合,得到多尺度融合后的特征图;模型训练,得到训练好的植物图像分割模型;最后对模型进行验证和测试。本发明能够较好的解决复杂背景下植物图像分割