基于多尺度特征和注意力机制的航空图像分割.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于多尺度特征和注意力机制的航空图像分割.docx

基于多尺度特征和注意力机制的航空图像分割摘要:航空图像分割是计算机视觉领域的一个重要任务,具有广泛的应用价值。然而,由于航空图像的特殊性,包含大面积的地物和复杂的纹理等因素,航空图像的分割任务具有一定的挑战性。为了解决这个问题,本文提出了一种基于多尺度特征和注意力机制的航空图像分割方法。首先,本文使用多尺度特征来提取航空图像的更全面的信息。在传统的航空图像分割方法中,通常只使用固定大小的滑动窗口来提取特征。然而,由于航空图像的尺度巨大,只使用固定大小的滑动窗口往往不能捕捉到完整的目标信息。因此,本文采用了

一种基于注意力机制与多尺度特征融合的植物图像分割方法.pdf

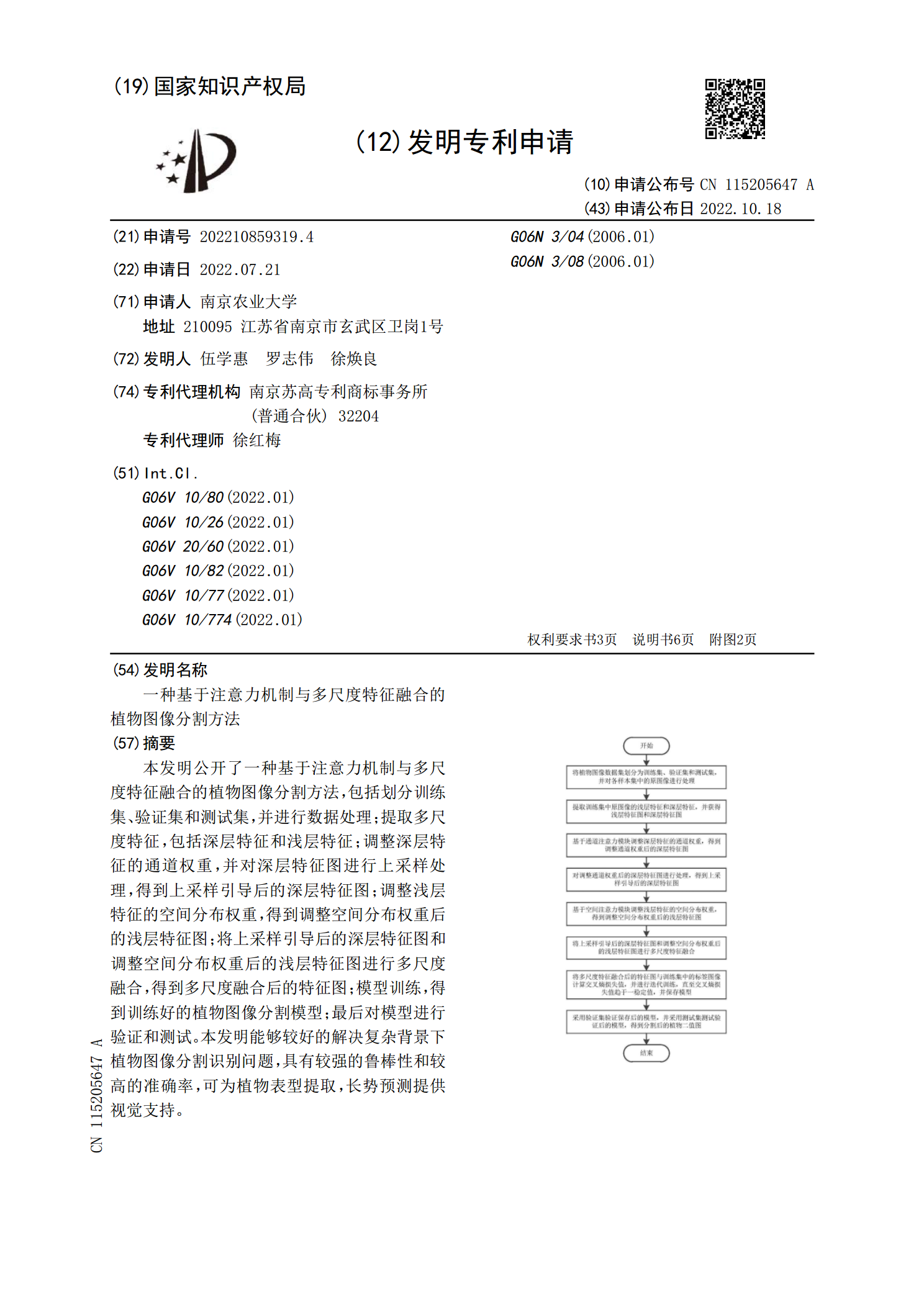

本发明公开了一种基于注意力机制与多尺度特征融合的植物图像分割方法,包括划分训练集、验证集和测试集,并进行数据处理;提取多尺度特征,包括深层特征和浅层特征;调整深层特征的通道权重,并对深层特征图进行上采样处理,得到上采样引导后的深层特征图;调整浅层特征的空间分布权重,得到调整空间分布权重后的浅层特征图;将上采样引导后的深层特征图和调整空间分布权重后的浅层特征图进行多尺度融合,得到多尺度融合后的特征图;模型训练,得到训练好的植物图像分割模型;最后对模型进行验证和测试。本发明能够较好的解决复杂背景下植物图像分割

基于多尺度感知和注意力机制的图像语义分割网络的研究的任务书.docx

基于多尺度感知和注意力机制的图像语义分割网络的研究的任务书一、任务背景:图像语义分割任务是计算机视觉领域中的重要任务之一,其目标是将图片中的每个像素标注为预定义的语义类别。图像语义分割任务涉及到像素的分类和位置信息,能够为目标检测、语义分析、自动驾驶等许多领域提供有力的支持。尽管在过去几年中,人们在该领域取得了重要进展,但是由于图像的多样性和复杂度,该任务仍然具有挑战性。在实现高效准确的图像语义分割过程中,多尺度感知和注意力机制这两个因素是非常关键的因素。多尺度感知能够在不丢失上下文信息的同时捕捉到图像中

基于注意力Unet的多尺度胎儿图像分割方法.docx

基于注意力Unet的多尺度胎儿图像分割方法基于注意力UNet的多尺度胎儿图像分割方法摘要:随着胎儿医学图像技术的快速发展,胎儿图像分割成为了解剖结构,提取特征和疾病诊断的重要环节。然而,胎儿图像分割面临着复杂的挑战,包括胎儿的形状和姿态的变化,背景噪声的干扰以及图像质量的不一致性。本研究针对这些问题,提出了一种基于注意力UNet的多尺度胎儿图像分割方法。该方法通过引入注意力机制在UNet的编码器和解码器之间构建了与尺度相关的特征模块,提高了模型对胎儿图像重要区域的关注度,并减弱了对背景和噪声的干扰。实验结

注意力机制和多尺度特征融合的细粒度图像分类.docx

注意力机制和多尺度特征融合的细粒度图像分类目录一、内容描述................................................31.1背景与意义...........................................41.2国内外研究现状.......................................51.3主要内容与结构安排...................................6二、相关工作.....................