基于旋转对称模板的相机标定.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于旋转对称模板的相机标定.docx

基于旋转对称模板的相机标定基于旋转对称模板的相机标定摘要:相机标定是计算机视觉领域中一个重要的任务,它在计算机视觉、图像处理、机器人等领域具有广泛的应用。本文提出了一种基于旋转对称模板的相机标定方法。该方法通过使用旋转对称模板,对相机进行标定,从而提高了标定的准确性和可靠性。实验结果表明,该方法在标定精度上具有较好的性能,并且具有较好的实用性。1.引言相机标定是计算机视觉领域中的一个重要问题,旨在确定相机内部参数(如焦距、畸变系数等)和外部参数(如旋转矩阵、平移向量等),从而使得相机能够准确地捕捉并处理图

基于投影变换的线阵旋转扫描相机标定方法.docx

基于投影变换的线阵旋转扫描相机标定方法基于投影变换的线阵旋转扫描相机标定方法摘要:线阵旋转扫描相机是一种常用于工业检测和三维测量的非接触式相机,精确的标定是确保其测量精度的关键。本文提出了一种基于投影变换的线阵旋转扫描相机标定方法。该方法通过利用线阵相机在不同旋转角度下观测到的校准板平面上的投影特征,计算出相机内外参数,从而实现相机的准确标定。实验证明,该方法能够有效地提高线阵旋转扫描相机的标定精度。关键词:线阵旋转扫描相机,标定,投影变换,内外参数1.引言线阵旋转扫描相机是一种通过旋转扫描来获取三维信息

基于云的相机标定.pdf

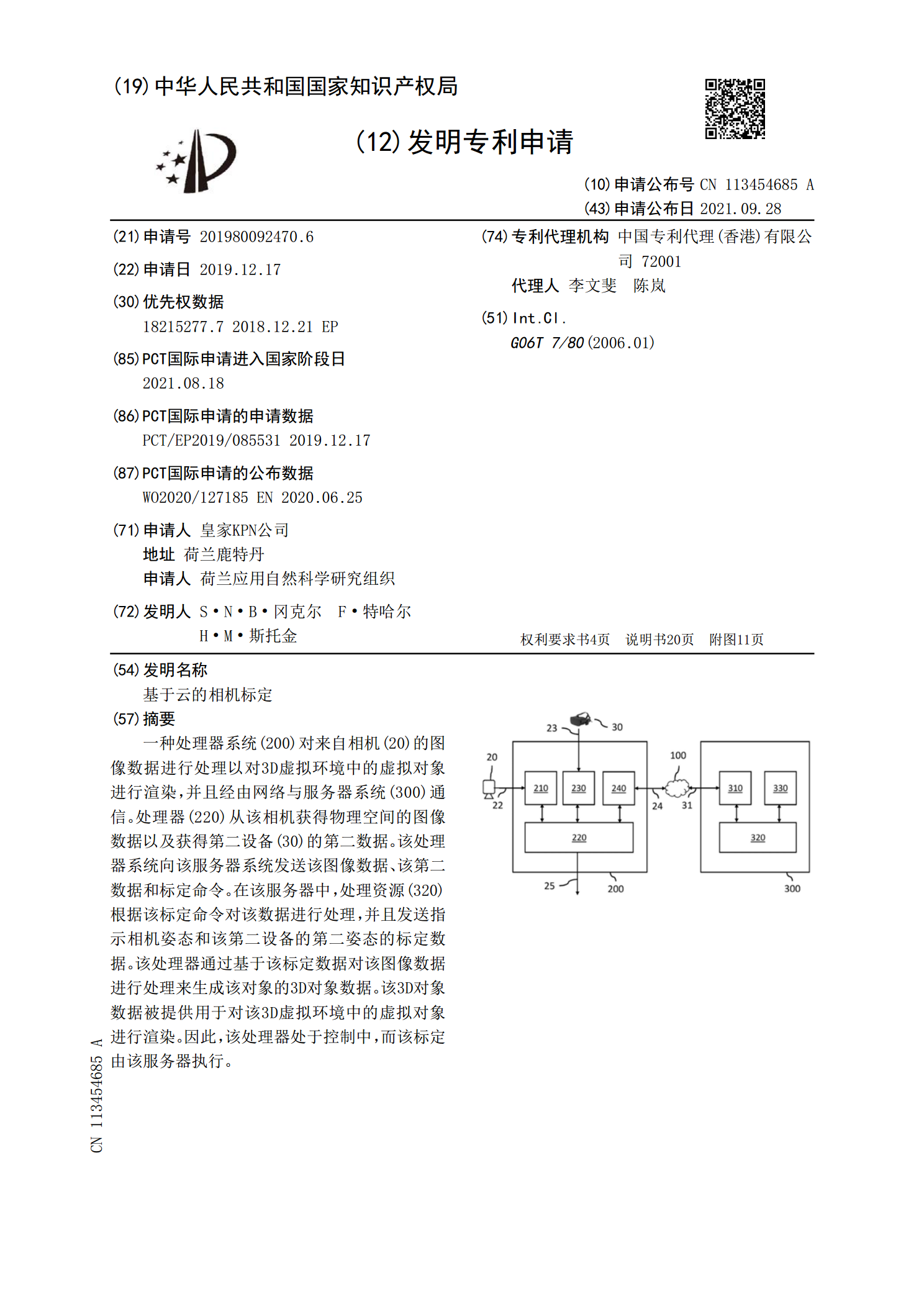

一种处理器系统(200)对来自相机(20)的图像数据进行处理以对3D虚拟环境中的虚拟对象进行渲染,并且经由网络与服务器系统(300)通信。处理器(220)从该相机获得物理空间的图像数据以及获得第二设备(30)的第二数据。该处理器系统向该服务器系统发送该图像数据、该第二数据和标定命令。在该服务器中,处理资源(320)根据该标定命令对该数据进行处理,并且发送指示相机姿态和该第二设备的第二姿态的标定数据。该处理器通过基于该标定数据对该图像数据进行处理来生成该对象的3D对象数据。该3D对象数据被提供用于对该3D虚

基于单目相机的旋转对称目标视觉测量的任务书.docx

基于单目相机的旋转对称目标视觉测量的任务书一、任务背景随着现代工业的高速发展,对于复杂旋转对称目标的视觉测量需求逐渐增大,尤其是在航空航天、汽车制造、机器人等领域,旋转对称目标的测量已经成为了不可或缺的一部分。然而,在目前的实际工程中,采用传统测量方法,如手工测量或者三坐标测量等,由于存在测量复杂、工序繁琐、数据不准确等问题,无法满足工业界对测量效率、准确性、可靠性等方面的要求。因此,如何提高旋转对称目标视觉测量中的效率和准确度,是一个亟待解决的问题。二、任务目标本次任务的目标是基于单目相机完成对旋转对称

基于场景的相机自标定研究.docx

基于场景的相机自标定研究摘要随着计算机视觉和机器学习的发展,相机自标定在物体识别、场景分析和机器人导航等方面被广泛应用。本论文旨在介绍基于场景的相机自标定研究的现状、问题和应用,以及未来可能的发展方向。我们综合了国内外的相关研究成果,分析其中的优点和缺点,探讨其应用实践,希望为相机自标定的研究和实践提供一些有益的思考和启示。关键词:相机自标定、基于场景、物体识别、场景分析、机器人导航引言相机自标定是指在不依赖外界传感器的情况下,仅使用相机自己的数据和内部参数,估计出相机的内部和外部参数。其优点在于不受外部