一种基于Transformer的多轮对话生成方法.pdf

邻家****mk

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

一种基于Transformer的多轮对话生成方法.pdf

本发明提供了一种基于Transformer的多轮对话生成方法。本方法首先输入一句话,本句上文对话历史,以及涉及到本句的领域文本文档内容;利用Transformer编码器,将上文对话历史与整合的文本文件作为模型的输入;使用Transformer解码器,对上一步编码器的输出进行解码,生成多轮对话所需的对话回复;将回复输出到系统。本方法发明将涉及到的某一或某些领域整合成一个文本文件,作为模型输入的一部分,与上文对话历史一并进行输入。提高了模型训练的准确性,丰富了对话语义。

基于Transformer指针抽取的人机多轮对话改写方法.pdf

本发明公开了一种基于Transformer指针抽取的人机多轮对话改写方法,其实现步骤为:构造文本语义相关性识别网络和语义缺失文本改写网络;生成训练集;训练文本语义相关性识别网络和语义缺失文本改写网络;判断用户输入文本间语义是否相关;改写语义缺失文本。本发明利用Transformer的预训练模型进行特征提取并编码,利用通过指针地址抽取文本关键信息内容的技术思路对用户文本进行改写。使得本发明具有可以判断是否需要对用户当前输入文本进行改写、改写用户语义缺失文本质量高、耗时短的优点,可用于人机多轮对话领域中对语义

一种基于对话历史建模的多轮对话生成方法及装置.pdf

一种基于对话历史建模的多轮对话生成方法及装置,属于人工智能领域,其特征在于,利用对话历史中各语句之间的显式回复关系对对话历史的语义表示过程进行优化获取近邻感知的对话历史语义表示;利用面向对话历史的注意力机制使查询语句自动从对话历史中吸收相关语义信息,得到对话历史增强的查询语义表示;再根据本申请新增的近邻感知的对话历史语义表示、及对话历史增强的查询语义表示通过神经网络逐词生成回复语句,能够有效捕捉对话历史中篇章级别的连贯语义关系,缓解对话历史建模的长期依赖问题和记忆延迟问题,并充分挖掘了查询语句在捕捉当前对

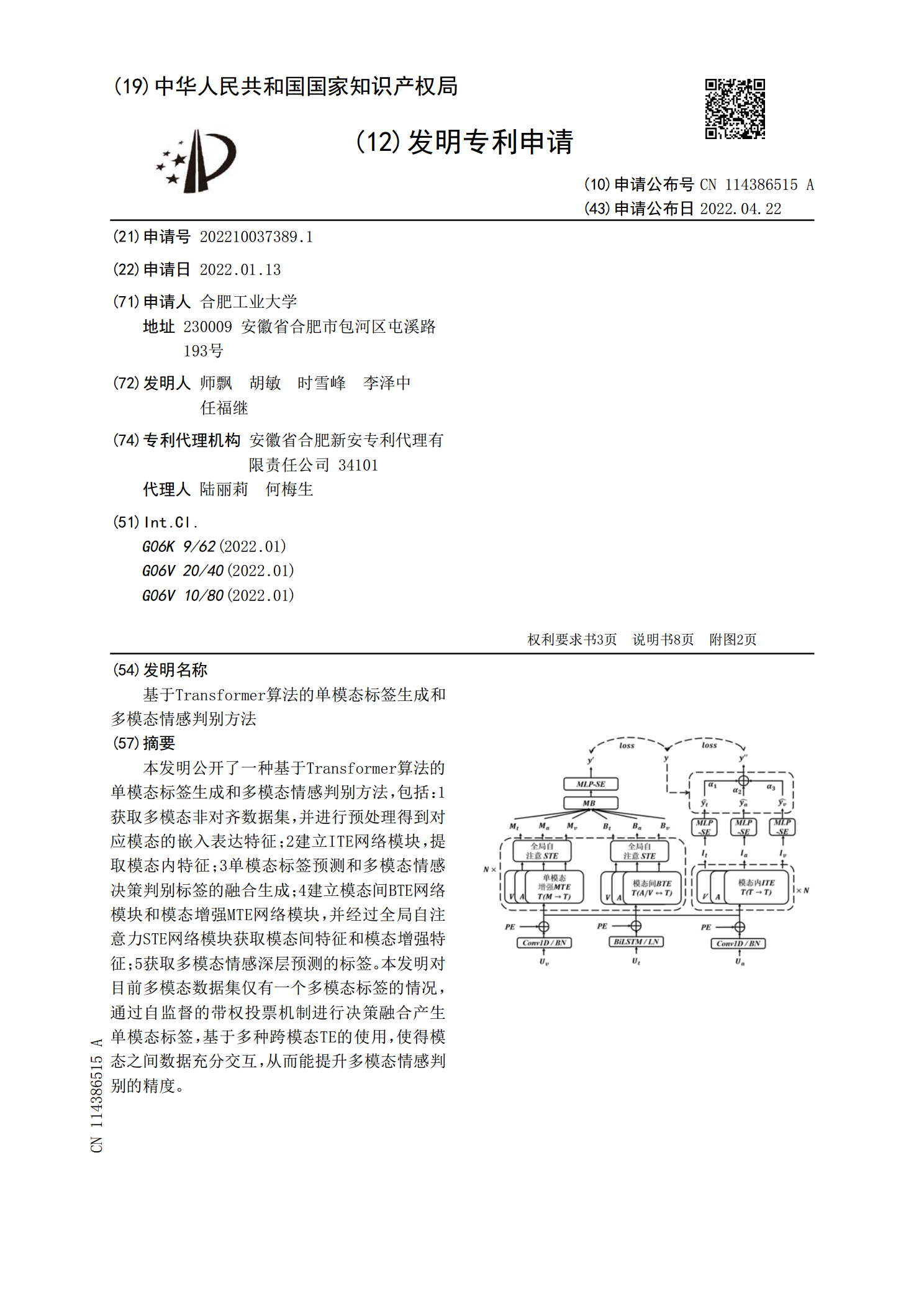

基于Transformer算法的单模态标签生成和多模态情感判别方法.pdf

本发明公开了一种基于Transformer算法的单模态标签生成和多模态情感判别方法,包括:1获取多模态非对齐数据集,并进行预处理得到对应模态的嵌入表达特征;2建立ITE网络模块,提取模态内特征;3单模态标签预测和多模态情感决策判别标签的融合生成;4建立模态间BTE网络模块和模态增强MTE网络模块,并经过全局自注意力STE网络模块获取模态间特征和模态增强特征;5获取多模态情感深层预测的标签。本发明对目前多模态数据集仅有一个多模态标签的情况,通过自监督的带权投票机制进行决策融合产生单模态标签,基于多种跨模态T

一种基于多领域多轮问答的对话状态跟踪方法.pdf

本发明提供一种基于多领域多轮问答的对话状态跟踪方法,该方法包括下列步骤:S1、建立对话状态模型,并对所述对话状态模型进行编码;S2、基于DomainInterestPrediction模块对对话回合的兴趣领域进行判断;S3、通过SlotgatePrediction模块对每一个slottype生成value值的方式进行判断;S4、基于SpanPrediction模块对slot中的value值进行预测,并最终生成word。