一种基于对话历史建模的多轮对话生成方法及装置.pdf

雨巷****怡轩

亲,该文档总共23页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

一种基于对话历史建模的多轮对话生成方法及装置.pdf

一种基于对话历史建模的多轮对话生成方法及装置,属于人工智能领域,其特征在于,利用对话历史中各语句之间的显式回复关系对对话历史的语义表示过程进行优化获取近邻感知的对话历史语义表示;利用面向对话历史的注意力机制使查询语句自动从对话历史中吸收相关语义信息,得到对话历史增强的查询语义表示;再根据本申请新增的近邻感知的对话历史语义表示、及对话历史增强的查询语义表示通过神经网络逐词生成回复语句,能够有效捕捉对话历史中篇章级别的连贯语义关系,缓解对话历史建模的长期依赖问题和记忆延迟问题,并充分挖掘了查询语句在捕捉当前对

一种多轮对话模型训练方法、多轮对话的生成方法及装置.pdf

本申请提供了一种多轮对话模型训练方法、多轮对话的生成方法及装置,通过获取任务场景,并根据获取到的任务场景预设意图类型数据、槽位种子模板、机器人行为以及与所述机器人行为对应的机器人回复数据,并构建多轮对话策略图,根据所述多轮对话策略图构建多轮对话数据集,由于多轮对话数据集可以通过多轮对话策略图中包含的元素以及数据进行自动生成,所以降低了训练样本形成过程中的人工参与程度,提高了模型训练效率。

一种基于Transformer的多轮对话生成方法.pdf

本发明提供了一种基于Transformer的多轮对话生成方法。本方法首先输入一句话,本句上文对话历史,以及涉及到本句的领域文本文档内容;利用Transformer编码器,将上文对话历史与整合的文本文件作为模型的输入;使用Transformer解码器,对上一步编码器的输出进行解码,生成多轮对话所需的对话回复;将回复输出到系统。本方法发明将涉及到的某一或某些领域整合成一个文本文件,作为模型输入的一部分,与上文对话历史一并进行输入。提高了模型训练的准确性,丰富了对话语义。

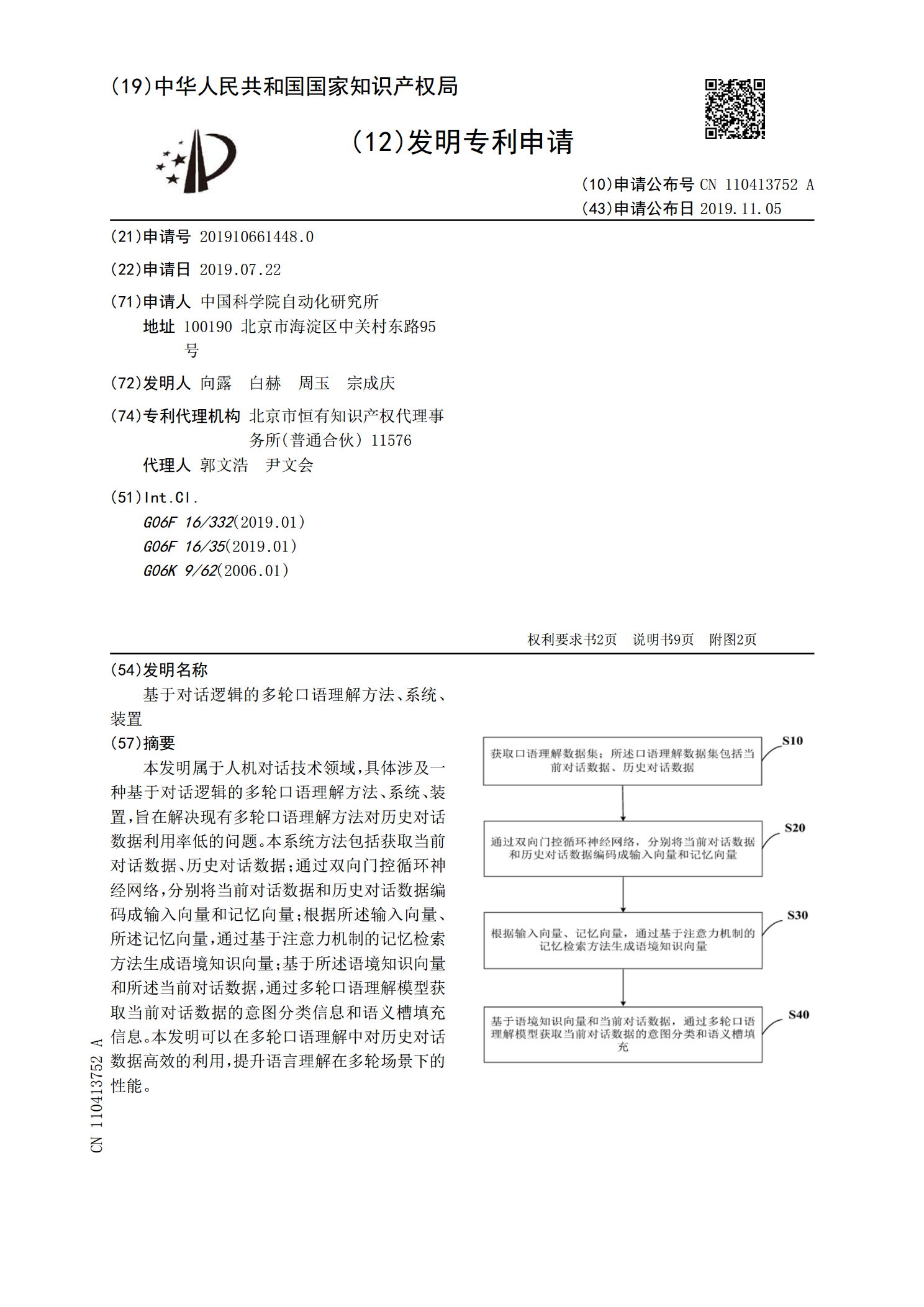

基于对话逻辑的多轮口语理解方法、系统、装置.pdf

本发明属于人机对话技术领域,具体涉及一种基于对话逻辑的多轮口语理解方法、系统、装置,旨在解决现有多轮口语理解方法对历史对话数据利用率低的问题。本系统方法包括获取当前对话数据、历史对话数据;通过双向门控循环神经网络,分别将当前对话数据和历史对话数据编码成输入向量和记忆向量;根据所述输入向量、所述记忆向量,通过基于注意力机制的记忆检索方法生成语境知识向量;基于所述语境知识向量和所述当前对话数据,通过多轮口语理解模型获取当前对话数据的意图分类信息和语义槽填充信息。本发明可以在多轮口语理解中对历史对话数据高效的利

一种对话生成方法及装置.pdf

本发明实施例公开了一种对话生成方法,包括:将第K轮询问句中的每个字转化为第一词向量,并根据第一词向量计算每个字的正向隐层向量和反向隐层向量;获取第K轮询问句的内容主题,并将内容主题转化为第二词向量;根据第二词向量、第K轮询问句中最后一个字的正向隐层向量、针对第K‑1轮询问句输出的第K‑1轮答复句中最后一个字的隐层向量、以及针对第K‑1轮询问句输出的第K‑1轮答复句的初始隐层向量,确定针对第K轮询问句输出的初始隐层向量;根据第K轮询问句中每个字的正向隐层向量和反向隐层向量、以及针对第K轮询问句输出的初始隐层