基于深度强化学习和块规划的月面路径规划系统和方法.pdf

和裕****az

亲,该文档总共19页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

基于深度强化学习和块规划的月面路径规划系统和方法.pdf

本发明公开了一种基于深度强化学习和块规划的月面路径规划方法,用于月面机器人在大范围月面地形中的快速路径规划。基于深度强化学习方法,提出了一种端到端的路径规划器,能够基于特定尺寸的月面可穿越性地图和机器人位置、目标位置,直接求解当前最佳运动方向。基于分层思想,设计一种块规划应用架构,首先利用块规划器在缩小地图上进行粗略初始路径规划,然后利用块规划器沿着初始路径进行分块精确路径规划。块规划应用架构能够有效压缩求解空间,显著降低路径规划时耗。本发明主要用于月面大范围遥测地形图上的机器人路径规划,通过端到端规划器

一种基于深度强化学习的最优路径规划的方法和系统.pdf

本发明涉及通信领域,特别是涉及一种基于深度强化学习的最优路径规划的方法和系统。主要包括:建立路由器状态矩阵,使用每次路径规划后的全部路由器状态矩阵迭代建立训练数据集;以每条可行路径执行后指定数量周期中每个周期全网的平均吞吐量之和为Reward,对强化学习模型进行训练;使用训练后的模型建立最优路径树,通过最优路径树进行路由路径选择获取最优路径;根据最优路径将数据包由源路由器发送至目的路由器后,获取下一时刻路由器状态矩阵,对训练数据集进行迭代更新,并使用更新后的训练数据集重新训练模型。本发明可以根据网络中所有

一种基于学生学业大数据系统的学习路径规划系统和方法.pdf

本发明涉及一种基于学生学业大数据系统的学习路径规划系统和方法,该智能课表系统包括服务器,服务器内设有数据处理器,该数据处理器上连接有若干维护存储模块;所述服务器与显示模块、操控模块以及信息采集端口连接。通过该智能课表系统可以进行网上查询课程介绍、课时安排、课程类别、录取级别以及实施进度等信息,并可网上申报课程和志愿填报,然后网上查询结构、学分认定以及课表安排等,对于学校、老师以及学生均非常方便、实用。此外,本系统还可与智能终端进行通讯连接,使用者通过其智能手机便可完成相关的查询等操作。

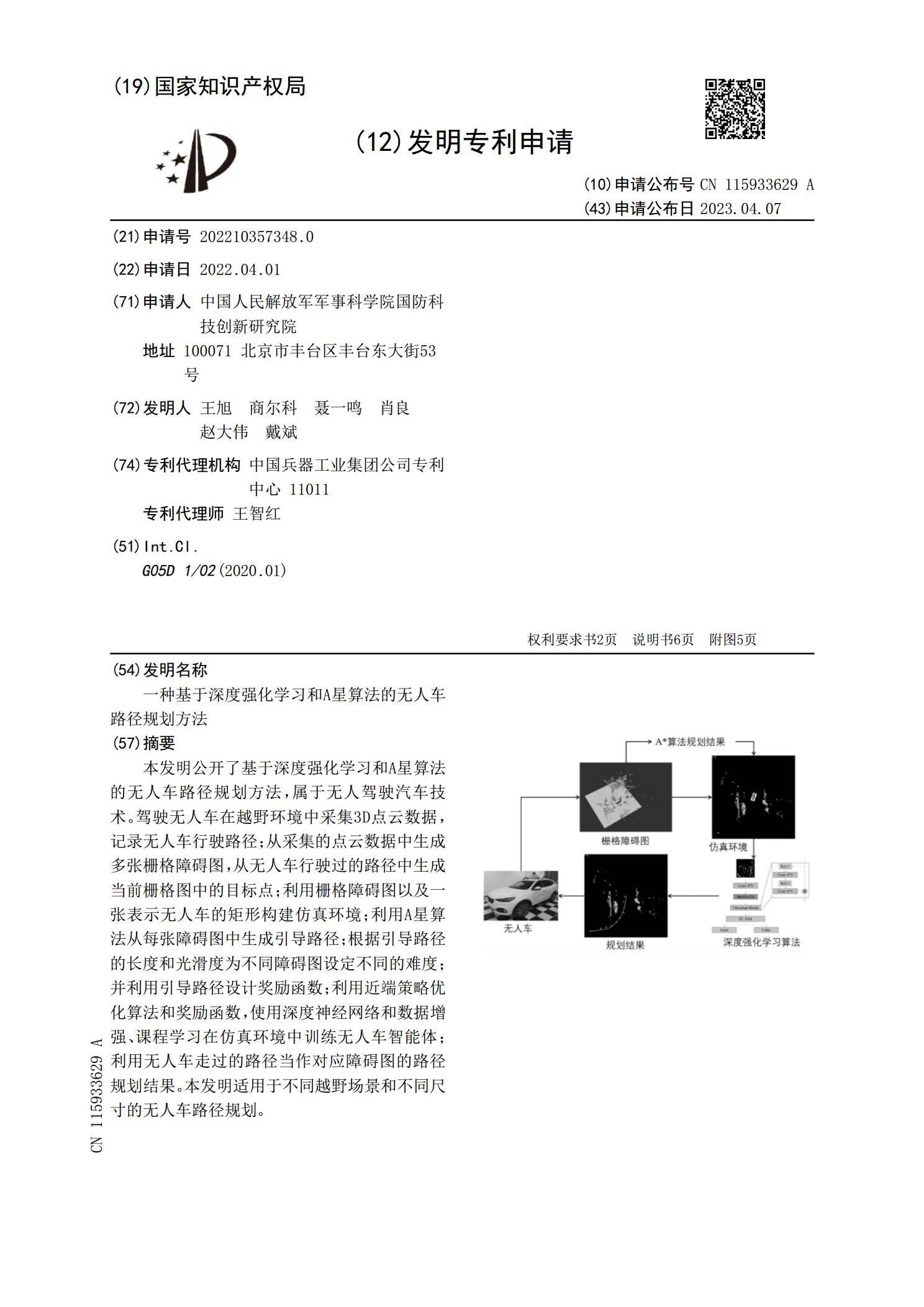

一种基于深度强化学习和A星算法的无人车路径规划方法.pdf

本发明公开了基于深度强化学习和A星算法的无人车路径规划方法,属于无人驾驶汽车技术。驾驶无人车在越野环境中采集3D点云数据,记录无人车行驶路径;从采集的点云数据中生成多张栅格障碍图,从无人车行驶过的路径中生成当前栅格图中的目标点;利用栅格障碍图以及一张表示无人车的矩形构建仿真环境;利用A星算法从每张障碍图中生成引导路径;根据引导路径的长度和光滑度为不同障碍图设定不同的难度;并利用引导路径设计奖励函数;利用近端策略优化算法和奖励函数,使用深度神经网络和数据增强、课程学习在仿真环境中训练无人车智能体;利用无人车

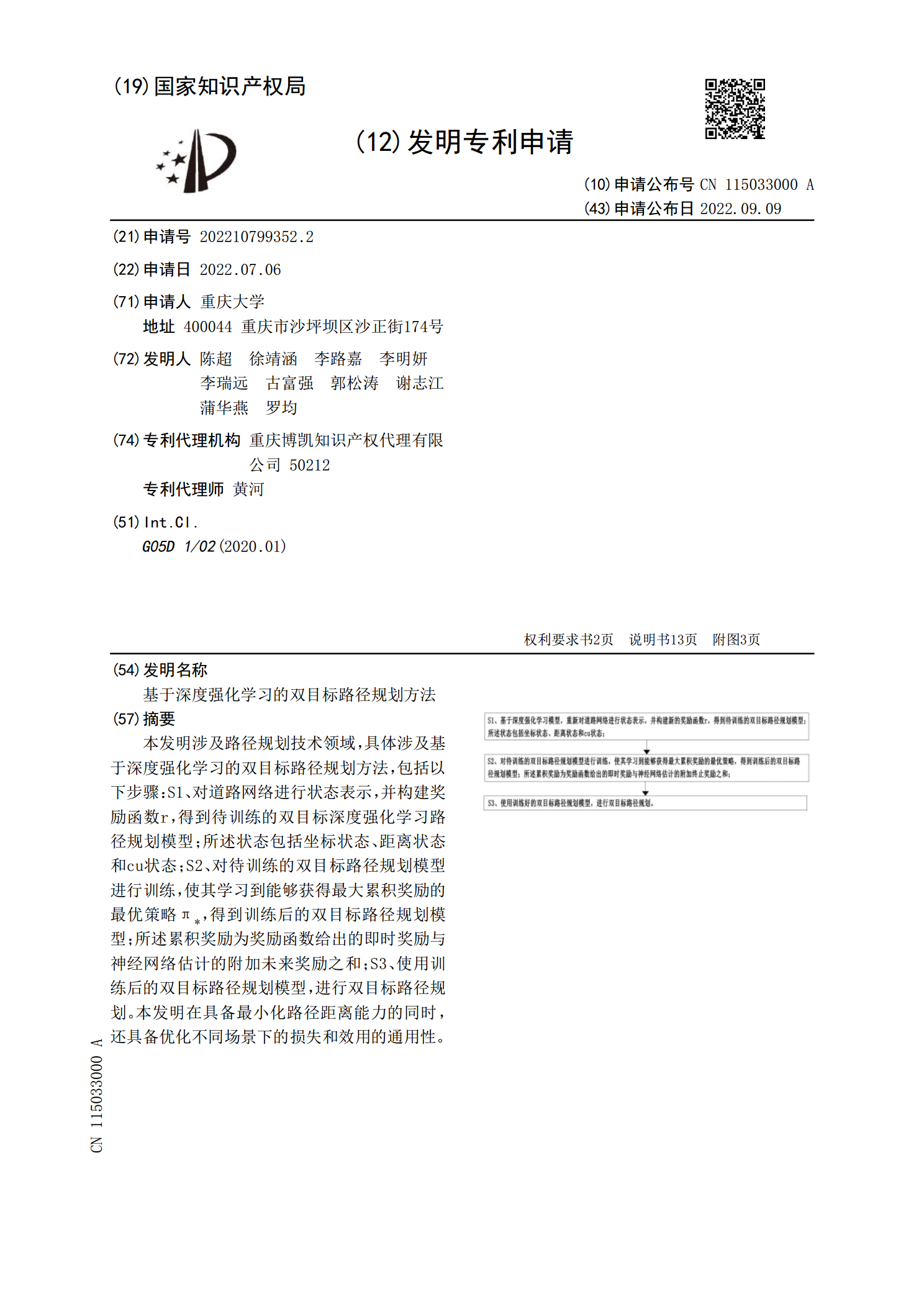

基于深度强化学习的双目标路径规划方法.pdf

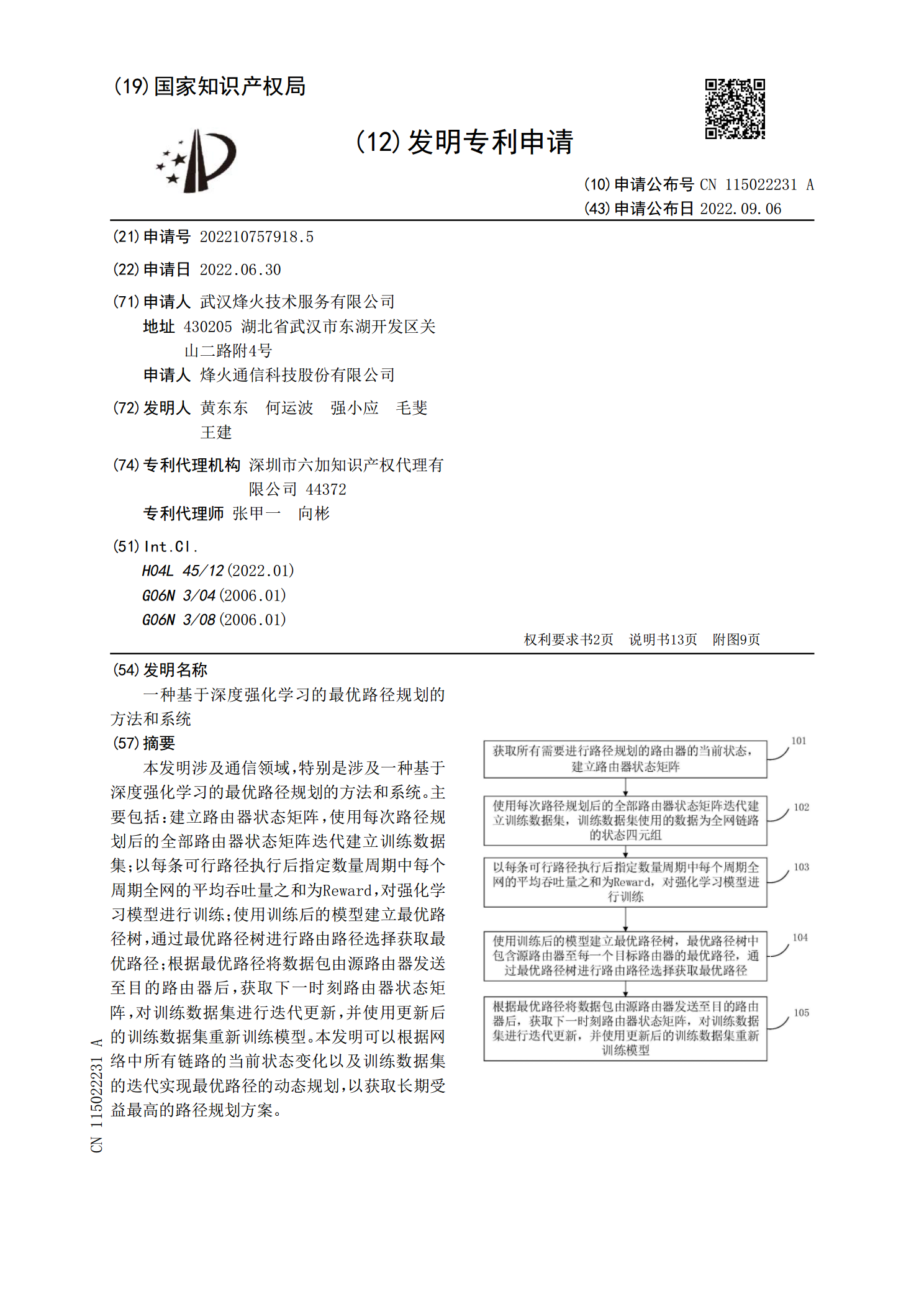

本发明涉及路径规划技术领域,具体涉及基于深度强化学习的双目标路径规划方法,包括以下步骤:S1、对道路网络进行状态表示,并构建奖励函数r,得到待训练的双目标深度强化学习路径规划模型;所述状态包括坐标状态、距离状态和cu状态;S2、对待训练的双目标路径规划模型进行训练,使其学习到能够获得最大累积奖励的最优策略π