一种基于深度学习的非合作目标相对位姿测量方法、系统.pdf

念珊****写意

亲,该文档总共19页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

一种基于深度学习的非合作目标相对位姿测量方法、系统.pdf

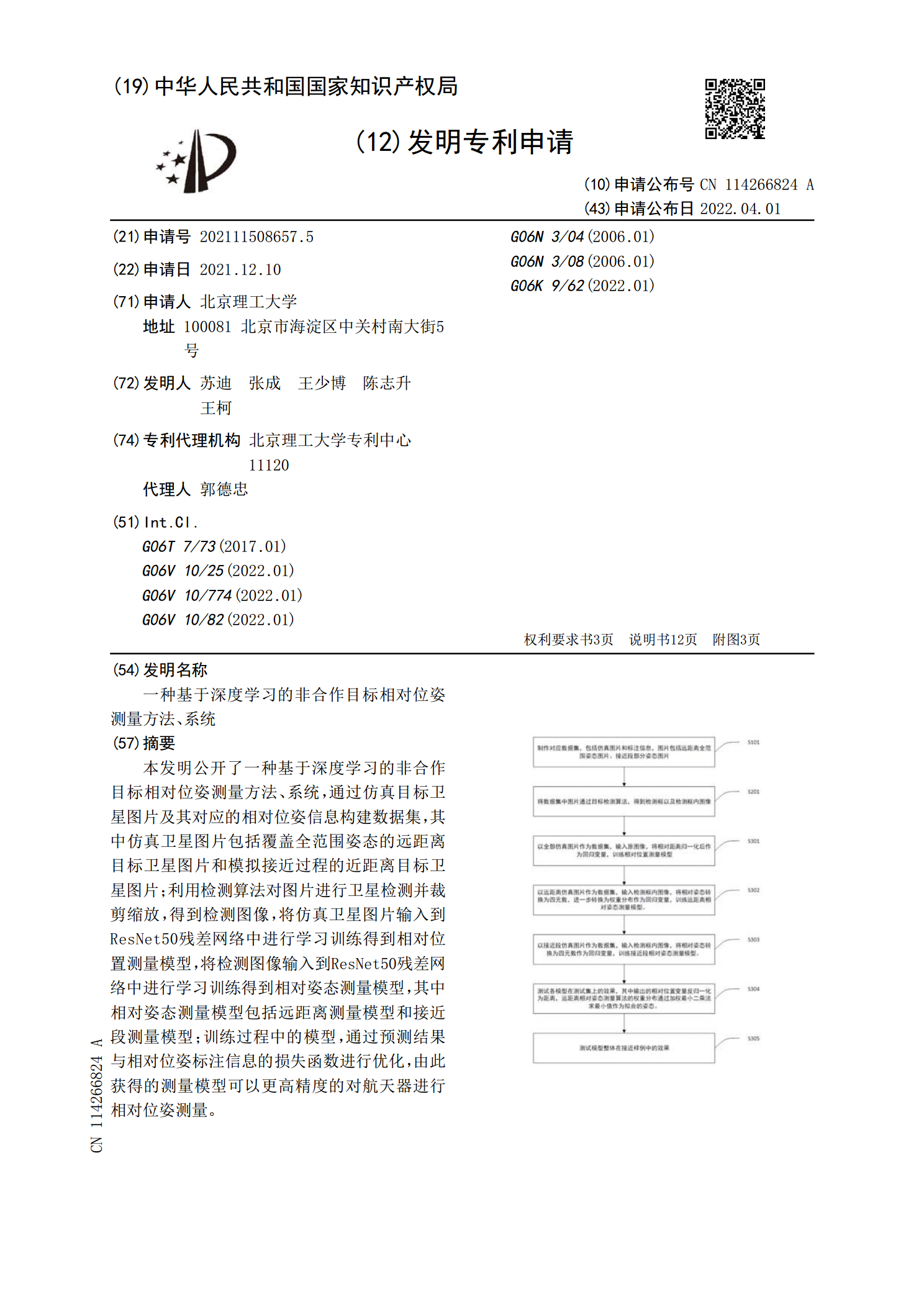

本发明公开了一种基于深度学习的非合作目标相对位姿测量方法、系统,通过仿真目标卫星图片及其对应的相对位姿信息构建数据集,其中仿真卫星图片包括覆盖全范围姿态的远距离目标卫星图片和模拟接近过程的近距离目标卫星图片;利用检测算法对图片进行卫星检测并裁剪缩放,得到检测图像,将仿真卫星图片输入到ResNet50残差网络中进行学习训练得到相对位置测量模型,将检测图像输入到ResNet50残差网络中进行学习训练得到相对姿态测量模型,其中相对姿态测量模型包括远距离测量模型和接近段测量模型;训练过程中的模型,通过预测结果与相

一种基于TOF相机的空间合作目标相对位姿测量方法.docx

一种基于TOF相机的空间合作目标相对位姿测量方法标题:基于TOF相机的空间合作目标相对位姿测量方法摘要:空间合作是现代科技应用中的一个重要领域,其中实现目标相对位姿测量是一个关键问题。本文提出了一种基于TOF(Time-of-Flight)相机的空间合作目标相对位姿测量方法。该方法利用TOF相机获取目标表面的深度图像,并从中提取表面特征,然后使用特征匹配的方法计算目标之间的相对位姿。实验结果表明,该方法能够精确地测量目标之间的相对位姿。关键词:TOF相机、空间合作、目标相对位姿、深度图像、特征匹配引言:空

基于点云的空间非合作目标初始相对位姿获取.docx

基于点云的空间非合作目标初始相对位姿获取基于点云的空间非合作目标初始相对位姿获取摘要近年来,点云处理技术在机器人、自动驾驶以及虚拟现实等领域中得到了广泛的应用。其中,点云的非合作目标初始相对位姿获取是一个关键问题。该问题指的是在没有任何先验信息的情况下,寻找点云场景中两个非连续目标之间的相对位姿。本文提出了一种基于点云的空间非合作目标初始相对位姿获取算法。该算法通过点云的特征提取、匹配和优化三个步骤实现目标初始相对位姿的获取。本文采用KITTI数据集进行了实验,结果表明该算法具有较好的效果和鲁棒性。关键词

一种基于多源信息融合的非合作航天器相对位姿测量方法.pdf

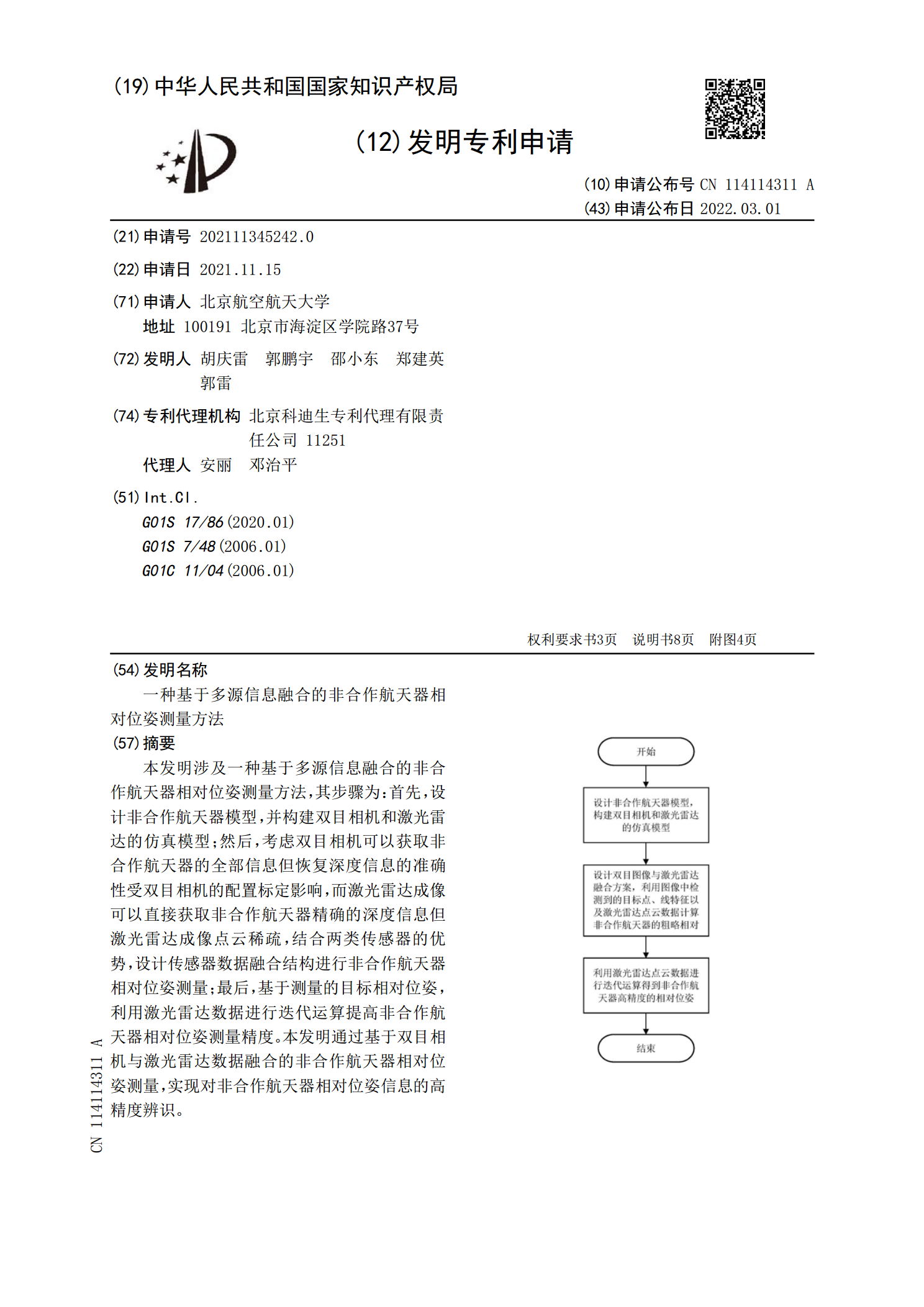

本发明涉及一种基于多源信息融合的非合作航天器相对位姿测量方法,其步骤为:首先,设计非合作航天器模型,并构建双目相机和激光雷达的仿真模型;然后,考虑双目相机可以获取非合作航天器的全部信息但恢复深度信息的准确性受双目相机的配置标定影响,而激光雷达成像可以直接获取非合作航天器精确的深度信息但激光雷达成像点云稀疏,结合两类传感器的优势,设计传感器数据融合结构进行非合作航天器相对位姿测量;最后,基于测量的目标相对位姿,利用激光雷达数据进行迭代运算提高非合作航天器相对位姿测量精度。本发明通过基于双目相机与激光雷达数据

基于SoftPOSIT算法的单目视觉非合作目标相对位姿估计.docx

基于SoftPOSIT算法的单目视觉非合作目标相对位姿估计随着无人机、机器人等智能机器的广泛应用,单目视觉非合作目标相对位姿估计技术逐渐成为研究的热点。非合作目标指的是没有特定标志或标记的场景中的目标。目标相对位姿估计是指在视觉系统检测到目标之后,推算出视觉相机与目标之间的空间位置关系。本文将介绍基于SoftPOSIT算法的单目视觉非合作目标相对位姿估计技术。一、技术原理单目相机测量目标相对位姿的方法主要分为三类:基于几何模型的方法、基于统计学习的方法和基于视觉SLAM的方法。其中,基于几何模型的方法是最