一种人体图像关键点姿态估计方法.pdf

书生****12

亲,该文档总共18页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

一种人体图像关键点姿态估计方法.pdf

本发明公开了一种人体图像关键点姿态估计方法,包括:对输入的训练图像预处理,用基于空洞卷积的大感受野特征金字塔网络的行人检测网络对输入图像进行检测;将检测到的人体形成的边界框进行裁剪,只保留框内图像;将裁剪后图像输入到设计的模型中,进行人体姿态关键点估计。本发明可以将含有人体的输入图像进行关键点生成,并且生成估计处理后的图像中生成的人体关键点具有较高精度较好保持了人体的骨架几何信息。

一种人体图像关键点姿态估计方法.pdf

本发明公开一种人体图像关键点姿态估计方法。包括步骤:对输入的训练图像预处理,用基于特征金字塔网络的行人检测网络对输入图像进行检测;将检测到的人体形成的边界框进行裁剪,只保留框内图像;将裁剪后图像输入到设计的模型中,进行人体姿态关键点估计。本发明可以将含有人体的输入图像进行关键点生成,并且生成估计处理后的图像中生成的人体关键点具有较高精度,较好保持了人体的骨架几何信息。

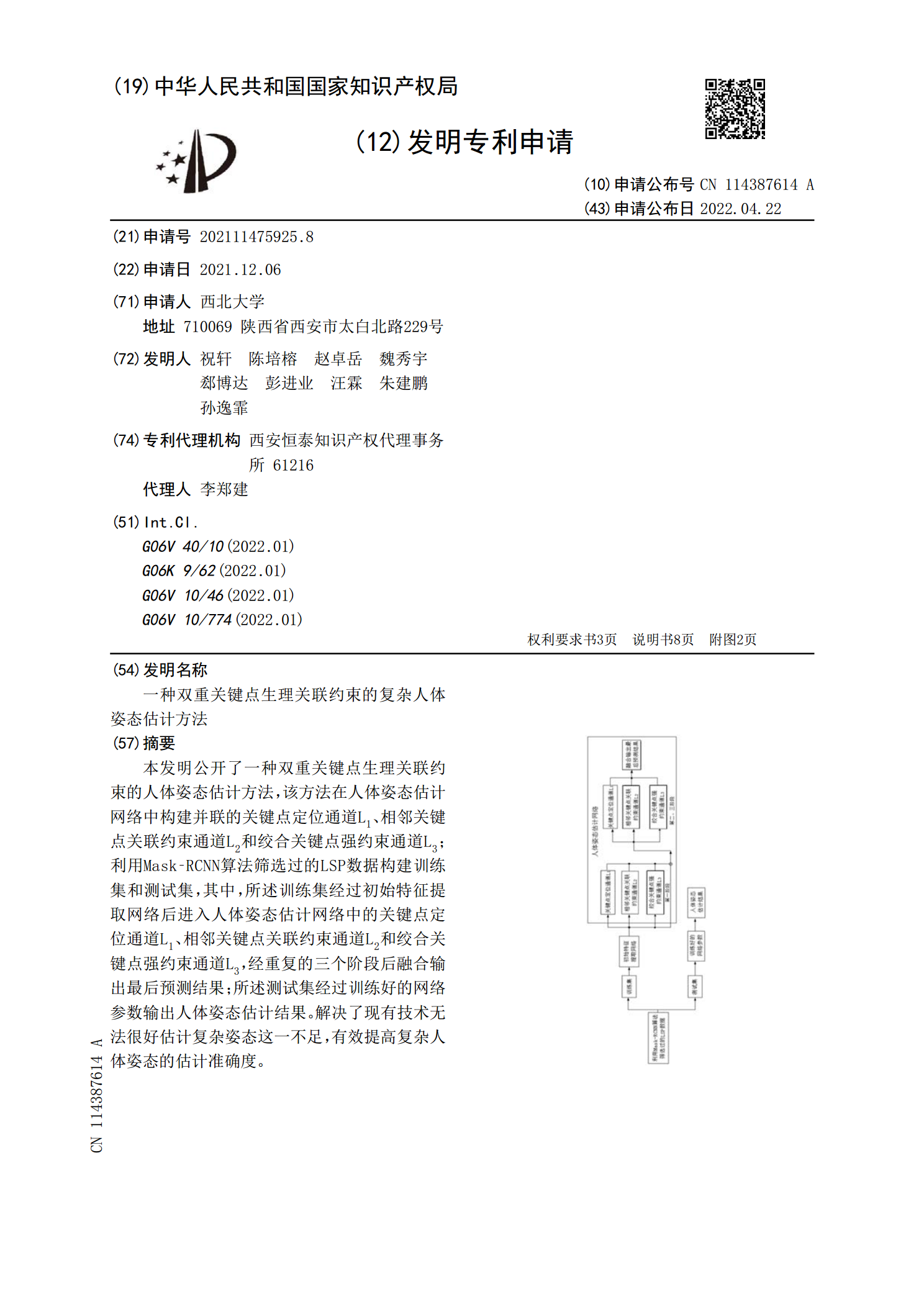

一种双重关键点生理关联约束的复杂人体姿态估计方法.pdf

本发明公开了一种双重关键点生理关联约束的人体姿态估计方法,该方法在人体姿态估计网络中构建并联的关键点定位通道L<base:Sub>1</base:Sub>、相邻关键点关联约束通道L<base:Sub>2</base:Sub>和绞合关键点强约束通道L<base:Sub>3</base:Sub>;利用Mask?RCNN算法筛选过的LSP数据构建训练集和测试集,其中,所述训练集经过初始特征提取网络后进入人体姿态估计网络中的关键点定位通道L<base:Sub>1</base:Sub>、相邻关键点关联约束通道L<b

一种基于事件点云的人体姿态估计方法.pdf

一种基于事件点云的人体姿态估计方法,包括以下步骤:1)从事件相机中获取原始事件流;2)将事件流下采样到固定数量并进行归一化处理;3)构建双分支图特征学习模块(DDGCNN):3.1)构建几何图;3.2)构建特征图;3.3)特征聚合;4)构建Transformer编码模块(TE);5)设计最近邻下采样模块CP;6)对得到的1D点的特征,利用重映射(FRM)模块,映射到2D特征空间中。7)利用2D特征回归出Heatmap,进一步利用极大值响应得到人体姿态。

人体姿态估计方法及设备.pdf

本申请提供了一种人体姿态估计方法及设备,能够将第二人体姿态估计模型所得到的人体关键点第二信息用于指导第一人体姿态估计模型的模型训练,从而以知识蒸馏的方式将第二人体姿态估计模型学习到的人体关键点知识传授给第一人体姿态估计模型,从而提高了第一人体姿态估计模型的人体关键点估计精度,同时保留了第一姿态估计模型较快的测试速度,能够实现实时的人体姿态估计。