一种潜在信息约束的非负矩阵分解方法.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

一种潜在信息约束的非负矩阵分解方法.docx

一种潜在信息约束的非负矩阵分解方法一种潜在信息约束的非负矩阵分解方法摘要:非负矩阵分解(NMF)是一种有效的数据降维和特征提取方法,通过将一个非负矩阵分解为两个非负矩阵的乘积来实现。然而,传统的NMF方法没有对潜在信息进行显式的约束,导致分解结果缺乏解释性和可解释性。为了克服这个问题,本文提出了一种潜在信息约束的非负矩阵分解方法。该方法在传统NMF的基础上引入了潜在信息的先验知识,并通过最小化预定义的信息损失函数来约束分解的结果。实验证明,该方法不仅能够提高NMF的解释性和可解释性,还能够更好地保持数据的

基于约束非负矩阵分解的符号网络社团发现方法.pptx

汇报人:/目录0102约束非负矩阵分解的定义符号网络社团发现的意义约束非负矩阵分解在社团发现中的应用03非负矩阵分解的基本原理约束条件的引入和作用社团结构的生成算法流程社团质量评估方法04数据预处理步骤矩阵分解和优化过程社团结构的可视化展示社团发现结果的应用场景05与传统社团发现方法的比较约束非负矩阵分解的优势约束非负矩阵分解的局限性对未来改进方向的探讨06实证数据的选择和预处理社团发现结果展示和解释结果的评估和比较分析对实证结果的应用价值探讨汇报人:

基于约束非负矩阵分解的符号网络社团发现方法.docx

基于约束非负矩阵分解的符号网络社团发现方法基于约束非负矩阵分解的符号网络社团发现方法摘要:随着社交网络的快速发展,社团结构的发现变得越来越重要。社团发现是一种对网络中节点进行聚类的方法,旨在找到具有紧密连接的节点集合。在本文中,我们提出了一种基于约束非负矩阵分解的符号网络社团发现方法。通过将社交网络表示为一个包含节点间关系信息的符号矩阵,并结合非负矩阵分解的思想,我们可以有效地发现社团结构。我们还引入了约束来保证所得的社团分解结果的准确性和可解释性。实验证明,我们的方法在不同类型的符号网络上具有较高的性能

双约束非负矩阵分解的复合故障信号分离方法.docx

双约束非负矩阵分解的复合故障信号分离方法Title:CompositeFaultSignalSeparationusingBi-constrainedNon-negativeMatrixFactorizationAbstract:Inrecentyears,theanalysisandseparationoffaultsignalsfromnoisymeasurementshavegainedsignificantattentioninvariousfields,suchasfaultdiagnosis,

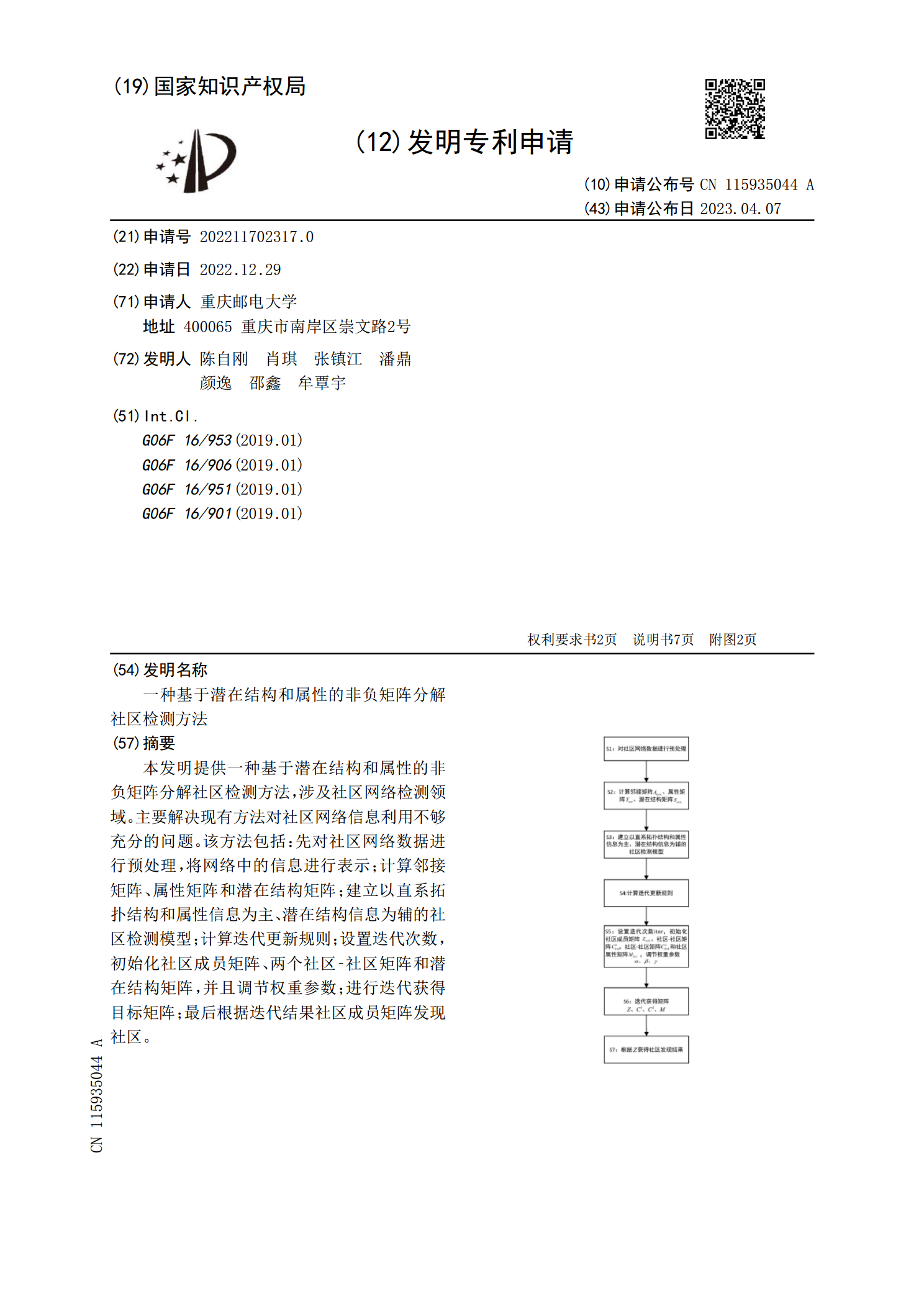

一种基于潜在结构和属性的非负矩阵分解社区检测方法.pdf

本发明提供一种基于潜在结构和属性的非负矩阵分解社区检测方法,涉及社区网络检测领域。主要解决现有方法对社区网络信息利用不够充分的问题。该方法包括:先对社区网络数据进行预处理,将网络中的信息进行表示;计算邻接矩阵、属性矩阵和潜在结构矩阵;建立以直系拓扑结构和属性信息为主、潜在结构信息为辅的社区检测模型;计算迭代更新规则;设置迭代次数,初始化社区成员矩阵、两个社区‑社区矩阵和潜在结构矩阵,并且调节权重参数;进行迭代获得目标矩阵;最后根据迭代结果社区成员矩阵发现社区。