基于多视角卷积神经网络的三维模型分类方法.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于多视角卷积神经网络的三维模型分类方法.docx

基于多视角卷积神经网络的三维模型分类方法摘要本文针对三维模型分类问题,提出了一种基于多视角卷积神经网络(MVCNN)的分类方法。首先,将三维模型从不同视角转化为二维图片。然后,使用MVCNN网络对这些图片进行训练,最终得到分类结果。实验结果表明,本文方法具有较高的分类准确性和较快的分类速度。关键词:三维模型,分类,卷积神经网络,多视角引言随着三维模型的广泛应用,对三维模型的分类和识别问题越来越受到关注。三维模型分类是指将三维模型分为不同的类别,其应用于计算机视觉、虚拟现实、游戏开发等领域。三维模型分类的关

基于卷积神经网络的三维模型分类方法及系统.pdf

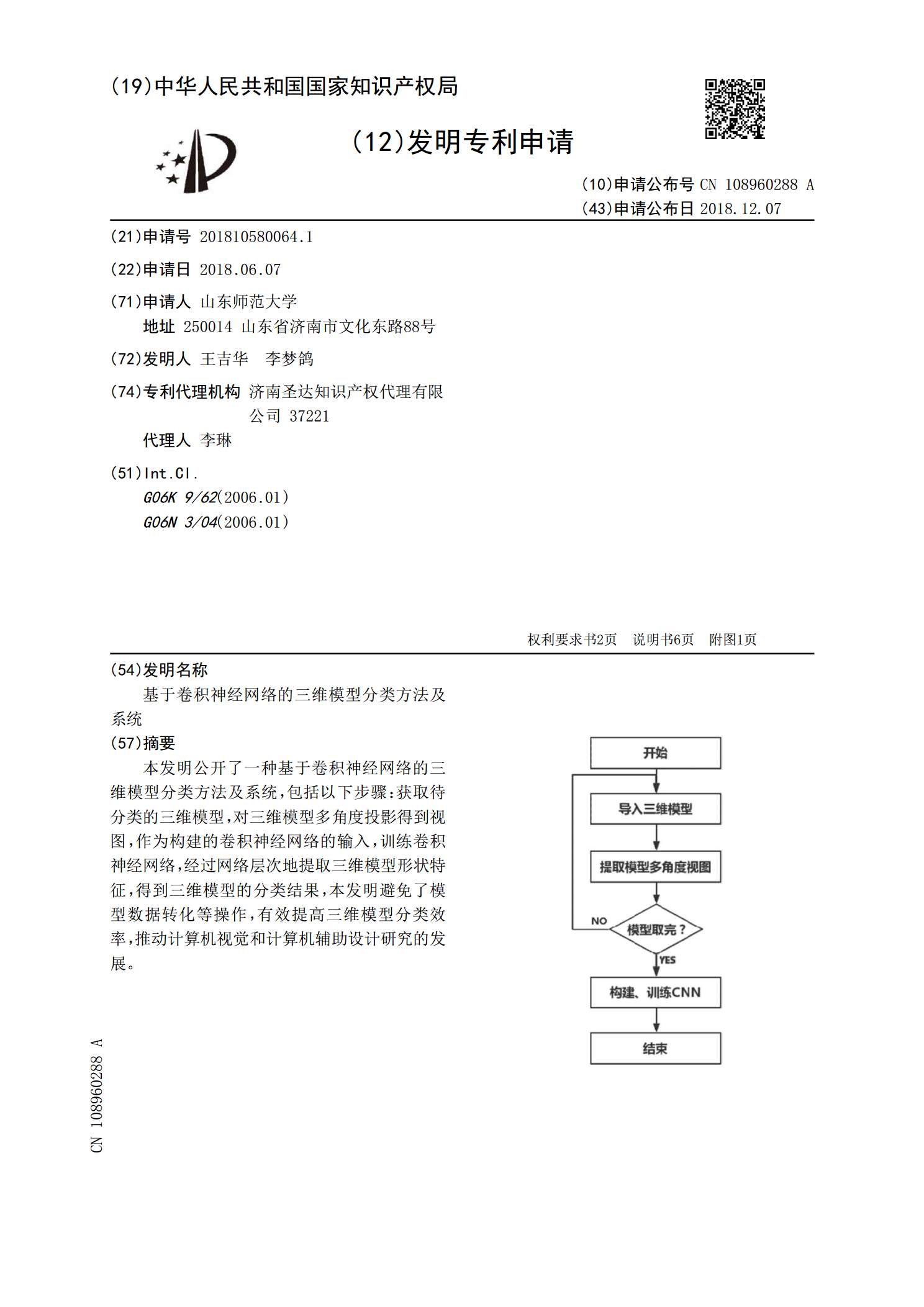

本发明公开了一种基于卷积神经网络的三维模型分类方法及系统,包括以下步骤:获取待分类的三维模型,对三维模型多角度投影得到视图,作为构建的卷积神经网络的输入,训练卷积神经网络,经过网络层次地提取三维模型形状特征,得到三维模型的分类结果,本发明避免了模型数据转化等操作,有效提高三维模型分类效率,推动计算机视觉和计算机辅助设计研究的发展。

基于卷积神经网络的三维CAD模型分类.docx

基于卷积神经网络的三维CAD模型分类标题:基于卷积神经网络的三维CAD模型分类摘要:随着三维计算机辅助设计(CAD)技术的广泛应用,大量的三维CAD模型被创建和使用。然而,对于大规模的三维CAD模型数据库来说,准确、高效地进行分类和检索是一个重要挑战。本文提出一种基于卷积神经网络(CNN)的方法,用于三维CAD模型的分类。通过设计适应CAD模型特点的网络结构和特征提取算法,我们能够有效地对三维CAD模型进行分类,并在实验证明我们的方法的有效性和性能。1.引言在现代制造和工程设计领域,三维CAD模型被广泛应

基于三维多视角挤压激励卷积神经网络的肺结节良恶性分类研究.pptx

汇报人:/目录0102模型构建背景模型构建过程模型优势与特点模型应用场景03研究背景与意义研究方法与实验设计实验结果与分析研究结论与展望04应用背景与目的应用方法与实验过程应用结果与效果评估应用价值与意义05比较研究背景与目的比较研究方法与实验设计比较研究结果与分析比较研究结论与建议06模型优化背景与目标模型优化方法与策略模型优化结果与效果评估模型优化价值与意义汇报人:

基于融合多视角特征的投影全卷积网络三维模型分割方法.pdf

本发明公开了基于融合多视角特征的投影全卷积网络三维模型分割方法,包括:步骤1,对输入三维网格模型数据集采集数据;步骤2,用融合多视角特征的FCN全卷积网络对模型投影渲染图进行语义分割,得到模型在各个视点方向下投影渲染图的像素被预测为各个标签的概率;步骤3,对模型在各个视点方向下投影渲染图语义分割概率图进行反投并采用最大视角池化,得到模型面片被预测为各个标签的概率;步骤4,采用GraphCut图割算法进行优化,得到模型面片的最终预测标签。