基于跨视图约束的多视图分类方法.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于跨视图约束的多视图分类方法.docx

基于跨视图约束的多视图分类方法基于跨视图约束的多视图分类方法摘要:多视图学习作为机器学习领域的一个重要研究方向,可以有效地从多个数据源中挖掘不同视图之间的关联信息,提高分类准确性。跨视图约束的多视图分类方法是一种基于数据关联性的多视图学习方法,通过利用视图之间的跨视图约束信息来进行分类。本文将对跨视图约束的多视图分类方法做详细阐述,介绍其基本原理、关键技术和应用场景,并对其进行实验验证和讨论。1.引言多视图分类是指从不同的视图角度对同一对象进行分类。不同于传统的单一视图学习方法,多视图学习能够综合多源数据

基于多视图的3D形状分类方法研究.docx

基于多视图的3D形状分类方法研究基于多视图的3D形状分类方法研究摘要:随着三维形状数据的广泛应用,基于多视图的3D形状分类方法成为当前研究的热点之一。本文综述了多视图的3D形状分类方法的研究现状,并结合实例介绍了常用的多视图特征提取、表示和分类算法。通过比较不同方法的优缺点以及相关应用领域的需求,对未来的研究方向进行了展望。关键词:多视图;三维形状分类;特征提取;特征表示;分类算法一、引言三维形状分类是计算机视觉和计算机图形学领域的一个重要研究方向,其应用涉及虚拟现实、计算机辅助设计、智能机器人等多个领域

基于多视图集成的鸟鸣分类研究.docx

基于多视图集成的鸟鸣分类研究【摘要】本文提出了一种基于多视图集成的鸟鸣分类研究方法。该方法采用了多种数据特征抽取和处理方法,并通过多视图融合实现了更准确和高效的分类。实验结果表明,该方法在鸟鸣的分类问题上有较好的表现。【关键词】鸟鸣分类;多视图集成;数据特征抽取;多视图融合【引言】鸟鸣声是大自然的音乐,每种鸟类的鸟鸣都是独特的。因此,通过对鸟鸣声的分类和分析不仅可以帮助我们更好地了解鸟类的生态系统,还可以促进保护和管理鸟类资源。传统的鸟鸣分类方法主要是基于声学特征的马尔科夫模型。但是,这种方法的性能在现实

一种基于多视图约束的导管中心线匹配方法.pdf

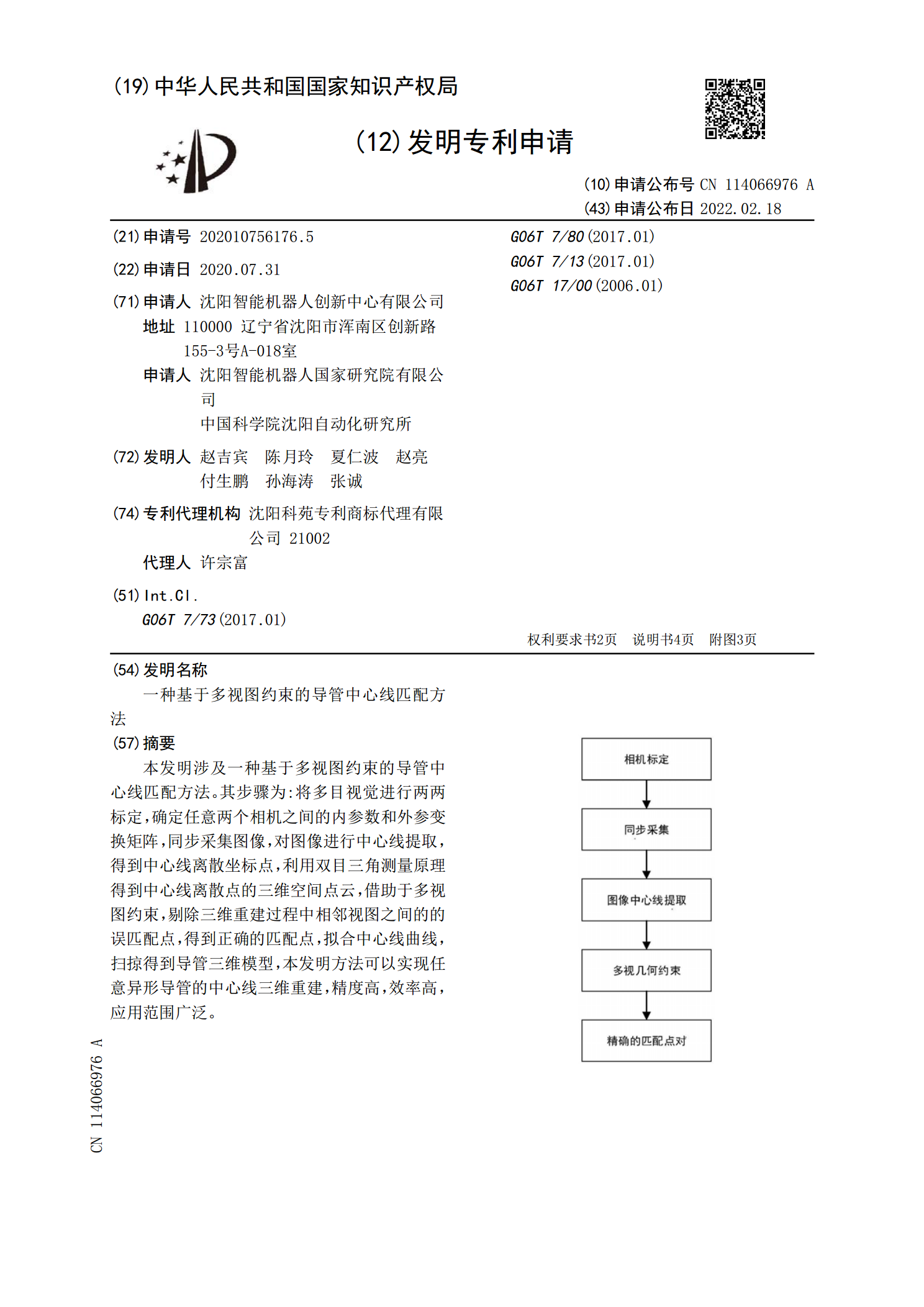

本发明涉及一种基于多视图约束的导管中心线匹配方法。其步骤为:将多目视觉进行两两标定,确定任意两个相机之间的内参数和外参变换矩阵,同步采集图像,对图像进行中心线提取,得到中心线离散坐标点,利用双目三角测量原理得到中心线离散点的三维空间点云,借助于多视图约束,剔除三维重建过程中相邻视图之间的的误匹配点,得到正确的匹配点,拟合中心线曲线,扫掠得到导管三维模型,本发明方法可以实现任意异形导管的中心线三维重建,精度高,效率高,应用范围广泛。

基于多视图协同分类的安卓恶意软件检测方法研究.docx

基于多视图协同分类的安卓恶意软件检测方法研究基于多视图协同分类的安卓恶意软件检测方法研究摘要:随着移动互联网和智能设备的普及,安卓恶意软件威胁日益严重。为了解决当前安卓恶意软件检测中的问题,本文提出了一种基于多视图协同分类的安卓恶意软件检测方法。该方法利用多个视图(如静态视图和动态视图)中的特征信息,通过协同学习的方式进行恶意软件检测,提高了检测的准确性和性能。实验结果表明,多视图协同分类方法在安卓恶意软件检测中具有显著的优势。关键词:安卓恶意软件检测;多视图协同分类;特征提取;协同学习1.引言随着移动互