基于文本、语音和视频的多模态情感识别的研究.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于文本、语音和视频的多模态情感识别的研究.docx

基于文本、语音和视频的多模态情感识别的研究摘要:多模态情感识别是一项旨在同时分析文本、语音和视频等多种模态数据来识别人类情感状态的研究领域。本论文综述了目前在多模态情感识别方面的研究进展和方法。首先,介绍了情感识别的重要性和挑战。接着,回顾了在文本、语音和视频方面的单一模态情感识别技术。然后,提出了多模态融合方法,包括特征级融合、决策级融合和模型级融合等。最后,分析了当前研究存在的问题和未来的研究方向。这项研究的结果可用于情感分析、智能客服和人机交互等领域。关键词:多模态情感识别、情感计算、文本情感分析、

基于表情和语音的多模态情感识别研究.docx

基于表情和语音的多模态情感识别研究多模态情感识别是指通过同时分析多种信息源(例如文本、音频、图像和视频)来识别人类情感状态的一种技术。该领域的研究在近年来得到了广泛的关注,并取得了显著的进展。本文将重点讨论基于表情和语音的多模态情感识别的研究进展、方法和应用。首先,我们需要了解情感识别的重要性和应用场景。情感是人类交流和认知的重要组成部分,对于理解人类行为和推测人类意图具有重要意义。情感识别可以应用于多个领域,如智能客服、人机交互、情感分析、市场调查等。因此,基于表情和语音的多模态情感识别具有广泛的应用前

基于语音和文本的双模态情感识别综述.docx

基于语音和文本的双模态情感识别综述目录一、内容简述................................................21.1研究背景与意义.......................................31.2研究目的与问题.......................................41.3文献综述.............................................4二、双模态情感识别研究现状...............

基于人脸多模态技术的视频情感分类算法的研究.docx

基于人脸多模态技术的视频情感分类算法的研究基于人脸多模态技术的视频情感分类算法的研究摘要:随着社交媒体和通信技术的快速发展,人们在日常生活中越来越倾向于通过视频来表达自己的情感。因此,视频情感分类成为了一个重要的研究领域。本论文将探讨基于人脸多模态技术的视频情感分类算法。引言:人的情感是一种非常复杂的心理状态,能够通过面部表情、语音、肢体语言等多种方式来传达。通过使用人脸分析和多模态技术,我们可以有效地从视频中提取情感信息,并对其进行分类。人脸分析是计算机视觉的一个重要研究方向,通过分析面部表情,可以获取

一种基于智能语音交互的多模态拒识方法和系统.pdf

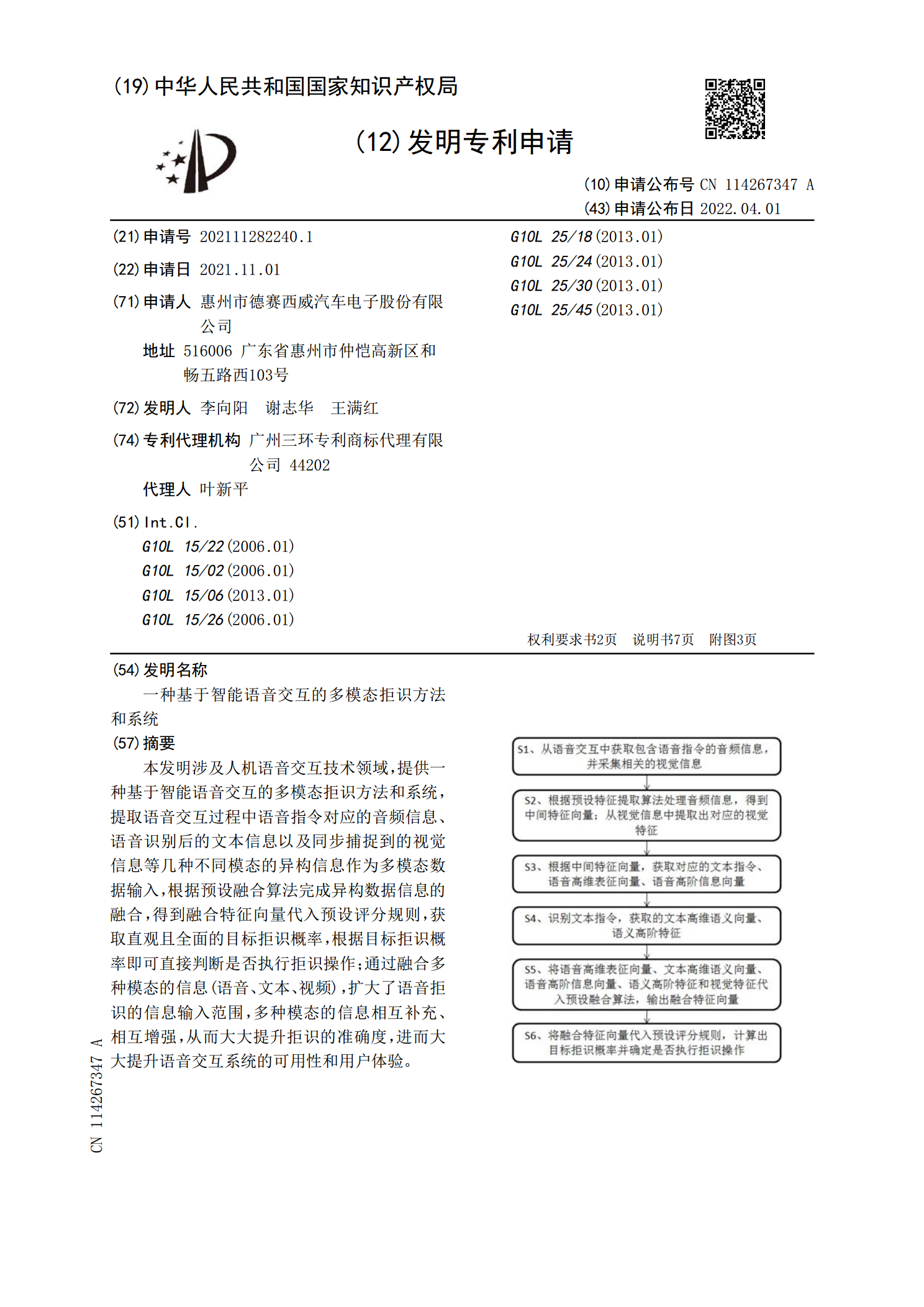

本发明涉及人机语音交互技术领域,提供一种基于智能语音交互的多模态拒识方法和系统,提取语音交互过程中语音指令对应的音频信息、语音识别后的文本信息以及同步捕捉到的视觉信息等几种不同模态的异构信息作为多模态数据输入,根据预设融合算法完成异构数据信息的融合,得到融合特征向量代入预设评分规则,获取直观且全面的目标拒识概率,根据目标拒识概率即可直接判断是否执行拒识操作;通过融合多种模态的信息(语音、文本、视频),扩大了语音拒识的信息输入范围,多种模态的信息相互补充、相互增强,从而大大提升拒识的准确度,进而大大提升语音