一种机器人视觉定位的新方法.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

一种机器人视觉定位的新方法.docx

一种机器人视觉定位的新方法标题:一种基于深度学习的机器人视觉定位新方法摘要:机器人视觉定位是机器人技术中的关键问题之一,它在机器人导航、自主控制和环境感知等方面具有重要的应用价值。近年来,深度学习技术的快速发展为机器人视觉定位提供了新的解决方案。本论文提出了一种基于深度学习的机器人视觉定位新方法。首先,我们介绍了机器人视觉定位的基本原理和现有的方法。然后,我们详细介绍了深度学习在机器人视觉定位中的应用,包括基于卷积神经网络(CNN)和循环神经网络(RNN)的方法。最后,我们通过实验证明,所提出的方法在机器

基于视觉流形正则化的机器人实时定位新方法.docx

基于视觉流形正则化的机器人实时定位新方法摘要机器人实时定位是机器人技术中非常重要的研究方向,具有广泛的应用。本文提出了一种基于视觉流形正则化的机器人实时定位新方法,该方法采用视觉流形学习进行姿态估计,同时结合机器人实时定位技术,能够有效地提高机器人的定位精度和实时性能。实验结果表明,该方法能够实现高精度的机器人实时定位。关键词:机器人;实时定位;视觉流形学习;姿态估计;定位精度引言机器人实时定位是机器人技术中的重要研究方向之一,它涉及到了机器人自身位置的精确定位。在实际应用中,机器人需要实现自主运动和执行

一种机器人视觉定位方法.pdf

本发明公开了一种机器人视觉定位方法,该方法包括:S1,对工件进行图像采集、预处理及轮廓的提取;S2,对特征向量进行距离归一化处理;S3,确定候选匹配点集;S4,得到初始匹配点集;S5,剔除误匹配点对。

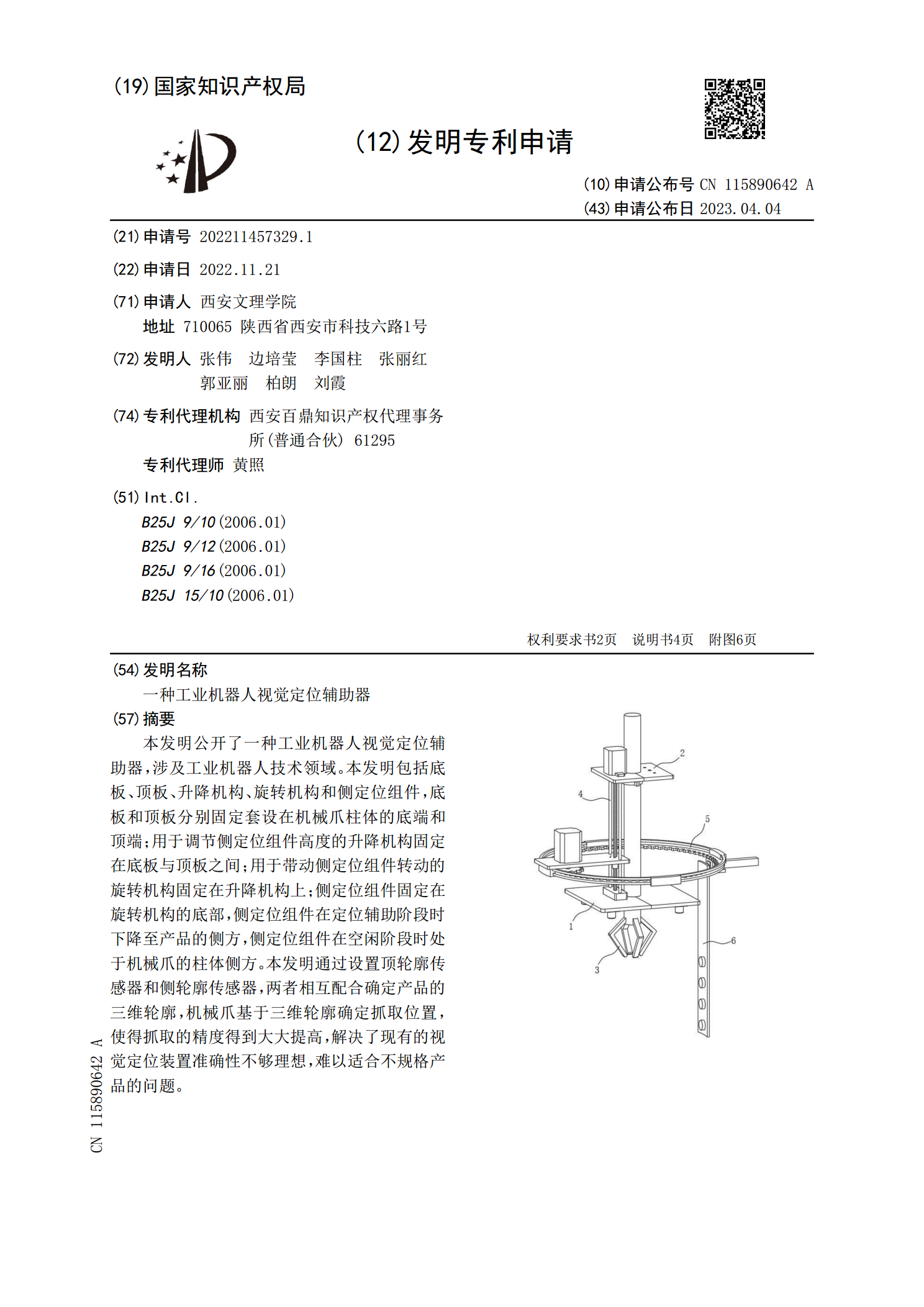

一种工业机器人视觉定位辅助器.pdf

本发明公开了一种工业机器人视觉定位辅助器,涉及工业机器人技术领域。本发明包括底板、顶板、升降机构、旋转机构和侧定位组件,底板和顶板分别固定套设在机械爪柱体的底端和顶端;用于调节侧定位组件高度的升降机构固定在底板与顶板之间;用于带动侧定位组件转动的旋转机构固定在升降机构上;侧定位组件固定在旋转机构的底部,侧定位组件在定位辅助阶段时下降至产品的侧方,侧定位组件在空闲阶段时处于机械爪的柱体侧方。本发明通过设置顶轮廓传感器和侧轮廓传感器,两者相互配合确定产品的三维轮廓,机械爪基于三维轮廓确定抓取位置,使得抓取的精

一种机器人双目视觉实时定位装置.pdf

本发明属于视觉实时定位领域,尤其是一种机器人双目视觉实时定位装置,针对现有的传统中实时定位系统容易受到外界因素的影响,从而影响实时定位的准确性的问题,现提出如下方案,其包括视觉在线定位数学模型推导模块,所述视觉在线定位数学模型推导模块包括双目视觉定位模块、双目视觉定位检测模块、双目视觉定位学习模块和数据整合模块,本发明具备了能适应实际场景中的复杂变化,在保持原算法高效率的同时,提高了鲁棒性和准确性,并且减轻困扰传统双目的轨迹漂移问题,提供更准确,更鲁棒的定位结果。