基于多模态融合的音乐情感分类方法研究的任务书.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于多模态融合的音乐情感分类方法研究的任务书.docx

基于多模态融合的音乐情感分类方法研究的任务书任务书一、选题背景随着音乐资源的爆发式增长和音乐信息获取的便捷化,音乐情感分类成为一个热门的研究领域。音乐情感分类旨在根据音乐中所表达的情感特征,将音乐分为不同的情感类别,如愉快、悲伤、兴奋等。传统的音乐情感分类方法主要基于音频信号分析,忽略了音乐本身的多模态特性。然而,音乐不仅仅可以通过声音来传达情感,还可以通过歌词、视频等多种形式来表达情感。因此,基于多模态融合的音乐情感分类方法成为一个具有挑战性和前景的研究方向。二、研究目标本研究的目标是开发一种基于多模态

多模态数据融合的情感分类研究的任务书.docx

多模态数据融合的情感分类研究的任务书任务书任务名称:多模态数据融合的情感分类研究任务目的:情感分类是自然语言处理中的一个重要研究领域,可以用来分析文本的情感倾向以及对情感数据进行分类。但是,单独使用文本数据进行情感分类往往会受限于语言表述的局限性和数据噪声的影响。本次研究任务旨在探究多模态数据融合技术在情感分类中的应用,并开发一种有效的情感分类模型,该模型能够综合运用文本、图像、音频等多种形式的数据,提高情感分类的准确度和鲁棒性。任务描述:1.数据收集根据任务需求,从开放数据集或其他可行的途径中,收集包含

一种基于决策融合的多模态情感分类方法.pdf

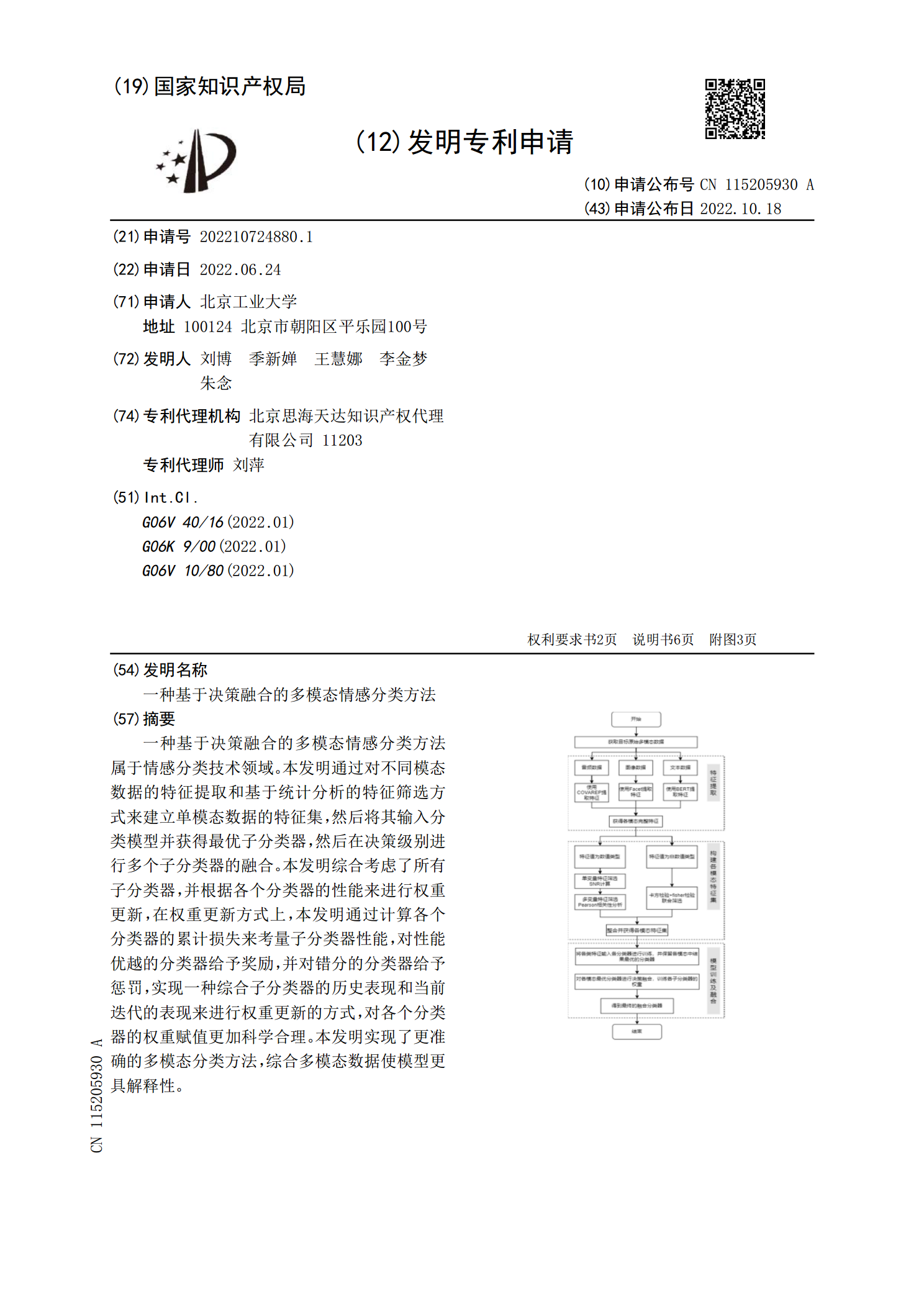

一种基于决策融合的多模态情感分类方法属于情感分类技术领域。本发明通过对不同模态数据的特征提取和基于统计分析的特征筛选方式来建立单模态数据的特征集,然后将其输入分类模型并获得最优子分类器,然后在决策级别进行多个子分类器的融合。本发明综合考虑了所有子分类器,并根据各个分类器的性能来进行权重更新,在权重更新方式上,本发明通过计算各个分类器的累计损失来考量子分类器性能,对性能优越的分类器给予奖励,并对错分的分类器给予惩罚,实现一种综合子分类器的历史表现和当前迭代的表现来进行权重更新的方式,对各个分类器的权重赋值更

一种基于多模态学习的音乐情感分类方法.pdf

本发明公开了一种基于多模态学习的音乐情感分类方法,包含以下步骤:数据预处理,根据所需模态信息对音乐的音频、歌词、评论分别进行预处理来获取模型的有效输入;表示学习,将每个模态使用不同的建模方式分别映射到各自的表示空间;特征提取,提取不同模态的模型映射后的特征向量,并降维至同一维度;多模态融合,将三种不同模态的特征进行级联早融合,从而建立更全面的特征表示;情感分类决策,使用融合后的特征对音乐进行有监督的情感分类。本发明的音乐情感分类方法,提供了一种基于多模态联合学习的方法,可以有效的减少目前主流的单模态模型方

多模态数据融合的情感分类研究的开题报告.docx

多模态数据融合的情感分类研究的开题报告一、研究背景和意义情感分类是自然语言处理领域的一个重要研究方向。在社交媒体、在线评论等文本数据的分析中,情感分类可以帮助我们更好地了解用户的真实感受和情绪态度。但是,单一模态无法获取多样化的情感信息,而情感信息又受情境、语言表达等多种因素影响,因此单一模态的情感分类精度往往较低。多模态数据融合技术可以将来自不同模态的信息融合起来,弥补单一模态的局限性,提高情感分类的准确性和稳定性。多模态数据主要包括文本、图像、音频和视频等。例如,在分析社交媒体中用户对某一话题的情感时