基于哈希学习的动作捕捉数据的编码与检索.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于哈希学习的动作捕捉数据的编码与检索.docx

基于哈希学习的动作捕捉数据的编码与检索基于哈希学习的动作捕捉数据的编码与检索摘要随着动作捕捉技术的发展,动作捕捉数据的获取量已经大大增加。如何高效地存储和检索这些数据成为一个重要的研究方向。哈希学习作为一种有效的数据编码和检索方法,可以将高维数据映射到低维空间,以实现快速的数据检索。本论文将介绍基于哈希学习的动作捕捉数据的编码与检索方法,并探讨其在实际应用中的优势与挑战。关键词:动作捕捉数据;哈希学习;编码;检索1.引言动作捕捉技术是一种用于获取人类运动数据的技术,已经被广泛应用于虚拟现实、游戏开发、人机

基于哈希学习的动作捕捉数据的编码与检索的开题报告.docx

基于哈希学习的动作捕捉数据的编码与检索的开题报告一、选题背景随着虚拟现实、增强现实等技术的发展,对于动作捕捉数据的需求越来越大。动作捕捉数据能够让虚拟现实场景更加逼真,增强现实应用更加真实生动,因此动作捕捉技术在游戏、电影、教育、医疗等领域都有着广泛的应用。然而,随着数据量的不断增大,如何高效地编码、检索这些数据成为了一个重要的问题。而基于哈希学习的方法,则能够在保证信息可靠性的同时,实现快速的编码与检索。因此,本文将从这个角度出发,研究基于哈希学习的动作捕捉数据的编码和检索。二、研究目的和意义基于哈希学

基于哈希编码学习的图像检索方法.docx

基于哈希编码学习的图像检索方法标题:基于哈希编码学习的图像检索方法摘要:图像检索技术在当今的信息时代中扮演着重要的角色,可以快速准确地从大规模的图像集合中检索到用户感兴趣的图像。然而,随着图像数据的快速增长,传统的图像检索方法面临着检索速度慢、存储空间大以及检索精度低的问题。为了解决这些问题,哈希编码学习技术逐渐成为图像检索领域的研究热点。本文将介绍基于哈希编码学习的图像检索方法,并讨论其优缺点及未来的研究方向。一、引言随着互联网和数码相机的普及,图像数据的数量呈现爆发式增长。面对如此大量的图像数据,如何

基于哈希学习的图像数据快速检索方法研究.docx

基于哈希学习的图像数据快速检索方法研究基于哈希学习的图像数据快速检索方法研究摘要:随着计算机视觉和图像处理的快速发展,图像数据的增长呈现出指数级的趋势。为了高效地对海量图像进行快速检索,研究者们提出了许多基于哈希学习的方法。本论文首先介绍了哈希学习的基本概念和原理,然后重点探讨了基于哈希学习的图像数据快速检索方法的研究进展与应用。最后,对该领域的研究挑战和未来发展方向进行了探讨。1.引言图像数据的快速检索在计算机视觉和多媒体领域具有重要的应用价值。然而,随着图像数据量的迅猛增长,传统的基于全局特征的图像检

一种基于哈希编码的图像声音检索方法.pdf

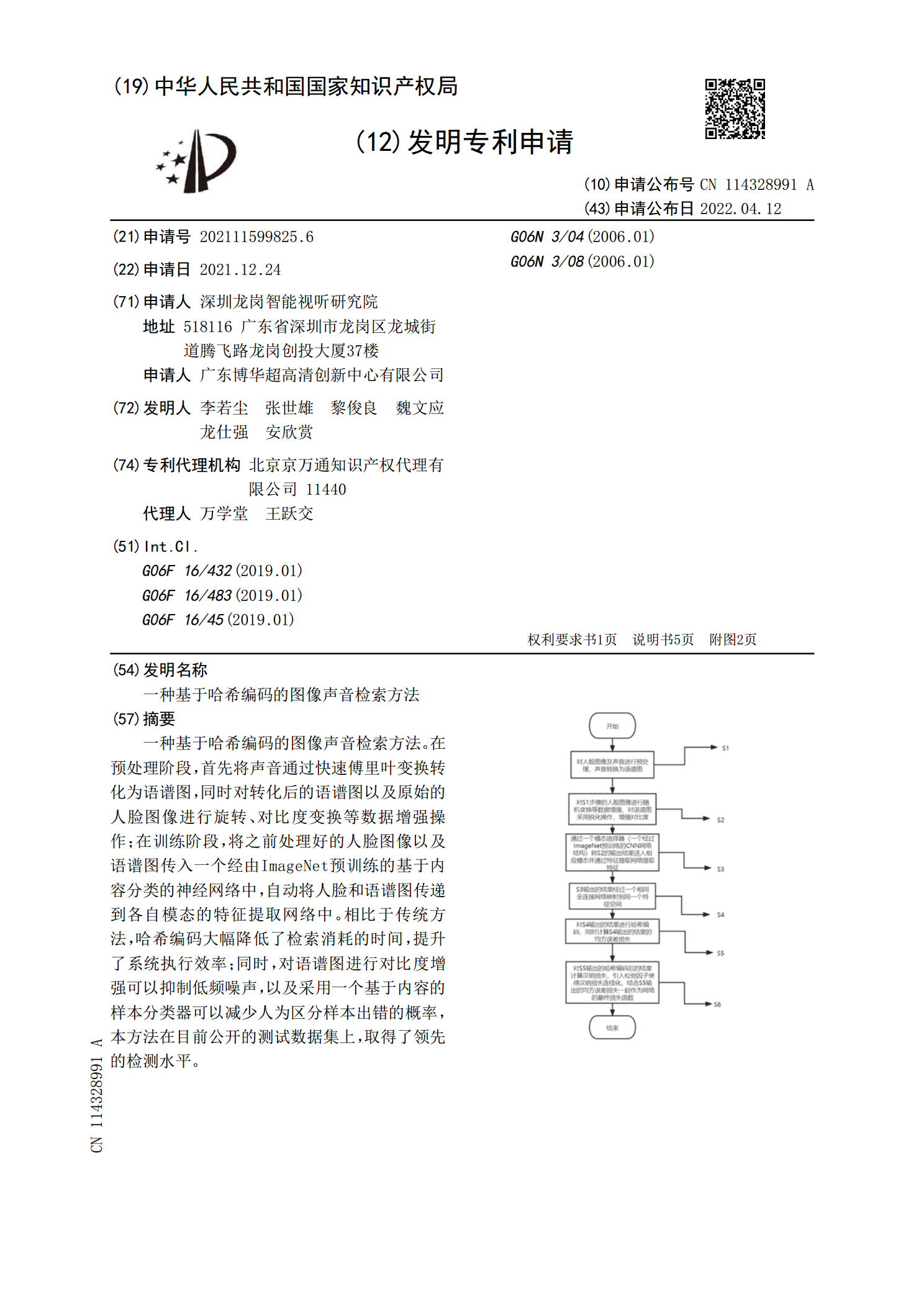

一种基于哈希编码的图像声音检索方法。在预处理阶段,首先将声音通过快速傅里叶变换转化为语谱图,同时对转化后的语谱图以及原始的人脸图像进行旋转、对比度变换等数据增强操作;在训练阶段,将之前处理好的人脸图像以及语谱图传入一个经由ImageNet预训练的基于内容分类的神经网络中,自动将人脸和语谱图传递到各自模态的特征提取网络中。相比于传统方法,哈希编码大幅降低了检索消耗的时间,提升了系统执行效率;同时,对语谱图进行对比度增强可以抑制低频噪声,以及采用一个基于内容的样本分类器可以减少人为区分样本出错的概率,本方法在