基于强化学习的智能小车路径规划.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于强化学习的智能小车路径规划.docx

基于强化学习的智能小车路径规划基于强化学习的智能小车路径规划摘要路径规划是智能小车系统中的重要问题之一,它涉及到如何在给定的环境中选择适当的路径来达到目标。传统的路径规划方法往往需要依赖于精确的地图和精确的传感器数据,而在现实世界中,地图和传感器数据往往是不完美并且存在噪声的。因此,传统的方法在实际应用中面临一些挑战。强化学习是一种在没有事先定义好的规则下通过试错来学习最佳行为的方法。本论文将介绍基于强化学习的智能小车路径规划方法,并提供一种解决方案来克服传统方法的限制。引言智能小车路径规划是一项重要的研

基于Android的智能小车控制及路径规划的任务书.docx

基于Android的智能小车控制及路径规划的任务书任务书一、背景随着智能化的快速发展,智能小车成为了人们智能出行的一种重要方式。智能小车不仅能够自主行驶,还可以进行语音控制和远程操控等功能。而在智能小车的控制过程中,路径规划是必不可少的一环。因此,本项目将基于Android系统,设计一个智能小车控制及路径规划系统。二、目的本项目旨在设计一款能够实现智能小车控制和路径规划功能的Android应用程序,具体目标如下:1.实现智能小车的基本控制,包括前进、后退、左转和右转等。2.利用Android应用程序对智能

基于改进遗传算法的智能小车路径规划方法.pdf

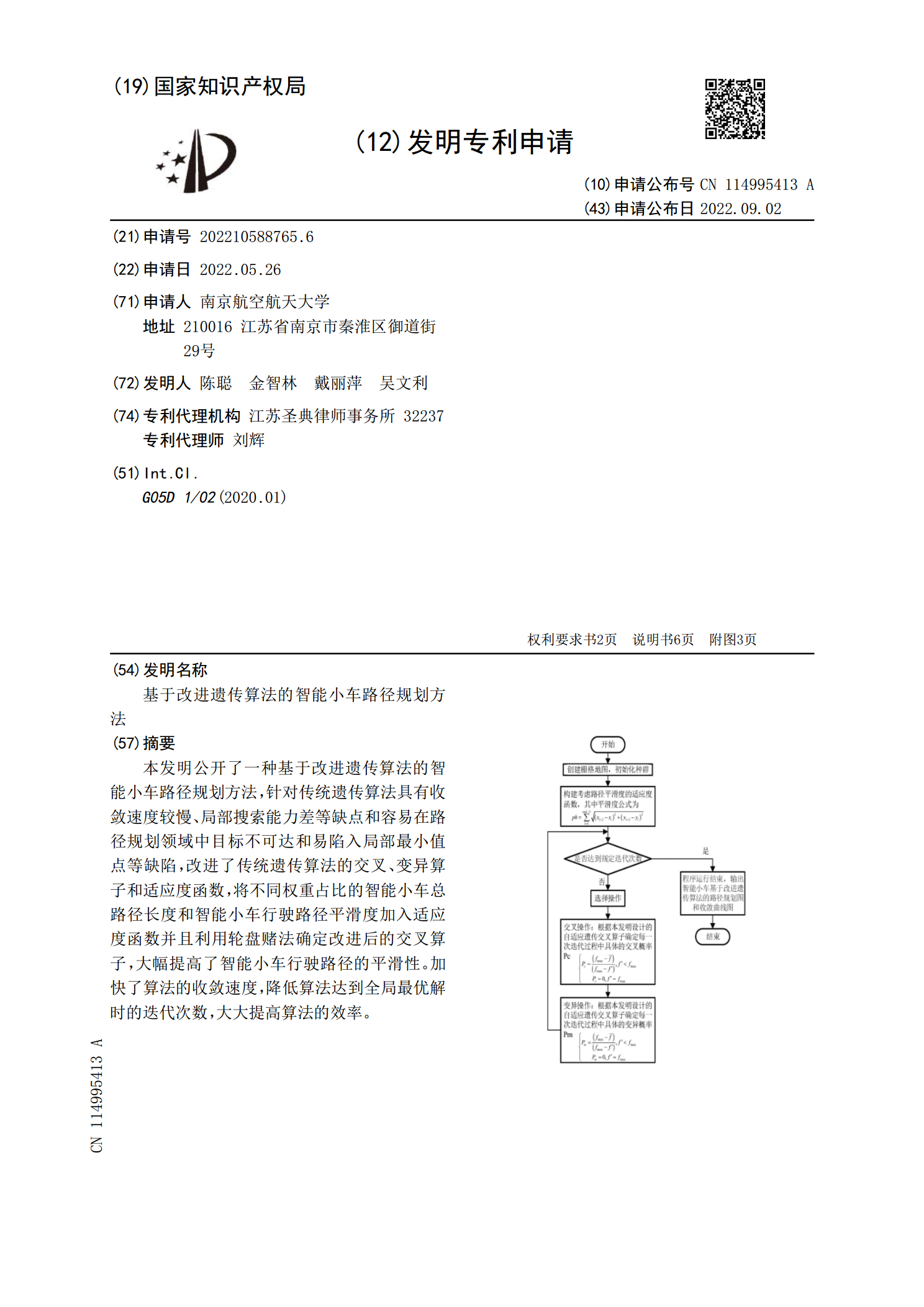

本发明公开了一种基于改进遗传算法的智能小车路径规划方法,针对传统遗传算法具有收敛速度较慢、局部搜索能力差等缺点和容易在路径规划领域中目标不可达和易陷入局部最小值点等缺陷,改进了传统遗传算法的交叉、变异算子和适应度函数,将不同权重占比的智能小车总路径长度和智能小车行驶路径平滑度加入适应度函数并且利用轮盘赌法确定改进后的交叉算子,大幅提高了智能小车行驶路径的平滑性。加快了算法的收敛速度,降低算法达到全局最优解时的迭代次数,大大提高算法的效率。

基于树莓派的智能小车路径规划方法及系统研究.docx

基于树莓派的智能小车路径规划方法及系统研究基于树莓派的智能小车路径规划方法及系统研究摘要:智能小车路径规划是智能交通系统中的一个重要研究方向。本文以树莓派为核心控制器,研究并设计了一种基于树莓派的智能小车路径规划方法及系统。该系统能够根据环境信息进行实时路径规划,并实现避障功能。在实际应用中,该系统能够提高小车的行驶效率并保证安全性。关键词:智能小车;路径规划;树莓派;避障;安全性1.引言智能交通系统是当前城市交通系统中的重要发展方向之一。智能小车作为智能交通系统的一个重要载体,其路径规划技术对于保证交通

基于改进蚁群算法的智能小车路径规划仿真研究.docx

基于改进蚁群算法的智能小车路径规划仿真研究摘要:智能小车路径规划在现代智能交通系统中有着广泛的应用前景。本文提出了一种基于改进蚁群算法的智能小车路径规划方法。在该方法中,通过引入瞬态调参策略和优化的蚁群算法,实现了智能小车的高效路径规划。在广泛的仿真实验中,与其他常见路径规划算法相比,该方法取得了较好的性能表现。关键词:智能小车;路径规划;蚁群算法;瞬态调参策略;优化1.引言智能交通系统是近年来快速发展的新型交通系统,它以智能化、信息化技术为基础,实现了交通信息的集成、智能交通设备的应用、智能交通管理等功