可见光图像与红外图像的融合方法研究的开题报告.docx

骑着****猪猪

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

可见光图像与红外图像的融合方法研究的开题报告.docx

可见光图像与红外图像的融合方法研究的开题报告一、选题背景在人类的日常生活中,图像数据具有非常重要的应用价值。可见光图像与红外图像是两种最常见和常用的图像数据类型,在军事、安防、医学等领域都有广泛的应用。但是,由于可见光图像和红外图像各自具有特殊的物理特性和特征,因此这两种图像数据的信息互补性很强。为了更好地利用和提高这两种图像数据的应用价值,将可见光图像和红外图像进行融合是一种有效的方法。因此,本文选取“可见光图像与红外图像的融合方法研究”作为研究主题。二、研究意义目前,可见光图像和红外图像融合算法已经得

红外图像与可见光图像融合方法.pdf

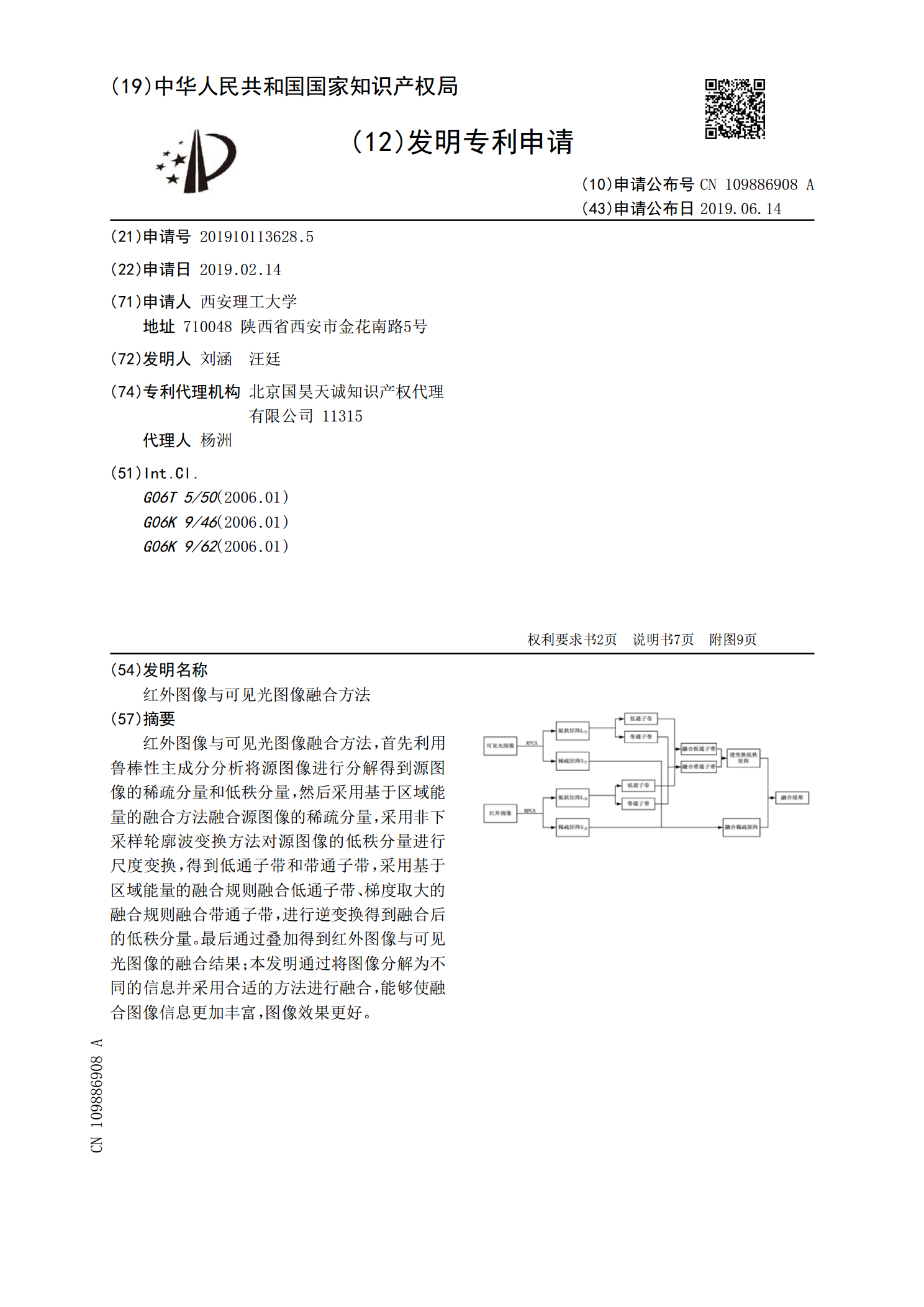

红外图像与可见光图像融合方法,首先利用鲁棒性主成分分析将源图像进行分解得到源图像的稀疏分量和低秩分量,然后采用基于区域能量的融合方法融合源图像的稀疏分量,采用非下采样轮廓波变换方法对源图像的低秩分量进行尺度变换,得到低通子带和带通子带,采用基于区域能量的融合规则融合低通子带、梯度取大的融合规则融合带通子带,进行逆变换得到融合后的低秩分量。最后通过叠加得到红外图像与可见光图像的融合结果;本发明通过将图像分解为不同的信息并采用合适的方法进行融合,能够使融合图像信息更加丰富,图像效果更好。

热红外图像增强及其与可见光图像融合技术的研究及应用的开题报告.docx

热红外图像增强及其与可见光图像融合技术的研究及应用的开题报告一、选题背景与意义热红外图像是医学影像、军事目标检测、边境监控等领域重要的无需接触背景之一。随着红外技术的发展,热红外图像的应用越来越广泛,但热红外图像受噪声和低对比度的影响很大,影响了人们对目标的分析与识别。因此,如何提高热红外图像的分析效果,已成为当今热门研究的领域。目前,热红外图像增强及其与可见光图像融合技术的研究与应用已成为研究人员关注的热点问题。二、文献综述(一)热红外图像增强技术目前,热红外图像增强技术主要有以下几种:1、无损增强:常

红外与可见光图像分解与融合方法研究.docx

红外与可见光图像分解与融合方法研究随着科技的不断发展,红外成像技术与可见光成像技术的应用越来越广泛。然而,两种成像技术所得到的图像信息有所不同,因此需要将它们进行分解与融合,以综合利用它们所包含的信息,提高图像的识别和分析能力。本文将就红外与可见光图像分解与融合方法进行探讨。首先,在红外与可见光图像分解方面,常见的方法有基于小波分解和基于矩阵分解。基于小波分解的方法通过对图像进行小波变换,将其分解为不同尺度的频率信息,从而分离出红外和可见光信号。该方法的主要优点是能够提取出局部的频率信息并维持图像的空间分

可见光图像与红外图像的融合方法研究的任务书.docx

可见光图像与红外图像的融合方法研究的任务书任务书:可见光图像与红外图像的融合方法研究一、问题背景现代科技中,图像融合技术已得到广泛应用。图像融合是指将多幅具有不同传感器、波长或视角等特点的图片,通过融合算法,生成一幅新的更综合、更清晰的图像。其中,可见光图像和红外图像的融合是应用比较广泛的一个方向。可见光图像与红外图像有不同的物理信息、表现方式和物理机理,如何将这两种图像融合在一起,形成更有价值的信息,是当前图像处理领域需要研究解决的方向。二、任务描述本任务要求将可见光图像和红外图像进行融合,得到更全面的