视频场景的重建与增强处理的中期报告.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

视频场景的重建与增强处理的中期报告.docx

视频场景的重建与增强处理的中期报告本次报告将重点介绍视频场景的重建与增强处理的中期进展情况。一、视频场景的重建目前,我们采用的是深度学习方法进行视频场景的重建。具体步骤为:1.数据集的准备。我们使用公开数据集UCF101和Hollywood-2来进行视频场景的重建。这些数据集包含了大量的视频样本,可以帮助我们训练出更加准确的模型。2.帧差法提取视频帧。在视频帧中,某些区域的运动将比其他区域更为剧烈,这可以被视为视频帧中有用信息的一种表现形式。我们将使用帧差法来提取视频帧。3.特征提取。我们采用了一种名为“

视频场景的重建与增强处理的任务书.docx

视频场景的重建与增强处理的任务书任务书任务名称:视频场景的重建与增强处理任务要求:1.通过分析视频内容,对视频中的场景进行重建,使得场景更加真实、清晰。2.对视频进行增强处理,使得画面更加清晰、色彩更加鲜明,提高视频的清晰度和观感程度。3.对重建后的视频进行优化处理,包括调整视频的亮度、对比度、饱和度等,使得整个画面更加舒适。4.对不同类型的视频,给出不同的处理方案。5.使用计算机图像处理技术,进行实时处理,保证处理效果和处理速度。任务基本要求:1.在完成任务的基础上,需要对处理技术进行总结和归纳,对处理

LCD视频缩放与增强处理的设计与实现的中期报告.docx

LCD视频缩放与增强处理的设计与实现的中期报告1.项目背景及意义随着科技的不断发展,液晶显示技术已成为当前广泛应用于各种显示设备的主流技术。LCD显示器在现代生活中广泛应用,其显示效果、清晰度和色彩还原度与CRT显示器相比较,有很大提高。但是在视频显示方面,由于不同视频信号源的分辨率和格式不同,液晶显示器的缩放及增强处理的质量和效果往往达不到用户的要求。因此如何提高LCD显示器在视频信号处理方面的质量和效果,成为当前LCD显示技术研究的一个重要方向。2.项目目标本项目旨在设计和实现一套液晶显示器视频缩放与

增强真实场景的视频通量.pdf

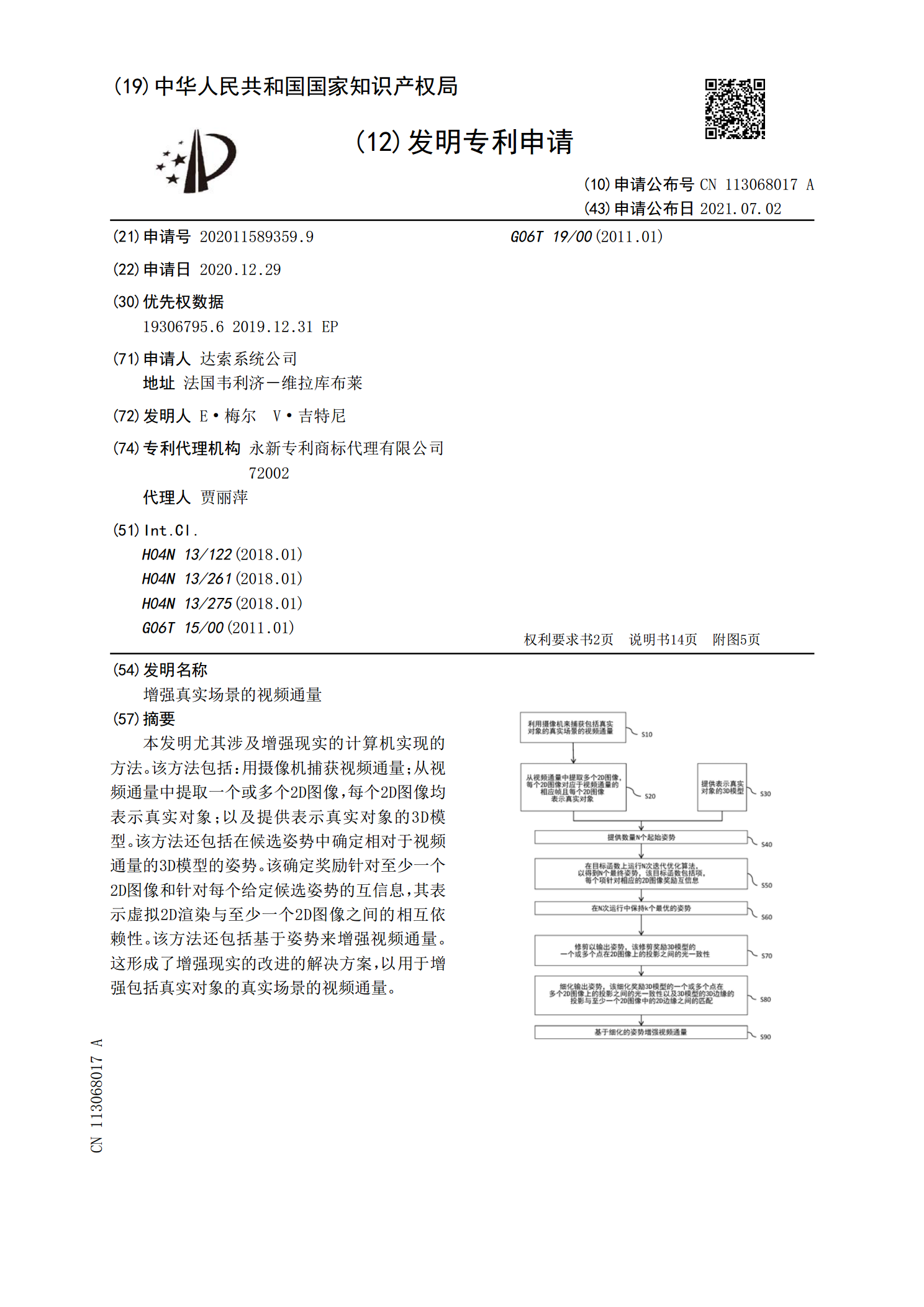

本发明尤其涉及增强现实的计算机实现的方法。该方法包括:用摄像机捕获视频通量;从视频通量中提取一个或多个2D图像,每个2D图像均表示真实对象;以及提供表示真实对象的3D模型。该方法还包括在候选姿势中确定相对于视频通量的3D模型的姿势。该确定奖励针对至少一个2D图像和针对每个给定候选姿势的互信息,其表示虚拟2D渲染与至少一个2D图像之间的相互依赖性。该方法还包括基于姿势来增强视频通量。这形成了增强现实的改进的解决方案,以用于增强包括真实对象的真实场景的视频通量。

复杂场景高位宽图像对比度增强处理研究的中期报告.docx

复杂场景高位宽图像对比度增强处理研究的中期报告中期报告-Introduction在传统的黑白图像中,增强图像的对比度是一种相对简单和常见的处理方法。但是,在复杂场景高位宽图像中,对比度增强是更具挑战性和复杂的任务。本研究旨在研究复杂场景高位宽图像对比度增强处理方法,并提供中期报告以展示研究进展情况。-LiteratureReview在针对复杂场景高位宽图像对比度增强的研究方面,已有一些相关工作。Su等人(2017)提出一种基于视觉感知的图像对比度增强方法,该方法包括对直方图均衡化进行改进和建立感知模型,从