一种基于多模态融合的视觉问答融合增强方法.pdf

猫巷****提格

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

一种基于多模态融合的视觉问答融合增强方法.pdf

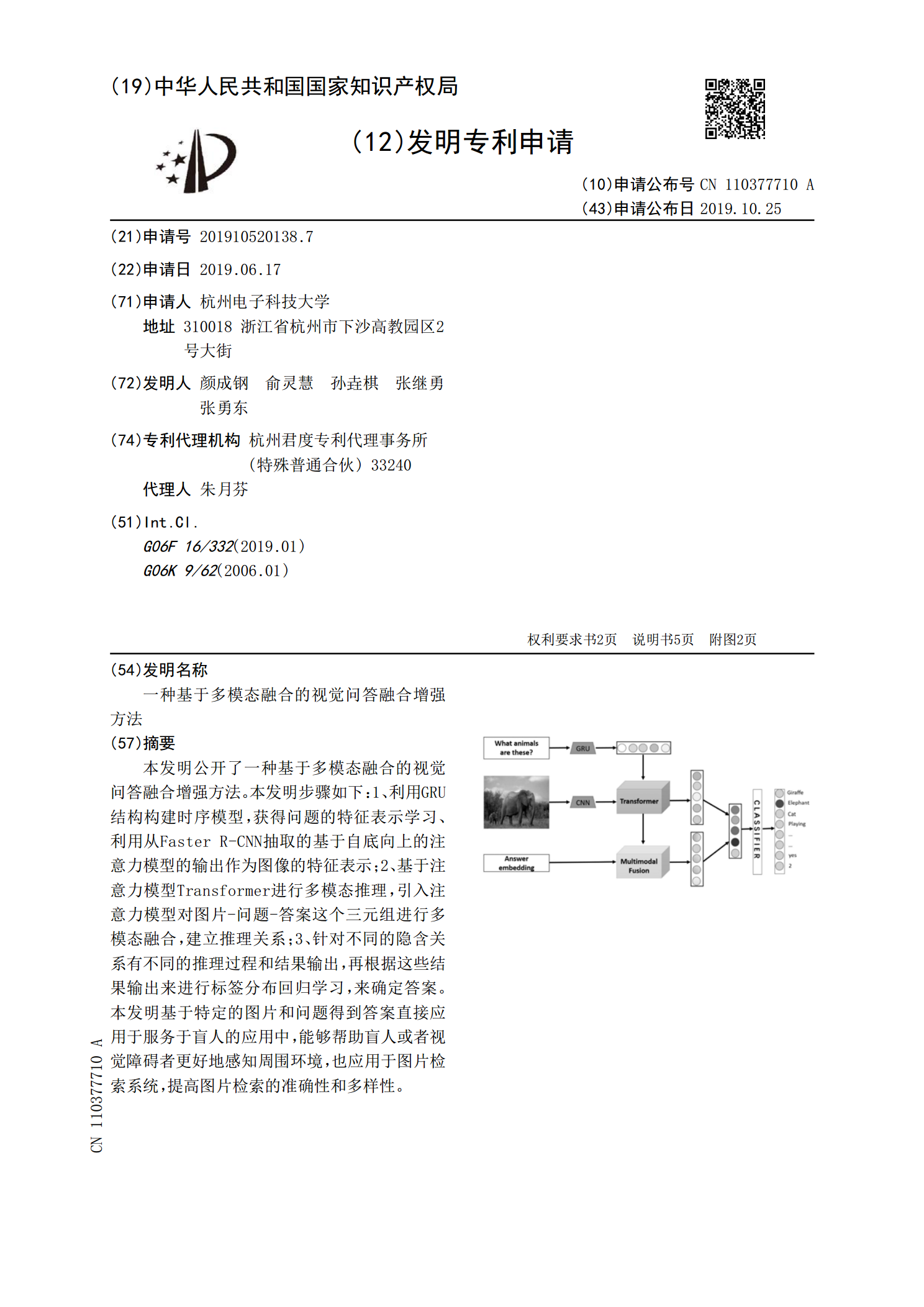

本发明公开了一种基于多模态融合的视觉问答融合增强方法。本发明步骤如下:1、利用GRU结构构建时序模型,获得问题的特征表示学习、利用从FasterR‑CNN抽取的基于自底向上的注意力模型的输出作为图像的特征表示;2、基于注意力模型Transformer进行多模态推理,引入注意力模型对图片‑问题‑答案这个三元组进行多模态融合,建立推理关系;3、针对不同的隐含关系有不同的推理过程和结果输出,再根据这些结果输出来进行标签分布回归学习,来确定答案。本发明基于特定的图片和问题得到答案直接应用于服务于盲人的应用中,能

视觉问答中的多模态信息融合.docx

视觉问答中的多模态信息融合标题:多模态信息融合在视觉问答中的应用与挑战摘要:视觉问答(VisualQuestionAnswering,缩写为VQA)是计算机视觉和自然语言处理领域的交叉研究热点。通过将图像和自然语言处理相结合,VQA旨在让计算机实现对图像提问并给出准确回答的能力。多模态信息融合在VQA任务中起着重要作用,本论文将讨论多模态信息融合的动机、方法和挑战,并提出一些解决方案。1.引言1.1背景介绍1.2研究意义2.多模态信息融合的动机2.1图像和文本特征的互补性2.2提高问答准确性和可解释性3.

视觉问答中的多模态信息融合的开题报告.docx

视觉问答中的多模态信息融合的开题报告一、研究背景随着科技的不断发展,人们的信息获取方式也在不断地发生变化,多模态信息的出现成为了信息时代的一种重要特征。同时,大数据的产生和分析也加强了对多模态信息的需求。多模态信息是指来自多种途径、多种媒体的信息以及不同类型的数据,例如图像、视频、语音、文字和手势等等。不同信息源提供的多模态数据信息对我们的决策与判断是非常有帮助的。如图像和文字的结合,可以提供更加全面、准确和准确的信息。然而,对于计算机而言,单一信息源处理数据的方法已经不能满足人们的需求,因此多模态信息融

一种基于全局信息融合的多模态医学图像融合方法.pdf

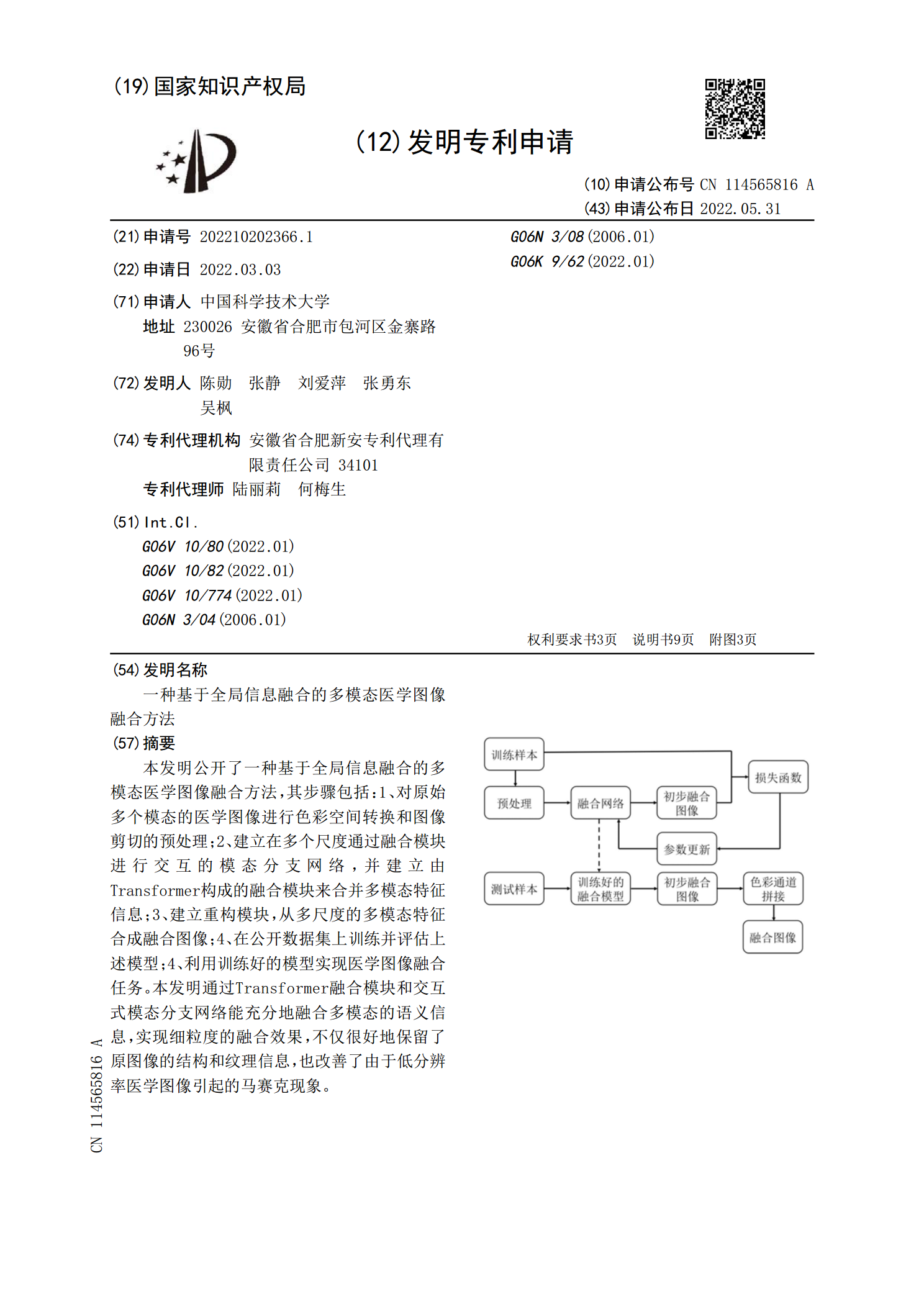

本发明公开了一种基于全局信息融合的多模态医学图像融合方法,其步骤包括:1、对原始多个模态的医学图像进行色彩空间转换和图像剪切的预处理;2、建立在多个尺度通过融合模块进行交互的模态分支网络,并建立由Transformer构成的融合模块来合并多模态特征信息;3、建立重构模块,从多尺度的多模态特征合成融合图像;4、在公开数据集上训练并评估上述模型;4、利用训练好的模型实现医学图像融合任务。本发明通过Transformer融合模块和交互式模态分支网络能充分地融合多模态的语义信息,实现细粒度的融合效果,不仅很好地保

一种基于分频域融合的多模态医学图像融合方法.pdf

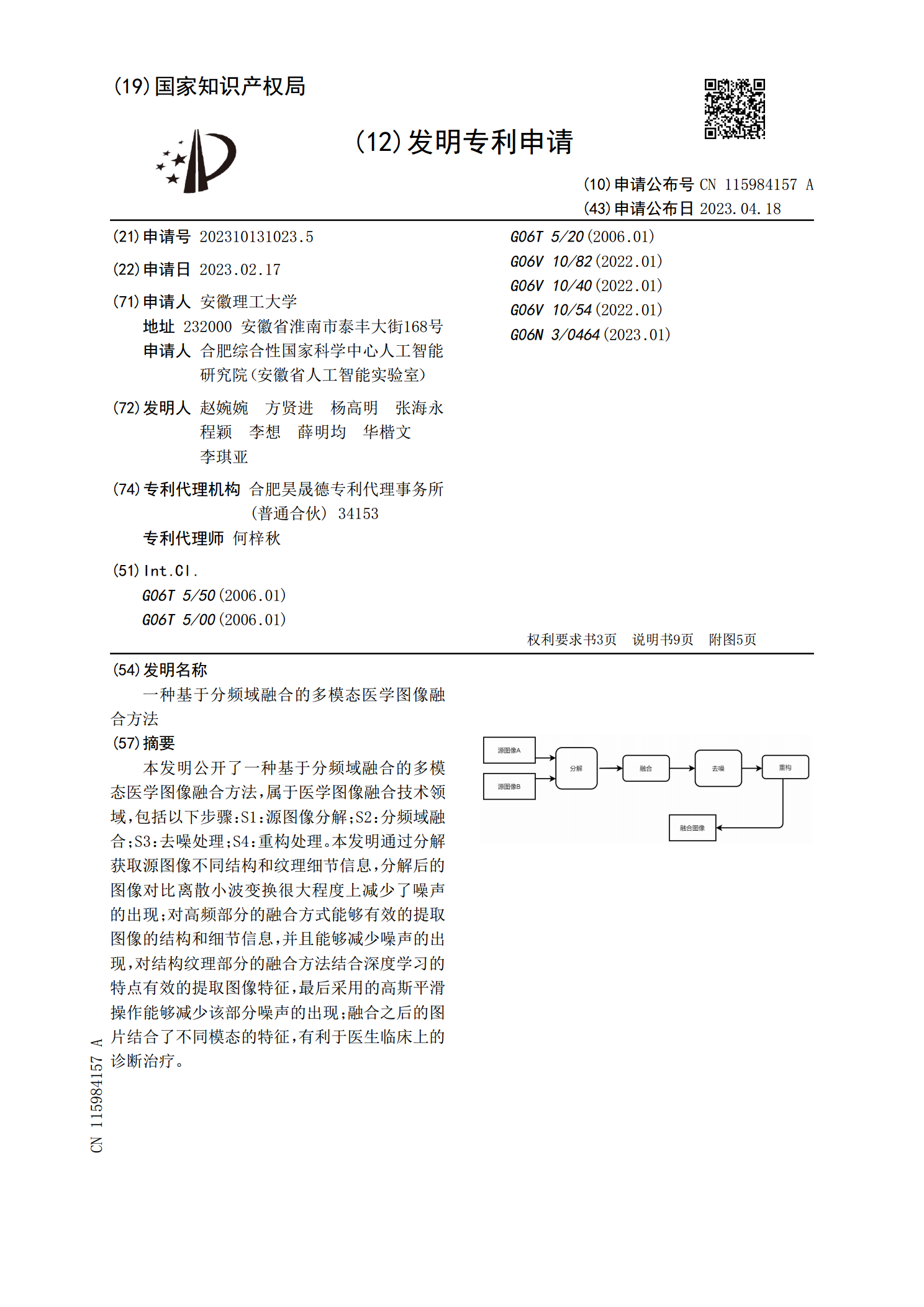

本发明公开了一种基于分频域融合的多模态医学图像融合方法,属于医学图像融合技术领域,包括以下步骤:S1:源图像分解;S2:分频域融合;S3:去噪处理;S4:重构处理。本发明通过分解获取源图像不同结构和纹理细节信息,分解后的图像对比离散小波变换很大程度上减少了噪声的出现;对高频部分的融合方式能够有效的提取图像的结构和细节信息,并且能够减少噪声的出现,对结构纹理部分的融合方法结合深度学习的特点有效的提取图像特征,最后采用的高斯平滑操作能够减少该部分噪声的出现;融合之后的图片结合了不同模态的特征,有利于医生临床上