基于多智能体深度强化学习的动态协作簇选择方法及装置.pdf

涵蓄****09

亲,该文档总共19页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

基于多智能体深度强化学习的动态协作簇选择方法及装置.pdf

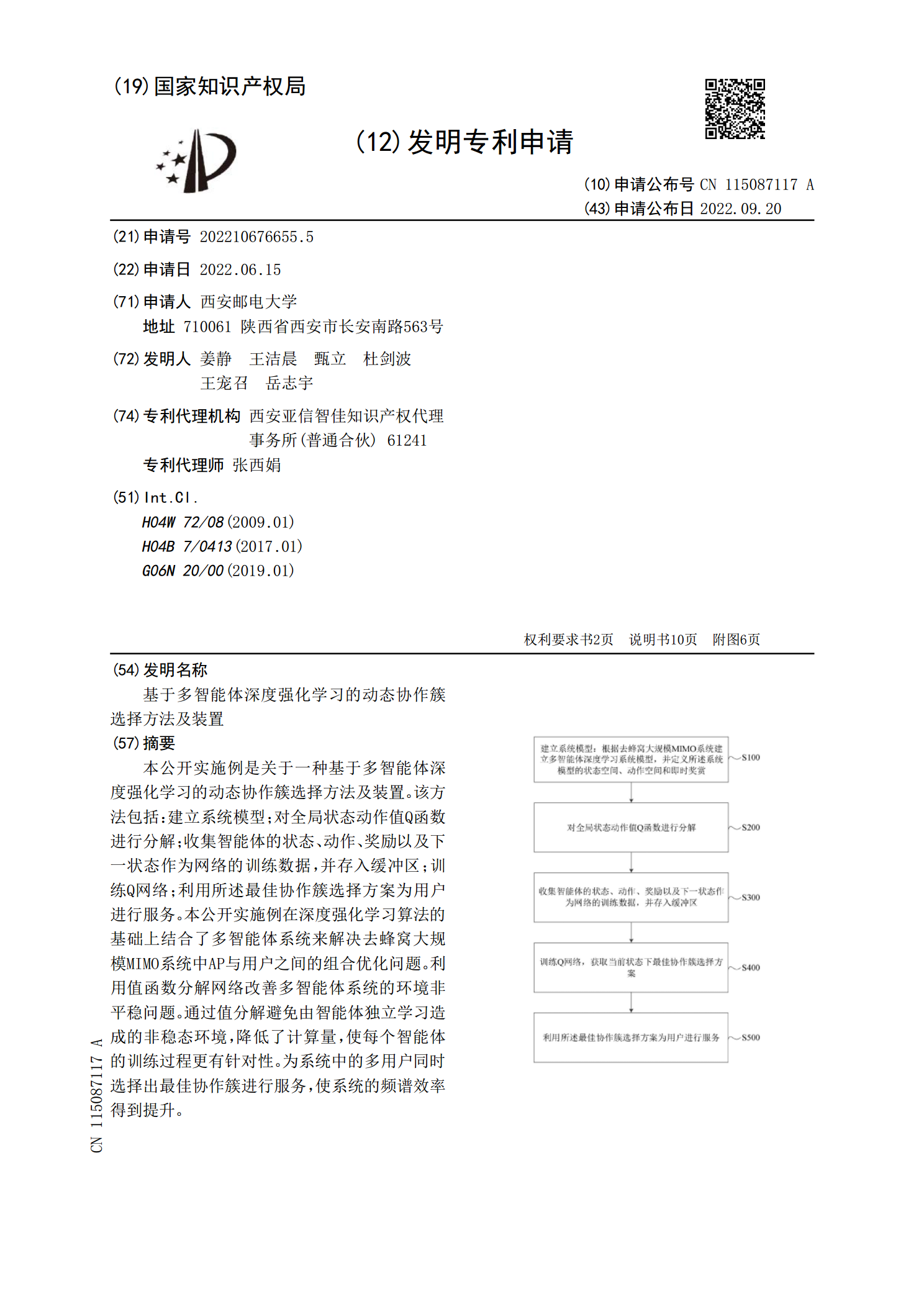

本公开实施例是关于一种基于多智能体深度强化学习的动态协作簇选择方法及装置。该方法包括:建立系统模型;对全局状态动作值Q函数进行分解;收集智能体的状态、动作、奖励以及下一状态作为网络的训练数据,并存入缓冲区;训练Q网络;利用所述最佳协作簇选择方案为用户进行服务。本公开实施例在深度强化学习算法的基础上结合了多智能体系统来解决去蜂窝大规模MIMO系统中AP与用户之间的组合优化问题。利用值函数分解网络改善多智能体系统的环境非平稳问题。通过值分解避免由智能体独立学习造成的非稳态环境,降低了计算量,使每个智能体的训练

基于多智能体强化学习的效用感知的协作服务缓存方法.pdf

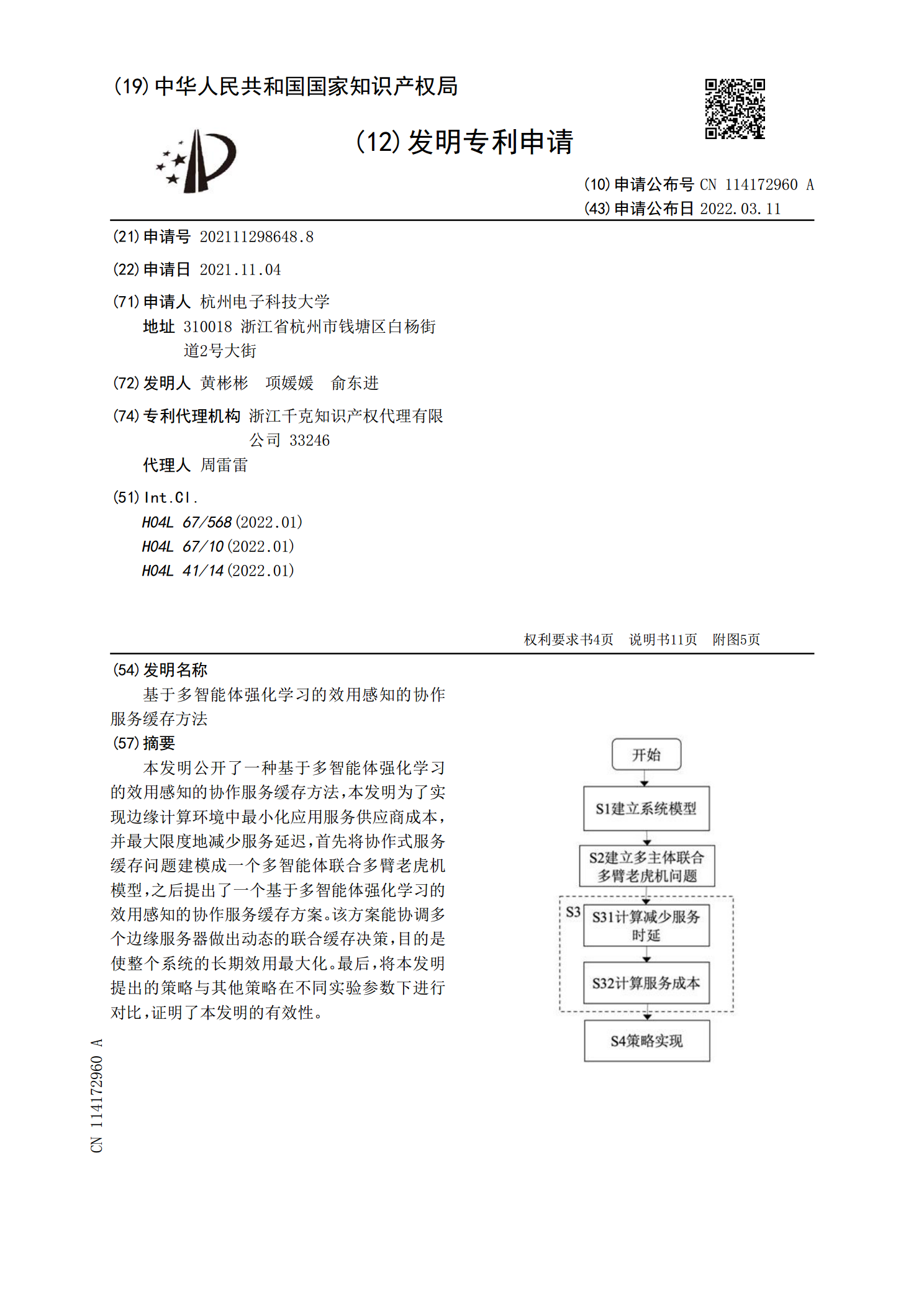

本发明公开了一种基于多智能体强化学习的效用感知的协作服务缓存方法,本发明为了实现边缘计算环境中最小化应用服务供应商成本,并最大限度地减少服务延迟,首先将协作式服务缓存问题建模成一个多智能体联合多臂老虎机模型,之后提出了一个基于多智能体强化学习的效用感知的协作服务缓存方案。该方案能协调多个边缘服务器做出动态的联合缓存决策,目的是使整个系统的长期效用最大化。最后,将本发明提出的策略与其他策略在不同实验参数下进行对比,证明了本发明的有效性。

基于深度强化学习的多智能体攻防决策方法.pdf

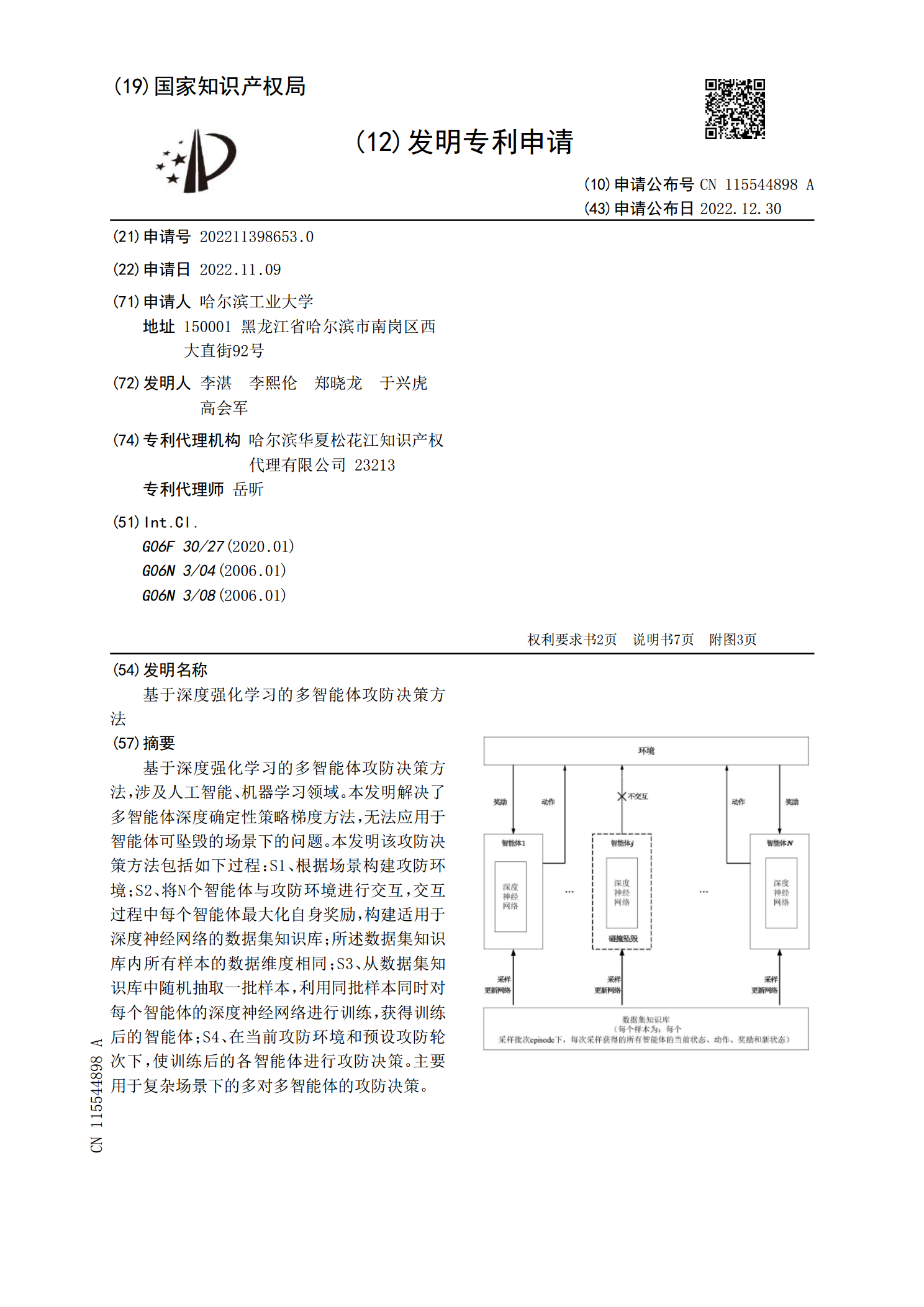

基于深度强化学习的多智能体攻防决策方法,涉及人工智能、机器学习领域。本发明解决了多智能体深度确定性策略梯度方法,无法应用于智能体可坠毁的场景下的问题。本发明该攻防决策方法包括如下过程:S1、根据场景构建攻防环境;S2、将N个智能体与攻防环境进行交互,交互过程中每个智能体最大化自身奖励,构建适用于深度神经网络的数据集知识库;所述数据集知识库内所有样本的数据维度相同;S3、从数据集知识库中随机抽取一批样本,利用同批样本同时对每个智能体的深度神经网络进行训练,获得训练后的智能体;S4、在当前攻防环境和预设攻防轮

基于多智能体深度强化学习的配.docx

基于多智能体深度强化学习的配目录一、内容概要................................................21.1背景与意义...........................................21.2国内外研究现状.......................................41.3研究内容与方法.......................................5二、相关理论基础........................

基于协作MIMO的多跳WSN动态分簇选择算法研究.docx

基于协作MIMO的多跳WSN动态分簇选择算法研究摘要无线传感器网络(WSN)是由大量分散无序的节点组成的网络,具有低能耗、低成本、易于部署等优点,适用于广泛的应用领域。多跳传输技术可以扩大无线网络范围,但是在多跳传输中,选择合适的簇头节点至关重要。本论文提出了一种基于协作多输入多输出(MIMO)的动态分簇选择算法,通过协作MIMO技术实现节点之间的数据通信,从而提高无线网络的传输能力和稳定性。本算法采用基于先验概率的动态簇头选择策略,实现最优化平衡网络能耗和数据传输性能的动态调节。模拟结果表明,本算法相比