一种基于MADDPG算法的映射运行方法.pdf

是立****92

亲,该文档总共17页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

一种基于MADDPG算法的映射运行方法.pdf

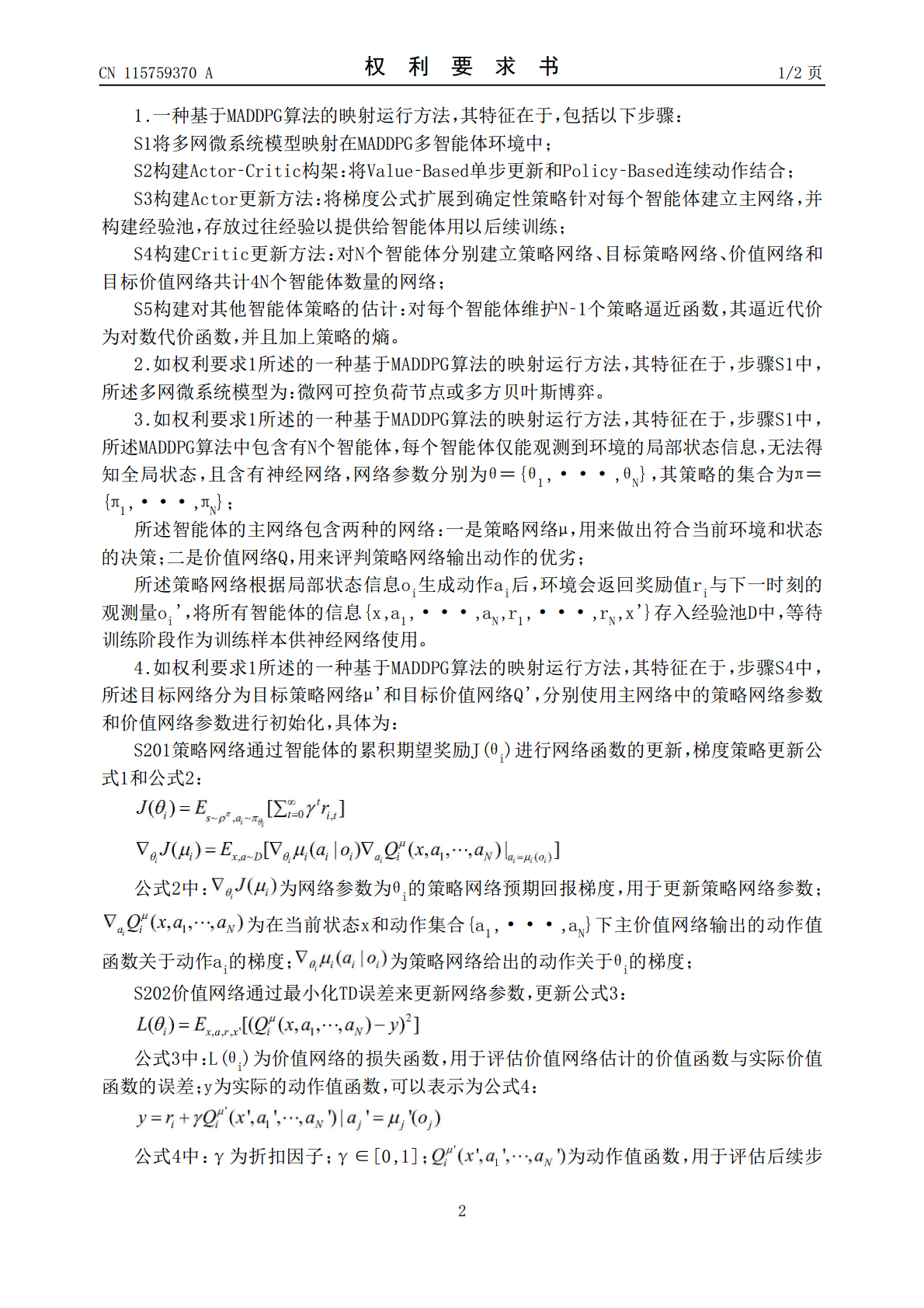

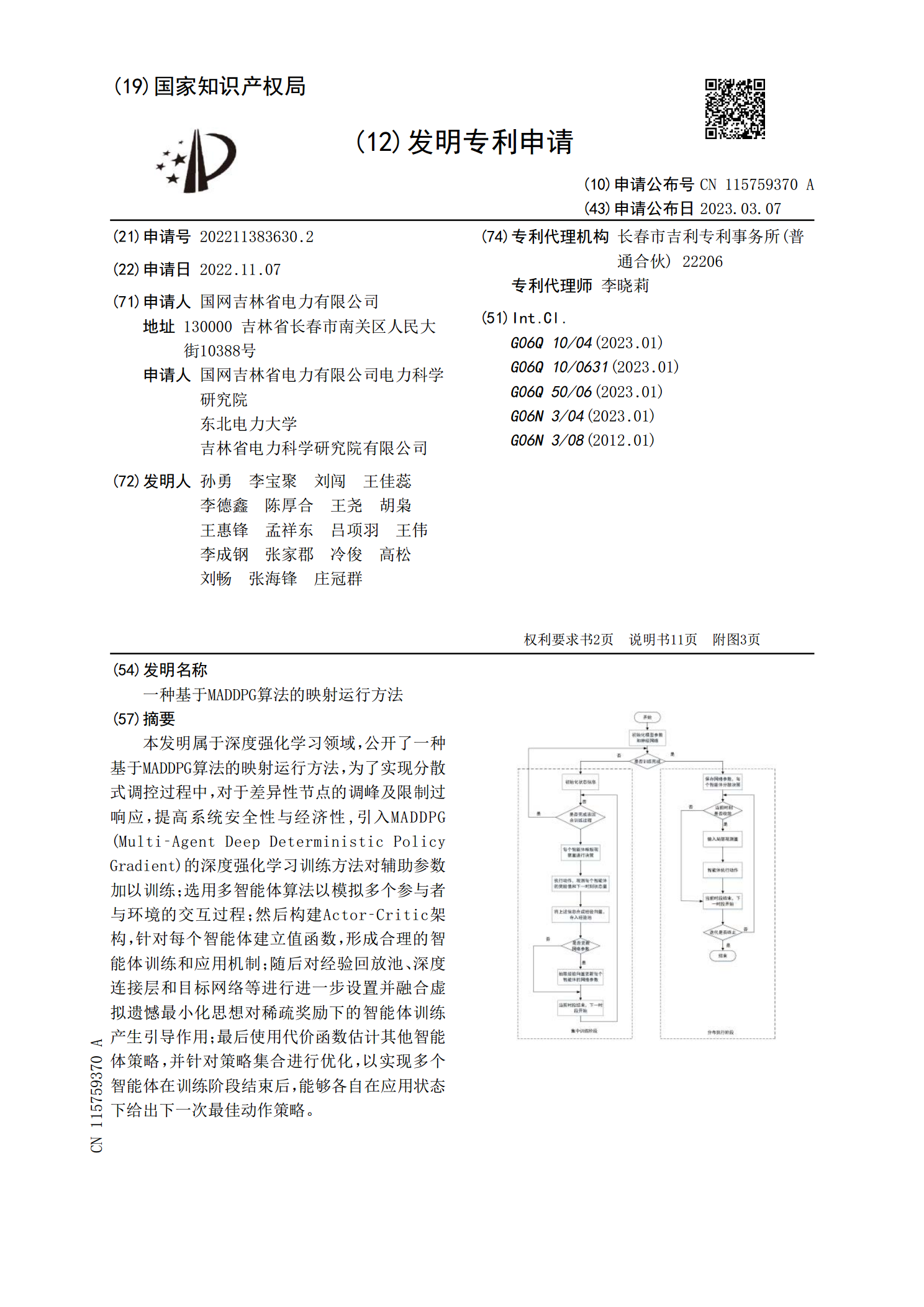

本发明属于深度强化学习领域,公开了一种基于MADDPG算法的映射运行方法,为了实现分散式调控过程中,对于差异性节点的调峰及限制过响应,提高系统安全性与经济性,引入MADDPG(Multi‑AgentDeepDeterministicPolicyGradient)的深度强化学习训练方法对辅助参数加以训练;选用多智能体算法以模拟多个参与者与环境的交互过程;然后构建Actor‑Critic架构,针对每个智能体建立值函数,形成合理的智能体训练和应用机制;随后对经验回放池、深度连接层和目标网络等进行进一步设

一种基于MADDPG算法的无人机数据收集方法.pdf

本发明涉及一种基于MADDPG算法的无人机数据收集方法,属于无线通信技术领域。该方法包括:S1:构建包含多个无人机以及多个传感器节点的无人机辅助的物联网数据收集系统,具体包括:建模无人机模型;建模传感器节点模型;建模信道模型;建模传感器节点关联变量;建模系统状态、动作和观测值;S2:建模系统代价函数:为由于缓冲区溢出和数据包到期而导致的丢包数量的相反数;S3:建模并训练MADDPG算法;S4:基于MADDPG算法确定无人机数据收集策略。本发明以最小化网络损失为优化目标,实现无人机数据收集轨迹及节点关联优化

一种基于映射方法的改进频繁模式增长算法.docx

一种基于映射方法的改进频繁模式增长算法随着数据的增长和应用的广泛,频繁模式挖掘成为数据挖掘领域的一个重要问题。频繁模式挖掘旨在找到数据集中出现次数频繁的数据项集合,这些项集合对于分析人员来说是有价值的。由于频繁模式挖掘的实际应用非常广泛,因此研究如何有效挖掘频繁模式是非常重要的。基于Apriori算法的频繁模式挖掘是当前最流行的方法之一,它可以刻画数据集中项集出现的频繁度,但也存在一些问题。在Apriori算法中,每轮迭代需要扫描整个数据集,这导致了算法效率低下。为了解决这个问题,学者们提出了很多基于Ap

基于primal RankRLS方法的本体映射算法.docx

基于primalRankRLS方法的本体映射算法IntroductionOntologymappingaimstoestablishcorrespondencesbetweendifferentontologies.Itplaysavitalroleinsemanticallyintegratingvariousknowledgesourcesandapplications,whichisfundamentaltothedevelopmentoftheSemanticWebandotherrelatedd

一种基于健壮型映射树的虚拟网络映射算法.docx

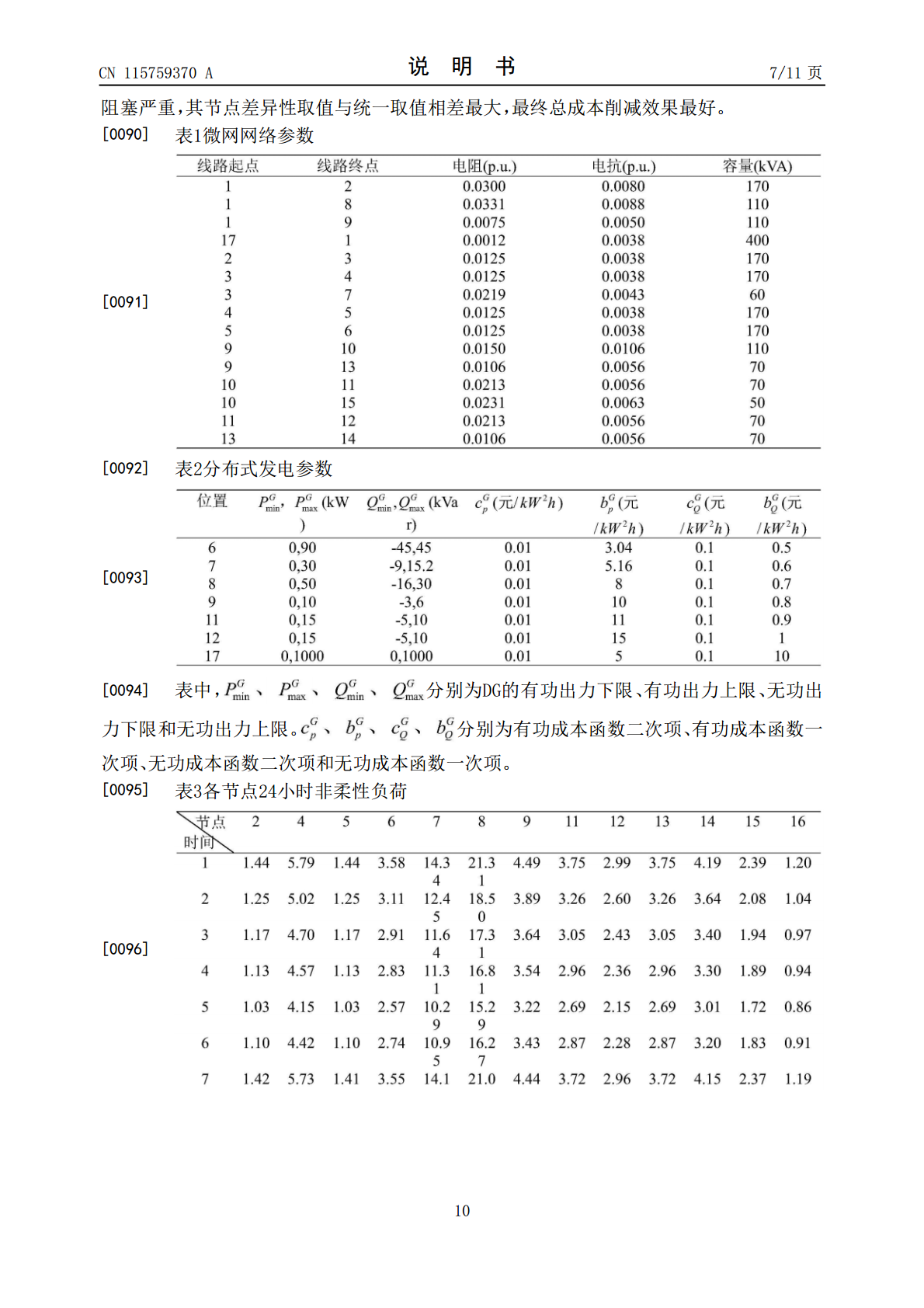

一种基于健壮型映射树的虚拟网络映射算法虚拟网络映射在云计算、网络功能虚拟化等领域越来越受到广泛的关注,是保障网络服务可靠性和可用性的重要手段之一。传统的虚拟网络映射算法通常采用最小割或者贪心算法,但是这些算法的缺点也同时比较明显,如易受到攻击、映射时间长等等问题。因此,本文提出一种基于健壮型映射树的虚拟网络映射算法,以解决传统算法存在的问题,并具有一定的实际应用价值。一、健壮型映射树的理论基础健壮型映射树是一种基于网络流的树状结构,它的基本思想是将原始虚拟网络转化为一个有向图,然后将该有向图映射到底层物理