基于改进Transformer模型的语音识别方法及装置.pdf

猫巷****奕声

亲,该文档总共18页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

基于改进Transformer模型的语音识别方法及装置.pdf

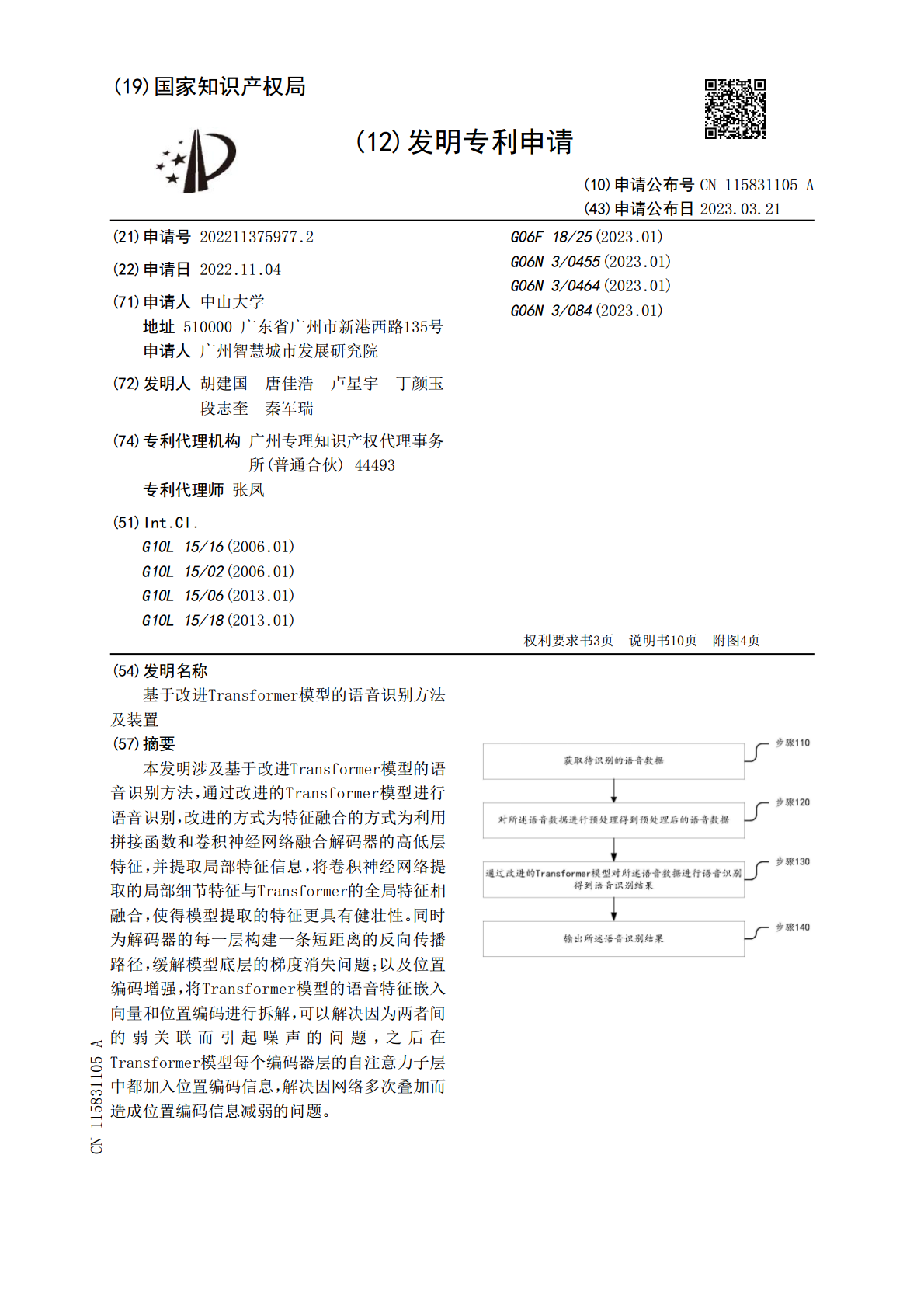

本发明涉及基于改进Transformer模型的语音识别方法,通过改进的Transformer模型进行语音识别,改进的方式为特征融合的方式为利用拼接函数和卷积神经网络融合解码器的高低层特征,并提取局部特征信息,将卷积神经网络提取的局部细节特征与Transformer的全局特征相融合,使得模型提取的特征更具有健壮性。同时为解码器的每一层构建一条短距离的反向传播路径,缓解模型底层的梯度消失问题;以及位置编码增强,将Transformer模型的语音特征嵌入向量和位置编码进行拆解,可以解决因为两者间的弱关联而引起噪

基于端对端transformer模型的语音识别方法.pdf

本发明公开了基于端对端transformer模型的语音识别方法,该方法包括:对原始语音信息进行预处理,得到音频序列信息;结合噪声修剪技术,构建transformer语音识别网络模型;基于transformer语音识别网络模型对音频序列信息进行识别处理,得到语音识别结果。通过使用本发明,能够通过获取语音数据的全局~局部信息和高层~低层特征信息进而提高模型的语音识别准确度。本发明作为基于端对端transformer模型的语音识别方法,可广泛应用于深度学习语音识别技术领域。

基于Transformer的房颤识别方法及装置.pdf

本发明公开了基于Transformer的房颤识别方法及装置,方法包括:获取原始心电数据;对所述原始心电数据进行分类标记,得到房颤心电数据和非房颤心电数据;对所述房颤心电数据和非房颤心电数据进行数据分段,构建用于神经网络训练的训练数据集和测试数据集;将所述训练数据集输入到Transformer中进行网络训练,得到目标模型;将所述测试数据集输入所述目标模型进行二分类,得到所述测试数据集中房颤心电数据和非房颤心电数据的分类结果。本发明的准确度高且精度高,可广泛应用于数据处理技术领域。

基于Transformer的改进短文本匹配模型.docx

基于Transformer的改进短文本匹配模型基于Transformer的改进短文本匹配模型摘要:短文本匹配是自然语言处理领域的一个重要任务,其目标是确定两个给定的短文本片段之间的语义相似性。近年来,基于Transformer的神经网络模型在短文本匹配任务上取得了显著的性能提升。本论文在综述Transformer模型在短文本匹配任务上的应用基础上,针对Transformer模型在长文本匹配和低资源条件下的不足,提出了一种改进的短文本匹配模型。1.引言短文本匹配是自然语言处理领域的一个重要任务,广泛应用于问

基于改进的隐马尔科夫模型的语音识别方法.pdf

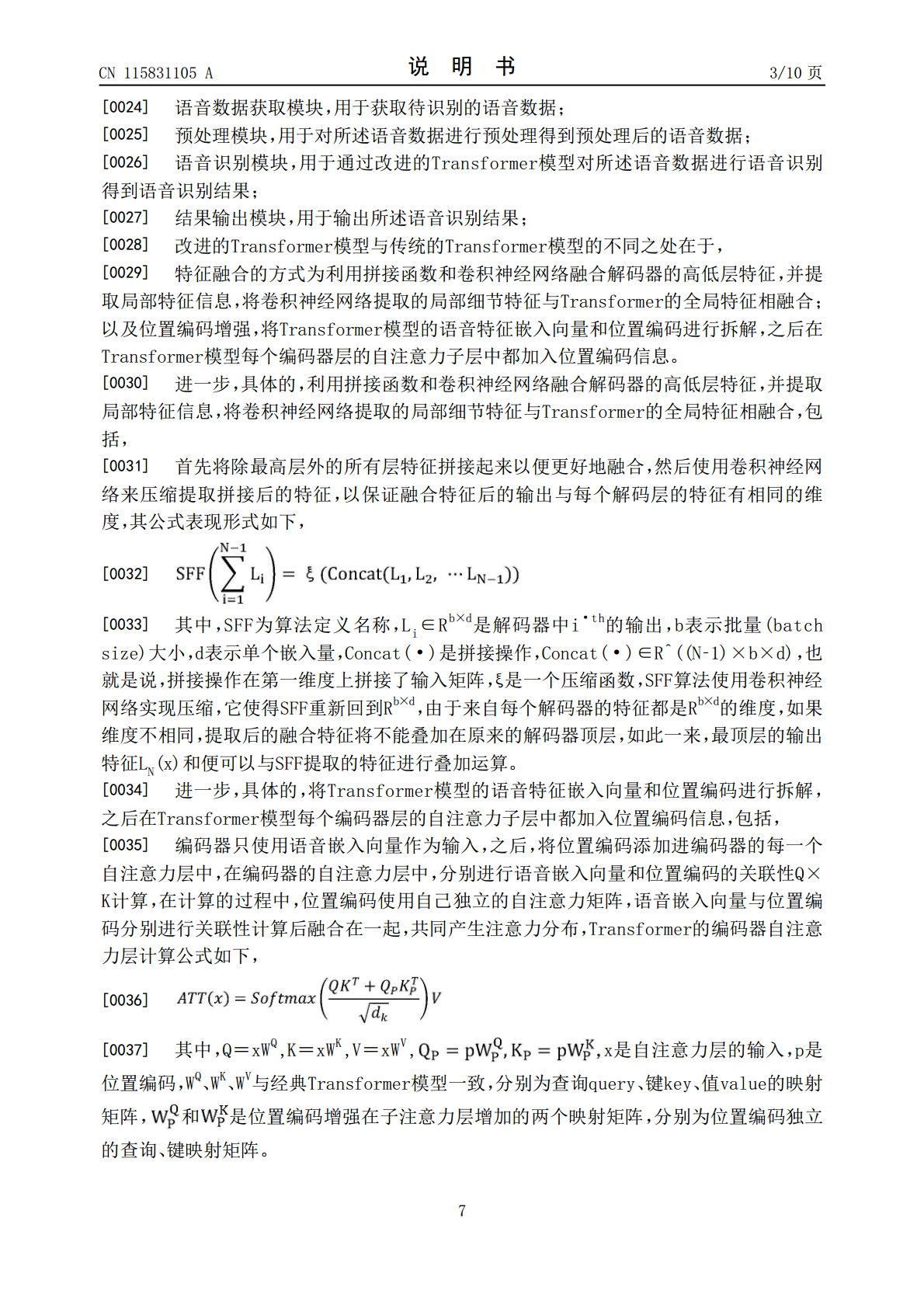

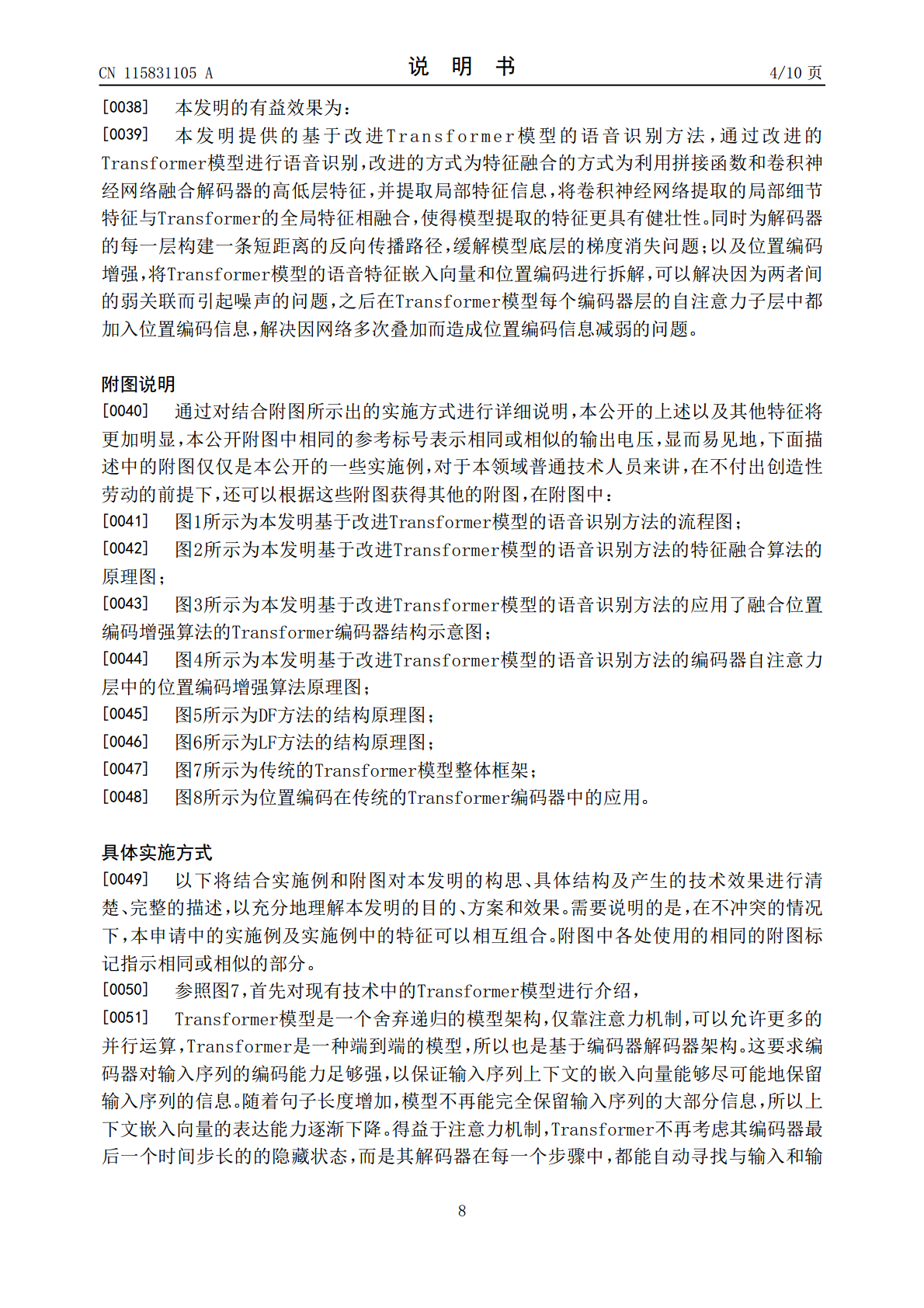

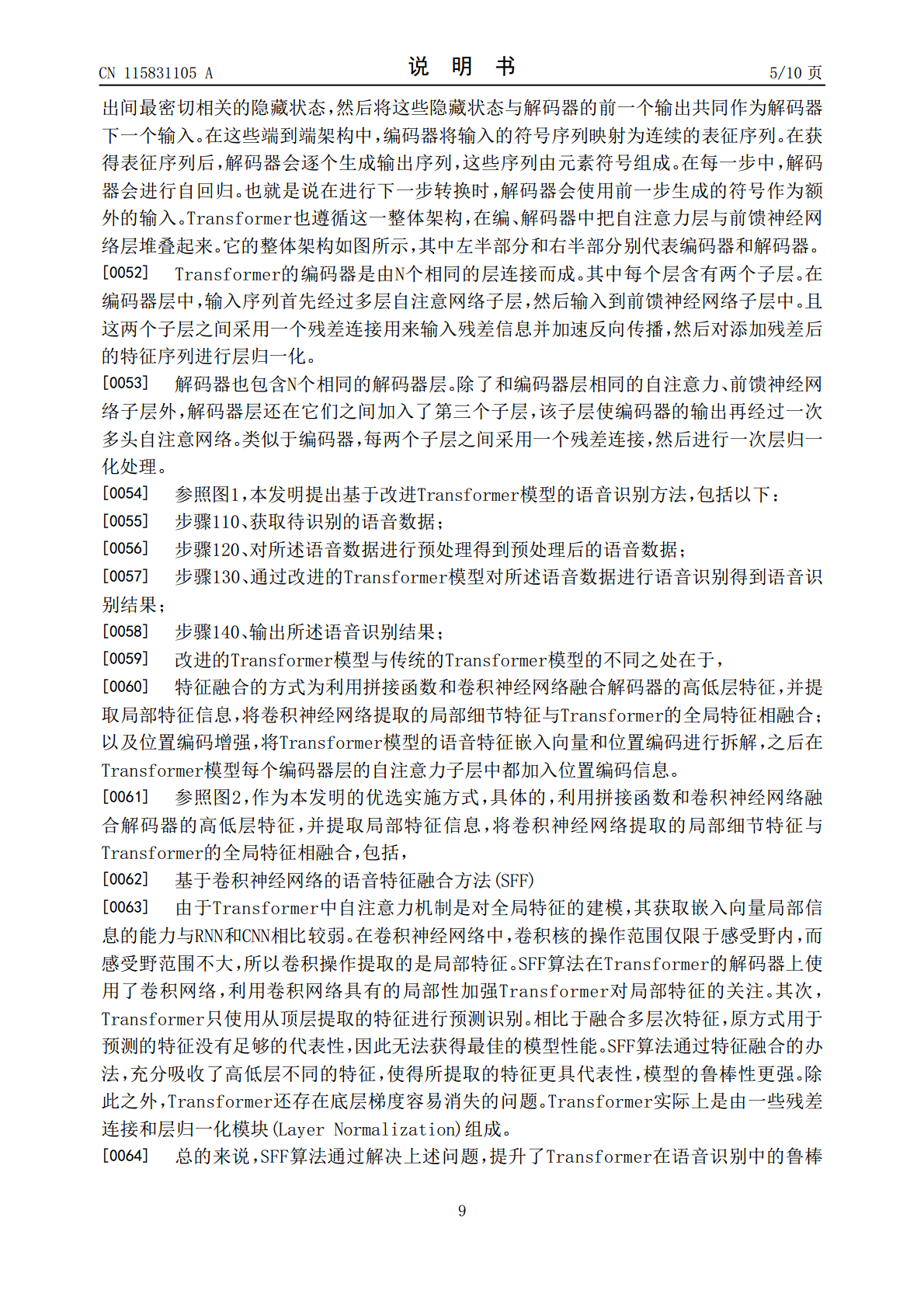

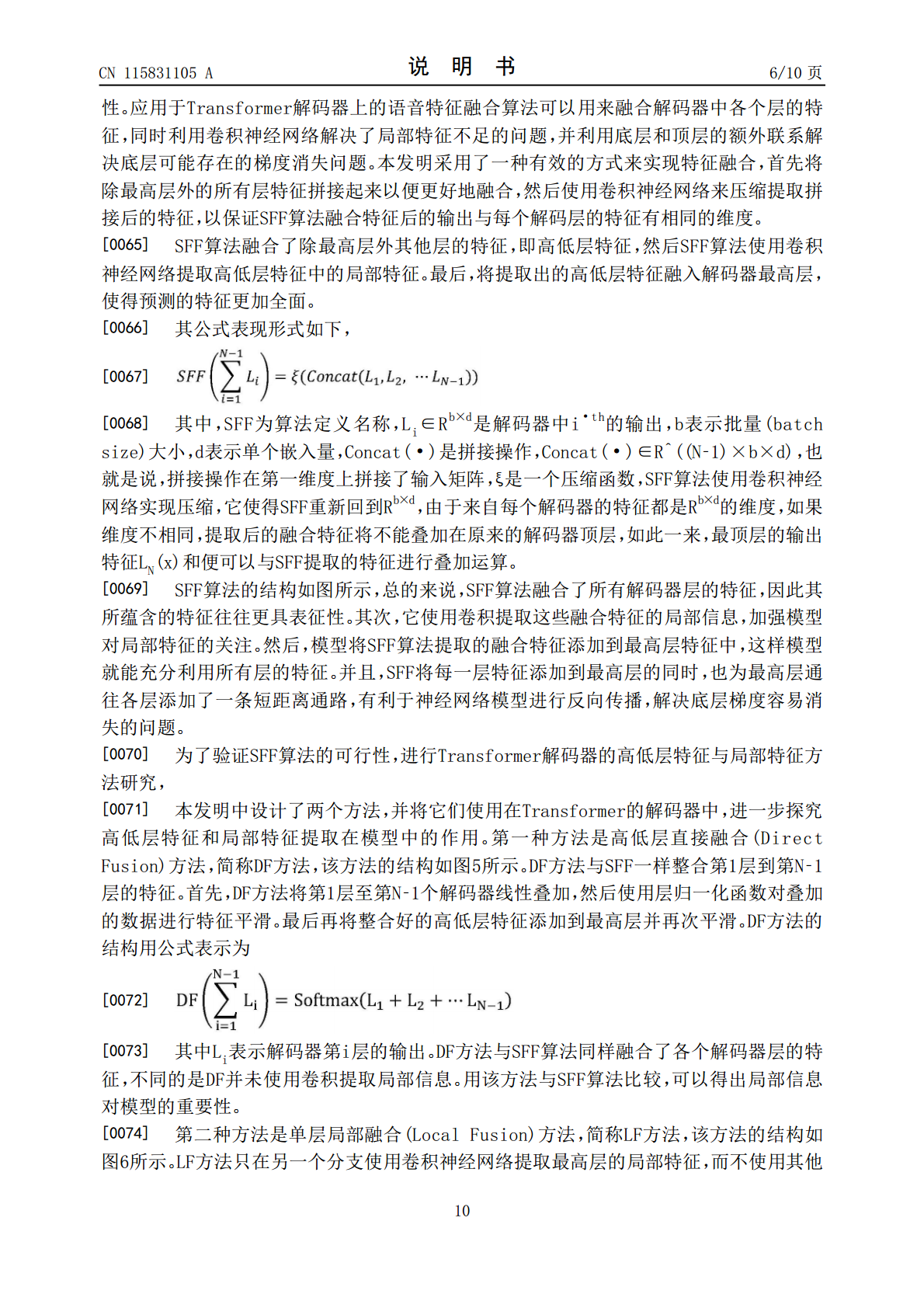

第39卷第6期中南大学学报(自然科学版)Vol.39No.62008年12月J.Cent.SouthUniv.(ScienceandTechnology)Dec.2008基于改进的隐马尔科夫模型的语音识别方法袁里驰1,2(1.中南大学信息科学与工程学院,湖南长沙,410083;2.江西财经大学信息管理学院,江西南昌,330013)摘要:针对隐马尔可夫(HMM)语音识别模型状态输出独立同分布等与语音实际特性不够协调的假设以及在使用段长信息时存在的缺陷,对隐马尔可夫模型进行改进,提出马尔可夫族模型。马尔可夫族