基于多目标深度强化学习的无人机边缘计算卸载方法.pdf

一只****ua

亲,该文档总共20页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

基于多目标深度强化学习的无人机边缘计算卸载方法.pdf

本发明涉及一种基于多目标深度强化学习的无人机边缘计算卸载方法,包括以下步骤:构建无人机‑移动边缘计算系统,采用深度强化学习的方法对无人机‑移动边缘计算系统的最小化时延和能耗的任务卸载模型进行求解,初始化用户偏好空间;对深度强化学习中的Q网络和目标Q网络进行初始化;偏好经验池更新;选择当前状态下的动作,并执行动作得到向量值奖励和下一个状态;经验存储操作;经验样本训练:输出卸载决策。本发明将UAV‑MEC系统的COP建模为一个多目标马尔可夫决策过程,并采用多目标深度强化学习方法进行求解,得到满足用户需求的最优

车辆边缘计算中基于联邦深度强化学习的任务卸载方法.pdf

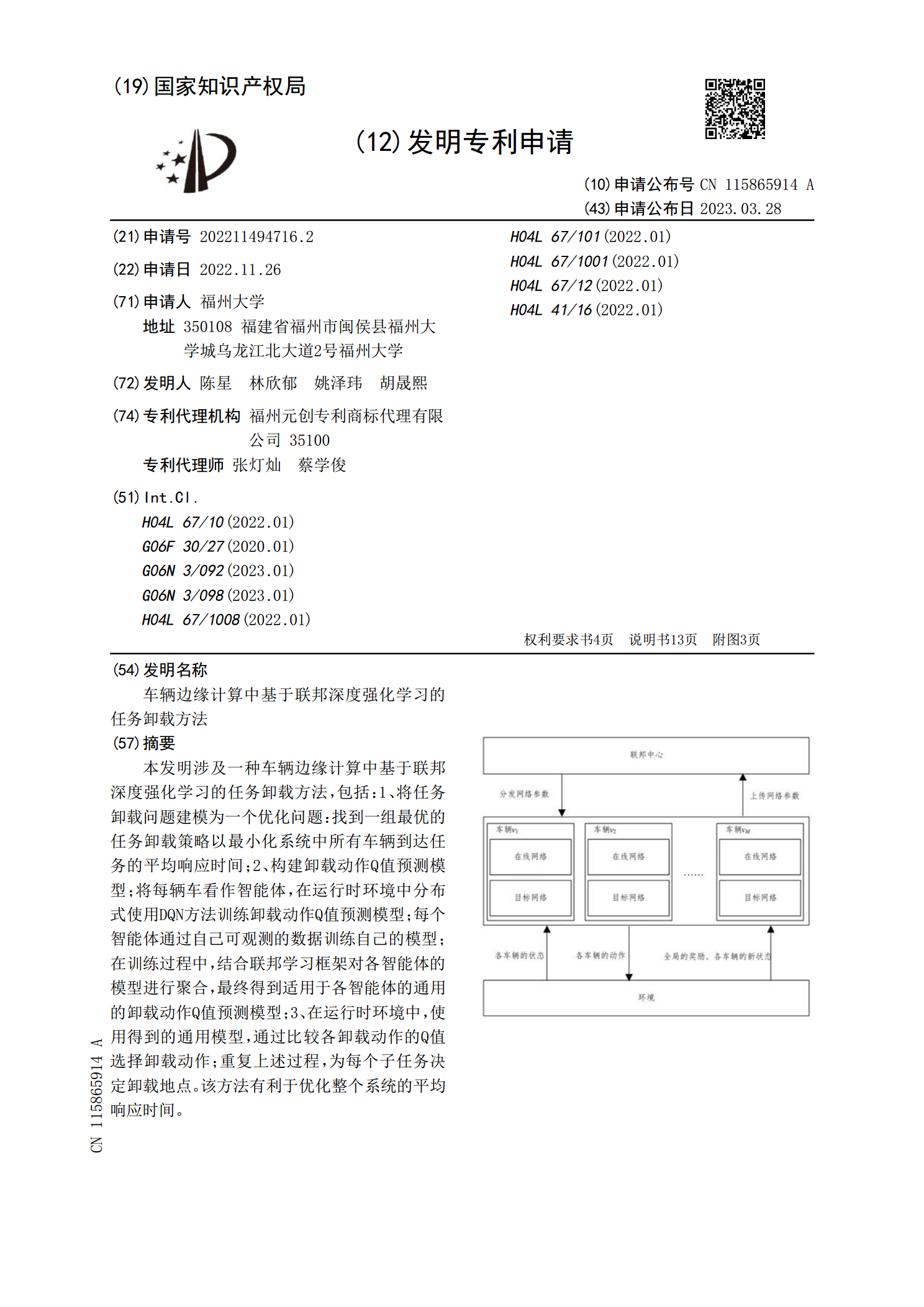

本发明涉及一种车辆边缘计算中基于联邦深度强化学习的任务卸载方法,包括:1、将任务卸载问题建模为一个优化问题:找到一组最优的任务卸载策略以最小化系统中所有车辆到达任务的平均响应时间;2、构建卸载动作Q值预测模型;将每辆车看作智能体,在运行时环境中分布式使用DQN方法训练卸载动作Q值预测模型;每个智能体通过自己可观测的数据训练自己的模型;在训练过程中,结合联邦学习框架对各智能体的模型进行聚合,最终得到适用于各智能体的通用的卸载动作Q值预测模型;3、在运行时环境中,使用得到的通用模型,通过比较各卸载动作的Q值选

基于深度强化学习的移动边缘计算任务卸载研究.docx

基于深度强化学习的移动边缘计算任务卸载研究基于深度强化学习的移动边缘计算任务卸载研究摘要:随着物联网和边缘计算的迅速发展,移动边缘计算作为一种有效的分布式计算模式,受到了广泛关注。移动边缘计算可以将计算任务卸载到靠近用户的边缘节点上,从而实现低延迟、高带宽的计算服务。然而,在移动边缘计算环境中,任务卸载决策面临着复杂的问题,包括多个用户设备和边缘节点的动态变化、网络带宽和计算资源的限制等。为了解决这些问题,本文提出了一种基于深度强化学习的移动边缘计算任务卸载方法。通过构建一个强化学习模型,利用深度神经网络

基于深度强化学习的边缘计算实时比例任务卸载.docx

基于深度强化学习的边缘计算实时比例任务卸载一、研究背景与意义随着物联网技术的快速发展,边缘计算作为一种新兴的计算模式,逐渐成为解决大数据处理和实时任务卸载的重要手段。边缘计算可以将计算任务从云端卸载到离数据源更近的设备上,降低网络延迟,提高数据传输效率,同时减少对云端资源的消耗。在实际应用中,边缘设备的计算能力有限,如何有效地利用这些设备进行实时比例任务卸载,提高边缘设备的计算性能和运行效率,成为了亟待解决的问题。深度强化学习(DeepReinforcementLearning,DRL)是一种模拟人类智能

一种基于深度强化学习的协作边缘计算任务卸载方法.pdf

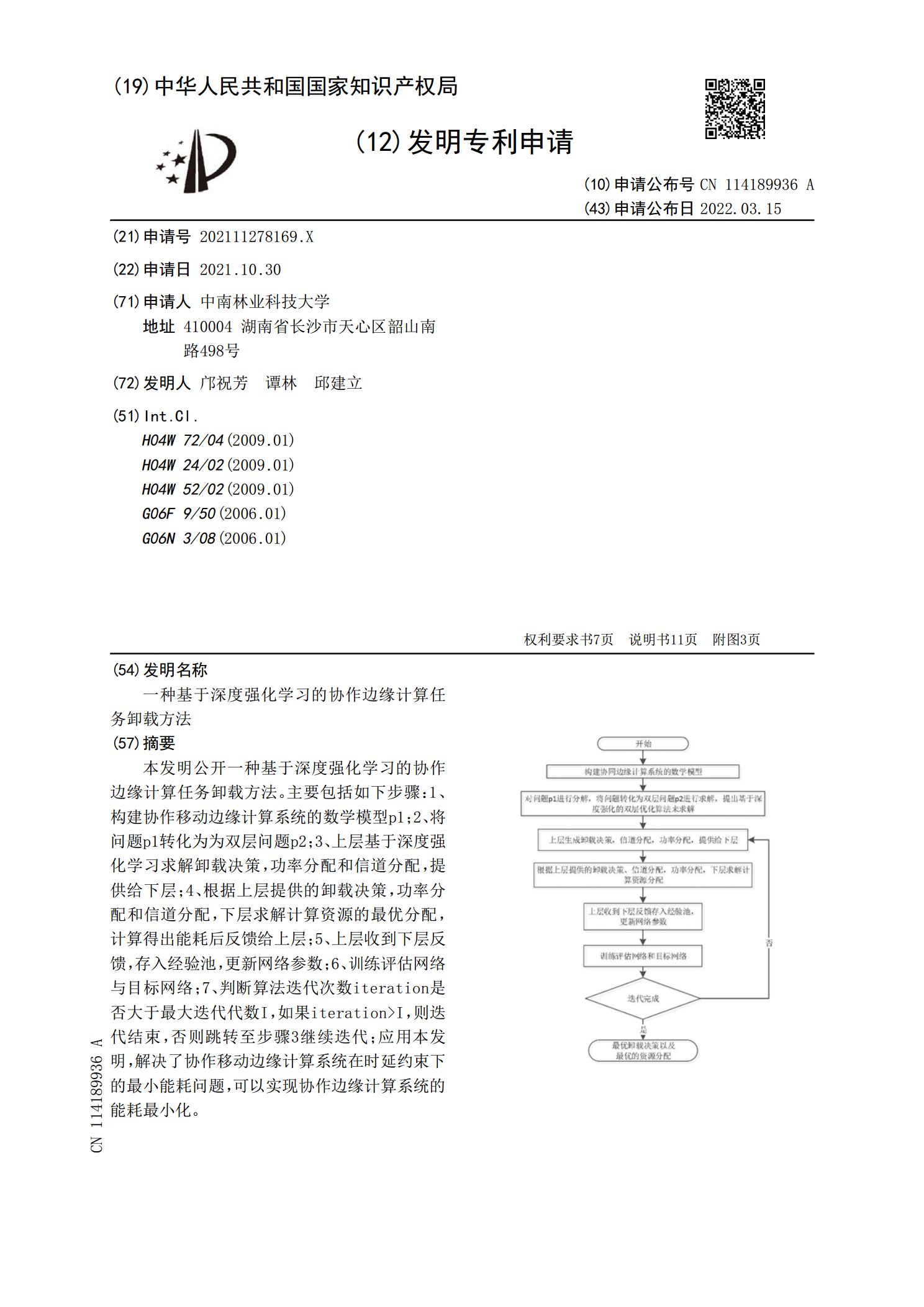

本发明公开一种基于深度强化学习的协作边缘计算任务卸载方法。主要包括如下步骤:1、构建协作移动边缘计算系统的数学模型p1;2、将问题p1转化为为双层问题p2;3、上层基于深度强化学习求解卸载决策,功率分配和信道分配,提供给下层;4、根据上层提供的卸载决策,功率分配和信道分配,下层求解计算资源的最优分配,计算得出能耗后反馈给上层;5、上层收到下层反馈,存入经验池,更新网络参数;6、训练评估网络与目标网络;7、判断算法迭代次数iteration是否大于最大迭代代数I,如果iteration>I,则迭代结束