kafka参数说明.docx

宜然****找我

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

kafka参数说明.docx

#############################System##############################唯一标识在集群中的ID,要求是正数。broker.id=0#服务端口,默认9092port=9092#监听地址,不设为所有地址host.name=debugo01#处理网络请求的最大线程数num.network.threads=2#处理磁盘I/O的线程数num.io.threads=8#一些后台线程数background.threads=4#等待IO线程处理的请求队列最大数qu

kafka参数说明.docx

#############################System##############################唯一标识在集群中的ID,要求是正数。broker.id=0#服务端口,默认9092port=9092#监听地址,不设为所有地址host.name=debugo01#处理网络请求的最大线程数num.network.threads=2#处理磁盘I/O的线程数num.io.threads=8#一些后台线程数background.threads=4#等待IO线程处理的请求队列最大数qu

kafka参数配置详解.pdf

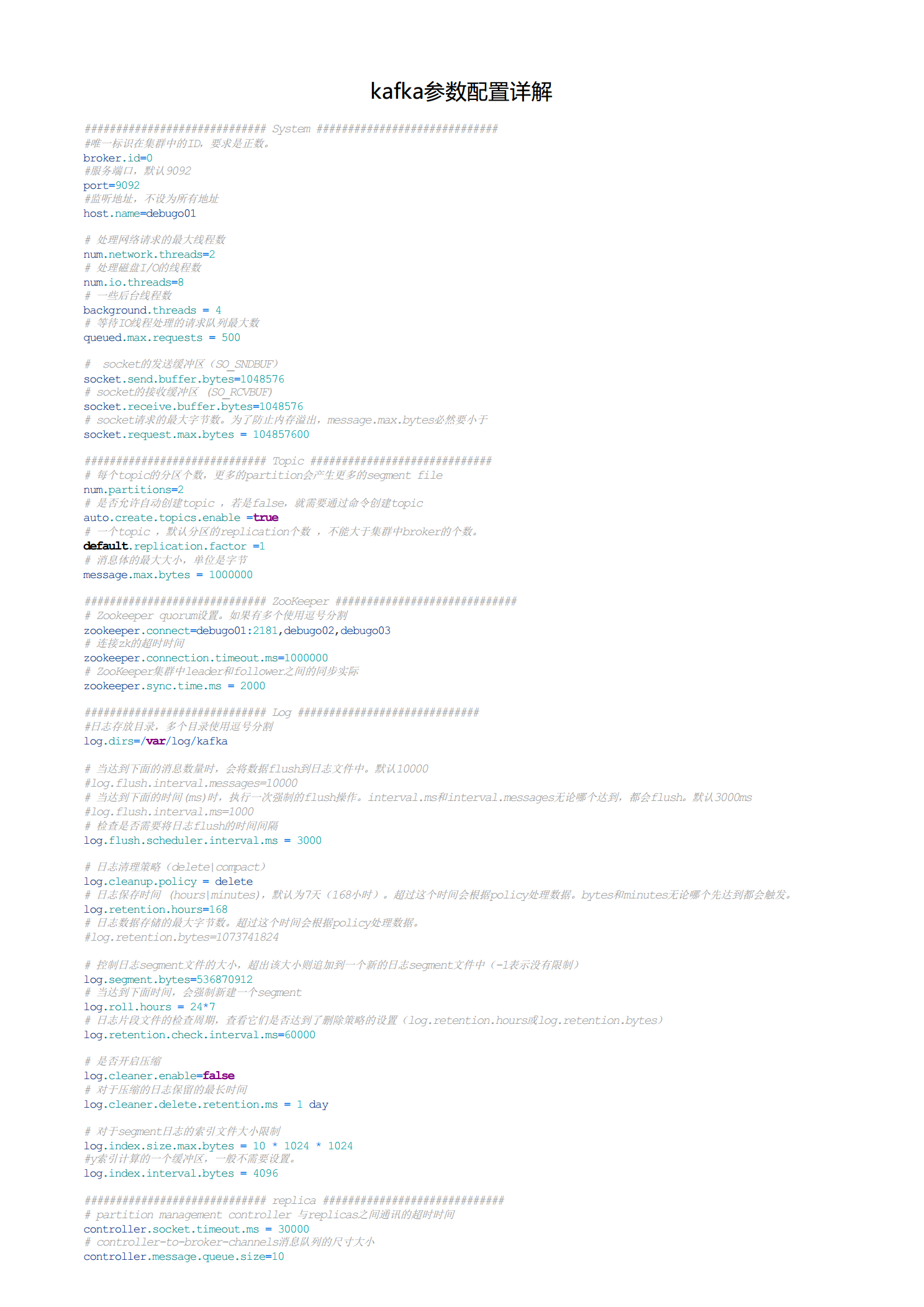

kafka参数配置详解#############################System##############################唯一标识ID在集群中的,要求是正数。broker.id=0#9服09务2端口,默认port=9092#监听地址,不设为所有地址host.name=debugo01#处理网络请求的最大线程数num.network.threads=2#I/O处理磁盘的线程数num.io.threads=8#一些后台线程数background.threads=4#IO等待线程处

kafka参数配置详解.pdf

kafka参数配置详解#############################System##############################唯一标识在集群中的ID,要求是正数。broker.id=0#服务端口,默认9092port=9092#监听地址,不设为所有地址host.name=debugo01#处理网络请求的最大线程数num.network.threads=2#处理磁盘I/O的线程数num.io.threads=8#一些后台线程数background.threads=4#等待IO线程处

kafka参数配置详解.pdf

kafka参数配置详解#############################System##############################唯一标识在集群中的ID,要求是正数。broker.id=0#服务端口,默认9092port=9092#监听地址,不设为所有地址host.name=debugo01#处理网络请求的最大线程数num.network.threads=2#处理磁盘I/O的线程数num.io.threads=8#一些后台线程数background.threads=4#等待IO线程处