Python机器学习——原理算法及案例实战-微课视频版课件第章-Python常用机器学习库-其他库.pptx

胜利****实阿

亲,该文档总共47页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

Python机器学习——原理算法及案例实战-微课视频版课件第章-Python常用机器学习库-其他库.pptx

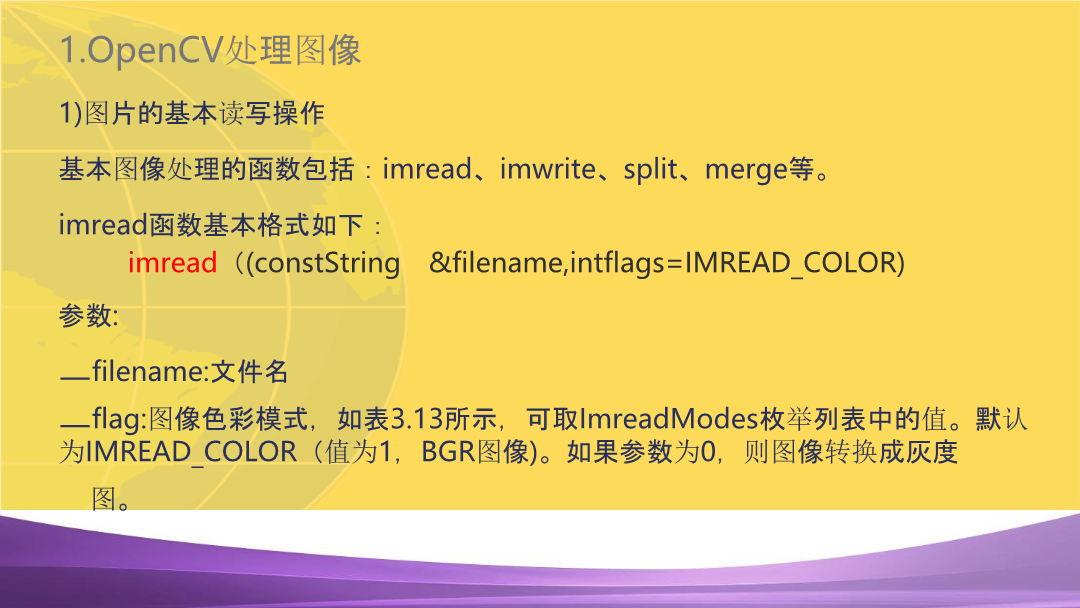

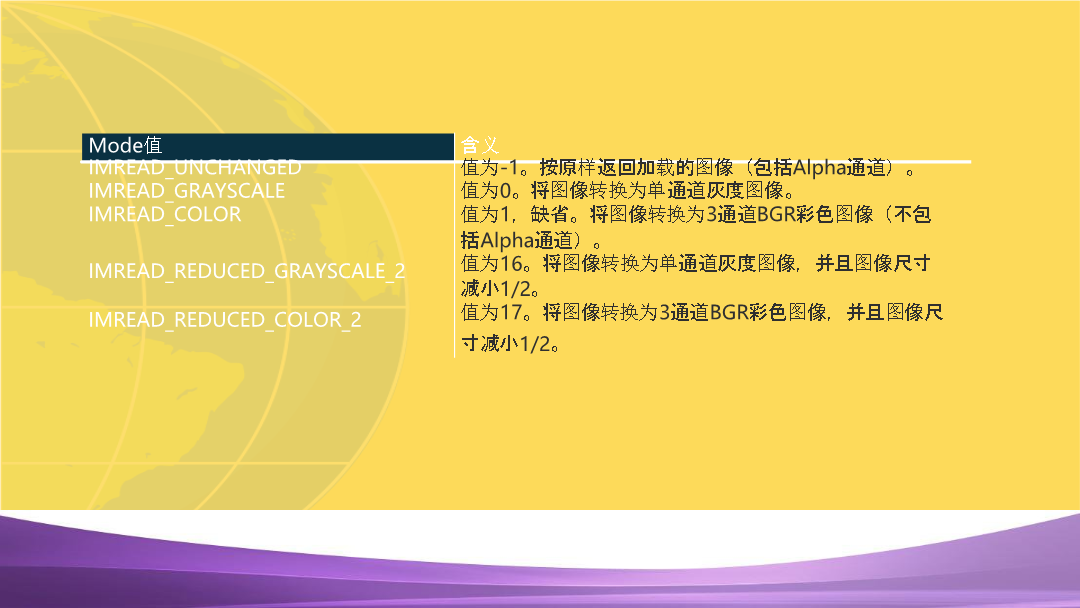

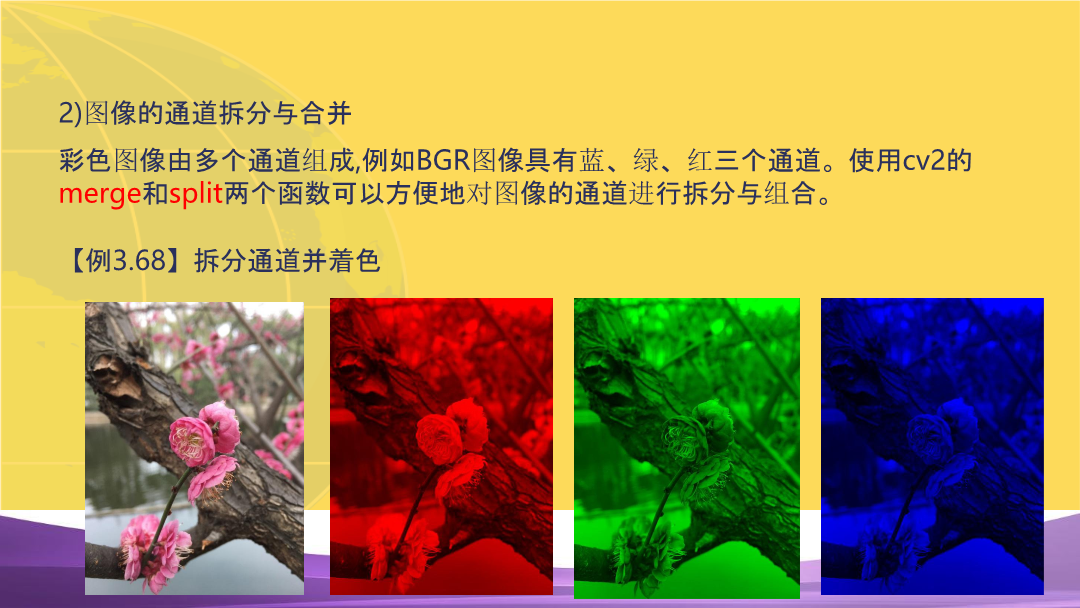

第3章Python常用机器学习库3.4OpenCV1.OpenCV窗口操作2)destroyAllWindows()与DestroyWindow(stringwinName)1.OpenCV处理图像【例3.67】2)图像的通道拆分与合并2.OpenCV捕获摄像头图像【例3.69】捕获摄像头图像。2)摄像头范围内的人脸检测【例3.70】检测摄像头范围内的人脸3.5ScikitlearnScikitlearn算法地图3.5.2SKlearn的一般步骤获取数据,创建数据集使用比较著名的是鸢尾花数据集,调用如

Python机器学习原理算法及案例实战答案.pdf

Python机器学习原理算法及案例实战答案1、k-近邻算法:手写字符识别通过算法训练识别字符为0-9的数字,也可以为A-Z的字符,目前sklearn提供的数据集里面为0-9的数字。数据训练前需要用图像处理软件将数字转换成宽高为32X32的黑白图像,然后将其变换成1x1024的向量。2、朴素贝叶斯:垃圾邮件过滤邮箱系统如何分辨一封Email是否属于垃圾邮件?这应该属于文本挖掘的范畴,通常会采用朴素贝叶斯的方法进行判别。它的主要原理是,根据邮件正文中的单词,是否经常出现在垃圾邮件中,进行判断。3、Logist

《Python机器学习:基础、算法与实战》记录.docx

本文档只有word版,所有PDF版本都为盗版,侵权必究《Python机器学习:基础、算法与实战》阅读笔记1.Python机器学习概述Python,作为一种高级编程语言,以其简洁的语法、强大的库支持和广泛的应用领域而著称。在机器学习领域,Python同样占据了一席之地,成为了众多数据科学家和机器学习工程师的首选开发工具。Python机器学习的基础主要建立在NumPy、pandas和scikitlearn等库之上。NumPy提供了多维数组对象和高效的数值计算功能,是进行机器学习数据处理和建模的基石。panda

Python机器学习库Scikit-learn.pdf

Python机器学习库Scikit-learnPython机器学习库Scikit-learn随着数据量的不断增加,数据挖掘技术越来越受到关注。机器学习作为一种数据挖掘技术,已经被证明可以处理各种大规模数据的问题。Scikit-learn是一个广泛使用的Python机器学习库,可以用来解决分类、回归、聚类和降维等各种机器学习问题。本论文将介绍Scikit-learn的主要特点和应用场景,并讨论它在机器学习领域中的重要性。Scikit-learn是一个用于Python编程语言的开放源代码软件库,简称sklea

基于Python的机器学习实战案例分析.pdf

基于Python的机器学习实战案例分析机器学习是目前最火热的技术领域之一,不仅可以应用在人工智能、自动驾驶、智能家居等领域,还可以为企业提供更加精准的决策支持。Python是一种广泛使用的编程语言,也是机器学习领域最受欢迎的语言之一。本文将介绍几个基于Python的机器学习实战案例,让读者深入了解Python在机器学习中的优势和应用。案例一:利用K近邻算法进行手写数字识别手写数字识别是机器学习中比较典型的问题,也是一个较为简单的案例。本案例利用K近邻算法对手写数字进行识别。K近邻算法是一种无监督式学习算法