一种基于显著轨迹空间信息的视频人体行为识别方法.pdf

猫巷****正德

亲,该文档总共11页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

一种基于显著轨迹空间信息的视频人体行为识别方法.pdf

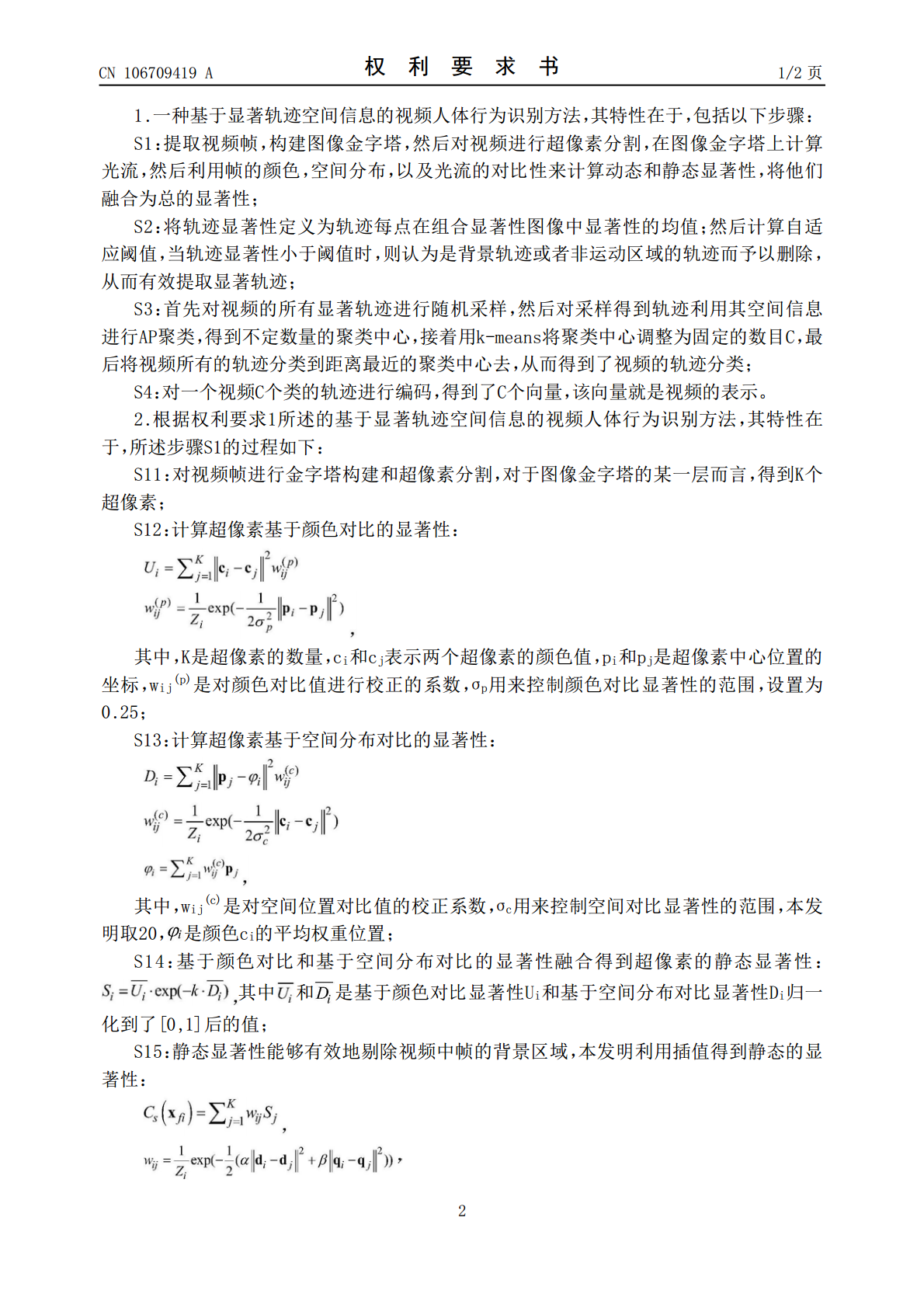

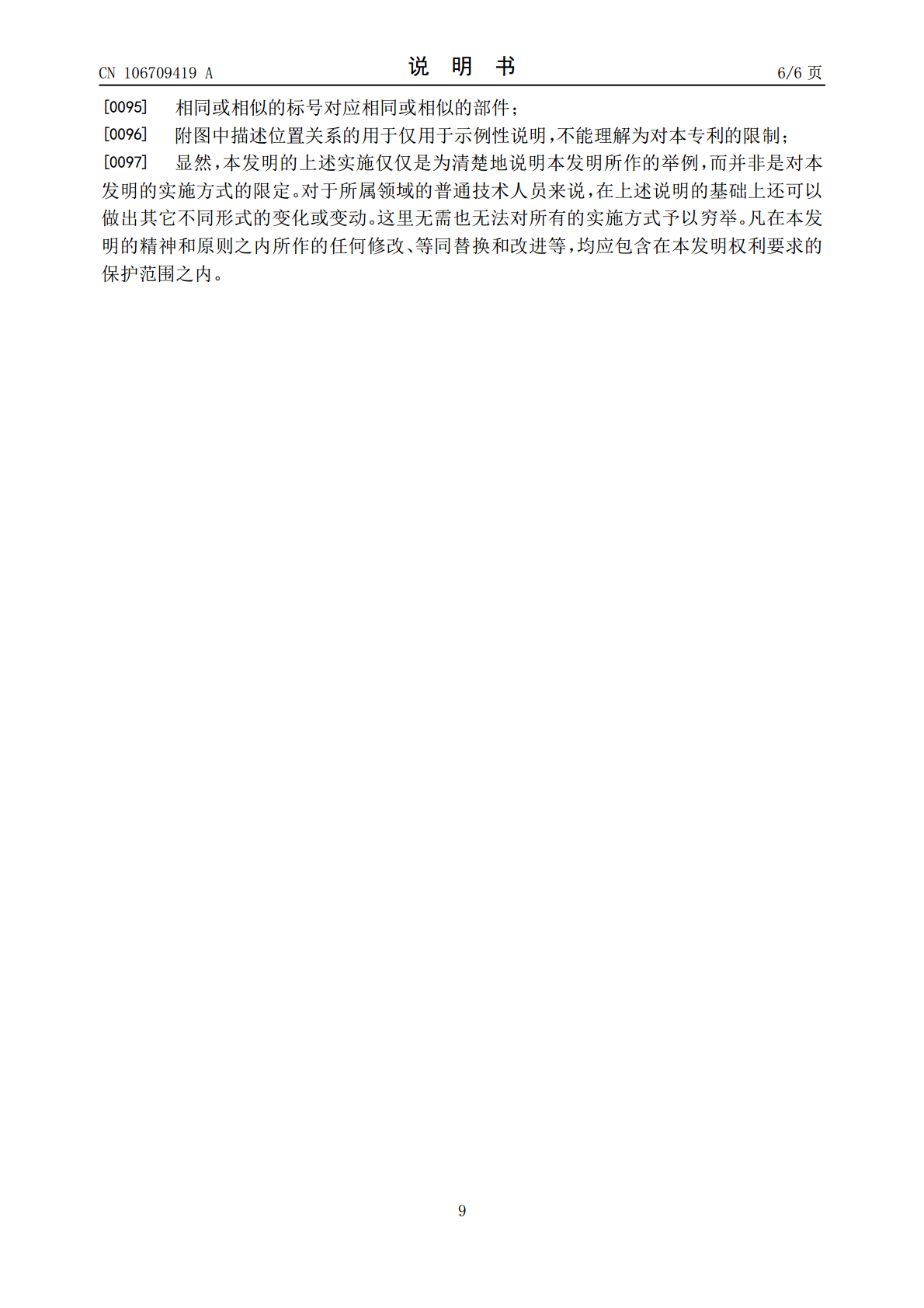

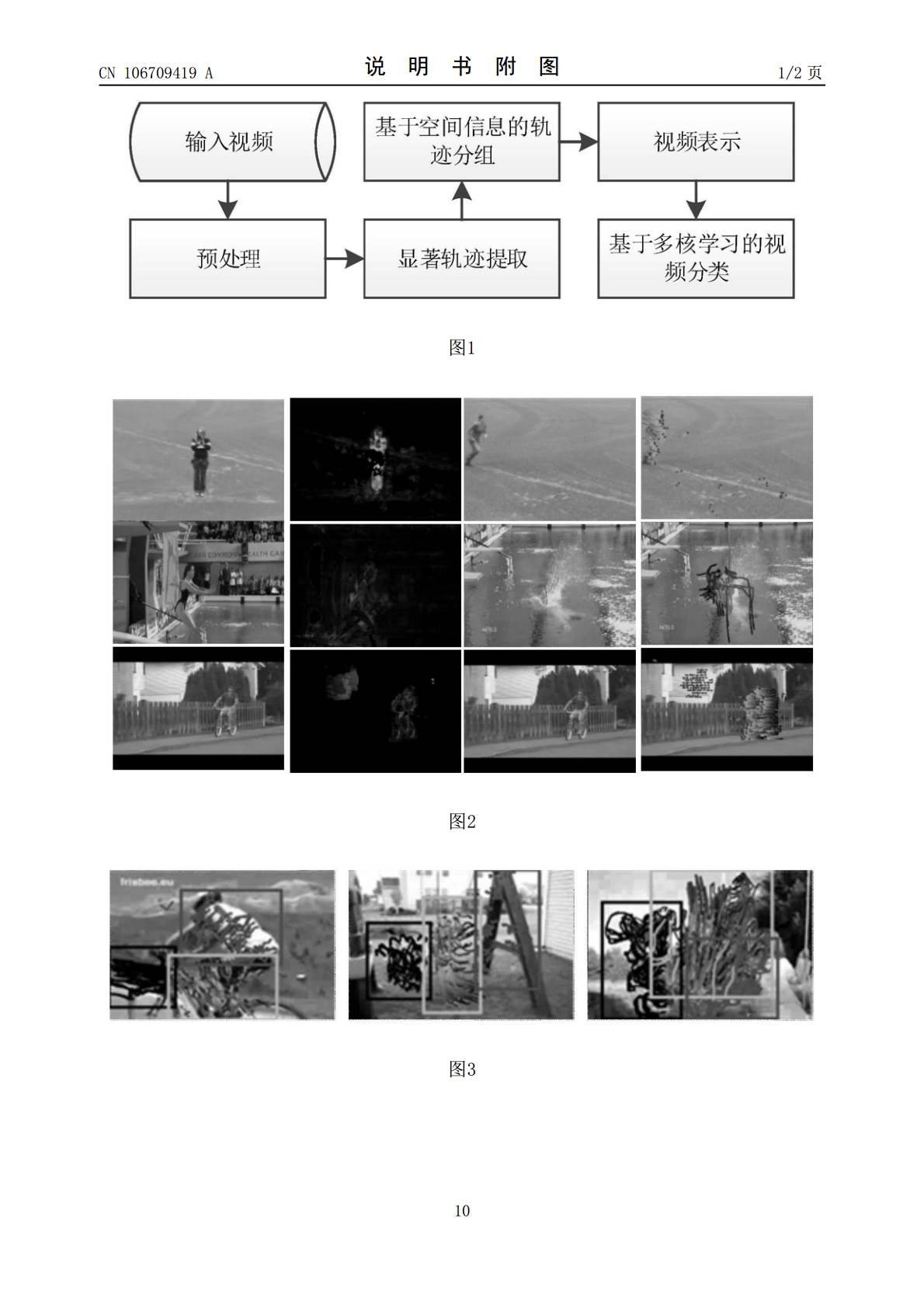

本发明提供一种基于显著轨迹空间信息的视频人体行为识别方法,该方法重新定义了视频中轨迹的显著性,有效地剔除视频中背景和人体非运动部位的轨迹,留下了前景中运动显著性高的轨迹,这些轨迹误差更小,表达能力也更强;另外该方法将不同人体部位的运动部件以及交互物体区分开来,并通过多核学习来利用他们之间的空间和语义关系,提高了算法的识别效果。

一种基于视频的人体行为识别方法.pdf

本发明公开了一种基于视频的人体行为识别方法,包括如下步骤:获取或选择包含深度和骨骼信息的人体行为视频的数据集,选择重要信息视频片段作为输入;对数据预处理:将深度图序列转化为三维点云,仅保留重要部位附近点云;对人体行为序列进行动作片段的划分,将每个动作的重要部位三维点云每帧叠加得到运动轨迹;对运动轨迹进行三维卷积神经网络特征图提取,得到时空特征图,根据骨骼点位置信息生成对应的热图;对时空特征图与热图进行操作,得到所有骨骼点特征集合。本发明可以充分利用局部的时空特征,充分考虑局部决策对识别效果的影响,从而有效

一种基于时序增强模块的视频人体行为识别方法.pdf

本发明公开了一种基于时序增强模块的人体行为识别方法,目的是提高人体行为识别的准确度。所述方法包括三个方面:(1)针对输入的视频片段进行稀疏采样,以及对提取到的特征进行保留时序信息的池化下采样;(2)构建时序增强模块,对时空特征进行提取激活,同时对时序信息进行增强和交互处理;(3)构建分类器得到行为识别结果。本发明在模型训练的过程中进行时序信息增强和交互处理,增强了视频帧之间的时序信息,为模型的训练提供了丰富的语义信息,增强了模型的鲁棒性和健壮性,由此可以提高人体行为识别的准确度。

一种基于显著性特征提取的视频行为识别方法.pdf

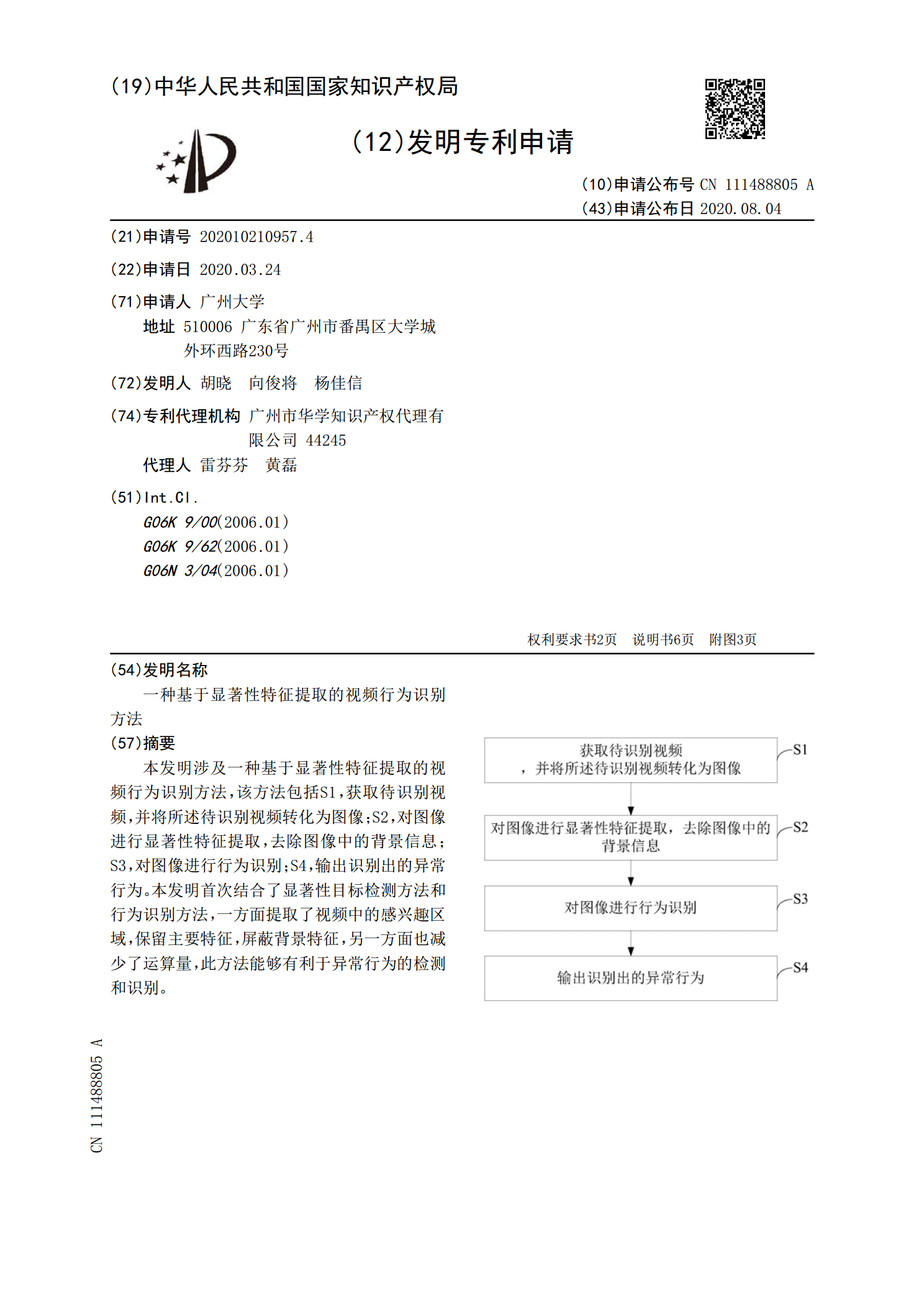

本发明涉及一种基于显著性特征提取的视频行为识别方法,该方法包括S1,获取待识别视频,并将所述待识别视频转化为图像;S2,对图像进行显著性特征提取,去除图像中的背景信息;S3,对图像进行行为识别;S4,输出识别出的异常行为。本发明首次结合了显著性目标检测方法和行为识别方法,一方面提取了视频中的感兴趣区域,保留主要特征,屏蔽背景特征,另一方面也减少了运算量,此方法能够有利于异常行为的检测和识别。

基于深度视频序列的人体行为识别方法研究.docx

基于深度视频序列的人体行为识别方法研究基于深度视频序列的人体行为识别方法研究摘要:人体行为识别是计算机视觉领域的一个重要研究方向,其应用涵盖了智能监控、人机交互、安防等多个领域。传统的基于2D图像的人体行为识别方法面临着视角变化、光照变化、遮挡等问题,限制了其在实际环境中的应用。近年来,深度学习技术的快速发展为基于深度视频序列的人体行为识别提供了新的解决思路。本文将重点探讨基于深度视频序列的人体行为识别方法,包括数据获取、特征提取、分类器设计等内容,并对未来的研究方向进行展望。1.引言人体行为识别是计算机