一种基于生成对抗网络的面部图像增强方法.pdf

青团****青吖

亲,该文档总共15页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

一种基于生成对抗网络的面部图像增强方法.pdf

本发明公开了一种基于生成对抗网络的面部图像增强方法.本发明包括以下步骤:1、使用3D稠密面部对齐方法对多种姿态的面部图像进行预处理;2、设计基于生成对抗网络的面部增强网络,两步生成对抗网络。3、针对任务需要设计Step‑I和Step‑II对应的目标函数4、使用MS‑1‑celeb预训练识别模型,并使用扩增数据预训练TS‑GAN模型;5、使用Multi‑PIE作为训练集,利用反向传播算法训练(4)中完成预训练的TS‑GAN模型参数,直至收敛。使用最终训练的TS‑GAN模型可以得到与输入图像对应的正脸图像,同

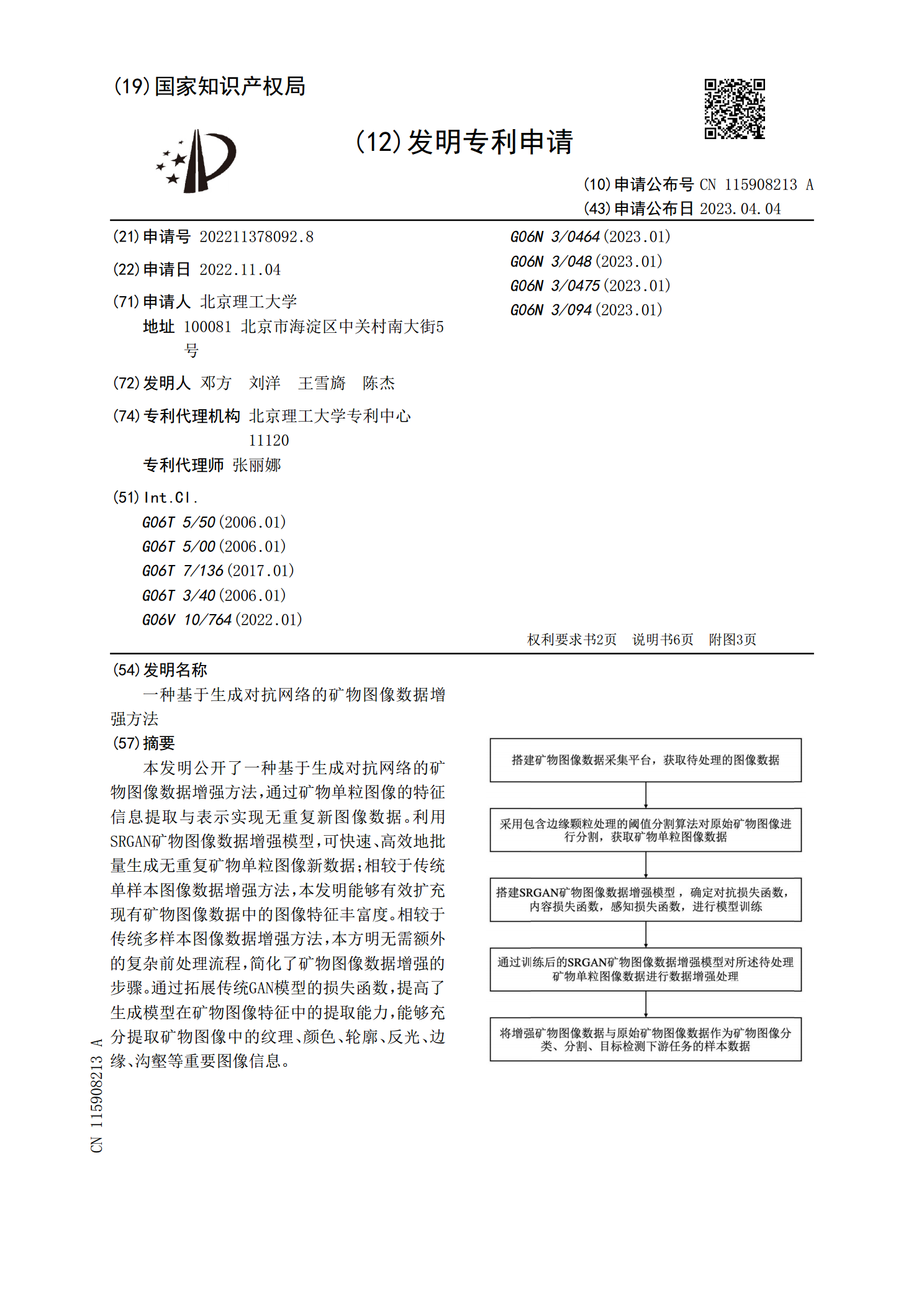

一种基于生成对抗网络的矿物图像数据增强方法.pdf

本发明公开了一种基于生成对抗网络的矿物图像数据增强方法,通过矿物单粒图像的特征信息提取与表示实现无重复新图像数据。利用SRGAN矿物图像数据增强模型,可快速、高效地批量生成无重复矿物单粒图像新数据;相较于传统单样本图像数据增强方法,本发明能够有效扩充现有矿物图像数据中的图像特征丰富度。相较于传统多样本图像数据增强方法,本方明无需额外的复杂前处理流程,简化了矿物图像数据增强的步骤。通过拓展传统GAN模型的损失函数,提高了生成模型在矿物图像特征中的提取能力,能够充分提取矿物图像中的纹理、颜色、轮廓、反光、边缘

基于生成对抗网络的人脸图像质量增强方法.pdf

本发明公开了人脸图像质量增加方法?生成对抗网络方法,具体地,包含以下五个步骤:1)静态人脸数据采集,2)数据处理,3)搭建生成对抗网络,4)训练生成对抗网络,5)测试生成对抗网络,本发明采用生成对抗网络来建模人脸图像质量,生成器包含图像增强、分辨率增强,图像增强实现对人脸图像亮度和噪声的矫正与增强,采用三种不同的方式来测量原始高质量人脸图像和增强后人脸图像之间的相似性,分别是MSE、SSIM以及判别器输出的分数,实现半监督的方法实现人脸图像质量增强,不需要标记训练数据,大大简化训练难度。

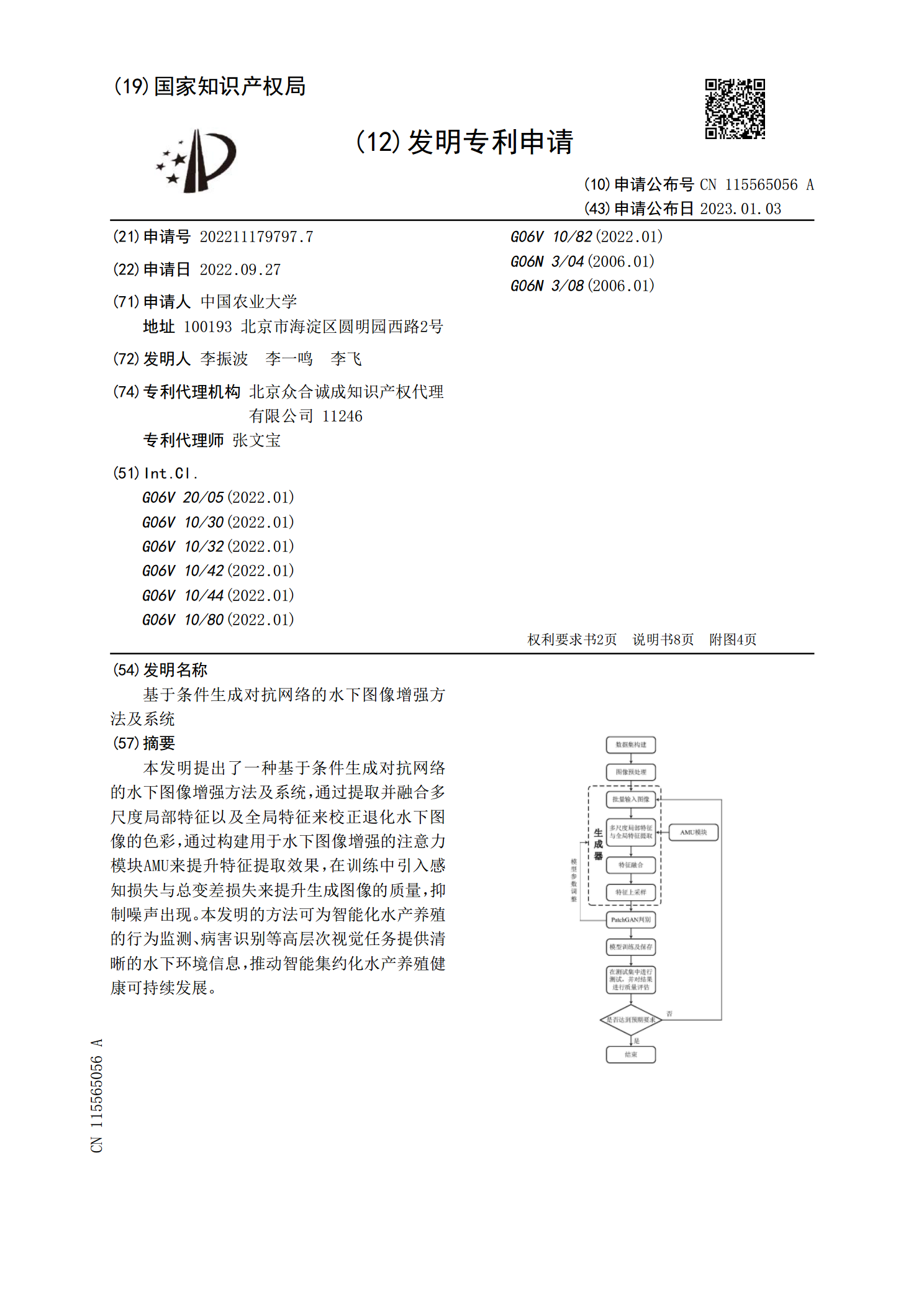

基于条件生成对抗网络的水下图像增强方法及系统.pdf

本发明提出了一种基于条件生成对抗网络的水下图像增强方法及系统,通过提取并融合多尺度局部特征以及全局特征来校正退化水下图像的色彩,通过构建用于水下图像增强的注意力模块AMU来提升特征提取效果,在训练中引入感知损失与总变差损失来提升生成图像的质量,抑制噪声出现。本发明的方法可为智能化水产养殖的行为监测、病害识别等高层次视觉任务提供清晰的水下环境信息,推动智能集约化水产养殖健康可持续发展。

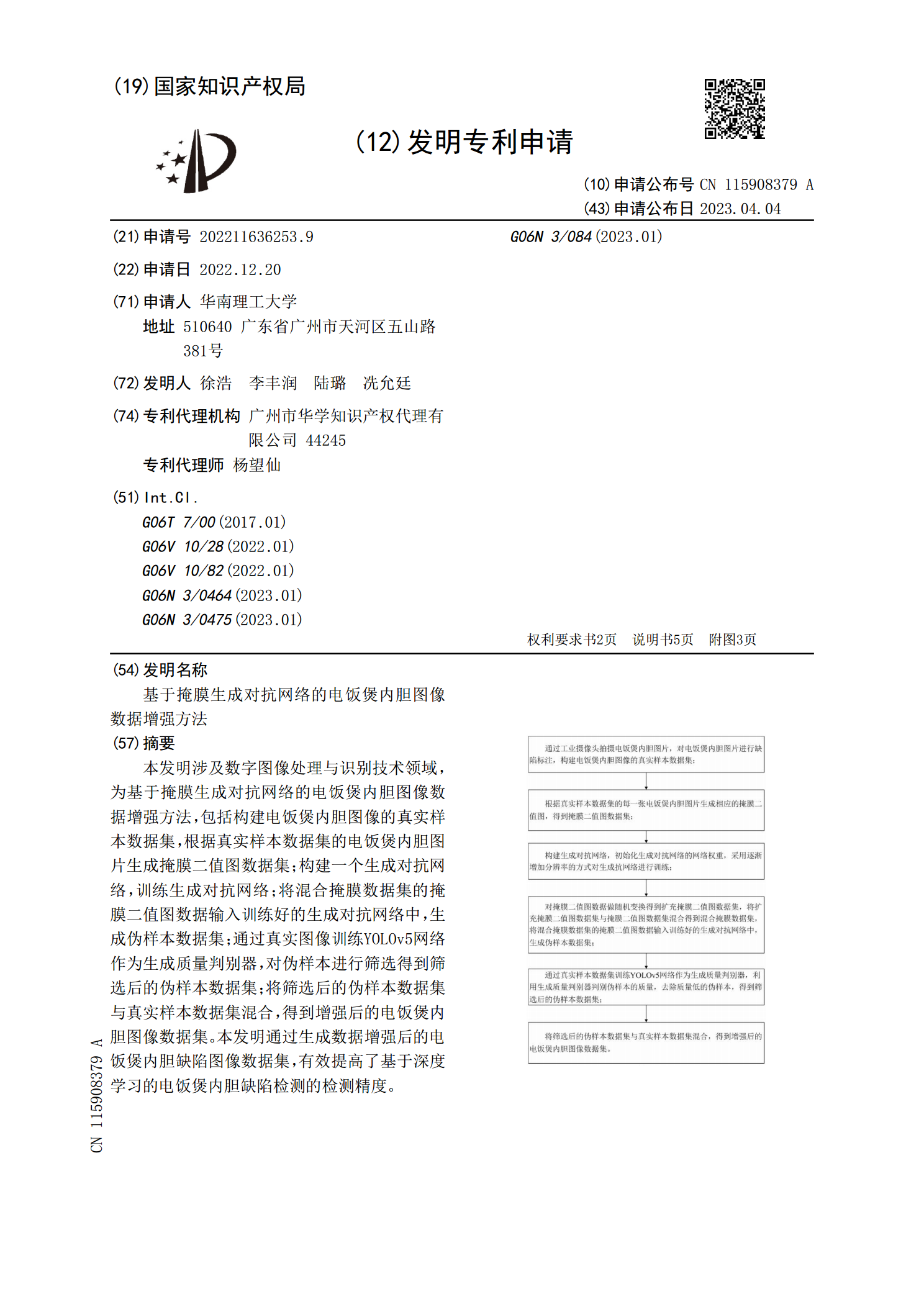

基于掩膜生成对抗网络的电饭煲内胆图像数据增强方法.pdf

本发明涉及数字图像处理与识别技术领域,为基于掩膜生成对抗网络的电饭煲内胆图像数据增强方法,包括构建电饭煲内胆图像的真实样本数据集,根据真实样本数据集的电饭煲内胆图片生成掩膜二值图数据集;构建一个生成对抗网络,训练生成对抗网络;将混合掩膜数据集的掩膜二值图数据输入训练好的生成对抗网络中,生成伪样本数据集;通过真实图像训练YOLOv5网络作为生成质量判别器,对伪样本进行筛选得到筛选后的伪样本数据集;将筛选后的伪样本数据集与真实样本数据集混合,得到增强后的电饭煲内胆图像数据集。本发明通过生成数据增强后的电饭煲内