一种云平台上基于SVM的恶意软件检测方法.pdf

星星****眨眼

亲,该文档总共14页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

一种云平台上基于SVM的恶意软件检测方法.pdf

本发明涉及一种云平台上基于SVM的恶意软件检测方法,属于信息安全领域。依次包括以下步骤:基于时序的API调用序列的提取、基于skip‑gram模型的API序列向量化、基于AutoEncoder模型的API向量降维、构建基于SVM的恶意软件检测模型、基于SVM的检测模型的训练。本发明选择的特征向量为软件的所有API调用序列,通过将序列进行压缩的操作尽最大可能地保留了序列特征,再将其输入到SVM模型中,不但有效提升检测效率,检测准确率也得到大幅提升。

基于SVM的敏感权限Android恶意软件检测方法.docx

基于SVM的敏感权限Android恶意软件检测方法随着智能手机的普及,安卓手机成为人们日常生活或工作中必不可少的设备。随之而来的是安卓恶意软件的数量激增。安卓恶意软件具有以下特点:难以检测、易于传播、危害巨大。其中,危害最大的安卓恶意软件依赖“敏感权限”,如获取用户的通讯录、短信、位置信息等。因此,如何实现高效准确的检测安卓敏感权限恶意软件是信息安全领域的研究热点。本文提出一种基于支持向量机(SVM)的敏感权限安卓恶意软件检测方法。该方法首先获取安装包的授权列表,将其转换为数字向量,然后利用SVM分类器对

基于SVM的安卓恶意软件检测.docx

基于SVM的安卓恶意软件检测随着移动设备的普及,安卓恶意软件的数量也越来越多。安卓恶意软件不仅会造成用户隐私泄露、资产损失等问题,还会对整个安卓生态系统造成危害。因此,安卓恶意软件检测成为了一个重要的研究领域。在安卓恶意软件检测中,机器学习算法是一种常用的方法,而支持向量机(SVM)是其中一种代表性算法。SVM是一种二分类的分类器,它将数据映射到高维空间中,通过构建一个最优的超平面来实现分类。SVM具有模型简单、分类精度高、鲁棒性强等优点,因此在安卓恶意软件检测中得到了广泛的应用。一般来说,SVM在安卓恶

基于Bagging-SVM的Android恶意软件检测模型.docx

基于Bagging-SVM的Android恶意软件检测模型INTRODUCTIONTherapidevolutionandproliferationofmobiledeviceshasincreasedtheprevalenceofmalwareonAndroiddevices.Researchersconstantlydiscovernewstrainsofmalicioussoftwarethatexploitvulnerabilitiesinthesedevices.Thus,thereisanee

基于SVM方法的恶意软件加壳分类系统的研究与实现.docx

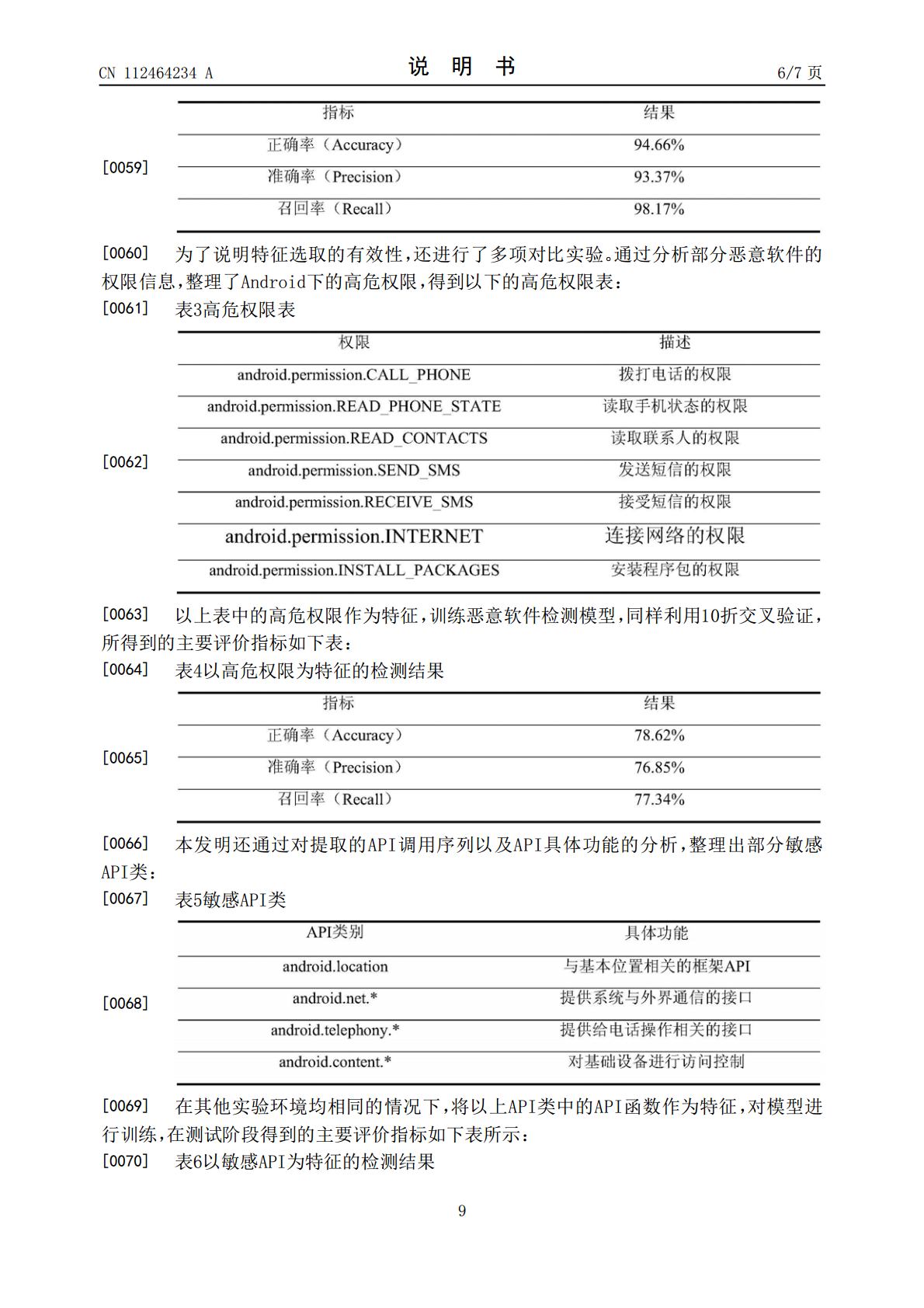

基于SVM方法的恶意软件加壳分类系统的研究与实现基于SVM方法的恶意软件加壳分类系统的研究与实现摘要:随着信息技术的快速发展,恶意软件已经成为互联网安全的主要威胁之一。恶意软件加壳是恶意软件作者用来逃避杀软和逆向分析的常用技术手段。为了对恶意软件进行准确分类和检测,本论文研究并实现了一种基于支持向量机(SVM)方法的恶意软件加壳分类系统。关键词:恶意软件、加壳、分类系统、支持向量机一、引言恶意软件是指那些具有恶意行为、潜在威胁计算机系统安全的软件程序。恶意软件被广泛应用于信息窃取、病毒传播、网络攻击等领域