基于语音雷达和深度学习的语音合成方法及系统.pdf

努力****向丝

亲,该文档总共14页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

基于语音雷达和深度学习的语音合成方法及系统.pdf

本发明公开了一种基于语音雷达和深度学习的语音合成方法及系统,方法包括:由雷达获得声带振动回波信号;将雷达回波信号经过模式分解获取基波,然后对基波进行中心削波作为语音激励源;由发音者发音时嘴唇区域视频通过深度学习方法训练共振峰估计模型;将测试者发音的视频作为输入,获得共振峰参数;最后基于雷达回波激励源模型和共振峰参数进行语音合成。本发明方法可以获得保留基频连续变化特性的语音激励源和更加准确的共振峰参数估计,通过语音合成器,可以获得自然度更高的合成语音。

基于深度学习的语音合成系统设计与实现.docx

基于深度学习的语音合成系统设计与实现基于深度学习的语音合成系统设计与实现摘要:随着深度学习技术的快速发展,语音合成技术也取得了显著的进展。本文针对基于深度学习的语音合成系统进行了设计与实现。首先,我们介绍了语音合成的背景和意义,并对现有的语音合成技术进行了综述。然后,我们详细阐述了基于深度学习的语音合成系统的设计原理和流程,并介绍了所用到的深度学习模型和算法。最后,我们通过实验验证了所设计的系统的性能,结果表明,基于深度学习的语音合成系统可以产生高质量的合成语音。关键词:深度学习,语音合成,系统设计,实现

基于深度学习的语音合成方法研究.docx

基于深度学习的语音合成方法研究基于深度学习的语音合成方法研究摘要:近年来,深度学习在语音合成领域取得了显著的进展。随着神经网络的快速发展和计算能力的提升,深度学习已经成为一种非常有效的语音合成方法。本文综述了基于深度学习的语音合成方法及其应用。首先,介绍了深度学习的基本概念和技术,包括深度神经网络、循环神经网络和卷积神经网络。然后,讨论了深度学习在语音合成中的应用,包括声码器建模、语音合成模型以及语音合成系统的开发。最后,讨论了深度学习在语音合成中的挑战和未来的研究方向。关键词:深度学习、语音合成、神经网

基于深度学习的多模态图像语音解读方法和系统.pdf

本发明公开了一种基于深度学习的多模态图像语音解读方法和系统,该方法包括搭建图像描述神经网络并训练得到图像描述神经网络模型;搭建语音转换神经网络并训练得到语音转换神经网络模型;获取待语音解读的图像,经图像描述神经网络模型翻译成文字序列、再经语音转换神经网络模型输出与文字序列对应的语音音频。本发明用于实现对无文字图片内容的理解并用语音的方式对图片中存在的对象及多个对象之间的关系、行为进行解读。有助于视觉障碍者对身边环境的实时了解,有助于该类人群的日常生活。同时,上述方案可以应用于幼儿教育,在小孩学习身边事物的

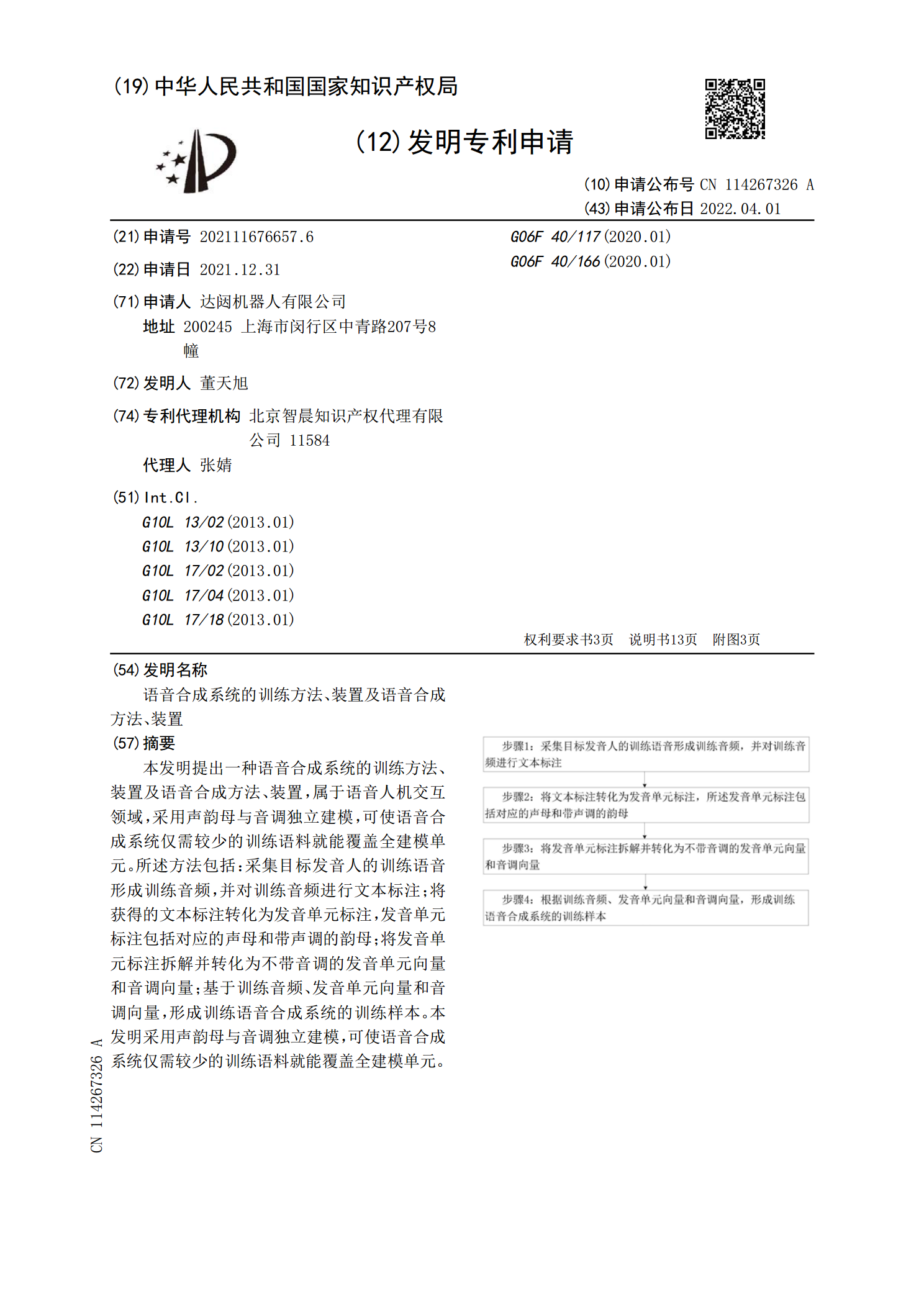

语音合成系统的训练方法、装置及语音合成方法、装置.pdf

本发明提出一种语音合成系统的训练方法、装置及语音合成方法、装置,属于语音人机交互领域,采用声韵母与音调独立建模,可使语音合成系统仅需较少的训练语料就能覆盖全建模单元。所述方法包括:采集目标发音人的训练语音形成训练音频,并对训练音频进行文本标注;将获得的文本标注转化为发音单元标注,发音单元标注包括对应的声母和带声调的韵母;将发音单元标注拆解并转化为不带音调的发音单元向量和音调向量;基于训练音频、发音单元向量和音调向量,形成训练语音合成系统的训练样本。本发明采用声韵母与音调独立建模,可使语音合成系统仅需较少的