基于双注意力机制的稀疏剪枝方法.pdf

雨巷****莺莺

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于双注意力机制的稀疏剪枝方法.pdf

本发明公开了一种基于双注意力机制的稀疏剪枝方法,该方法在保证性能精度较好的条件下高效压缩网络模型大小和参数量。根据空间注意力和通道注意力理论,融合通道注意力和空间注意力机制模块筛选注意力位于网络模型中最佳结构,随后根据网络中不同权重所对应的掩码来选择性保留和剔除相对应权重,通过掩码矩阵来更新和完成剪枝操作,同时根据神经网络总体空间损失实时更新掩码矩阵和权重矩阵。通过Pytorch深度学习框架来不断更新网络权重,并根据掩码矩阵对神经网络进行剪枝操作。实验结果表明本方法在对公共数据集进行性能测试时识别准确率较

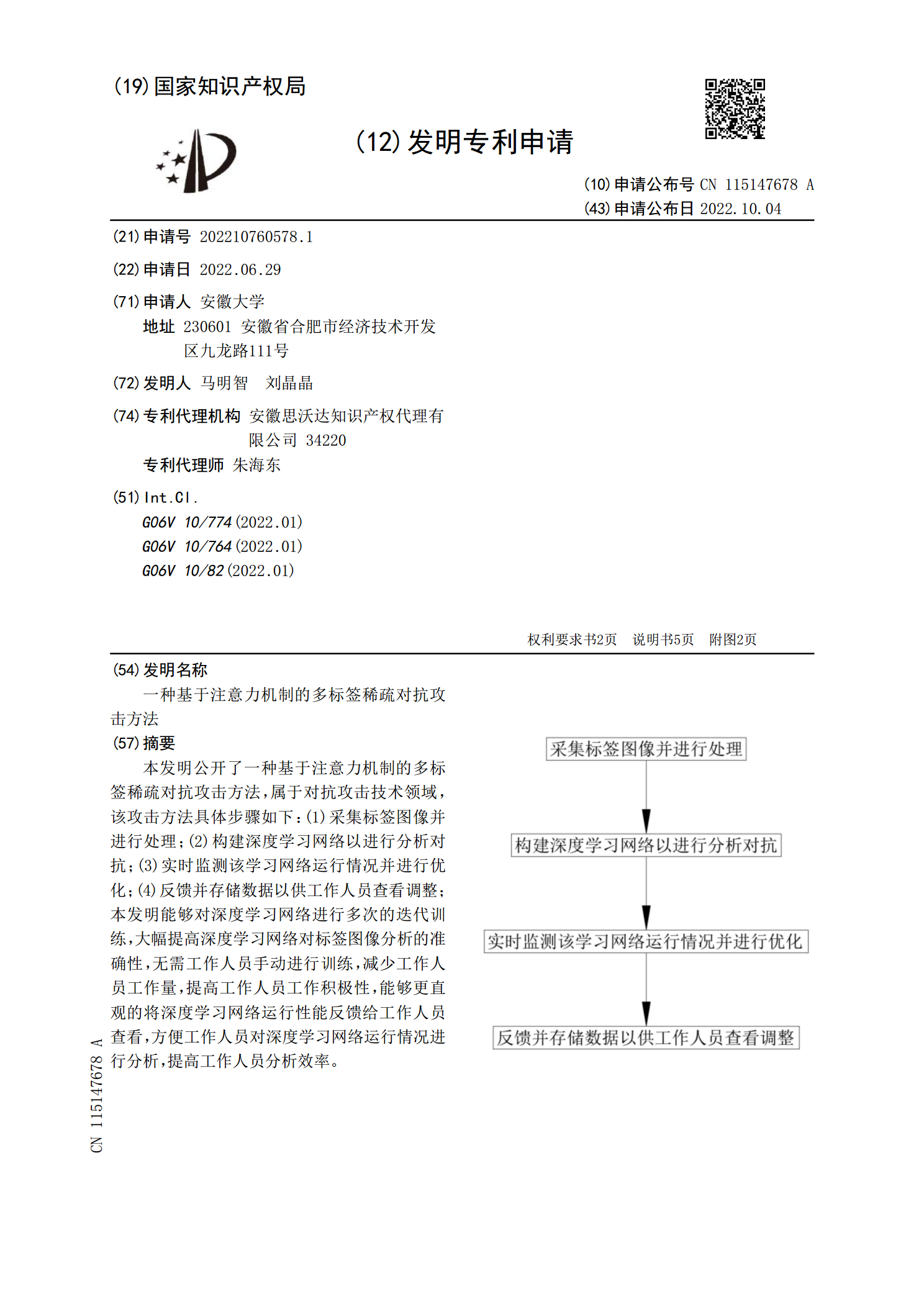

一种基于注意力机制的多标签稀疏对抗攻击方法.pdf

本发明公开了一种基于注意力机制的多标签稀疏对抗攻击方法,属于对抗攻击技术领域,该攻击方法具体步骤如下:(1)采集标签图像并进行处理;(2)构建深度学习网络以进行分析对抗;(3)实时监测该学习网络运行情况并进行优化;(4)反馈并存储数据以供工作人员查看调整;本发明能够对深度学习网络进行多次的迭代训练,大幅提高深度学习网络对标签图像分析的准确性,无需工作人员手动进行训练,减少工作人员工作量,提高工作人员工作积极性,能够更直观的将深度学习网络运行性能反馈给工作人员查看,方便工作人员对深度学习网络运行情况进行分析

基于子空间稀疏注意力机制的唇语识别方法、系统及介质.pdf

本发明涉及一种基于子空间稀疏注意力机制的唇语识别方法、系统及介质,方法包括:获取唇部区域图像序列,基于所述唇部区域图像序列提取得到唇部特征序列;将所述唇部特征序列输入到预设的训练完备的音素序列提取模型,得到与所述唇部特征序列相对应的发音音素序列;将所述发音音素序列输入到搭建有子空间稀疏自注意力机制的句子推理模型中得到目标句子序列。本发明通过构建一个特殊的注意力机制对上下文信息进行增强,实现了在一个正向操作中预测长句子序列,从而大大提高推理速率和准确率。

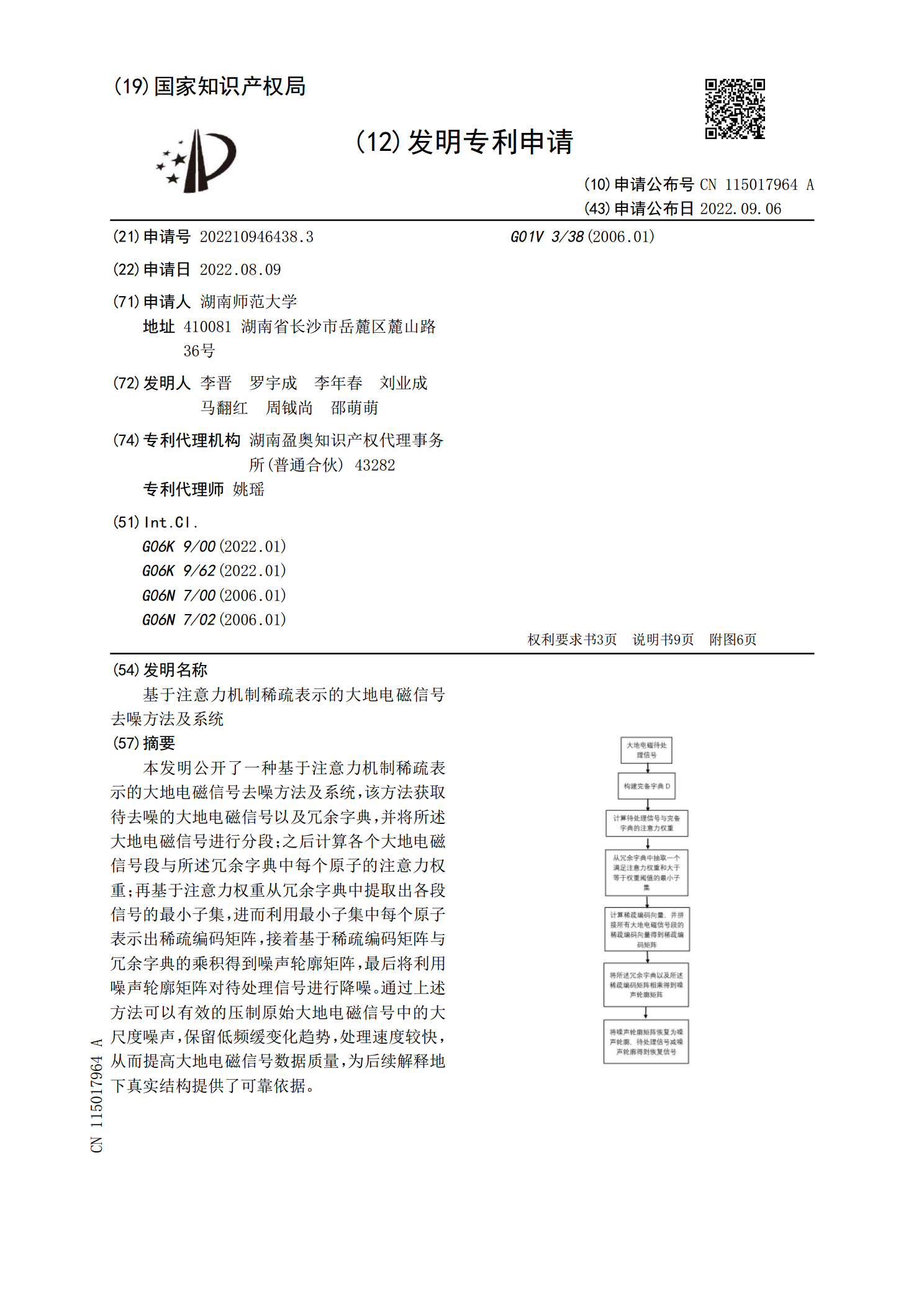

基于注意力机制稀疏表示的大地电磁信号去噪方法及系统.pdf

本发明公开了一种基于注意力机制稀疏表示的大地电磁信号去噪方法及系统,该方法获取待去噪的大地电磁信号以及冗余字典,并将所述大地电磁信号进行分段;之后计算各个大地电磁信号段与所述冗余字典中每个原子的注意力权重;再基于注意力权重从冗余字典中提取出各段信号的最小子集,进而利用最小子集中每个原子表示出稀疏编码矩阵,接着基于稀疏编码矩阵与冗余字典的乘积得到噪声轮廓矩阵,最后将利用噪声轮廓矩阵对待处理信号进行降噪。通过上述方法可以有效的压制原始大地电磁信号中的大尺度噪声,保留低频缓变化趋势,处理速度较快,从而提高大地电

基于双注意力机制的图像描述生成方法研究.docx

基于双注意力机制的图像描述生成方法研究基于双注意力机制的图像描述生成方法研究摘要:图像描述生成是计算机视觉和自然语言处理领域中的一个重要任务。本文研究基于双注意力机制的图像描述生成方法,通过引入空间注意力和语义注意力,提高了模型对图像特征的感知能力,从而生成更准确和详细的图像描述。实验结果表明,该方法在各项评测指标上都取得了显著的提升。1.引言随着深度学习技术的发展,图像描述生成成为了一个备受关注的领域。图像描述生成任务要求模型从输入图像中生成与图像内容相对应的自然语言描述。图像描述生成对于提高图像与语言