基于预训练模型和混合神经网络的医疗实体关系抽取.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于预训练模型和混合神经网络的医疗实体关系抽取.docx

基于预训练模型和混合神经网络的医疗实体关系抽取基于预训练模型和混合神经网络的医疗实体关系抽取摘要:医疗实体关系抽取是医疗信息处理领域的一个重要任务,可以帮助医疗机构和研究人员快速准确地获取医疗数据中的关系信息。本文提出了一种基于预训练模型和混合神经网络的医疗实体关系抽取方法。该方法首先利用预训练模型来学习医疗文本的语义表示,然后将这些表示作为输入,通过混合神经网络来进行关系分类。实验结果表明,所提出的方法在医疗实体关系抽取任务上取得了优异的性能,并且相比于其他方法具有更高的准确率和召回率。1.引言在医疗信

基于联合神经网络模型的中文医疗实体分类与关系抽取.docx

基于联合神经网络模型的中文医疗实体分类与关系抽取标题:基于联合神经网络模型的中文医疗实体分类与关系抽取摘要:中文医疗信息处理是自然语言处理领域的重要研究方向之一。本论文基于联合神经网络模型,针对中文医疗文本进行实体分类与关系抽取。首先,介绍了医疗信息处理的背景和意义,以及目前主流的实体分类与关系抽取方法。然后,详细介绍了联合神经网络模型及其在实体分类和关系抽取中的应用。接着,设计了实验流程并分别进行了实体分类和关系抽取的实验,最终得到了效果较好的实验结果。实验结果表明,基于联合神经网络模型的中文医疗实体分

基于预训练模型与规则结合的武器装备实体关系抽取方法.pdf

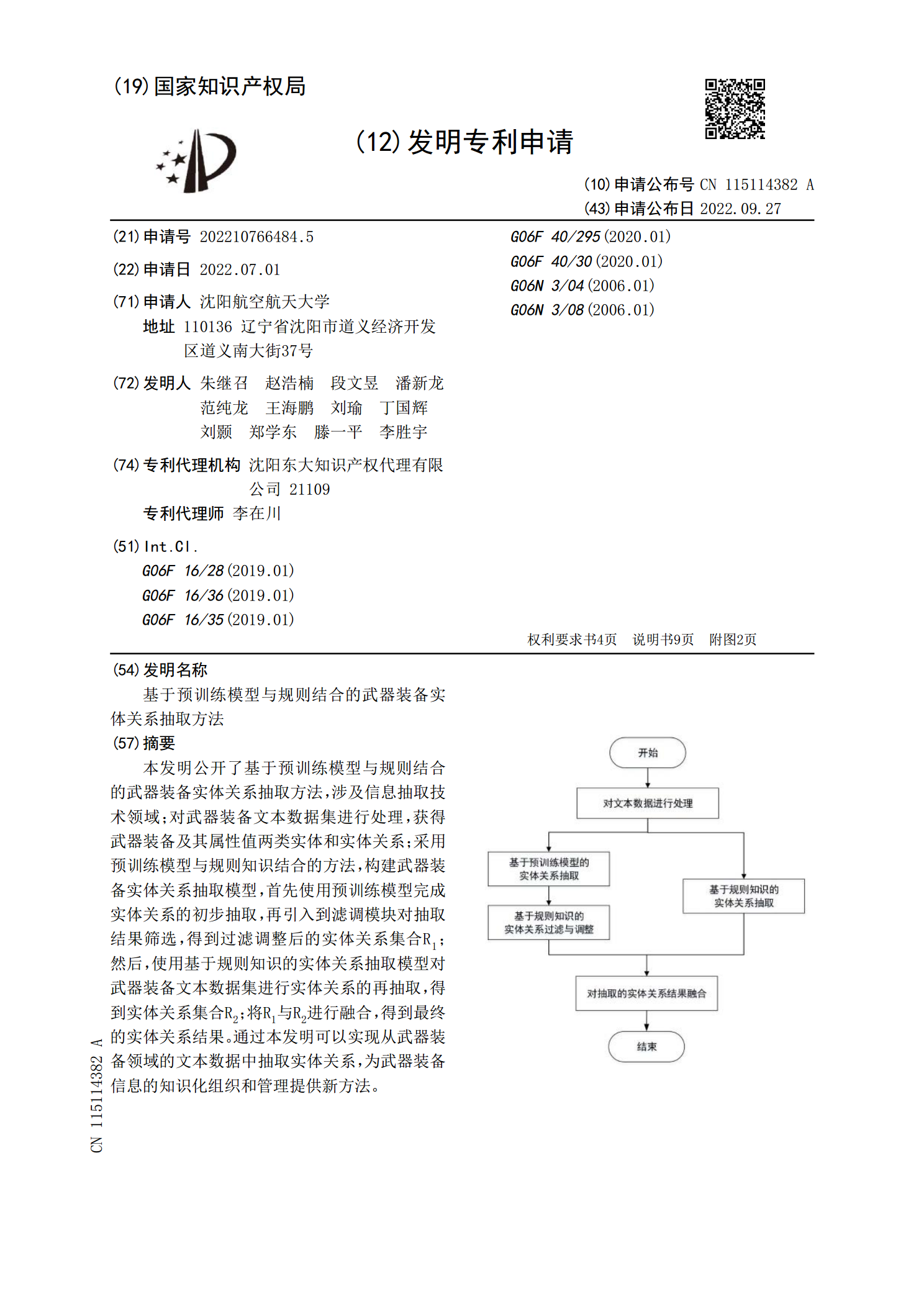

本发明公开了基于预训练模型与规则结合的武器装备实体关系抽取方法,涉及信息抽取技术领域;对武器装备文本数据集进行处理,获得武器装备及其属性值两类实体和实体关系;采用预训练模型与规则知识结合的方法,构建武器装备实体关系抽取模型,首先使用预训练模型完成实体关系的初步抽取,再引入到滤调模块对抽取结果筛选,得到过滤调整后的实体关系集合R<base:Sub>1</base:Sub>;然后,使用基于规则知识的实体关系抽取模型对武器装备文本数据集进行实体关系的再抽取,得到实体关系集合R<base:Sub>2</base:

基于预训练模型与规则结合的武器装备实体关系抽取方法.pdf

本发明公开了基于预训练模型与规则结合的武器装备实体关系抽取方法,涉及信息抽取技术领域;对武器装备文本数据集进行处理,获得武器装备及其属性值两类实体和实体关系;采用预训练模型与规则知识结合的方法,构建武器装备实体关系抽取模型,首先使用预训练模型完成实体关系的初步抽取,再引入到滤调模块对抽取结果筛选,得到过滤调整后的实体关系集合R<base:Sub>1</base:Sub>;然后,使用基于规则知识的实体关系抽取模型对武器装备文本数据集进行实体关系的再抽取,得到实体关系集合R<base:Sub>2</base:

基于神经网络的药物实体与关系联合抽取.docx

基于神经网络的药物实体与关系联合抽取基于神经网络的药物实体与关系联合抽取摘要:药物实体与关系的抽取在生物医药领域具有重要的应用价值。本文基于神经网络的方法,提出了一种药物实体与关系的联合抽取模型。首先,通过预训练的词向量模型,将生物医学文本转化为连续向量表示。然后,利用双向长短时记忆网络(BiLSTM)对文本进行特征提取。最后,通过条件随机场(CRF)模型对药物实体与关系进行联合抽取。实验结果表明,我们提出的方法在药物实体与关系的抽取任务上具有较高的准确性和鲁棒性。1.引言药物实体与关系的抽取是生物医药领