基于运动检测与KCF算法的目标跟踪方法.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于运动检测与KCF算法的目标跟踪方法.docx

基于运动检测与KCF算法的目标跟踪方法基于运动检测与KCF算法的目标跟踪方法摘要:目标跟踪是计算机视觉领域中一项重要研究任务,广泛应用于视频监控、无人机、自动驾驶等领域。本文基于运动检测与KCF算法提出了一种有效的目标跟踪方法。首先,通过运动检测算法识别视频中的感兴趣目标,然后利用KCF算法对目标进行跟踪。实验结果表明,该方法能够准确、实时地跟踪目标。关键词:目标跟踪,运动检测,KCF算法1.引言随着计算机视觉和机器学习技术的不断发展,目标跟踪技术成为了计算机视觉领域中的一个热门研究方向。目标跟踪的任务是

基于Retinaface与KCF人脸目标检测与跟踪算法研究.pptx

汇报人:/目录0102人脸目标检测算法的重要性人脸目标检测算法的分类Retinaface算法原理简介KCF算法原理简介03Retinaface算法流程特征提取与分类器训练人脸边界框的预测与调整实验结果与分析04KCF算法流程特征提取与跟踪器设计目标跟踪过程中的模型更新实验结果与分析05联合实现方案概述数据预处理与特征共享检测与跟踪结果的融合策略实验结果与分析06Retinaface与KCF算法的局限性分析算法优化方向探讨在人脸识别系统中的应用前景在智能监控等领域的潜在应用价值汇报人:

基于KCF相似度的TLD目标跟踪算法.docx

基于KCF相似度的TLD目标跟踪算法基于KCF相似度的TLD目标跟踪算法摘要:目标跟踪是计算机视觉和图像处理领域的一个重要研究方向。TLD(Tracking-Learning-Detection)是一种集合了跟踪、学习和检测的目标跟踪算法,它结合了传统目标跟踪算法和机器学习技术,能够实现对目标的快速、准确跟踪。本文针对TLD算法中的相似度计算问题,提出了基于KCF(KernelizedCorrelationFilter)相似度的TLD目标跟踪算法。该算法能够有效提高目标跟踪的准确性和稳定性,具有良好的实际

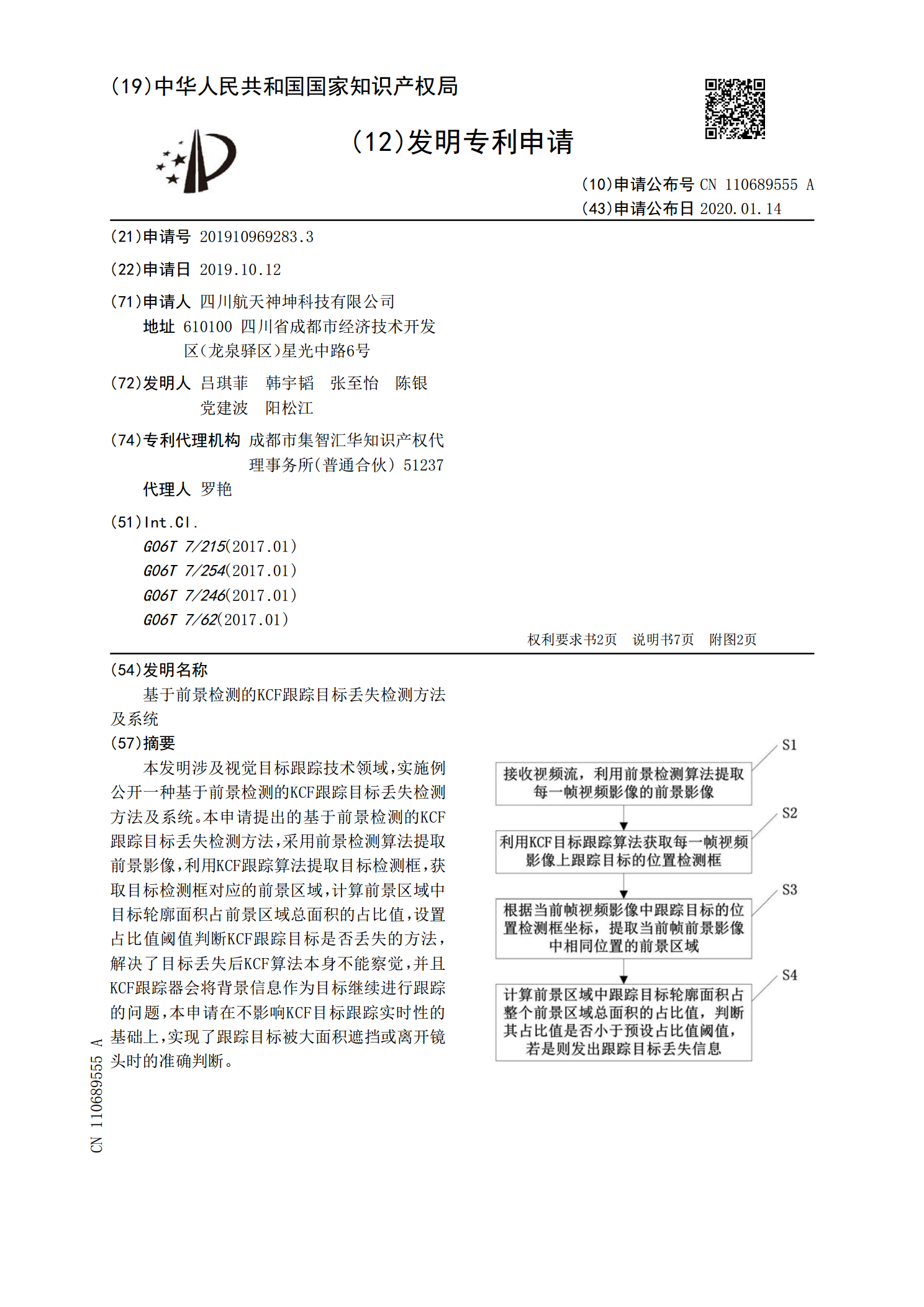

基于前景检测的KCF跟踪目标丢失检测方法及系统.pdf

本发明涉及视觉目标跟踪技术领域,实施例公开一种基于前景检测的KCF跟踪目标丢失检测方法及系统。本申请提出的基于前景检测的KCF跟踪目标丢失检测方法,采用前景检测算法提取前景影像,利用KCF跟踪算法提取目标检测框,获取目标检测框对应的前景区域,计算前景区域中目标轮廓面积占前景区域总面积的占比值,设置占比值阈值判断KCF跟踪目标是否丢失的方法,解决了目标丢失后KCF算法本身不能察觉,并且KCF跟踪器会将背景信息作为目标继续进行跟踪的问题,本申请在不影响KCF目标跟踪实时性的基础上,实现了跟踪目标被大面积遮挡或

基于KCF和SIFT特征的抗遮挡目标跟踪算法.docx

基于KCF和SIFT特征的抗遮挡目标跟踪算法基于KCF和SIFT特征的抗遮挡目标跟踪算法摘要:目标跟踪是计算机视觉领域中的一个重要研究方向,它在许多应用中具有广泛的应用价值。然而,在实际应用中,目标跟踪算法往往面临着许多挑战,其中之一就是目标被遮挡时的准确跟踪问题。本文提出了一种基于KCF(KernelizedCorrelationFilter)和SIFT(Scale-InvariantFeatureTransform)特征的抗遮挡目标跟踪算法,通过结合KCF的快速计算和SIFT的旋转不变性,提高了算法在