基于序列到序列的中文短文本省略补全.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于序列到序列的中文短文本省略补全.docx

基于序列到序列的中文短文本省略补全序列到序列(Sequence-to-Sequence,简称Seq2Seq)模型是一种深度神经网络代表性的模型,常用于处理序列类型的数据,能够对输入序列进行编码之后生成对应的输出序列。Seq2Seq模型的应用场景非常广泛,其中之一就是中文短文本省略补全。中文短文本省略补全是指对于一些短文本,由于篇幅有限或者为了表达更为简洁,可能会省略掉一些关键词或者信息。这个时候,Seq2Seq模型可以帮助我们对这些短文本进行补全。在实际应用中,中文短文本省略补全被广泛应用于搜索引擎、自然

基于序列到序列框架的自动文摘技术研究.docx

基于序列到序列框架的自动文摘技术研究自动文摘技术是自然语言处理领域的一个重要研究方向,其目的是从大量的文本中提取出简洁准确的摘要。序列到序列(sequence-to-sequence,Seq2Seq)框架是一种常用的自动文摘技术方法。本论文将对基于Seq2Seq框架的自动文摘技术进行研究,并分析其优势和挑战。第一部分:引言在信息爆炸的时代,人们面临着大量的信息获取困难。自动文摘技术可以帮助人们从大量文本中迅速获取摘要信息,提高信息获取效率。随着机器学习和深度学习技术的发展,基于Seq2Seq框架的自动文摘

基于全卷积网络的序列到序列的睡眠障碍检测方法.pdf

本发明公开了一种基于全卷积网络的序列到序列的睡眠障碍检测方法,该方法获取需要检测睡眠障碍的数据集,对数据集进行预处理,构建包括全卷积网络和长短时记忆网络的睡眠唤醒检测网络模型并进行模型训练,利用训练后的睡眠唤醒检测网络模型进行睡眠障碍检测。本发明通过对多模态生物信号进行统一预处理,减少了工作量,提升了处理效率,并且保留了数据的上下文信息,提升了检测准确率;本发明直接从多种原始生物信号中给出睡眠唤醒指数,实现了睡眠障碍检测的自动化,并且通过序列到序列的检测方式,保留了数据在时序上的关联性,取得了更好的检测结

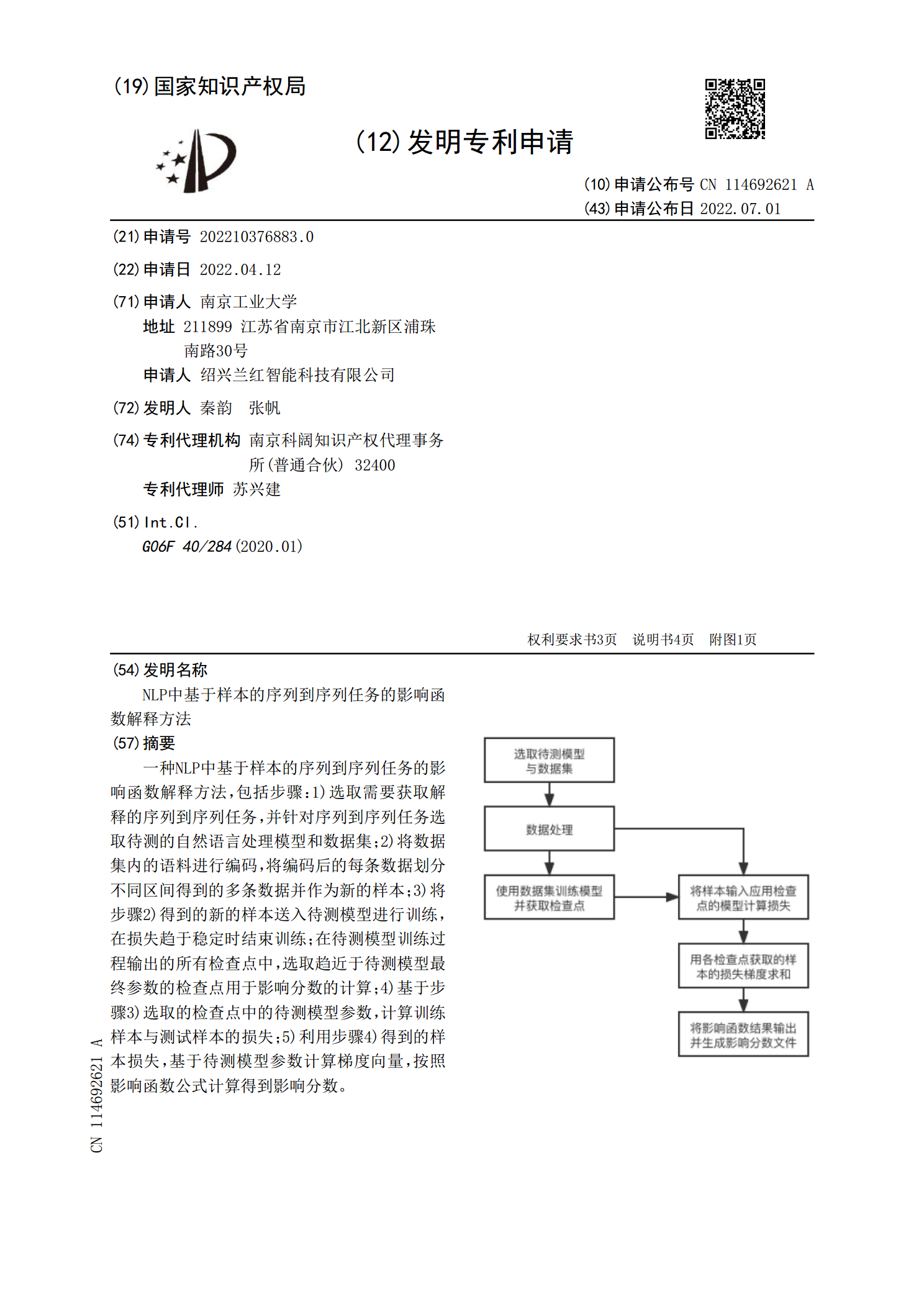

NLP中基于样本的序列到序列任务的影响函数解释方法.pdf

一种NLP中基于样本的序列到序列任务的影响函数解释方法,包括步骤:1)选取需要获取解释的序列到序列任务,并针对序列到序列任务选取待测的自然语言处理模型和数据集;2)将数据集内的语料进行编码,将编码后的每条数据划分不同区间得到的多条数据并作为新的样本;3)将步骤2)得到的新的样本送入待测模型进行训练,在损失趋于稳定时结束训练;在待测模型训练过程输出的所有检查点中,选取趋近于待测模型最终参数的检查点用于影响分数的计算;4)基于步骤3)选取的检查点中的待测模型参数,计算训练样本与测试样本的损失;5)利用步骤4)

基于多尺度与改进注意力机制的序列到序列模型.docx

基于多尺度与改进注意力机制的序列到序列模型基于多尺度与改进注意力机制的序列到序列模型摘要:序列到序列(Sequence-to-Sequence,Seq2Seq)模型是一种重要的深度学习模型,广泛应用于机器翻译、文本摘要、语音识别等自然语言处理任务中。然而,传统的Seq2Seq模型存在着信息丢失和困难的建模长依赖关系的问题。为了解决这些问题,本论文提出了一种基于多尺度与改进注意力机制的Seq2Seq模型。首先,我们引入了多尺度机制,通过不同尺度的信息捕获和多尺度的特征融合来更好地利用输入序列的信息。其次,我