基于改进的Graph Cut算法的羊体图像分割.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于改进的Graph Cut算法的羊体图像分割.docx

基于改进的GraphCut算法的羊体图像分割基于改进的GraphCut算法的羊体图像分割摘要:图像分割是计算机视觉领域的关键任务之一,对于羊体图像分割的需求日益增长。GraphCut算法是图像分割领域中常用的方法之一,但在处理羊体图像时存在一些问题。为了解决这些问题,本论文提出了一种改进的GraphCut算法,通过增加特征提取和能量函数设计的步骤,使得算法在羊体图像分割上具有更好的性能。通过在多个羊体图像数据集上的实验验证,结果表明改进的算法在准确性和效率方面都有提升。1.引言图像分割是计算机视觉领域的重

基于多尺度的改进Graph cut算法.docx

基于多尺度的改进Graphcut算法基于多尺度的改进Graphcut算法Graphcut是一种有效的图像分割算法,它把图像分割问题转化为在图中进行最小割的问题,通过计算图中两个子图之间的最小割来获得最优分割。Graphcut算法在各种图像分割任务中都具有广泛的应用,例如分割前景和背景、医学图像分割等。但是,传统的Graphcut算法存在一些问题,例如分割过程中不能解决模糊边界问题以及对图像的分辨率要求高,等。为了解决这些问题,本文提出一种基于多尺度的改进Graphcut算法。首先,我们利用高斯金字塔对输入

基于统计形状模型的医学图像Graph Cut分割方法.pdf

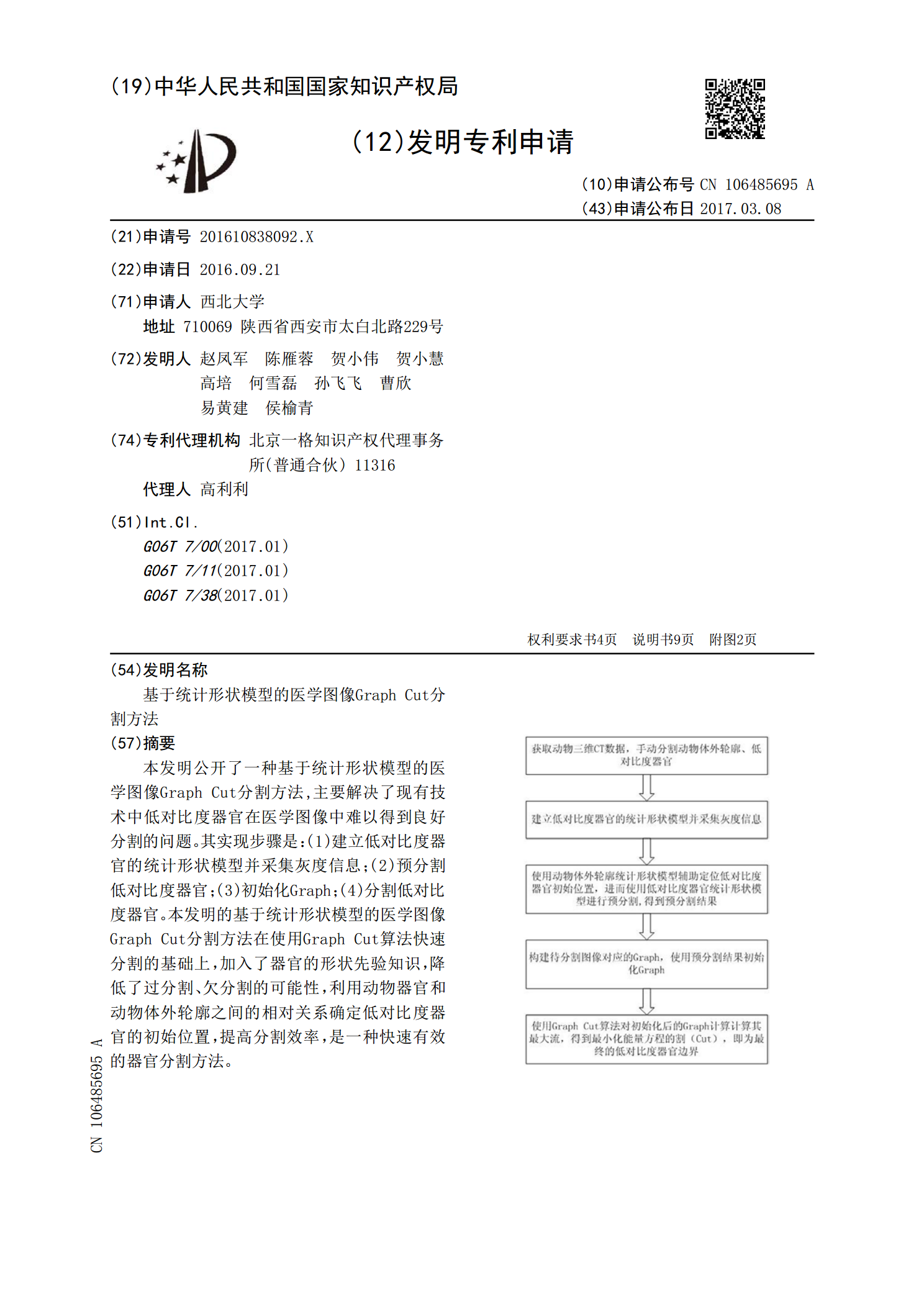

本发明公开了一种基于统计形状模型的医学图像GraphCut分割方法,主要解决了现有技术中低对比度器官在医学图像中难以得到良好分割的问题。其实现步骤是:(1)建立低对比度器官的统计形状模型并采集灰度信息;(2)预分割低对比度器官;(3)初始化Graph;(4)分割低对比度器官。本发明的基于统计形状模型的医学图像GraphCut分割方法在使用GraphCut算法快速分割的基础上,加入了器官的形状先验知识,降低了过分割、欠分割的可能性,利用动物器官和动物体外轮廓之间的相对关系确定低对比度器官的初始位置,提

基于改进Graph Cuts的印刷电路板CT图像分割算法.docx

基于改进GraphCuts的印刷电路板CT图像分割算法Introduction印刷电路板(PrintedCircuitBoard,PCB)是电子工程中最常用的基础组件之一,是一种用于连通电子元件和器件电连接的支架。在印刷电路板制造过程中,CT(ComputedTomography)成像技术可以为PCB的检测提供可靠的手段。然而,由于PCB的复杂性和噪音的测量干扰,提高CT图像的准确性和稳定性是一个挑战。本文介绍了一种基于改进GraphCuts的PCBCT图像分割算法,以提高整个PCB制造过程的准确性和可靠

基于超像素的Graph-Based图像分割算法.docx

基于超像素的Graph-Based图像分割算法基于超像素的Graph-Based图像分割算法摘要:图像分割是计算机视觉领域的重要研究方向之一,对于图像理解、物体识别以及图像处理等应用具有重要意义。然而,由于图像中的像素过多和复杂的纹理结构,传统的图像分割方法往往存在着计算复杂度高、易受噪声和纹理影响等问题。为了解决这些问题,本文提出了基于超像素的Graph-Based图像分割算法。该算法将图像分割问题转化为超像素分割问题,利用超像素的局部特征和全局上下文信息来进行图像分割,并且结合了图论中的图模型,通过最