基于深度学习的模糊图像超分辨率重建方法.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于深度学习的模糊图像超分辨率重建方法.docx

基于深度学习的模糊图像超分辨率重建方法摘要超分辨率重建是计算机视觉中的一个重要任务,旨在通过低分辨率图像恢复高分辨率细节。随着深度学习的快速发展,利用神经网络进行超分辨率重建已经取得了显著的成果。然而,在处理模糊图像时,传统的超分辨率方法仍然存在一些挑战。因此,本文提出了基于深度学习的模糊图像超分辨率重建方法,旨在通过结合深度学习和模糊图像处理技术,提高模糊图像超分辨率重建的效果。引言在实际应用中,由于传感器限制、图像采集设备等因素的影响,获取的图像可能会出现模糊现象。这对于一些需要准确细节信息的任务而言

基于深度学习的超声图像超分辨率重建方法.pdf

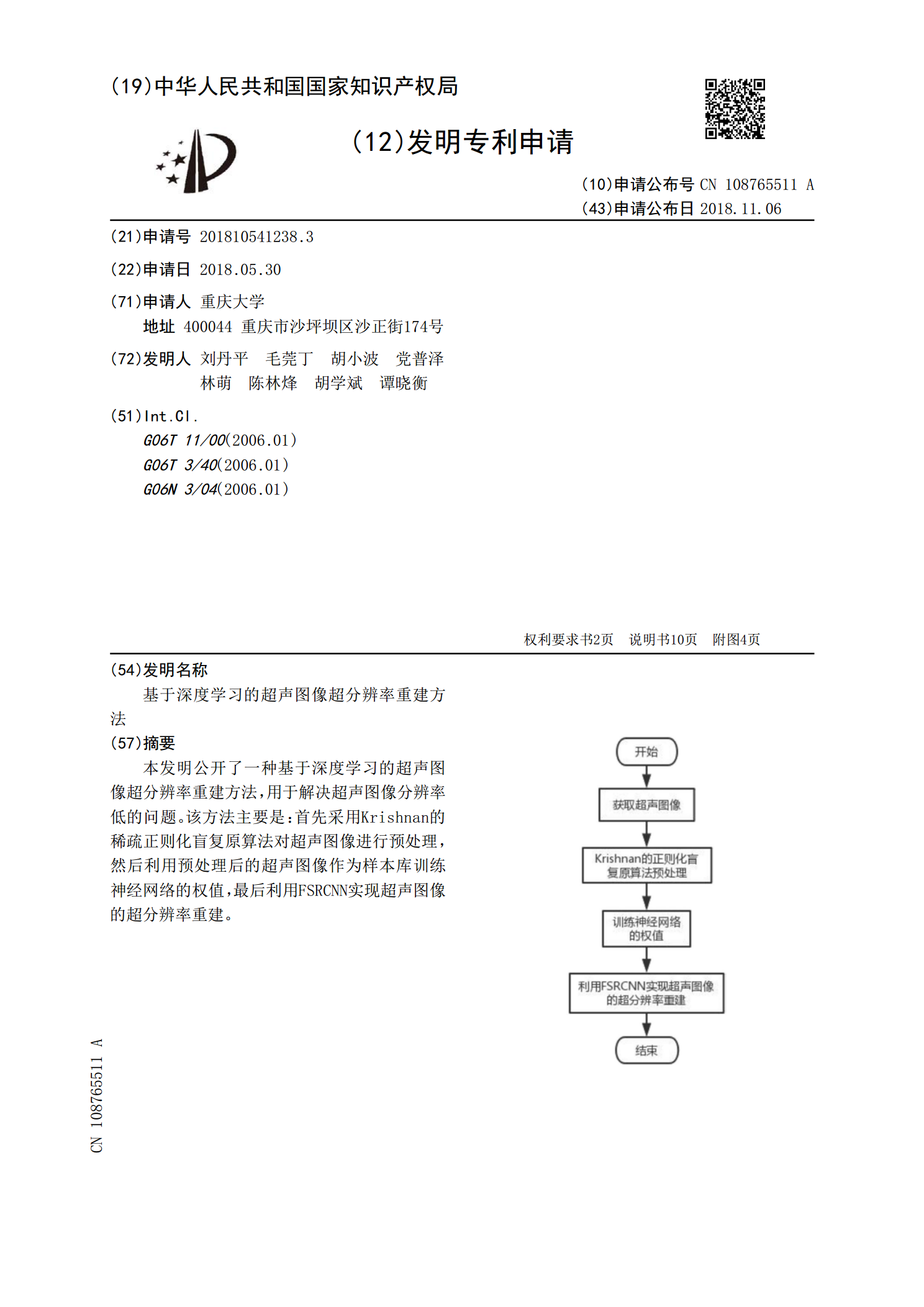

本发明公开了一种基于深度学习的超声图像超分辨率重建方法,用于解决超声图像分辨率低的问题。该方法主要是:首先采用Krishnan的稀疏正则化盲复原算法对超声图像进行预处理,然后利用预处理后的超声图像作为样本库训练神经网络的权值,最后利用FSRCNN实现超声图像的超分辨率重建。

基于深度学习的图像超分辨率重建.docx

基于深度学习的图像超分辨率重建基于深度学习的图像超分辨率重建摘要随着数字图像的广泛应用,人们对于图像质量和细节的要求越来越高。然而,由于硬件限制或者图像采集过程中的噪声,往往会导致图像存在低分辨率的问题。为了解决这个问题,图像超分辨率重建技术被提出。本文提出了一种基于深度学习的图像超分辨率重建算法,并对其进行了详细的实验和分析。实验结果表明,所提出的算法在提高图像质量和细节方面具有显著的优势。1.引言随着科技的不断发展,图像超分辨率重建技术被广泛应用在图像处理领域。图像超分辨率重建旨在从一个或多个低分辨率

基于深度学习的单幅图像超分辨率重建方法研究.docx

基于深度学习的单幅图像超分辨率重建方法研究基于深度学习的单幅图像超分辨率重建方法研究摘要:随着数字图像处理技术的不断发展,超分辨率重建逐渐成为图像处理领域的研究热点之一。单幅图像超分辨率重建是利用深度学习算法来提高图像的分辨率,从而提高图像的质量。本文主要研究了基于深度学习的单幅图像超分辨率重建方法,并对其进行了性能评估和分析。1.引言超分辨率重建是指从低分辨率图像中恢复出高分辨率图像的过程。在实际应用中,由于种种原因,采集的图像常常会受到分辨率限制,超分辨率重建技术能够有效地提高图像的质量和细节。传统的

基于深度学习的水下图像超分辨率重建方法.docx

基于深度学习的水下图像超分辨率重建方法摘要水下图像在获取过程中会受到多种因素的影响,导致其分辨率低、图像质量差。为此,本文提出了一种基于深度学习的水下图像超分辨率重建方法。该方法通过构建卷积神经网络模型,从高分辨率的水下图像和低分辨率的水下图像之间建立联系,实现了对低分辨率水下图像的重建和超分辨率。本文提出的方法在一定程度上改善了水下图像的质量,为水下图像的处理提供了一种新的思路。关键词:深度学习,水下图像,超分辨率重建1.引言水下图像获取在现代海洋科学、海洋资源开发和生态环保等领域有着广泛的应用。然而,