基于强化学习的可回收运载火箭着陆制导.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于强化学习的可回收运载火箭着陆制导.docx

基于强化学习的可回收运载火箭着陆制导摘要随着人类航空航天事业的发展,可回收运载火箭成为了航空航天工业的重点研究领域之一。本文针对可回收运载火箭着陆制导问题进行研究,提出了一种基于强化学习的着陆制导解决方案。本文首先介绍了可回收运载火箭着陆的背景和意义,然后阐述了本文提出的强化学习着陆制导方法的原理及实现细节,最后通过仿真实验对该方法进行验证,结果表明该方法能够实现可回收运载火箭的精准着陆。关键词:可回收运载火箭,着陆制导,强化学习,精准着陆引言可回收运载火箭是指具有重复使用能力的运载火箭,其在完成任务后能

基于最优制导的运载火箭姿态控制方法研究.docx

基于最优制导的运载火箭姿态控制方法研究摘要:运载火箭在飞行过程中需要进行姿态控制,以保证飞行稳定和任务完成。而最优控制理论已经成为了现代控制领域中的重要分支,因此,基于最优制导的运载火箭姿态控制方法也备受研究者的关注。本文将从理论和应用两个方面介绍这一方法。关键词:最优制导,运载火箭,姿态控制一、引言运载火箭是宇航科技中重要的一环,其需要在飞行过程中精确地控制姿态,以保证飞行稳定和任务完成。在传统的火箭姿态控制方法中,常用的控制器包括PID控制器、模型预测控制器等基础控制器。虽然这些控制器具有较高的稳定性

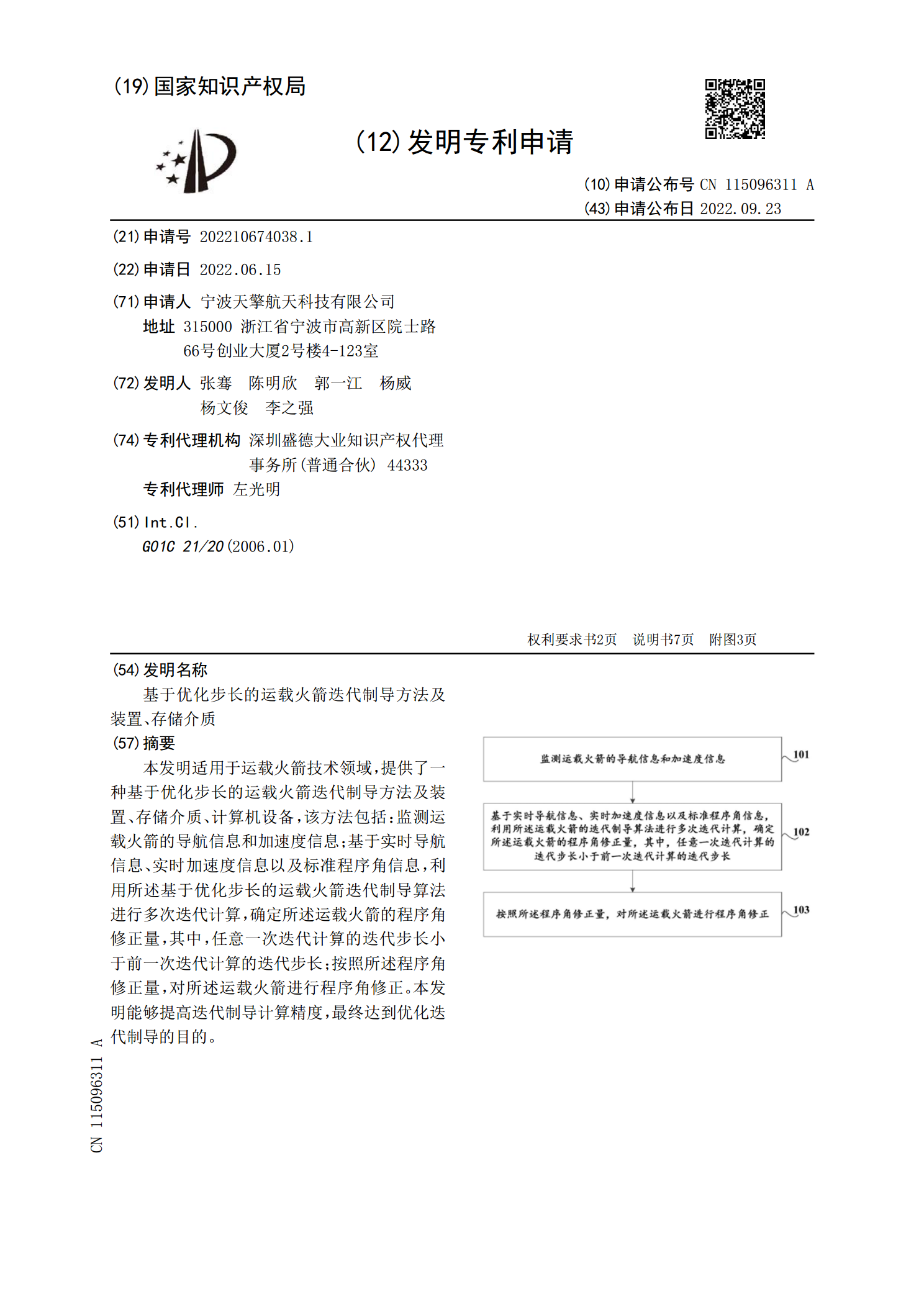

基于优化步长的运载火箭迭代制导方法及装置、存储介质.pdf

本发明适用于运载火箭技术领域,提供了一种基于优化步长的运载火箭迭代制导方法及装置、存储介质、计算机设备,该方法包括:监测运载火箭的导航信息和加速度信息;基于实时导航信息、实时加速度信息以及标准程序角信息,利用所述基于优化步长的运载火箭迭代制导算法进行多次迭代计算,确定所述运载火箭的程序角修正量,其中,任意一次迭代计算的迭代步长小于前一次迭代计算的迭代步长;按照所述程序角修正量,对所述运载火箭进行程序角修正。本发明能够提高迭代制导计算精度,最终达到优化迭代制导的目的。

基于摄动制导的运载火箭一子级落点控制.docx

基于摄动制导的运载火箭一子级落点控制基于摄动制导的运载火箭一子级落点控制摘要:运载火箭是航天器发射的重要工具,而其落点的精确控制则是保证航天器能够顺利进入预定轨道的关键。本论文基于摄动制导的理论和方法,研究了运载火箭一子级的落点控制问题。首先,对运载火箭的发射过程进行建模,确定了影响落点的各种摄动源,并通过数值仿真的方法进行分析。然后,设计了一种基于摄动制导的控制策略,以实现对运载火箭一子级的落点进行精确控制。最后,通过实验验证了本文提出的控制策略的有效性和可行性。关键词:摄动制导、运载火箭、一子级、落点

基于偏置比例导引与凸优化的火箭垂直着陆制导.docx

基于偏置比例导引与凸优化的火箭垂直着陆制导近年来,随着航空航天技术的快速发展,火箭垂直着陆技术成为了航空航天领域研究的热点之一。火箭垂直着陆技术的研究不仅可以为人类探索宇宙提供更加高效、安全的方法,还可以为未来商业航天产业的发展提供强有力的支撑。火箭垂直着陆制导作为控制火箭进行安全着陆的核心技术之一,为实现火箭垂直着陆提供了重要的保障。本文将基于偏置比例导引与凸优化的方法,探讨火箭垂直着陆制导技术的研究。首先,我们来了解一下偏置比例导引。偏置比例导引是一种经典的导引方式,它基于贯穿导弹的轴线旋转角速度,将