基于深度学习的场景识别方法综述.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于深度学习的场景识别方法综述.docx

基于深度学习的场景识别方法综述基于深度学习的场景识别方法综述摘要:随着深度学习的快速发展,场景识别已经逐渐成为计算机视觉领域的一个重要任务。本文对基于深度学习的场景识别方法进行了综述,并对其在实际应用中的表现进行了评估。我们首先简要介绍了场景识别的背景和意义,然后介绍了深度学习的基本原理,以及在场景识别中的应用。接着,我们详细讨论了几种常用的基于深度学习的场景识别方法,并分析了它们的优缺点。最后,我们总结了当前的研究现状,并展望了未来的发展方向。1.引言场景识别是指通过计算机视觉技术,将图像或视频中的场景

基于深度学习的场景文字检测综述.docx

基于深度学习的场景文字检测综述基于深度学习的场景文字检测综述摘要:场景文字检测(SceneTextDetection)是计算机视觉领域中一个重要的任务,它旨在从自然场景中准确地检测出显著的文字区域。随着深度学习的发展,基于深度学习的场景文字检测方法在精度和性能方面取得了显著的突破。本综述对基于深度学习的场景文字检测的方法进行了综述和归纳,并对其中的关键技术进行了详细的分析和比较。本文以卷积神经网络(ConvolutionalNeuralNetwork,CNN)为基础,对现有的场景文字检测方法进行了全面地调

一种基于深度学习的场景识别方法.pdf

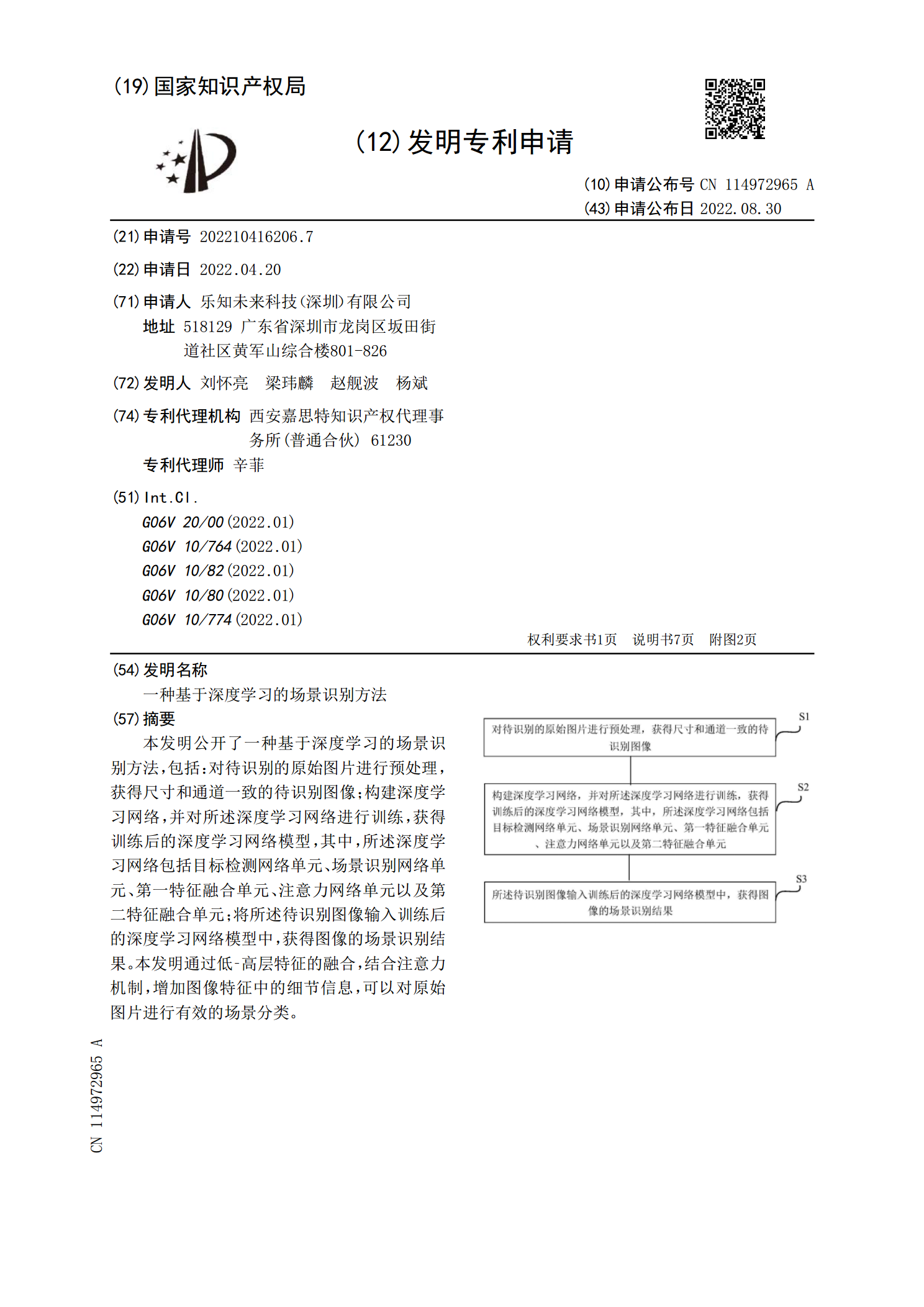

本发明公开了一种基于深度学习的场景识别方法,包括:对待识别的原始图片进行预处理,获得尺寸和通道一致的待识别图像;构建深度学习网络,并对所述深度学习网络进行训练,获得训练后的深度学习网络模型,其中,所述深度学习网络包括目标检测网络单元、场景识别网络单元、第一特征融合单元、注意力网络单元以及第二特征融合单元;将所述待识别图像输入训练后的深度学习网络模型中,获得图像的场景识别结果。本发明通过低‑高层特征的融合,结合注意力机制,增加图像特征中的细节信息,可以对原始图片进行有效的场景分类。

基于深度学习的场景分割算法研究综述.docx

基于深度学习的场景分割算法研究综述一、概述1.场景分割技术的定义及其在计算机视觉领域的重要性场景分割技术,作为计算机视觉领域的一项关键技术,旨在将输入的图像划分为多个具有特定语义信息的区域或对象。它旨在为每个像素分配一个预定义的类别标签,从而实现对图像内容的精细理解。这种技术不仅要求准确识别图像中的不同对象,还需精细地界定它们之间的边界,以便为后续的应用提供准确、详细的信息。在计算机视觉领域,场景分割技术的重要性不言而喻。它是图像理解和分析的基础。通过对图像进行像素级的类别划分,我们可以获得关于图像内容的

基于深度学习的场景文字检测与识别综述.docx

基于深度学习的场景文字检测与识别综述标题:基于深度学习的场景文字检测与识别综述摘要:场景文字检测与识别是计算机视觉领域的热门研究方向,其在实际应用中起着重要作用。本综述旨在系统地总结基于深度学习的场景文字检测与识别方法,并对其现有的技术和未来的研究方向进行探讨。首先介绍了场景文字检测的背景和意义,然后对深度学习在场景文字检测与识别中的应用进行详细阐述,包括基于卷积神经网络(CNN)的文字检测和识别方法、基于循环神经网络(RNN)的端到端文字识别方法以及基于注意力机制的文字识别方法。接着,讨论了当前存在的挑