基于特征重建的知识蒸馏方法.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于特征重建的知识蒸馏方法.docx

基于特征重建的知识蒸馏方法基于特征重建的知识蒸馏方法摘要知识蒸馏是一种将深度神经网络中的知识转移到另一个网络中的方法,以提高模型的泛化性能。本文提出了一种基于特征重建的知识蒸馏方法,通过重建网络的特征来捕捉原始网络的知识,并通过一定的损失函数进行蒸馏。实验结果表明,该方法在不同的数据集上都能获得较好的性能提升。关键词:知识蒸馏;特征重建;深度神经网络;损失函数一、引言近年来,深度神经网络在计算机视觉、自然语言处理等领域取得了显著的成果。然而,深度神经网络过于复杂,参数众多,很容易在训练过程中产生过拟合的问

基于残差蒸馏网络的图像超分辨重建方法.pdf

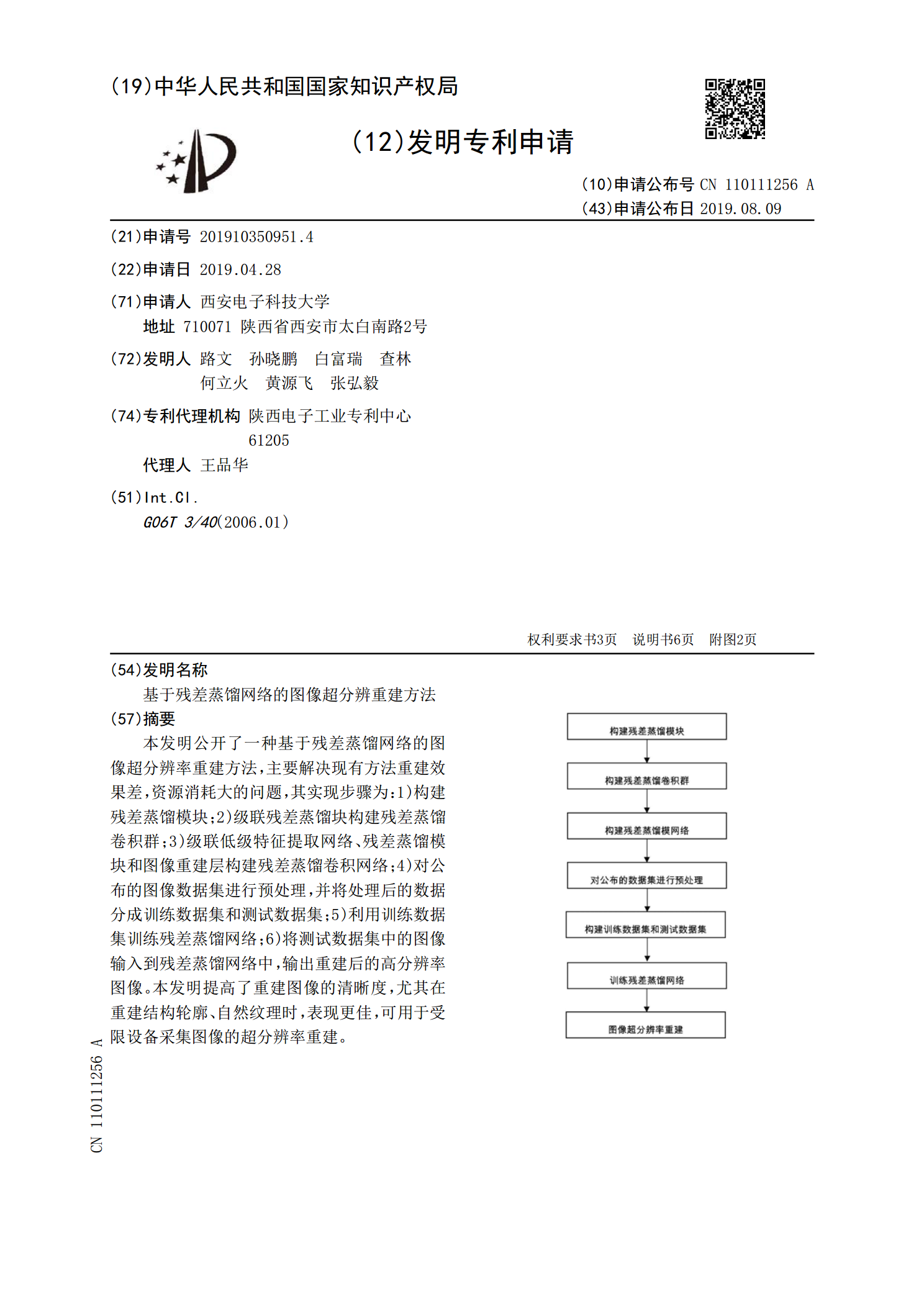

本发明公开了一种基于残差蒸馏网络的图像超分辨率重建方法,主要解决现有方法重建效果差,资源消耗大的问题,其实现步骤为:1)构建残差蒸馏模块;2)级联残差蒸馏块构建残差蒸馏卷积群;3)级联低级特征提取网络、残差蒸馏模块和图像重建层构建残差蒸馏卷积网络;4)对公布的图像数据集进行预处理,并将处理后的数据分成训练数据集和测试数据集;5)利用训练数据集训练残差蒸馏网络;6)将测试数据集中的图像输入到残差蒸馏网络中,输出重建后的高分辨率图像。本发明提高了重建图像的清晰度,尤其在重建结构轮廓、自然纹理时,表现更佳,可用

一种基于解耦特征和对抗特征的知识蒸馏方法.pdf

本发明提供一种基于解耦特征和对抗特征的知识蒸馏方法,属于目标检测技术领域,包括以下步骤:首先构建教师网络和学生网络,然后先对教师网络进行训练,使其达到设定的要求;再利用训练好的教师网络,结合解耦特征模块和对抗特征模块,使学生网络进行第一阶段学习,使学生网络的骨干网络达到设定要求;然后再利用教师网络和候选框特征学习模块对学生网络的区域建议网络进行第二阶段学习;反复迭代进行两阶段学习,使学生网络对目标的检测能力达到设定要求;本发明提供的方法使得学生网络实现对缺陷的高速检测,同时还保证检测的高精度。

基于几何特征约束的模型重建方法.doc

基于几何特征约束的模型重建方法姓名:秦海学号:140308020105专业:机械制造及其自动化摘要:由于大多数机械零件产品都是按一定特征设计制造的,同时特征之间具有确定的几何约束关系,此,在产品的模型重建过程中一个重要的目标即是还原这些特征以及它们之间的约束。具体方法是首先进行特征识别将测量数据分块,然后基于特征约束建立优化数学模型,在建模过程中寻求满足特征参数目标函数下的约束最优解,使重建模型更为准确、接近原型。关键词:反求工程基于特征几何约束模型重建Abstract:Anapproachispropo

基于特征光斑的脚部模型重建方法.pdf

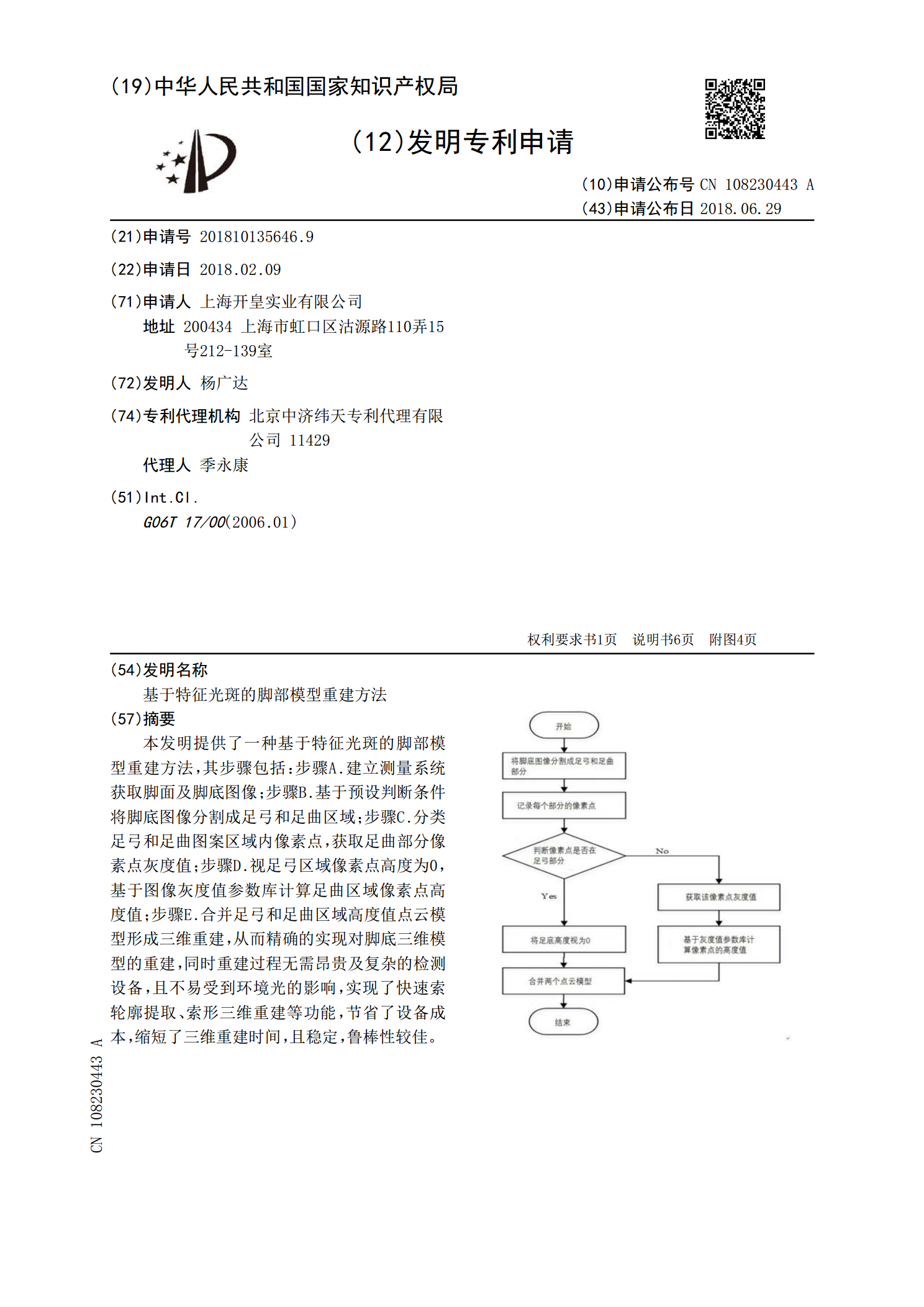

本发明提供了一种基于特征光斑的脚部模型重建方法,其步骤包括:步骤A.建立测量系统获取脚面及脚底图像;步骤B.基于预设判断条件将脚底图像分割成足弓和足曲区域;步骤C.分类足弓和足曲图案区域内像素点,获取足曲部分像素点灰度值;步骤D.视足弓区域像素点高度为0,基于图像灰度值参数库计算足曲区域像素点高度值;步骤E.合并足弓和足曲区域高度值点云模型形成三维重建,从而精确的实现对脚底三维模型的重建,同时重建过程无需昂贵及复杂的检测设备,且不易受到环境光的影响,实现了快速索轮廓提取、索形三维重建等功能,节省了设备成本