基于三维场景的视频融合方法.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于三维场景的视频融合方法.docx

基于三维场景的视频融合方法基于三维场景的视频融合方法摘要:随着虚拟现实技术的发展,三维场景的视频融合方法成为一个热门的研究领域。本文首先介绍了三维场景的概念,然后分析了目前主流的视频融合方法,包括传统的基于2D矩阵的融合方法和基于深度图的融合方法。接着,本文提出了一种基于RGB-D传感器的三维场景视频融合方法,该方法能够融合来自多个传感器的视频流,并生成高质量的三维场景视频。最后,本文进行了实验验证,结果表明所提出的方法在三维场景视频融合方面具有较好的效果。关键词:三维场景、视频融合、虚拟现实、RGB-D

基于三维场景的视频融合方法.pptx

汇报人:/目录01定义和背景目的和意义关键技术023D模型获取场景渲染纹理映射03视频帧的预处理特征提取融合算法选择融合效果评估04虚拟现实和增强现实影视制作和游戏开发安全监控和智能交通教育和培训05实时性和效率问题多源数据融合的挑战算法优化和改进新技术和新方法的应用汇报人:

一种多路视频与三维GIS场景的融合方法.pdf

本发明公开了一种多路视频与三维GIS场景的融合方法,包括定义视频对象中的数据结构,并给每一视频对象的各个参数赋予初始值;判断视频对象在场景中的空间位置信息、姿态信息以及摄像头可观察的区域信息,并根据上述信息,将视频对象抽象化为视锥体几何对象;根据摄像头的属性信息,将场景中所有的视锥体几何对象进行分类,形成多个视频图层;建立场景中各视频图层下所有视频对象的R树索引信息;进入三维场景的可见范围,将可见范围内的渲染对象实时存储,并实时生成可视范围内三维场景的视锥体等步骤。优点是:通过建立视频与三维场景的拓扑信息

基于WebGL的实景三维场景与视频监控图像融合技术研究.docx

基于WebGL的实景三维场景与视频监控图像融合技术研究摘要:随着实时视频监控技术的发展和对三维场景的需求增加,实景三维场景与视频监控图像融合的研究变得非常重要。本文研究了基于WebGL的实景三维场景与视频监控图像融合技术,提出了一种基于深度图像融合的方法来实现这一目标。通过将深度图像与实景三维场景相结合,可以将实时视频监控图像准确地投射到三维场景中,实现更直观、全面的监控。关键词:实景三维场景,视频监控,深度图像,WebGL一、引言近年来,随着互联网的发展和技术的进步,视频监控系统在各个领域得到了广泛应用

一种无人机实时视频与三维场景融合的方法.pdf

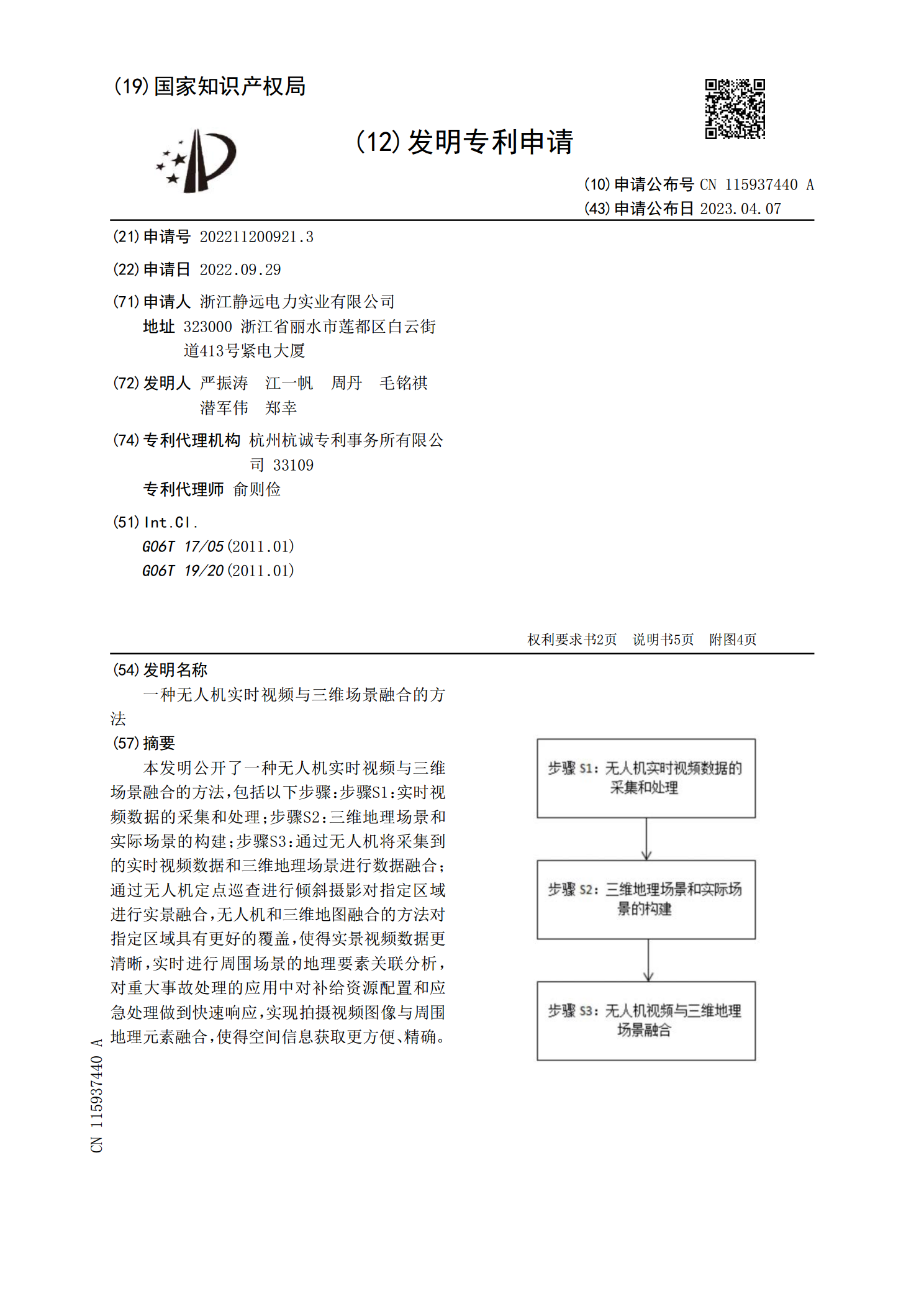

本发明公开了一种无人机实时视频与三维场景融合的方法,包括以下步骤:步骤S1:实时视频数据的采集和处理;步骤S2:三维地理场景和实际场景的构建;步骤S3:通过无人机将采集到的实时视频数据和三维地理场景进行数据融合;通过无人机定点巡查进行倾斜摄影对指定区域进行实景融合,无人机和三维地图融合的方法对指定区域具有更好的覆盖,使得实景视频数据更清晰,实时进行周围场景的地理要素关联分析,对重大事故处理的应用中对补给资源配置和应急处理做到快速响应,实现拍摄视频图像与周围地理元素融合,使得空间信息获取更方便、精确。