基于深度学习的事件关系抽取模型.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于深度学习的事件关系抽取模型.docx

基于深度学习的事件关系抽取模型基于深度学习的事件关系抽取模型摘要:事件关系抽取是自然语言处理领域的重要研究方向之一。深度学习技术的兴起为事件关系抽取提供了新的方法和思路。本论文首先介绍了事件关系抽取的背景和意义,然后详细阐述了基于深度学习的事件关系抽取模型的原理和实现,包括神经网络模型、特征提取和模型训练等。接着,本文对比了传统方法和基于深度学习的方法,在数据集上进行了实验,并对实验结果进行评估和分析。最后,本文总结了基于深度学习的事件关系抽取模型的优势和不足,并对未来工作进行了展望。关键词:事件关系抽取

基于深度学习的食品安全事件实体自动抽取模型研究.docx

基于深度学习的食品安全事件实体自动抽取模型研究基于深度学习的食品安全事件实体自动抽取模型研究摘要:随着食品安全问题的日益突出,准确抽取食品安全事件中的实体信息对于食品监管部门和消费者都具有重要意义。因此,本研究旨在基于深度学习的方法,提出一种有效的食品安全实体自动抽取模型。本研究首先介绍了食品安全问题的背景和意义,然后详细讨论了深度学习在实体抽取中的应用,包括卷积神经网络(CNN)和循环神经网络(RNN)。接着,本研究提出了一种基于BiLSTM-CRF模型的食品安全实体自动抽取方法,并通过实验验证了该模型

基于深度学习模型的信访要素抽取方法及抽取系统.pdf

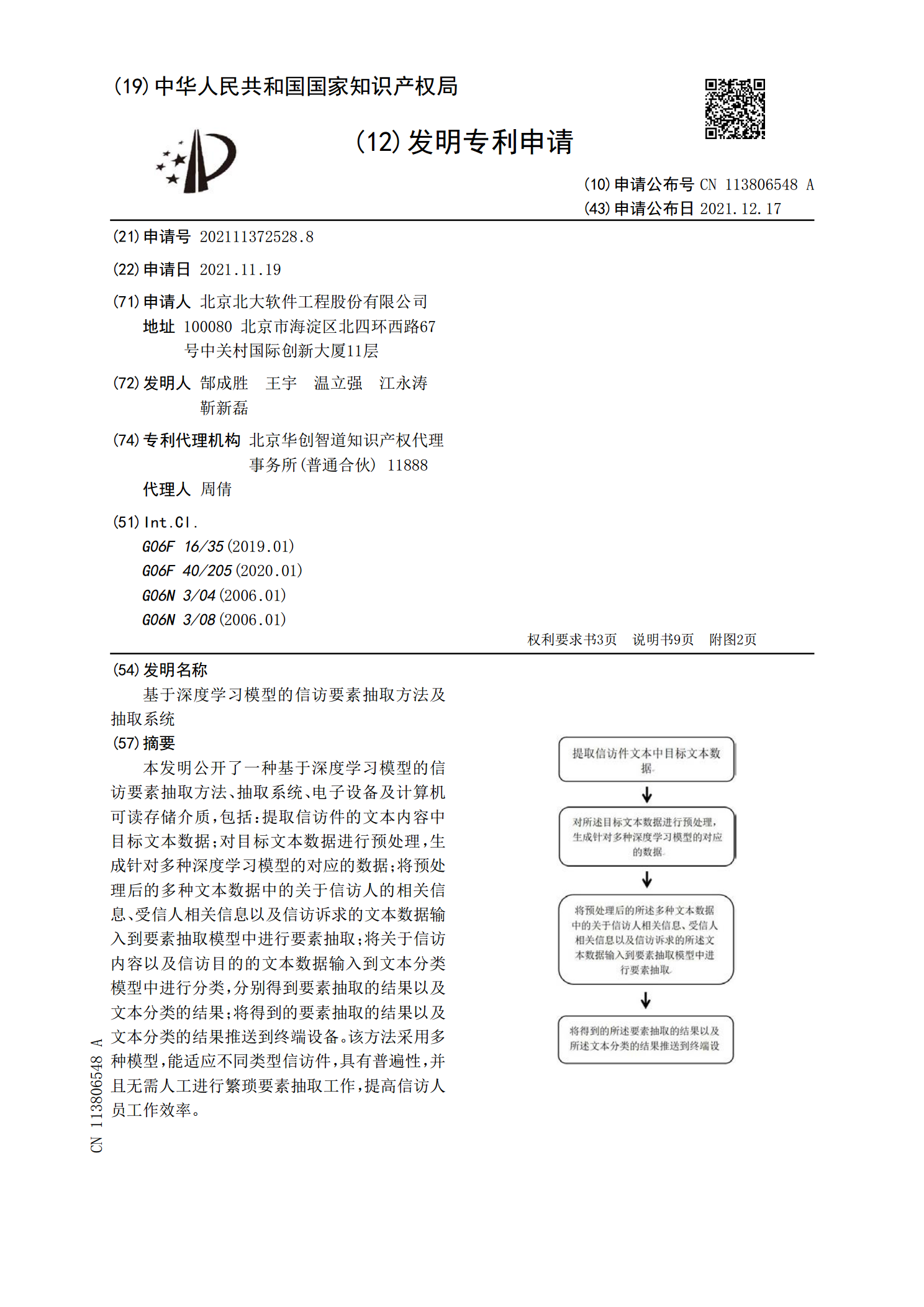

本发明公开了一种基于深度学习模型的信访要素抽取方法、抽取系统、电子设备及计算机可读存储介质,包括:提取信访件的文本内容中目标文本数据;对目标文本数据进行预处理,生成针对多种深度学习模型的对应的数据;将预处理后的多种文本数据中的关于信访人的相关信息、受信人相关信息以及信访诉求的文本数据输入到要素抽取模型中进行要素抽取;将关于信访内容以及信访目的的文本数据输入到文本分类模型中进行分类,分别得到要素抽取的结果以及文本分类的结果;将得到的要素抽取的结果以及文本分类的结果推送到终端设备。该方法采用多种模型,能适应不

基于深度学习的文本关系抽取研究.pptx

,CONTENTS第一章第二章深度学习模型介绍文本关系抽取的挑战与需求深度学习在文本关系抽取中的优势第三章基于神经网络的抽取方法基于图神经网络的抽取方法基于Transformer的抽取方法基于预训练语言模型的抽取方法第四章数据集介绍与预处理实验设置与对比实验效果评估指标与方法实验结果分析与讨论第五章文本关系抽取的应用场景未来研究方向与挑战深度学习在文本关系抽取中的发展趋势感谢您的观看

基于深度学习的关系抽取研究综述.docx

基于深度学习的关系抽取研究综述摘要:关系抽取是自然语言处理中的重要任务,它的目的是从文本中提取实体之间的关系。近年来,深度学习技术被广泛应用于关系抽取领域,它不仅提高了关系抽取的准确率和效率,还能够自动地学习抽取规则和特征。本文综述了基于深度学习的关系抽取研究,包括数据集、特征提取、模型设计等方面,并讨论了未来的研究方向。关键词:深度学习;关系抽取;特征提取;模型设计。1.引言关系抽取是一项重要的自然语言处理任务,它的目的是从文本中提取出实体之间的关系。在许多应用中,关系抽取是必须的,例如文本分类、知识图