基于紧凑型Vision Transformer的细粒度视觉分类研究.docx

骑着****猪猪

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于紧凑型Vision Transformer的细粒度视觉分类研究.docx

基于紧凑型VisionTransformer的细粒度视觉分类研究摘要:本文以细粒度视觉分类为研究对象,提出了基于紧凑型VisionTransformer的方法。该方法使用Transformer编码器来提取图像中的特征,并通过一个分类头来进行分类。相比于传统的卷积神经网络,该方法具有更好的效果和更高的计算效率。实验结果表明,在多个数据集上,该方法都可以获得优于传统方法的性能。关键词:细粒度视觉分类,VisionTransformer,Transformer编码器,深度学习引言:细粒度视觉分类是一项重要的计算

基于Vision Transformer模型的植物叶片病害检测分类方法.pdf

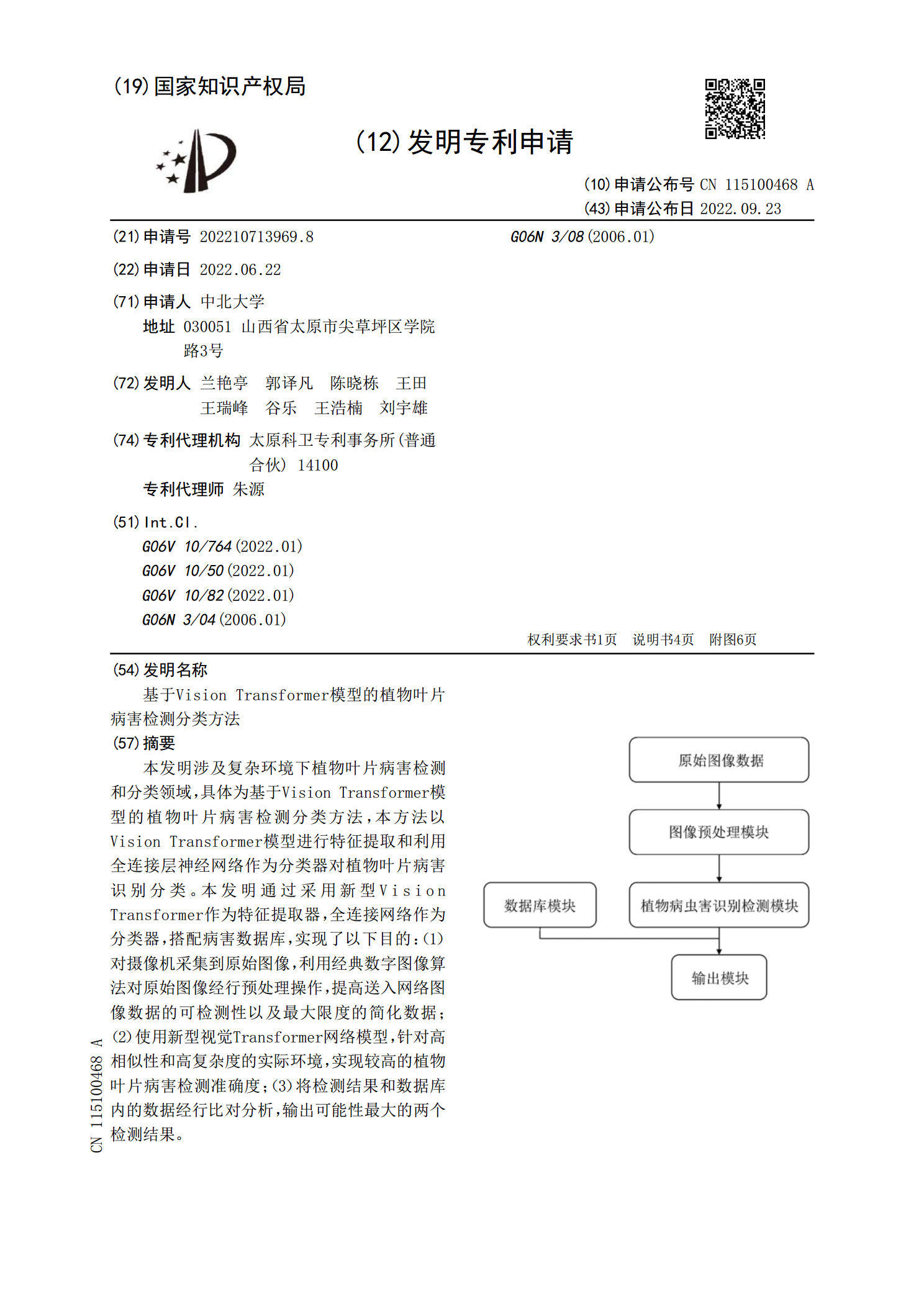

本发明涉及复杂环境下植物叶片病害检测和分类领域,具体为基于VisionTransformer模型的植物叶片病害检测分类方法,本方法以VisionTransformer模型进行特征提取和利用全连接层神经网络作为分类器对植物叶片病害识别分类。本发明通过采用新型VisionTransformer作为特征提取器,全连接网络作为分类器,搭配病害数据库,实现了以下目的:(1)对摄像机采集到原始图像,利用经典数字图像算法对原始图像经行预处理操作,提高送入网络图像数据的可检测性以及最大限度的简化数据;(2)使用新型视觉T

一种基于Transformer的细粒度图像分类方法.pdf

本发明公开了一种基于Transformer的细粒度图像分类方法。本方法为:1)将样本图像输入线性映射和编码器层中提取多层令牌特征;2)通过令牌特征选择模块作用于编码器提取的多层令牌特征;3)通过语义部件生成模块作用于第一层令牌特征,获取包含辨识性视觉图案的局部区域,利用局部分支学习该区域内对象的细节信息;4)将两个分支的分类令牌交换,编码器作用于交换后的分类令牌与当前分支的图像块令牌,融合全局分支提取的图像完整信息与局部分支获取的关键区域的细节信息;5)通过中心损失函数约束细粒度对象类内特征距离,间接地增

基于Transformer的视觉分割技术进展.docx

基于Transformer的视觉分割技术进展1.Transformer在计算机视觉中的应用自2017年ViLBERT模型提出以来,Transformer在自然语言处理(NLP)领域取得了显著的成果。随着深度学习技术的不断发展,Transformer逐渐被应用于计算机视觉领域,如图像分类、目标检测和语义分割等任务。在这些任务中,Transformer的核心思想是通过自注意力机制捕捉输入序列中的全局依赖关系,从而实现对复杂场景的理解和表示。基于Transformer的视觉分割技术取得了重要进展。SEGForm

基于NI Vision机器视觉技术的应用.docx

基于NIVision机器视觉技术的应用基于NIVision机器视觉技术的应用摘要:随着机器视觉技术的发展,越来越多的应用领域开始采用这项技术。NIVision是一种常用的机器视觉解决方案,具备强大的图像处理和分析能力。本论文将重点探讨并介绍基于NIVision机器视觉技术的应用,包括工业自动化、医疗影像、交通监控和农业等领域。通过对这些应用的案例分析,可以更好地理解和认识NIVision技术的优势和潜力,以及其对各个行业的影响。关键词:机器视觉;NIVision;图像处理;应用案例1.引言机器视觉技术是指