基于改进DQN算法的路径规划方法研究.docx

骑着****猪猪

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于改进DQN算法的路径规划方法研究.docx

基于改进DQN算法的路径规划方法研究摘要:本文提出了一种基于改进DQN算法的路径规划方法,该方法利用强化学习的思想,通过状态-动作值函数学习来优化路径规划任务。改进DQN算法在经典DQN算法的基础上,采用了分布式强化学习和双Q学习的技术,提高了算法的学习效率和稳定性。通过实验验证,改进DQN算法的路径规划方法能够在较短的时间内获得更优的路径规划结果。关键词:路径规划;DQN算法;强化学习;状态-动作值函数学习一、引言路径规划是机器人、自动驾驶车辆等智能系统中的重要问题,其目的是在给定的地图和任务需求下,找

基于改进DQN算法的船舶全局路径规划研究.docx

基于改进DQN算法的船舶全局路径规划研究1.内容概览本研究基于改进的DQN算法,针对船舶全局路径规划问题进行了深入探讨。对现有的船舶路径规划方法进行了综述和分析,总结了其优缺点以及在实际应用中的问题。详细阐述了改进DQN算法的基本原理和实现过程,包括环境建模、动作空间定义、经验回放、目标网络更新等关键环节。在此基础上,设计了适用于船舶路径规划问题的DQN算法,并通过实验验证了其有效性和优越性。将所提出的算法应用于实际船舶路径规划任务,实现了较高的路径规划精度和效率,为船舶行业提供了一种实用的解决方案。1.

基于改进的DQN机器人路径规划.pptx

汇报人:CONTENTSPARTONEPARTTWO深度Q学习简介DQN算法基本原理DQN算法优缺点PARTTHREE改进的必要性改进方案介绍改进效果评估PARTFOUR机器人路径规划问题概述基于改进的DQN算法的路径规划流程实验结果及分析PARTFIVE算法优化方向实际应用拓展跨领域合作可能性PARTSIX研究成果总结对未来研究的建议汇报人:

基于RRT路径规划算法的改进方法研究.docx

基于RRT路径规划算法的改进方法研究基于RRT路径规划算法的改进方法研究摘要:路径规划是机器人导航中的一个重要问题,RRT(Rapidly-exploringRandomTrees)是一种高效的算法,用于解决机器人路径规划问题。然而,RRT算法也存在一些缺点,例如在高维空间中的搜索效率较低以及无法适应动态环境。基于这些缺点,本文提出了一种基于RRT算法的改进方法,通过引入启发式信息和学习机制,提高了路径规划的效率和适应性。实验结果表明,改进后的方法相比于传统的RRT算法在搜索效率和路径质量方面具有显著的改

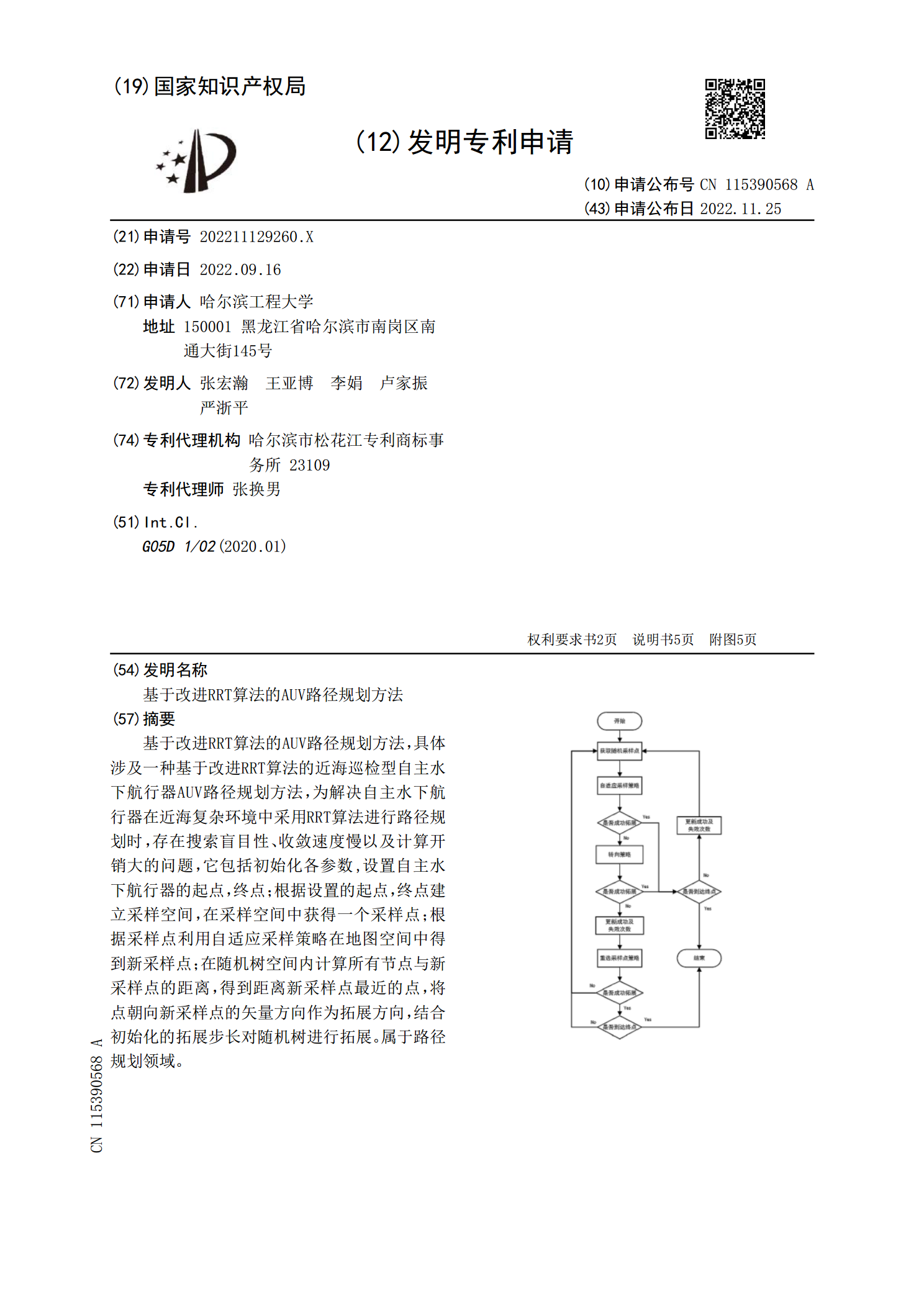

基于改进RRT算法的AUV路径规划方法.pdf

基于改进RRT算法的AUV路径规划方法,具体涉及一种基于改进RRT算法的近海巡检型自主水下航行器AUV路径规划方法,为解决自主水下航行器在近海复杂环境中采用RRT算法进行路径规划时,存在搜索盲目性、收敛速度慢以及计算开销大的问题,它包括初始化各参数,设置自主水下航行器的起点,终点;根据设置的起点,终点建立采样空间,在采样空间中获得一个采样点;根据采样点利用自适应采样策略在地图空间中得到新采样点;在随机树空间内计算所有节点与新采样点的距离,得到距离新采样点最近的点,将点朝向新采样点的矢量方向作为拓展方向,结