基于多任务学习的对话策略在线实现方法.pdf

一吃****昕靓

亲,该文档总共11页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

基于多任务学习的对话策略在线实现方法.pdf

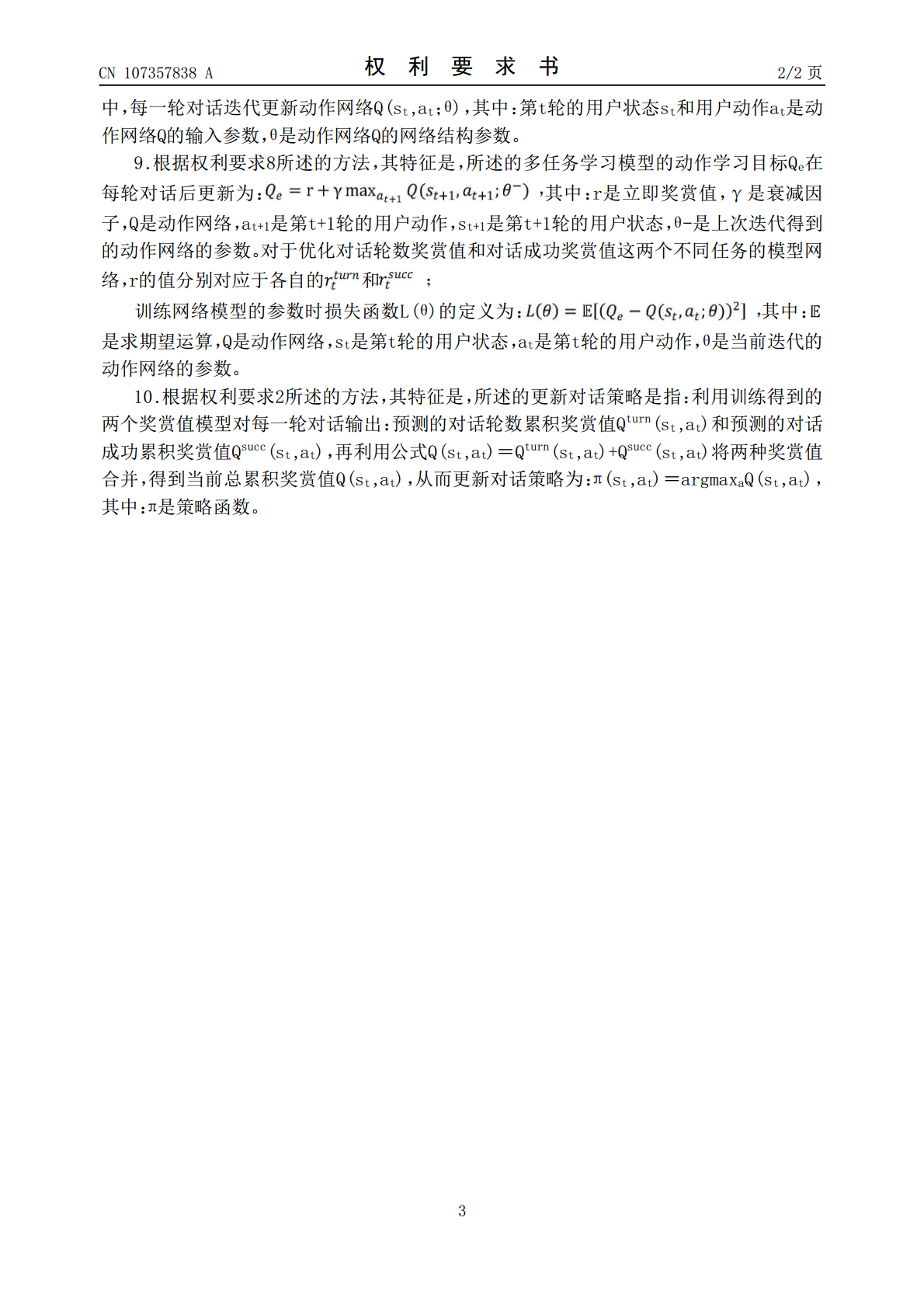

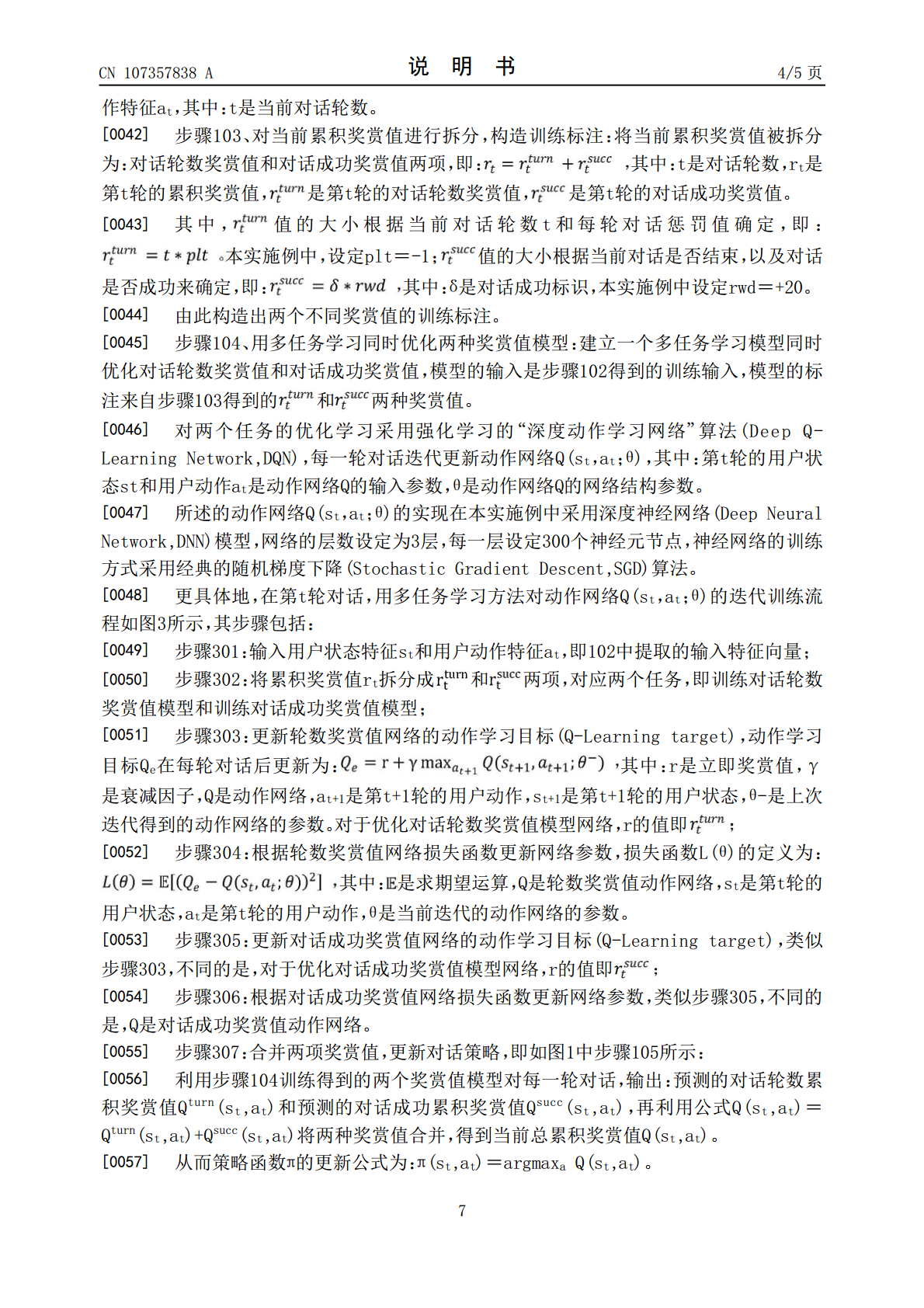

一种基于多任务学习的对话策略在线实现方法,通过实时获取人机对话的语料信息,提取当前用户状态特征和用户动作特征并构造得到训练输入;然后将对话策略学习过程中的单一累积奖赏值拆分成对话轮数奖赏值和对话成功奖赏值作为训练标注,并在线训练过程中通过多任务学习技术对两种不同的值模型同时进行优化,最后合并两项奖赏值,并更新对话策略。本发明采用强化学习的框架,通过在线学习进行对话策略优化,无需根据领域人工设计规则策略,能够适应不同复杂度的领域信息结构、不同规模的数据;本发明将原始优化单一累积奖赏值的任务进行分解,利用多任

基于在线学习的多任务方法研究.docx

基于在线学习的多任务方法研究基于在线学习的多任务方法研究摘要:随着互联网的不断发展,在线学习(OnlineLearning)成为学习领域的重要研究方向之一。在传统的离线学习中,模型是通过对全量数据进行批量训练得到的;而在线学习则是一种在数据逐步到达的情况下连续更新模型的方法。在线学习在训练效率和实时性上具有优势,因此受到了广泛的关注。同时,多任务学习(Multi-TaskLearning)也是近年来备受研究者关注的领域之一。多任务学习可以使得多个相关任务共享信息,提升训练效果。本文将结合在线学习和多任务学

基于在线学习的多任务方法研究的开题报告.docx

基于在线学习的多任务方法研究的开题报告一、研究背景及意义在现代社会中,人们对于学习的需求越来越多样化和个性化,同时互联网和移动设备的发展也使得在线学习这种方式变得越来越普及。然而,通常来讲,一个人想要掌握一项技能或领域,需要学习和掌握多种相关的任务。例如,想要学好计算机科学,不仅要学习编程语言,还需要掌握相关的数据结构、算法、计算机网络等多个方面的知识。这就引出了一种问题,即如何在在线学习中帮助学习者同时学习和掌握多个领域或技能的相关任务。多任务学习是一种可以解决这个问题的方法,它可以同时训练和优化多个相

基于在线学习的多任务方法研究的任务书.docx

基于在线学习的多任务方法研究的任务书任务书一、背景随着互联网技术的发展,在线学习成为了教育领域的重要研究领域之一。在线学习提供了全新的教学方式和学习手段,为学生们提供更加灵活和便捷的学习方式,并且降低了学习成本。近年来,针对在线学习中的多任务学习问题的研究也逐渐受到了学术界的关注。多任务学习是指在同一时间段内进行多个学习任务的过程,它可以极大地提高学习效率和学习效果。但是,在线学习中的多任务学习方法研究仍然处于初级阶段,相关研究工作还需深入探索。因此,本研究将基于在线学习的多任务方法进行研究,探索在线学习

基于对话系统的在线学习方法及装置.pdf

本发明提供一种基于对话系统的在线学习方法及装置,其中,方法包括,获取用户输入的当前对话信息,以及获取前N轮的历史对话信息;根据当前对话信息,以及历史对话信息对预先构建的应答决策器进行更新;根据当前对话信息以及更新后的应答决策器,确定当前应答输出。本发明提供的基于对话系统的在线学习方法及装置,针对用户输入的对话信息,动态地对对话系统中的应答决策器进行更新,以适应不同用户的对话习惯,可以实现提高对话系统的对话灵活性。