内容分发网络的观察.docx

sy****28

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

内容分发网络的观察.docx

内容分发网络的观察在网络内容提供商的成本与网络用户的服务质量之间寻找平衡在网络中,越来越多的内容分发技术成为了优化网络性能的重要组成部分。内容分发网络可以提供最大化的贷款,提高可接入能力,保障内容复制的准确性。利用内容分发网络,把内容分发到各个接近用户的缓存服务器,为用户提供了高速、可靠的网络应用和网络服务。而且,内容分发网络有多个入网点(PoP),并形成代理服务器,可以在代理服务器上存储相同的内容,使得对于大多数网站来说,能够满足用户请求。一般来讲,CDN的拓扑结构包括以下部分:一组代理服务器(分布于世

内容分发网络.pdf

本申请提供了一种内容分发网络,包括通过网络连接的内容发布节点、核心存储节点、中心管理节点、中心数据库和二个以上的边缘缓存节点,其中:内容发布节点用于接收需要发布的介质数据,获取并将其属性参数信息和缓存节点推送列表保存到中心数据库,并将介质数据发送到核心存储节点;核心存储节点用于接收并存储介质数据;中心管理节点用于接收并将用户的服务请求重定向到合适的边缘缓存节点;边缘缓存节点用于根据缓存节点推送列表下载并缓存介质数据,以及将本地缓存或回源下载的介质数据返回用户。本申请通过上述手段,可较大程度的降低核心存储的

媒体分发网络内容分发与内容调度的研究的综述报告.docx

媒体分发网络内容分发与内容调度的研究的综述报告随着互联网技术的不断发展,互联网媒体的内容分发成为了一项具有重要意义的工作。为满足用户对各种场景下不同类型的内容需求,媒体分发网络需要及时、高效、平稳地将内容进行分发。为了保证内容分发的高性能和高质量,内容分发与内容调度成为了媒体分发网络研究的重要领域。一、媒体分发网络媒体分发网络是指通过互联网对音频、视频等媒体内容进行传输至用户终端的网络环境。它是由诸如HTTP、RTSP、RTP/RTCP、FLV等协议组成的分层架构,最基本的结构基于最小带宽的HTTP数据分

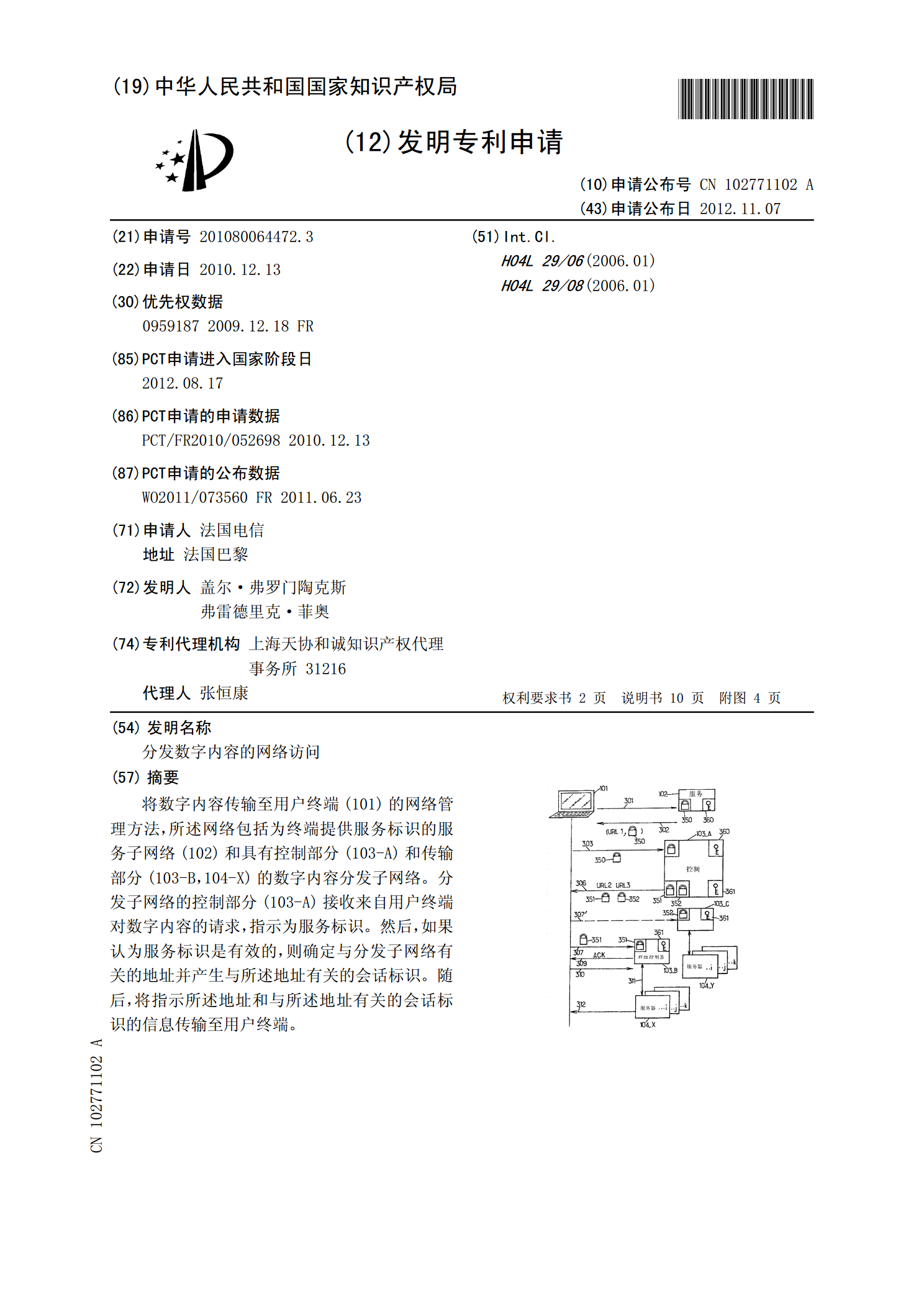

分发数字内容的网络访问.pdf

将数字内容传输至用户终端(101)的网络管理方法,所述网络包括为终端提供服务标识的服务子网络(102)和具有控制部分(103-A)和传输部分(103-B,104-X)的数字内容分发子网络。分发子网络的控制部分(103-A)接收来自用户终端对数字内容的请求,指示为服务标识。然后,如果认为服务标识是有效的,则确定与分发子网络有关的地址并产生与所述地址有关的会话标识。随后,将指示所述地址和与所述地址有关的会话标识的信息传输至用户终端。

IP网络内容分发技术.doc

IP网络内容分发技术聂秀英摘要与传统的PSTN不同,IP网络主要为用户提供基于服务器/客户端的非对称的数据业务。由于IP网络服务的无地域性和无国界性,在用户数量达到一定程度时,用户对信息的消费会给包含有受用户欢迎的信息内容的服务器造成巨大的压力,同时造成接近于这些服务器的骨干网络的拥塞。最近几年内作为解决这些问题的内容分发技术成为业界的研究热点之一,本文主要介绍目前IP网络上较多采用的CDN(contentdistributionnetwork,内容分发网络)技术、组播技术和端到端技术等几种IP网络内容分