一种基于BERT模型的智能问答实现方法.pdf

长春****主a

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

一种基于BERT模型的智能问答实现方法.pdf

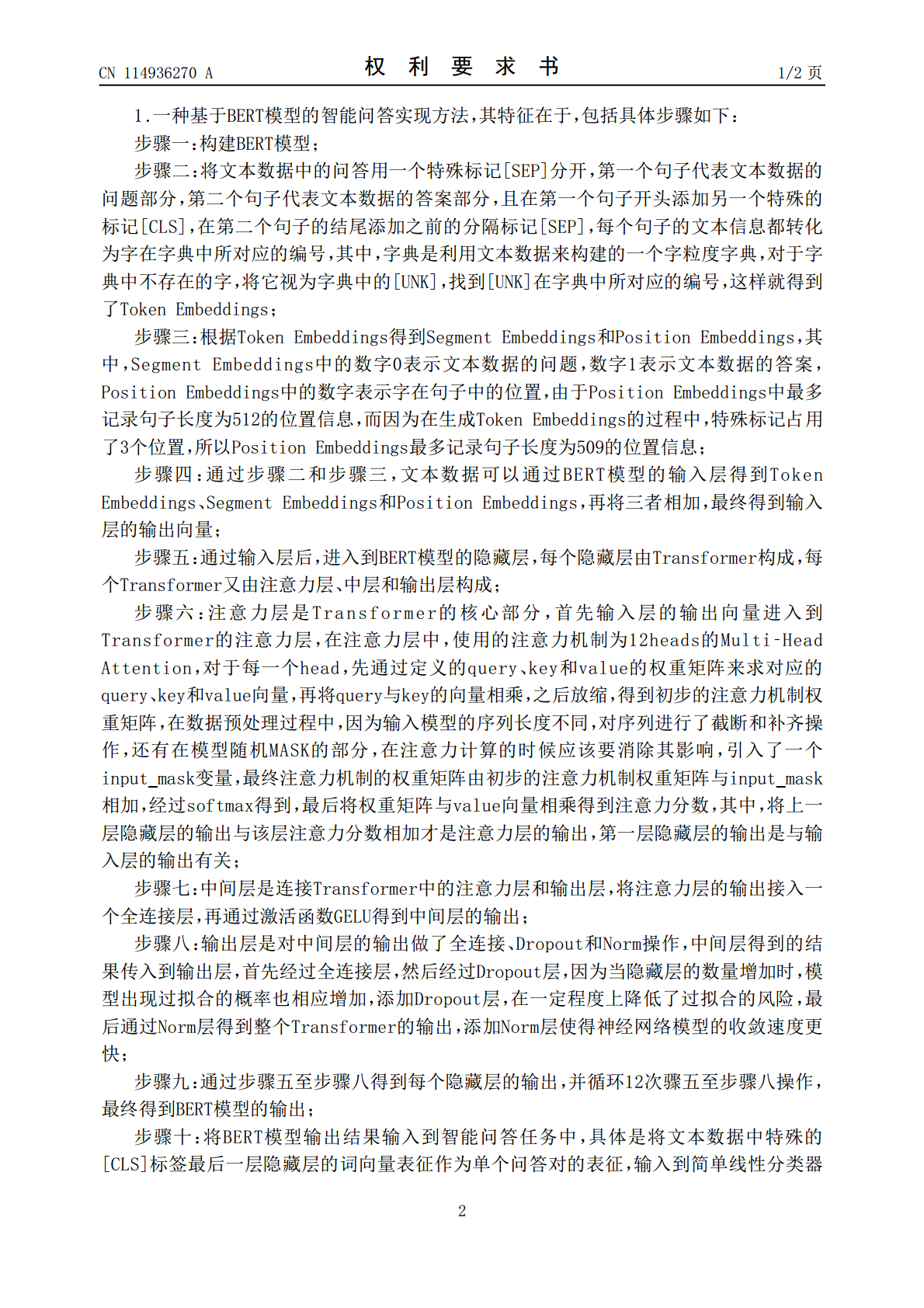

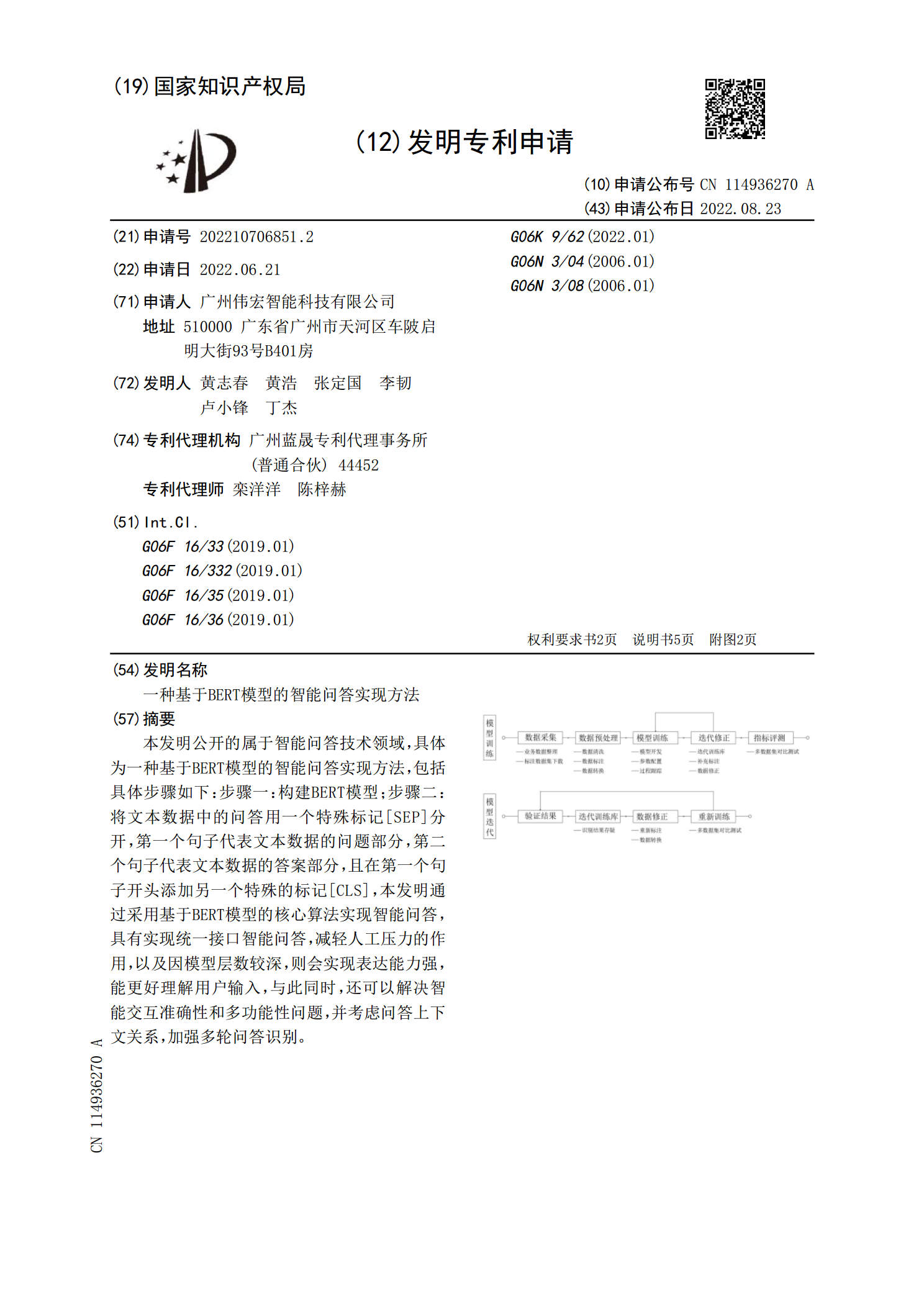

本发明公开的属于智能问答技术领域,具体为一种基于BERT模型的智能问答实现方法,包括具体步骤如下:步骤一:构建BERT模型;步骤二:将文本数据中的问答用一个特殊标记[SEP]分开,第一个句子代表文本数据的问题部分,第二个句子代表文本数据的答案部分,且在第一个句子开头添加另一个特殊的标记[CLS],本发明通过采用基于BERT模型的核心算法实现智能问答,具有实现统一接口智能问答,减轻人工压力的作用,以及因模型层数较深,则会实现表达能力强,能更好理解用户输入,与此同时,还可以解决智能交互准确性和多功能性问题,并

基于BERT模型的知识库问答方法研究.pptx

添加副标题目录PART01BERT模型的原理BERT模型的特点BERT模型的应用场景PART02基于BERT模型的文本表示方法基于BERT模型的答案选择方法基于BERT模型的知识推理方法基于BERT模型的问题生成方法PART03数据集介绍实验设置与参数调整实验结果分析结果比较与讨论PART04优势分析局限性分析未来研究方向PART05在智能客服领域的应用前景在教育领域的应用前景在医疗领域的应用前景在其他领域的应用前景与展望感谢您的观看

基于BERT模型的多任务法律案件智能判决方法.pptx

,目录PartOnePartTwoBERT模型的基本原理BERT模型在自然语言处理领域的应用BERT模型在法律领域的应用前景PartThree多任务学习的基本概念多任务学习在法律案件智能判决中的优势多任务学习在法律案件智能判决中的实现方式PartFour数据预处理与标注模型架构设计与优化训练与推理过程实验结果与分析PartFive案例选择与数据来源案例分析方法应用效果评估指标实际应用效果分析PartSix基于BERT模型的多任务法律案件智能判决方法面临的挑战未来发展方向与展望对法律行业的意义与价值Part

视觉问答的实现方法和基于视觉问答检验模型的方法.pdf

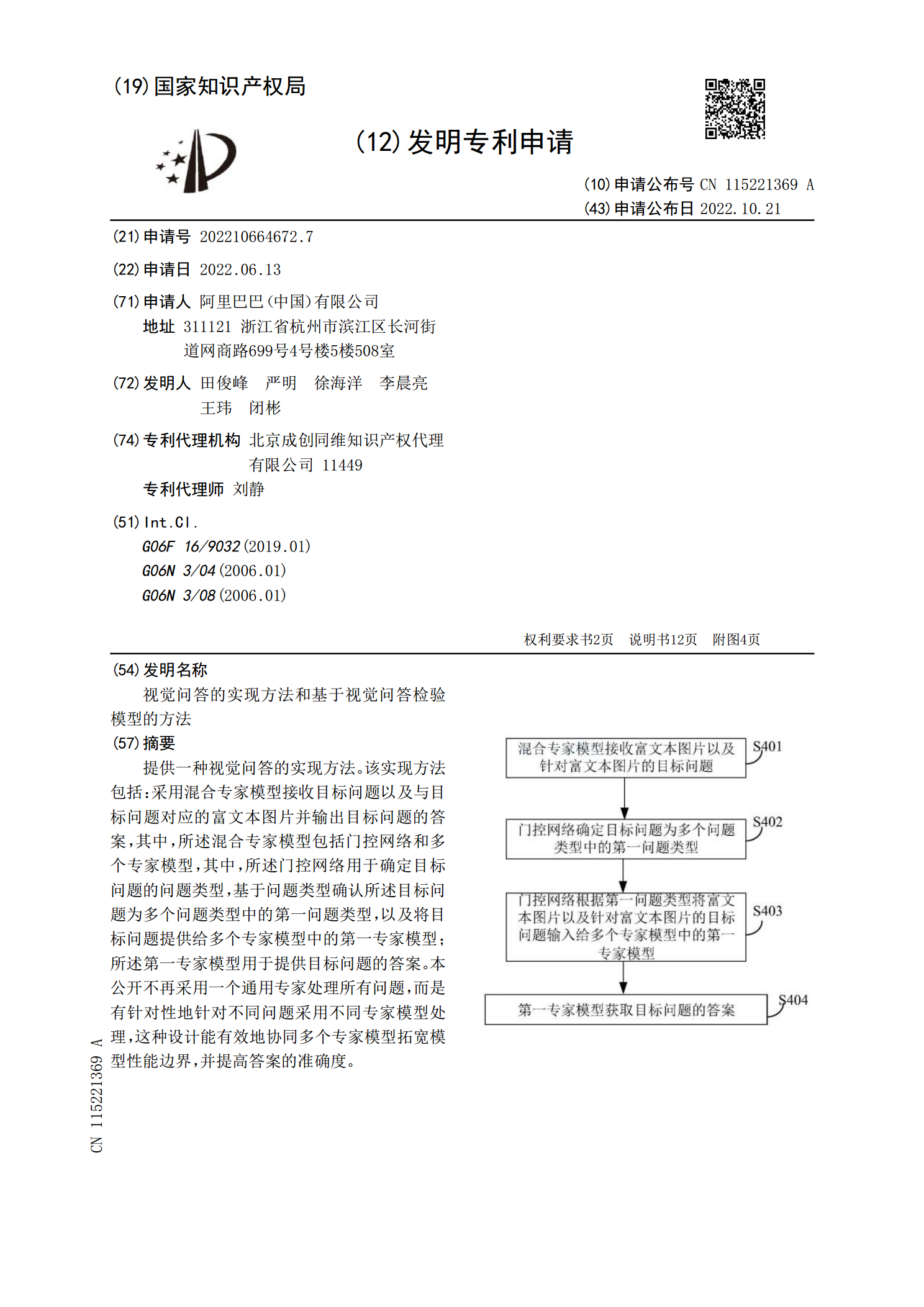

提供一种视觉问答的实现方法。该实现方法包括:采用混合专家模型接收目标问题以及与目标问题对应的富文本图片并输出目标问题的答案,其中,所述混合专家模型包括门控网络和多个专家模型,其中,所述门控网络用于确定目标问题的问题类型,基于问题类型确认所述目标问题为多个问题类型中的第一问题类型,以及将目标问题提供给多个专家模型中的第一专家模型;所述第一专家模型用于提供目标问题的答案。本公开不再采用一个通用专家处理所有问题,而是有针对性地针对不同问题采用不同专家模型处理,这种设计能有效地协同多个专家模型拓宽模型性能边界,并

基于BERT模型的勘探开发资料关键信息智能提取.docx

基于BERT模型的勘探开发资料关键信息智能提取基于BERT模型的勘探开发资料关键信息智能提取摘要:近年来,随着互联网和大数据技术的发展,海量的开发资料被广泛应用于勘探开发领域。这些资料的关键信息提取对于决策和判断至关重要。然而,由于开发资料的复杂性和多样性,传统的信息提取方法面临许多挑战。本论文基于BERT模型,提出了一种基于深度学习的勘探开发资料关键信息智能提取方法,通过训练模型进行关键信息的提取和分类,实现了对开发资料的智能化处理,为勘探开发提供了更准确和高效的决策依据。1.引言随着勘探开发领域的不断