视觉深度学习模型压缩加速综述.docx

18****28

亲,该文档总共38页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

视觉深度学习模型压缩加速综述.docx

视觉深度学习模型压缩加速综述1.内容概述视觉深度学习模型压缩加速是计算机视觉领域的一个重要研究方向,旨在提高模型的运行效率和降低计算资源消耗。随着深度学习技术的快速发展,越来越多的视觉任务得到了有效解决。这些复杂的深度学习模型在实际应用中面临着计算资源和存储空间的限制,如手机、嵌入式设备等。研究如何对视觉深度学习模型进行压缩和加速变得尤为重要。本综述主要介绍了视觉深度学习模型压缩加速的相关技术和方法,包括传统模型压缩技术(如知识蒸馏、剪枝、量化等)在视觉领域的应用,以及新兴的网络结构设计方法(如网络剪枝、

基于深度学习的序列识别模型压缩与加速研究.docx

基于深度学习的序列识别模型压缩与加速研究标题:基于深度学习的序列识别模型压缩与加速研究摘要:序列识别模型在许多实际应用中发挥了重要的作用,包括自然语言处理、语音识别、图像处理等领域。然而,随着深度学习的快速发展,序列识别模型往往具有大量参数和复杂的计算过程,导致模型的训练和推理过程非常耗时。为了解决这个问题,本文针对深度学习序列识别模型进行了压缩和加速的研究。具体而言,本文提出了一种基于深度学习的序列识别模型压缩与加速方法,通过对模型参数进行剪枝和量化以及优化模型架构等方式,实现了模型的高效压缩和加速。实

基于深度学习的序列识别模型压缩与加速研究的任务书.docx

基于深度学习的序列识别模型压缩与加速研究的任务书一、研究背景深度学习在音频、图像、自然语言处理等领域取得了显著的成果。序列识别是一种非常重要的应用,广泛应用于语音识别、自然语言理解、机器翻译等领域。然而,深度学习的计算量大、存储空间要求高,给模型的实际应用带来挑战。因此,压缩与加速深度学习模型已成为当前深度学习研究的热点之一。二、研究任务本研究旨在针对序列识别模型进行压缩与加速。具体任务如下:1.研究序列识别模型压缩与加速的技术手段与方法:理论探究压缩和加速序列识别模型的方法,包括模型剪枝、层次化压缩、量

一种针对深度学习分割任务的模型压缩和加速方法.pdf

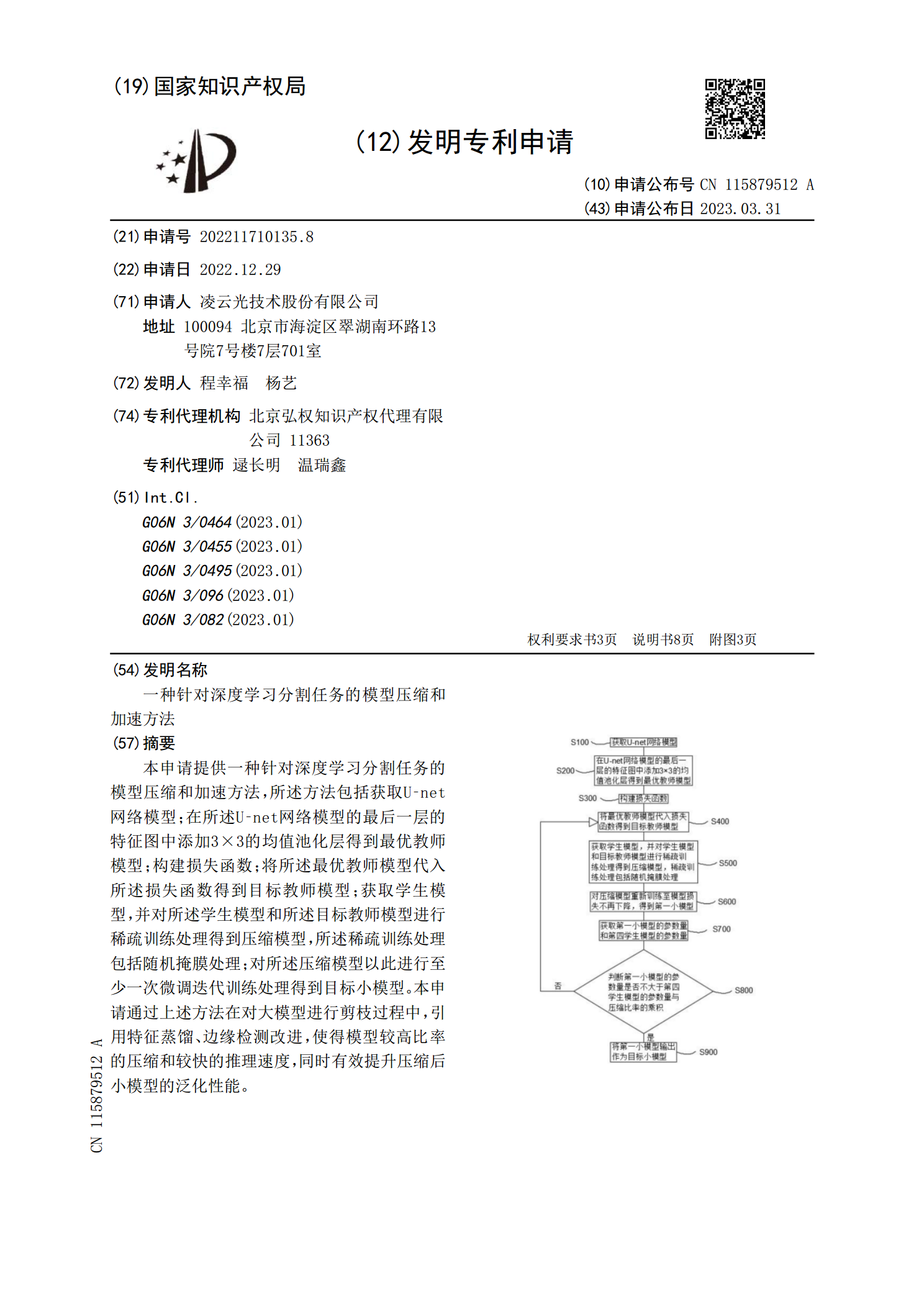

本申请提供一种针对深度学习分割任务的模型压缩和加速方法,所述方法包括获取U?net网络模型;在所述U?net网络模型的最后一层的特征图中添加3×3的均值池化层得到最优教师模型;构建损失函数;将所述最优教师模型代入所述损失函数得到目标教师模型;获取学生模型,并对所述学生模型和所述目标教师模型进行稀疏训练处理得到压缩模型,所述稀疏训练处理包括随机掩膜处理;对所述压缩模型以此进行至少一次微调迭代训练处理得到目标小模型。本申请通过上述方法在对大模型进行剪枝过程中,引用特征蒸馏、边缘检测改进,使得模型较高比率的压缩

深度模型简化:存储压缩和计算加速的开题报告.docx

深度模型简化:存储压缩和计算加速的开题报告摘要如今,随着深度学习技术的飞速发展,深度模型的大小越来越大,这给存储和计算带来了极大的挑战。为了解决这个问题,本文针对深度模型的存储压缩和计算加速进行了探讨。首先,介绍了深度模型在存储和计算方面的瓶颈,接着分别介绍了模型压缩和加速的方法,包括参数剪枝、权值共享、低秩分解和缩小网络结构等。最后,结合实际应用中的案例,比较了这些方法的优缺点,最后得出了关于深度模型简化的一些结论。1.引言深度学习技术的飞速发展改变了人们对计算机视觉、自然语言处理等领域的认知。但是,深